全球掀起 DeepSeek 複現狂潮,一文彙總!

因為 V3 版本開源模型的發佈,DeepSeek 又火了一把,而且這一次,是外網刷屏。

全球複現DeepSeek的一波狂潮來了!

正如LeCun所言:「這一次,正是開源對閉源的勝利!」

在沒有頂級芯片的情況下,以極低成本芯片訓出突破性模型的DeepSeek,或將威脅到美國的AI霸權。

大模型比拚的不再是動輒千萬億美元的算力戰。

OpenAI、Meta、Google這些大公司引以為傲的技術優勢和高估值將會瓦解,英偉達的股價將開始動搖。

種種這些觀點和討論,讓人不禁懷疑:數百億美元支出,對這個行業真的必要嗎?甚至有人說,中國量化基金的一群天才,將導致諾斯達克崩盤。

從此,大模型時代很可能會進入一個分水嶺:超強性能的模型不再獨屬於算力巨頭,而是屬於每個人。

以下項目地址彙總:

DeepSeek-R1:

https://github.com/deepseek-ai/DeepSeek-R1

HuggingFace:

https://github.com/huggingface/open-r1

伯克利團隊:

https://github.com/Jiayi-Pan/TinyZero

港科大團隊:

https://github.com/hkust-nlp/simpleRL-reason

Open R1:DeepSeek-R1全開源複現?

今天,HuggingFace團隊官宣複刻DeepSeek R1所有pipeline。

複刻完成後,所有的訓練數據、訓練腳本等等,將全部開源。

這個項目叫做Open R1,當前還在進行中。截止目前,星標衝破3.4k,斬獲255個fork。

項目地址:https://github.com/huggingface/open-r1

項目地址:https://github.com/huggingface/open-r1不過話說回來,DeepSeek-R1本身就是開源的,HuggingFace搞這麼個「Open R1」項目,又是為何?

官方在項目頁中做瞭解釋:

這個項目的目的是構建R1 pipeline中缺失的部分,以便所有人都能在此之上複製和構建R1。

HuggingFace表示,將以DeepSeek-R1的技術報告為指導,分3個步驟完成這個項目:

-

第1步:用DeepSeek-R1蒸餾高質量語料庫,來複製R1-Distill模型。

-

第2步:複製DeepSeek用來構建R1-Zero的純強化學習(RL)pipeline。這可能涉及為數學、推理和代碼整理新的大規模數據集。

-

第3步:通過多階段訓練,從基礎模型過渡到RL版本。

結合DeepSeek的官方技術報告來看,也就是說,Open R1項目首先要實現的,是用R1數據蒸餾小模型,看看效果是不是像DeepSeek說的那麼好:

DeepSeek開源了6個用R1蒸餾的小模型,其中蒸餾版Qwen-1.5甚至能在部分任務上超過GPT-4o。

接下來,就是按照DeepSeek所說,不用SFT,純靠RL調教出R1-Zero,再在R1-Zero的基礎上複刻出性能逼近o1的R1模型。

其中多階段訓練是指,R1技術報告提到,DeepSeek-R1訓練過程中引入了一個多階段訓練流程,具體包括以下4個階段:

-

冷啟動

用數千個長思維鏈(CoT)樣本對基礎模型進行監督微調(SFT),為模型提供初始的推理能力

-

面向推理的強化學習

在第一個SFT階段的基礎之上,用和訓練R1-Zero相同的大規模強化學習方法,進一步提升模型的推理能力,特別是應對編程、數學、科學和邏輯推理任務的能力。

-

拒絕采樣和監督微調

再次使用監督微調,提升模型的非推理能力,如事實知識、對話能力等。

-

針對所有場景的強化學習

這次強化學習的重點是讓模型行為與人類偏好保持一致,提升模型的可用性和安全性。

目前,在GitHub倉庫中,已經可以看到這幾個文件:

-

GRPO實現

-

訓練和評估代碼

-

合成數據生成器

伯克利團隊30美元成本複刻 R1-Zero?

來自UC伯克利博士生潘家怡和另兩位研究人員,在CountDown遊戲中複現了DeepSeek R1-Zero。

他們表示,結果相當出色!

實驗中,團隊驗證了通過強化學習RL,3B的基礎語言模型也能夠自我驗證和搜索。

更令人興奮的是,成本不到30美金(約217元),就可以親眼見證「啊哈」時刻。

這個項目叫做TinyZero,採用了R1-Zero算法——給定一個基礎語言模型、提示和真實獎勵信號,運行強化學習。

然後,團隊將其應用在CountDown遊戲中(這是一個玩家使用基礎算術運算,將數字組合以達到目標數字的遊戲)。

模型從最初的簡單輸出開始,逐步進化出自我糾正和搜索的策略。

在以下示例中,模型提出瞭解決方案,自我驗證,並反復糾正,直到解決問題為止。

在消融實驗中,研究人員運行了Qwen-2.5-Base(0.5B、1.5B、3B、7B四種參數規模)。

結果發現,0.5B模型僅僅是猜測一個解決方案然後停止。而從1.5B開始,模型學會了搜索、自我驗證和修正其解決方案,從而能夠獲得更高的分數。

他們認為,在這個過程,基礎模型的參數規模是決定性能的關鍵。

他們還驗證了,額外的指令微調(SFT)並非是必要的,這也印證了R1-Zero的設計決策。

這是首個驗證LLM推理能力的實現可以純粹通過RL,無需監督微調的開源研究

基礎模型和指令模型兩者區別:

-

指令模型運行速度快,但最終表現與基礎模型相當

-

指令輸出的模型更具結構性和可讀性

此外,他們還發現,具體的RL算法並不重要。PPO、GRPO、PRIME這些算法中,長思維鏈(Long CoT)都能夠湧現,且帶來不錯的性能表現。

而且,模型在推理行為中非常依賴於具體的任務:

-

對於Countdow任務,模型學習進行搜索和自我驗證

-

對於數字乘法任務,模型反而學習使用分佈規則分解問題,並逐步解決

蘋果機器學習科學家Yizhe Zhang對此表示,太酷了,小到1.5B的模型,也能通過RL湧現出自我驗證的能力。

港科大團隊使用8K樣本完成7B模型複刻

港科大助理教授何俊賢的團隊(共同一作黃裕振、Weihao Zeng),只用了8K個樣本,就在7B模型上複刻出了DeepSeek-R1-Zero和DeepSeek-R1的訓練。

結果令人驚喜——模型在複雜的數學推理上取得了十分強勁結果。

項目地址:https://github.com/hkust-nlp/simpleRL-reason

項目地址:https://github.com/hkust-nlp/simpleRL-reason他們以Qwen2.5-Math-7B(基礎模型)為起點,直接對其進行強化學習。

整個過程中,沒有進行監督微調(SFT),也沒有使用獎勵模型。

最終,模型在AIME基準上實現了33.3%的準確率,在AMC上為62.5%,在MATH上為77.2%。

這一表現不僅超越了Qwen2.5-Math-7B-Instruct,並且還可以和使用超過50倍數據量和更複雜組件的PRIME和rStar-MATH相媲美!

其中,Qwen2.5-7B-SimpleRL-Zero是在Qwen2.5-Math-7B基礎模型上僅使用純PPO方法訓練的,僅採用了MATH數據集中的8K樣本。

Qwen2.5-7B-SimpleRL則首先通過Long CoT監督微調(SFT)作為冷啟動,然後再進行強化學習。

在這兩種方法中,團隊都只使用了相同的8K MATH樣本,僅此而已。

大概在第44步的時候,「啊哈時刻」出現了!模型的響應中,出現了自我反思。

並且,在這個過程中,模型還顯現了更長的CoT推理能力和自我反思能力。

在博客中,研究者詳細剖析了實驗設置,以及在這個強化學習訓練過程中所觀察到的現象,例如長鏈式思考(CoT)和自我反思機制的自發形成。

與DeepSeek R1類似,研究者的強化學習方案極其簡單,沒有使用獎勵模型或MCTS(蒙地卡羅樹搜索)類技術。

他們使用的是PPO算法,並採用基於規則的獎勵函數,根據生成輸出的格式和正確性分配獎勵:

-

如果輸出以指定格式提供最終答案且正確,獲得+1的獎勵

-

如果輸出提供最終答案但不正確,獎勵設為-0.5

-

如果輸出未能提供最終答案,獎勵設為-1

該實現基於OpenRLHF。初步試驗表明,這個獎勵函數有助於策略模型快速收斂,產生符合期望格式的輸出。

第一部分:SimpleRL-Zero(從頭開始的強化學習)

接下來,研究者為我們分享了訓練過程動態分析和一些有趣的湧現模式。

訓練過程動態分析

如下所示,所有基準測試的準確率在訓練過程中都在穩步提高,而輸出長度則呈現先減少後逐漸增加的趨勢。

經過進一步調查,研究者發現,Qwen2.5-Math-7B基礎模型在初始階段傾向於生成大量代碼,這可能源於模型原始訓練數據的分佈特徵。

輸出長度的首次下降,是因為強化學習訓練逐漸消除了這種代碼生成模式,轉而學會使用自然語言進行推理。

隨後,生成長度開始再次增加,此時出現了自我反思機制。

訓練獎勵和輸出長度

訓練獎勵和輸出長度 基準測試準確率(pass@1)和輸出長度

基準測試準確率(pass@1)和輸出長度自我反思機制的湧現

在訓練到第 40 步左右時,研究者觀察到:模型開始形成自我反思模式,這正是DeepSeek-R1論文中所描述的「aha moment」(頓悟時刻)。

第二部分:SimpleRL(基於模仿預熱的強化學習)

如前所述,研究者在進行強化學習之前,先進行了long CoT SFT預熱,使用了8,000個從QwQ-32B-Preview中提取的MATH示例響應作為SFT數據集。

這種冷啟動的潛在優勢在於:模型在開始強化學習時已具備long CoT思維模式和自我反思能力,從而可能在強化學習階段實現更快更好的學習效果。

與RL訓練前的模型(Qwen2.5-Math-7B-Base + 8K QwQ知識蒸餾版本)相比,Qwen2.5-7B-SimpleRL的平均性能顯著提升了6.9個百分點。

此外,Qwen2.5-7B-SimpleRL不僅持續優於Eurus-2-7B-PRIME,還在5個基準測試中的3個上超越了Qwen2.5-7B-SimpleRL-Zero。

訓練過程分析

訓練獎勵和輸出長度

訓練獎勵和輸出長度 基準測試準確率(pass@1)和輸出長度

基準測試準確率(pass@1)和輸出長度Qwen2.5-SimpleRL的訓練動態表現與Qwen2.5-SimpleRL-Zero相似。

有趣的是,儘管研究者先進行了long CoT SFT,但在強化學習初期仍然觀察到輸出長度減少的現象。

他們推測,這可能是因為從QwQ提取的推理模式不適合小型策略模型,或超出了其能力範圍。

因此,模型選擇放棄這種模式,轉而自主發展新的長鏈式推理方式。

最後,研究者用達芬奇的一句話,對這項研究做了總結——

簡約,便是最終極的精緻。

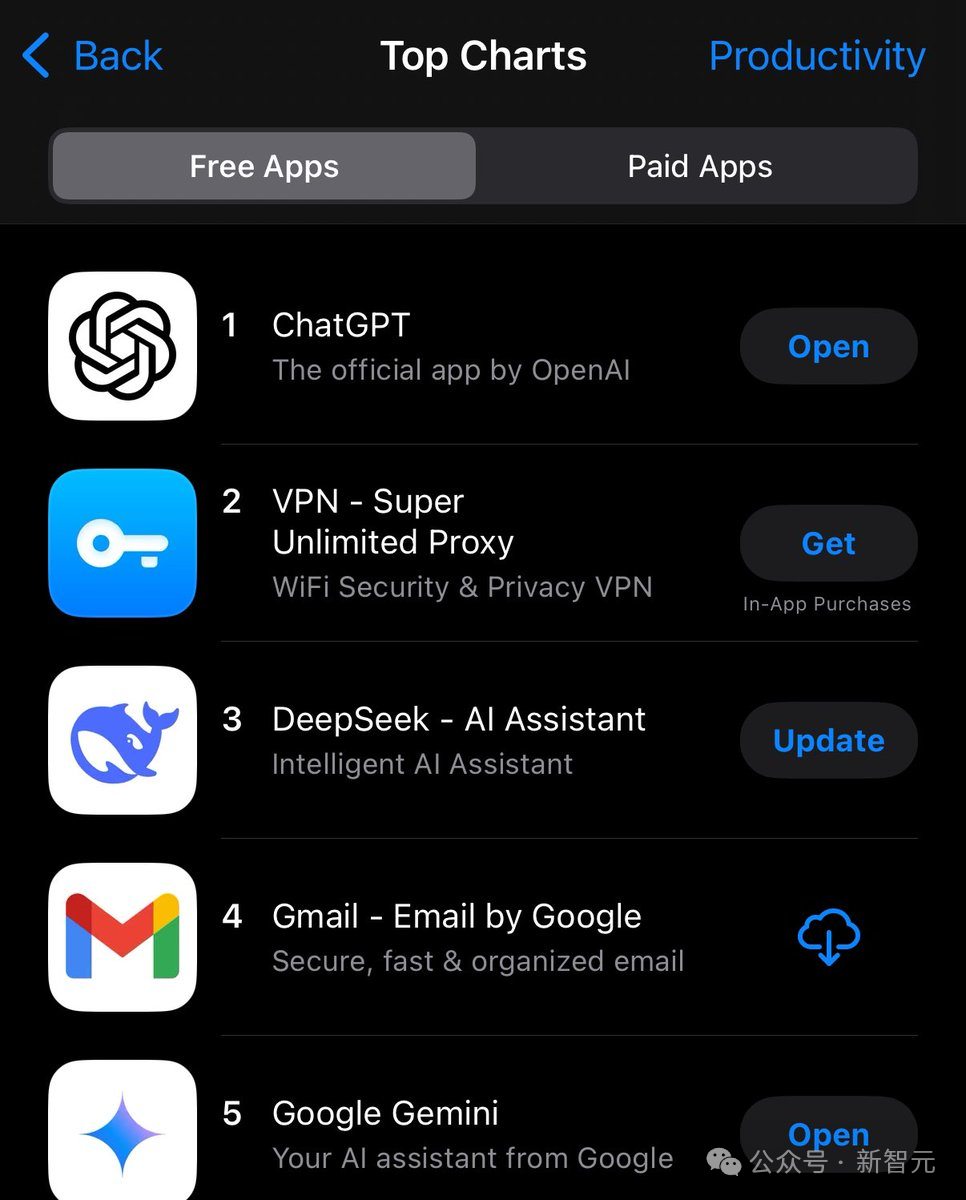

從史丹福到MIT,R1成為首選

一個副業項目,讓全世界科技大廠為之惶恐。

DeepSeek這波成功,也成為業界的神話,網民最新截圖顯示,這款應用已經在APP Store「效率」應用榜單中擠進前三。

在Hugging Face中,R1下載量直接登頂,另外3個模型也霸佔著熱榜。

a16z合夥人Anjney Midha稱,一夜之間,從史丹福到MIT,DeepSeek R1已經成為美國頂尖高校研究人員「首選模型」。

還有研究人員表示,DeepSeek基本上取代了我用ChatGPT的需求。

中國AI,這一次真的震撼了世界。

參考資料:

https://x.com/junxian_he/status/1883183099787571519

https://x.com/jiayi_pirate/status/1882839370505621655