被「逼急」的中國團隊,如何3天震塌矽谷AI帝國?

還記得前年 ChatGPT 刷屏的時候嗎?

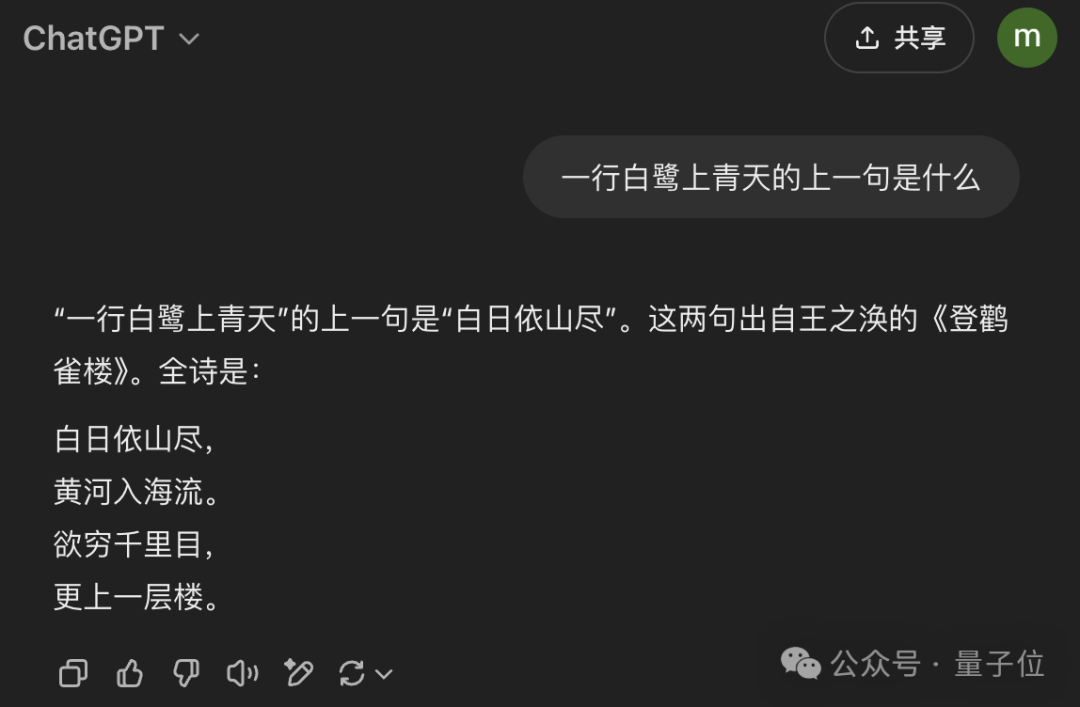

全球科技圈瘋狂吹捧,但問問身邊的普通人,十個裡有八個都在說「太難用了」:註冊要國外手機號,充值要美國信用卡,界面全是英文,想用還得翻牆……後來的 Claude、Gemini 和 Llama,都是「只在新聞標題見過」的名字。

這兩年來,整個 AI 界的酸甜苦辣和風雲變幻,在真正的藍海市場面前,都像是一場自嗨。大家都在頭疼同樣的問題:怎麼推廣出去?怎麼讓普通人知道 AI 有什麼用?反過來再問問自己——現在的 AI 應用真的有用嗎?

但這個春節,情況突然不一樣了。

打開微信,朋友圈被 DeepSeek 的對話截圖刷屏。服務器從年前就在崩潰的邊緣反復橫跳。打開界面永遠都是:「不好意思,和 DeepSeek 聊天的人有點太多了,請過一會兒再提問吧。」

不再是科技圈的自嗨,而是 AI 真正第一次走進了中國普通人的生活。

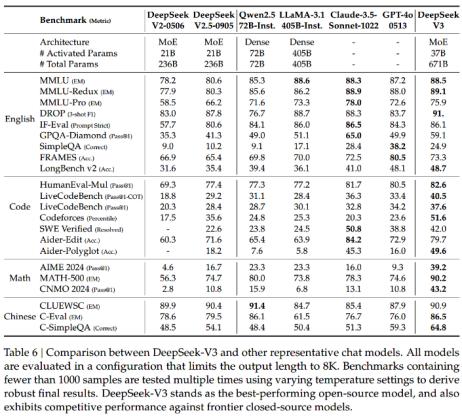

突如其來的「全民 AI 狂歡」背後,是一家中國團隊完成的驚人技術突破。1 月 20 日,DeepSeek 發佈了推理模型 DeepSeek-R1,這款完全開源的模型在多項第三方測試中超越了 OpenAI 最新的 o1 模型,同時 API 價格僅為後者的 3.7%。

這幾乎相當於免費送你一個頂配版 ChatGPT。用戶瘋狂湧入,直接把 DeepSeek 送上了中美應用商店雙榜第一。更刺激的是,這個「低成本平替」的玩法直接把華爾街也干懵了。英偉達一夜暴跌 6000 億,創下史上最大單日跌幅,股民們人都看傻了:原來 AI 不一定要堆算力?

緊接著在除夕夜,他們又推出了多模態大一統開源模型 Janus-Pro(目前還沒上網頁端)。僅用 16 個計算節點(每節點 8 張 A100)訓練一週,1.5B 版本就達到了驚人的效果。而配備 32 個節點訓練兩週的 7B 版本,更是在多模態理解基準 MMBench 上拿下 79.2 分,超越了包括 TokenFlow(68.9 分)和 MetaMorph(75.2 分)在內的所有現有統一多模態模型。

這一系列事件背後,折射出的是整個 AI 行業面臨的根本性問題:技術發展究竟是否一定要與巨額投入掛鉤?Windows 部門前總裁 Steven Sinofsky 在最新發佈的分析中指出,當前 AI 行業的發展高度依賴資本投入。

OpenAI 每年支出 50 億美元,Google 在 2024 年的 AI 預期支出更是將超過 500 億美元,而微軟對 OpenAI 的投資已達到 130 億美元。這種發展模式形成了一個看似合理但可能存在隱患的邏輯:砸錢就能搞出好 AI。更多的投入必然帶來更強的算力,進而產出更好的模型。

而 DeepSeek 走出了一條截然不同的道路。他們的發展軌跡令人驚歎:2023 年 7 月 17 日成立,2024 年 1 月 5 日發佈第一個 AI 大模型 DeepSeek LLM,5 月 7 日發佈 DeepSeek-V2 正式打響中國大模型價格戰,12 月 26 日開源 DeepSeek-V3。

我們 CSDN 編輯部其實也是從 DeepSeek-V2 時期就開始買他們家的 API 了,不為其他原因:當時送了 500 萬 tokens,到過期了也沒用完;後面充了 10 塊錢又買了幾百萬 tokens,到現在 R1 出來了還是沒用完。

在訓練成本方面,DeepSeek-V3 僅用了 557.6 萬美元就完成了訓練。這個投入對比一下 Meta 的數據就格外刺眼:Llama 3 系列的計算預算高達 3930 萬 H100 GPU Hours,這樣的算力足夠訓練 15 個 DeepSeek-V3。

這一下子問題就來了:Meta 的員工要咋跟領導解釋呢?就在模型發佈後不久,一位 Meta 員工在美國匿名職場社區 teamblind 爆料:整個生成式 AI 團隊已經陷入恐慌。「工程師們正在瘋狂地分析 DeepSeek,試圖從中複製任何可能的東西。這一點都不誇張。」

更讓管理層頭疼的是,當生成式 AI 組織中每一位「領導」的薪資都比訓練整個 DeepSeek-V3 的成本還要高,而公司有好幾十個這樣的「領導」時,他們要如何向高層解釋這些開支?

在算法層面,DeepSeek 在混合專家模型(Mixture of Experts)訓練中解決了不規則損失峰值問題,實現了 8 位浮點訓練以顯著降低內存佔用。這些創新使他們將通常需要數月的訓練時間縮短到了 60 天。這些成就甚至得到了 OpenAI 首席研究官 Mark Chen 的認可,他承認 DeepSeek 獨立發現了一些與 o1 相同的核心理念。

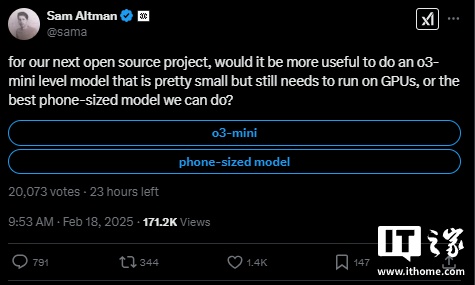

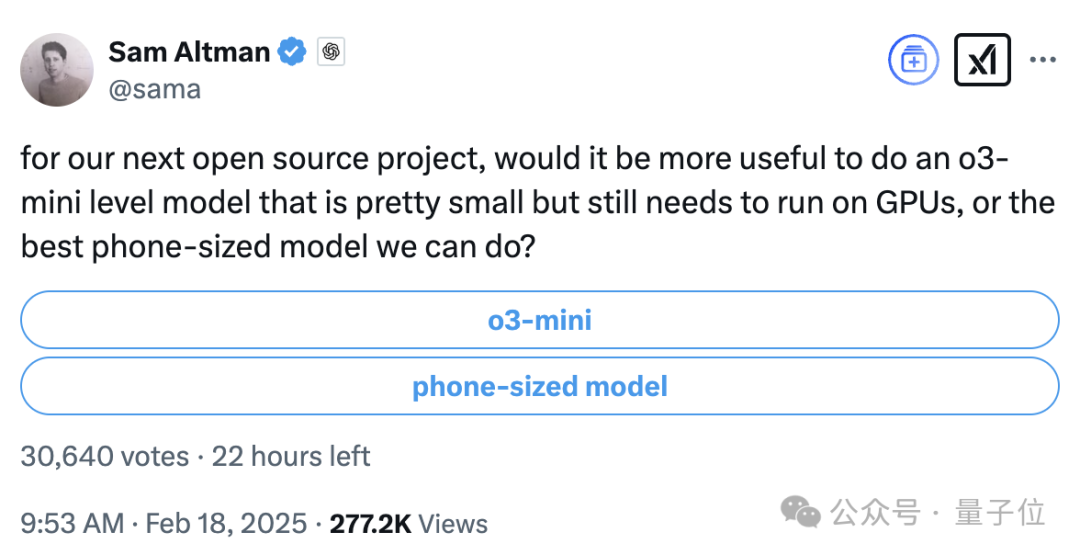

而 OpenAI 首席執行官 Sam Altman 終於沒憋住氣,正式回覆並承認了 DeepSeek 的成功,重點感歎了它的便宜。

這裏可以回顧一下 DeepSeek-V3 剛發佈時 Sam Altman 的反應,態度可謂是 180 度大轉彎了:

我們可以簡單地把 Sam 對一件事的態度分為三級:

-

釋然了:不藏著掖著,正面坦然回應各種事情;

-

破防了:連名字都不提,陰陽怪氣一波;(對Google經常這麼幹)

-

高度重視:規範大小寫,不再打全小寫的英文;

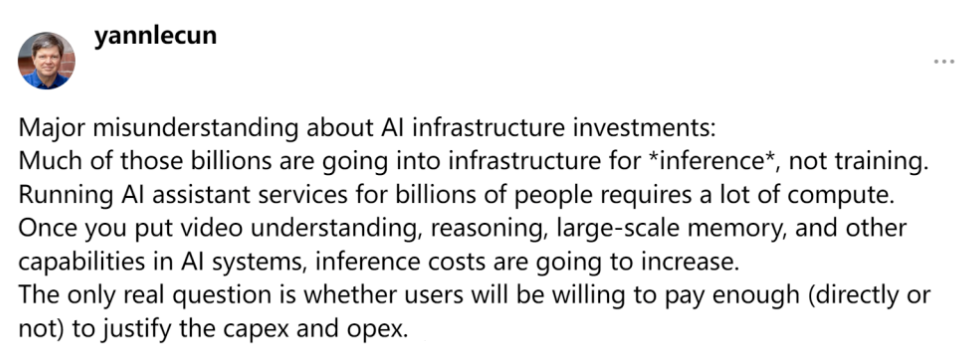

當然,對於 DeepSeek,矽谷也存在各種不同的聲音。圖靈獎得主、Meta AI 首席科學家 Yann LeCun(楊立昆)指出,人們常常誤解了 AI 基礎設施投資的重點。他認為大部分資金其實用於推理而非訓練,隨著 AI 能力的增強,維持服務運行的成本會變得更高。

立昆還發表了一個更具全局視野的觀點:「與其說是中國在人工智能上超越美國,正確的看法應該是開源代碼正在超越私有模式。」

這句話倒不一定需要過度解讀,因為我們往期整理的數篇楊立昆採訪都顯示,他其實就是想藉著這個機會再次拉踩一下 OpenAI,醉翁之意不在中美,而在於開源閉源之爭:《圖靈獎得主楊立昆:統治慾望源於生存需求,而非智能水平,AI 不會有這種想法 | AI 2025》

總之,如今這場風波背後的核心問題在於:DeepSeek 展示的高效路線是否預示著 AI 發展的新範式?砸錢買顯卡以後還會管用嗎?

美國科技巨頭們的擔憂顯然不是沒有根據的。近日,美國財經媒體 CNBC 推出了一期長達 40 分鐘的專題節目,深入探討 DeepSeek 對美國 AI 主導地位可能帶來的衝擊。

CNBC 邀請了矽谷新銳 AI 創業公司 Perplexity 的 CEO Aravind Srinivas 進行深度對談,此人相當能侃,AI 科技大班營上一次整理他的文章還是一篇四萬字的採訪,盡顯他對於拿下Google的決心:《Perplexity CEO 最新四萬字訪談:殺死Google,成為 AI 時代的搜索占士!》

以下是訪談全文,由 CSDN 精編整理:

主持人:請跟我們描述一下中美之間的 AI 競賽,以及其中的利害關係。

Aravind Srinivas:首先要說明,中國在與美國的競爭中面臨很多不利因素。最主要的是他們無法獲得我們這裏能用的所有硬件資源。他們基本上在使用比我們低端的 GPU,幾乎就是在用上一代的設備。由於更大的模型通常意味著更強的智能,這自然讓他們處於劣勢。

但另一方面,這些限制反而成就了創新。因為他們必須尋找變通方案,最終反而打造出了更高效的解決方案。這就像是在說:「嘿,你們必須開發一個頂級模型,但我不給你們資源,你們得自己想辦法。」

除非從數學上能證明這是不可能的,否則你總能找到更高效的解決方案。這可能會讓他們比美國找到更高效的方法。當然,他們已經開源了模型,所以我們也可以採用類似的技術,但他們培養的這種人才和能力將逐漸成為他們的優勢。

目前,美國最好的開源模型是 Meta 推出的 Llama 系列。它非常出色,基本可以在普通電腦上運行。雖然它在發佈時聲稱自己接近 GPT-4 性能,但事實上只有那個巨大的 405B 參數模型才符合宣傳水平,而不是你能在電腦上運行的 70B 模型。所以,此前一直沒有一個既小巧便宜,又快速高效的開源模型能與最強大的閉源模型相媲美。

然後這些中國團隊突然推出了一個令人震驚的模型,API 價格比 GPT-4 便宜十倍,比 Claude 便宜十五倍。速度極快,而且在某些基準測試中與 GPT-4 不相上下,有些甚至更好。他們只用了大約 2048 個 H800 GPU,相當於 1500 到 2000 個 H100 GPU,這比 GPT-4 通常訓練時用的 GPU 數量少了二三十倍。總共只花了 500 萬美元的計算預算,就做出了這麼驚人的模型,還完全開源並發佈了技術論文。

主持人:當你理解他們所做的一切時,最讓你驚訝的是什麼?

Aravind Srinivas:我的驚訝在於,當我閱讀他們的技術論文時,發現他們提出了很多聰明的解決方案。

首先,他們成功訓練了一個混合專家模型(Mixture of Experts),這本身就不容易。人們之所以很難跟上 OpenAI 的步伐,特別是在 MoE 架構上,主要是因為存在很多不規則的損失峰值。數值不穩定,經常需要重新啟動訓練檢查點。他們提出了非常巧妙的解決方案來平衡這個問題,而且沒有使用額外的技巧。

他們還實現了 8 位浮點訓練,至少在部分數值計算上做到了。他們巧妙地確定了哪些部分需要高精度,哪些部分可以用低精度。據我所知,8 位浮點訓練在美國並不普遍,大多數訓練仍然在用 16 位精度,雖然有些人在探索這個方向,但很難做到正確。正是因為他們沒有那麼多內存和 GPU,所以他們找到了很多數值穩定性的方法,使他們的訓練能夠順利進行。他們在論文中說,大部分訓練都很穩定,這意味著他們可以隨時重新運行這些訓練,用更多或更好的數據。整個訓練只用了 60 天,這真的非常驚人。

主持人:你最驚訝的是哪個部分?

Aravind Srinivas:通常人們認為中國人只會複製,認為只要在美國停止發表研究論文,停止描述基礎設施架構的細節,停止開源,他們就追不上來。但事實是,DeepSeek V3 中的創新確實令人驚豔。我相信 Meta 在開發下一代 Llama 模型時,一定會借鑒他們的一些技術突破。DeepSeek 是真正的創新 —— 而一旦你做出了真正的突破,其他人自然會跟進。

主持人:我們並不完全瞭解他們訓練用的數據是什麼。雖然它是開源的,我們知道一些訓練方式,但不是全部。有觀點認為它是基於公開的 ChatGPT 輸出訓練的,這意味著只是複製品,但你說它超越了這一點,有真正的創新。

Aravind Srinivas:沒錯。他們訓練了 14.8 萬億個 token。互聯網上確實有大量 ChatGPT 生成的內容,如果你現在去看任何 LinkedIn 帖子或 X 帖子,大多數評論都是 AI 寫的。就連 X 上都有 Grok 推文增強器,LinkedIn 上有 AI 增強器,Google Docs 和 Word 里也有 AI 工具來重寫內容。

如果你用 AI 寫了點什麼然後複製到網上,自然會帶有一些 ChatGPT 式的訓練痕跡。很多人甚至在複製的時候懶得刪掉「我是一個語言模型」這樣的字眼。在這個領域很難控制這些。所以我不會因為它對某些提示(比如「你是誰」或「你是哪個模型」)的回應而否定他們的技術成就。在我看來,這根本不重要。

主持人:長期以來,我們認為中國在 AI 領域落後。這場競賽現在情況如何?我們能說中國正在趕上,還是已經趕上了?

Aravind Srinivas:如果我們說 Meta 正在趕上 OpenAI 和 Anthropic,那麼同樣的說法也適用於中國趕上美國。實際上,在 o1 發佈後,我看到中國出現了比美國更多試圖複製它的論文。值得注意的是,DeepSeek 能使用的計算資源大概和美國的博士生差不多。順便說一句,這不是在批評其他人。就拿我們 Perplexity 來說,我們決定不訓練模型是因為覺得這太貴了,而且我們認為不可能追上其他人。

主持人:你會將 DeepSeek 整合到 Perplexity 中嗎?

Aravind Srinivas:我們已經開始使用它了。他們有 API,而且開源了,所以我們也可以自己部署。使用它很有意義,因為它實際上讓我們能以更低成本做很多事情。但我在想的不止這些。這些人真的能用一個好團隊訓練出如此優秀的模型,這意味著美國公司,包括我們在內,已經沒有藉口不去嘗試類似的事情了。

主持人:在公共場合,我們經常能夠聽到很多生成式 AI 領域的意見領袖,無論是研究還是創業方面,比如 Elon Musk 等人都說中國追不上。

Aravind Srinivas:首先,我不確定 Elon 是否說過中國追不上。我不瞭解這一點。

主持人:Sam Altman 也說過類似的話。

Aravind Srinivas:你必須區分開像 Sam 這樣的人說的話和他自身的利益關係。我的觀點是,無論你做什麼來阻止他們追趕都無關緊要。他們最終還是追上來了。需求是發明之母,就是這樣。

更危險的是,他們現在擁有最好的開源模型,而所有美國開發者都在基於此構建。這才是更危險的,因為這樣他們就能掌握開發者心智和生態系統。一般來說,歷史已經證明,一旦開源趕上或超越了閉源軟件,所有開發者都會轉向開源。這是歷史規律。

主持人:當 Llama 被開發並廣泛使用時,人們在問「我們應該信任朱克伯格嗎?」但現在的問題變成了「我們應該信任中國嗎?」

所以,「開源的是誰」這件事,本身重要嗎?

Aravind Srinivas:從某種意義上說這並不重要,因為你仍然可以完全控制它。你可以在自己的計算機上運行自己的權重,你來掌控模型。但是,讓我們自己的人才依賴別人開發的軟件看起來並不太好,即使它是開源的。開源模型也有一天可能不再開源。對吧?現在的許可證很寬鬆,但是隨著時間推移,他們隨時可能改變許可證。

所以我們在美國也需要有人在建設,這就是為什麼 Meta 如此重要。我認為 Meta 最終會建造出比 DeepSeek-V3 更好的模型並開源它,不管他們叫它 Llama 4 還是 3 點幾都不重要。我認為關鍵是我們不要把所有精力都放在禁止他們、阻止他們上面。相反,應該努力競爭並戰勝他們。這才是美國的方式。做得更好。

主持人:看起來我們現在聽到越來越多關於這些中國公司的消息,他們正在以更高效、更低成本的方式開發類似的技術,對嗎?

Aravind Srinivas:如果你籌集了 100 億美元,並決定將其中 80% 用於計算集群,那麼你很難去想出和那些只有 500 萬美元的人一樣的解決方案。而且也沒必要去批評那些投入更多的人。他們只是在試圖盡快完成目標。

主持人:當我們說開源時,有很多不同的版本。有些人批評 Meta 沒有公佈所有內容,就連 DeepSeek 本身也不是完全透明的。

Aravind Srinivas:當然。你可以把開源的定義推到極致,說我應該能完全複製你的訓練過程。但首先,有多少人真的有資源去做這件事?而且,比較一下,他們在技術報告中分享的細節已經比其他公司多得多了。順便說一句,Meta 也是這樣,他們的 Llama 3.3 技術報告非常詳細,對科學非常有價值。他們分享的細節已經比其他公司現在做的要多得多了。

主持人:當你想到 DeepSeek 只花了不到 600 萬美元就做到這一點,再想想 OpenAI 在開發 GPT 模型上花了多少錢,這對閉源模型生態系統的軌跡、發展形勢意味著什麼?對 OpenAI 意味著什麼?

Aravind Srinivas:很明顯,我們會在今年看到一個開源版本的 GPT-4,甚至比它更好、更便宜的版本。完全開源。

主持人:由 OpenAI 開發的?

Aravind Srinivas:很可能不是。我不認為他們會在意是不是由他們開發的。我認為他們已經轉向了新的範式,就是 o1 系列模型。Ilya Sutskever 已經說了,預訓練正在遇到瓶頸,他明確表示預訓練時代已經結束。很多人都這麼說。這並不意味著 Scaling Law 遇到了瓶頸。我認為我們現在正在不同維度上進行擴展。模型在測試時花在思考上的時間、強化學習,就像是在嘗試讓模型在遇到新提示時,能夠進行推理、收集數據並與世界互動,使用各種工具。我認為發展正朝著這個方向前進,我感覺 OpenAI 現在更專注於這方面。

主持人:那我的問題是,現在 OpenAI 的護城河在哪裡?

Aravind Srinivas:嗯,我仍然認為,目前還沒有其他人做出類似 o1 那樣的系統。我知道有人在爭論 o1 是否真的值得,可能在一些提示詞上它確實更好,但大多數時候它的輸出並沒有比 Claude 好多少。但至少他們在 o3 中展示的結果,比如在競爭性編程方面的表現,已經接近 AI 軟件工程師的水平了。

主持人:但這不就是時間問題嗎?互聯網上很快就會充滿推理數據。

Aravind Srinivas:確實有可能。現在還沒人知道。所以在它真正實現之前,這種不確定性就是他們的護城河。就是說,還沒有其他人擁有同樣的推理能力。但到今年年底,推理領域會有多個玩家嗎?我絕對認為會的。

主持人:所以我們正在看到大語言模型及其能力的商業化嗎?

Aravind Srinivas:我認為我們會看到類似的軌跡。就像在預訓練和後訓練那種系統中,今年會有更多商業化的類 GPT-4 模型。我覺得推理類模型也會經歷類似的軌跡,一開始只有一兩個玩家知道怎麼做,但隨著時間推移……(可能越來越多)因為 OpenAI 可能會在另一個方向取得突破。現在推理是他們的護城河。但如果突破一直在發生,一次又一次,那麼「突破」這個詞本身可能也會失去一些價值。

主持人:說得對。即使現在也很難區分,對吧?因為有預訓練的突破,然後我們又進入了不同的階段。

Aravind Srinivas:是的。可以肯定的是,今天存在的任何模型,無論是這種程度的推理還是多模態能力,都會出現成本降低 5 到 10 倍的開源版本。這隻是時間問題。不確定的是,像在測試時進行推理的模型,是否能便宜到我們都能在手機上運行。我覺得這一點還不清楚。

主持人:DeepSeek 展示的這些能力,你覺得可以稱之為中國的 ChatGPT 時刻嗎?

Aravind Srinivas:有可能。我是說,這肯定給了他們很大的信心,讓他們意識到自己並沒有落後,而且無論你如何限制他們的計算資源,他們總能找到解決方案。我相信團隊對他們的成果感到非常興奮。

主持人:這如何改變投資格局?那些每年在基礎設施上花費數百億美元的超大規模公司,還有為了 GPU 籌集數十億美元的 OpenAI 和 Anthropic,但 DeepSeek 告訴我們,你不一定需要這些。

Aravind Srinivas:是的。我認為很明顯,他們會在推理方面投入更多,因為他們明白,他們在過去兩年構建的東西現在變得如此便宜,已經很難證明繼續投入那麼多資金的合理性了。

主持人:推理的成本主張還一樣嗎?他們需要同樣數量的高端 GPU,還是可以像 DeepSeek 那樣用低端的?

Aravind Srinivas:再說一次,除非被證明不行,否則很難說不可能。但我猜想,為了快速前進,你會想用高端芯片,想比競爭對手走得更快。我認為最優秀的人才仍然想在率先實現突破的團隊工作。總是會有一些榮譽屬於真正的先驅者,而不是快速跟隨者。

主持人:這有點像 Sam Altman 的推文,他曾經暗示說 DeepSeek-V3 只是在複製,任何人都能複製,對吧?

Aravind Srinivas:但在這個領域,每個人都在複製別人。你可以說 Google 最先提出了 Transformer,不是 OpenAI,OpenAI 只是複製了它。Google 構建了第一個大語言模型,他們沒有產品化,但 OpenAI 以產品的方式做到了。所以你可以從很多角度來說這個問題。這都不重要。

資料參考: