能思考會搜索的國產大模型,全網瘋測的 DeepSeek 牛在哪?

IT之家的家友們,蛇年吉祥!

在這個農曆新年期間,科技界卻並不平靜…

距離 OpenAI 發佈由 GPT-3.5 模型驅動的 ChatGPT 聊天機器人,已經過去了兩年多的時間。

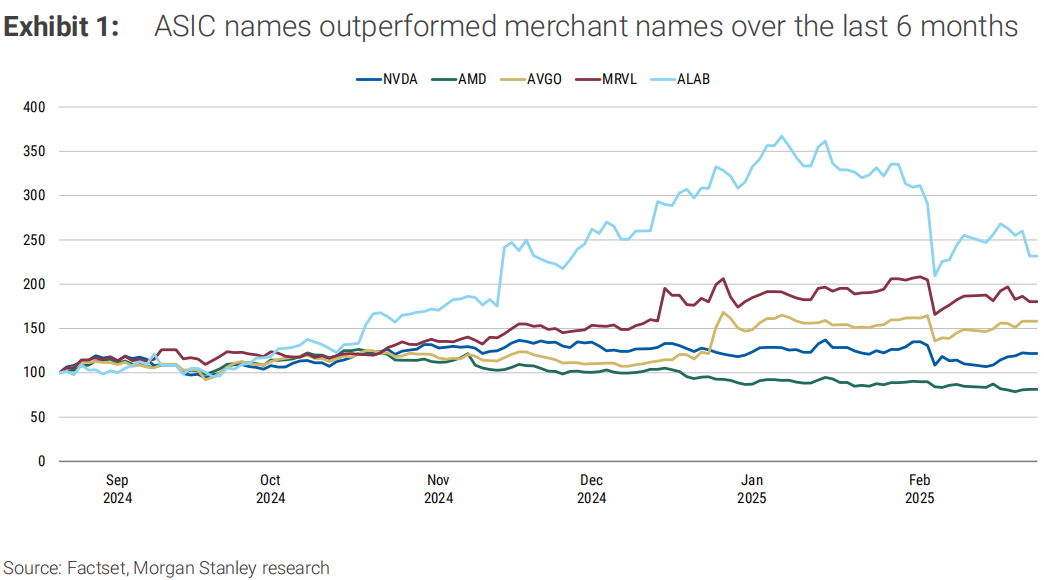

在這兩年間,不管是微軟、Google這樣的科技巨頭,還是如雨後春筍般出現的初創企業,都在 AI 大模型領域,投入了巨額的資源。

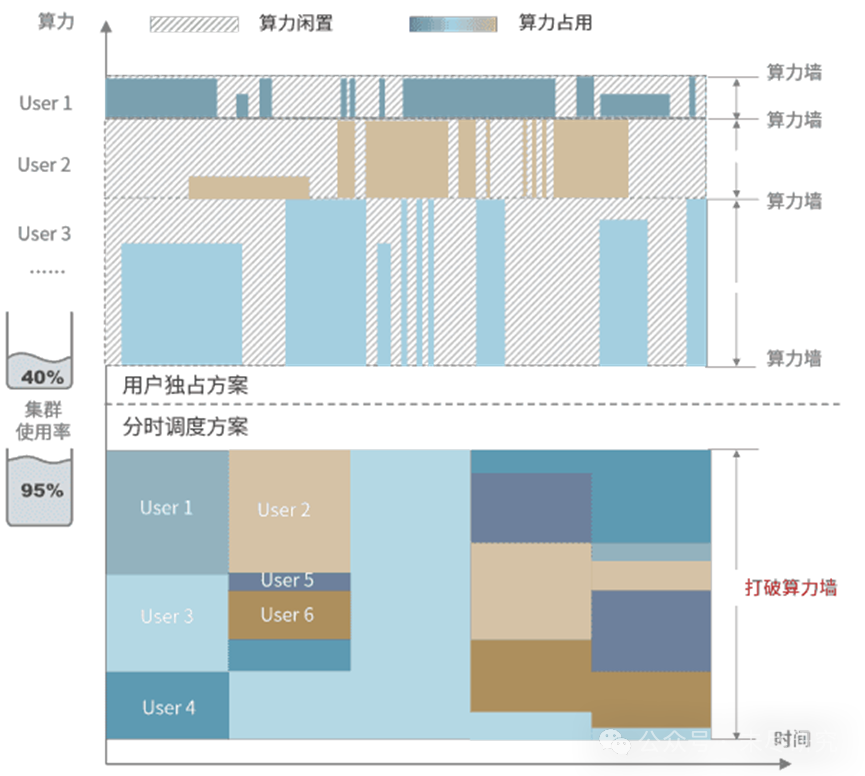

算力逐漸膨脹,大模型的訓練及推理成本也同樣水漲船高。

OpenAI 去年推出的 ChatGPT Pro 會員,價格已經來到了每月 200 美元。

「屠龍者終成惡龍」,每月 20 美元的 ChatGPT Plus 會員,包含的 o1 模型使用次數,可以說僅僅只夠「玩一玩」,很難真的應用於自己的工作之中。

如果未來成本進一步上漲,難道 AI 的未來,是每月 2000 美元的「ChatGPT Pro Max 會員」嗎?

然而,一家來自杭州的「小公司」 DeepSeek,卻給整個 AI 行業帶來了新思路,這兩天可以說是火遍了全網。IT之家這就來跟大家一起看看是怎麼回事。

01. 用起來怎麼樣?

去年年底,DeepSeek-V3 模型發佈,其多項評測成績超越了 Qwen2.5-72B 和 Llama-3.1-405B 等其他開源模型,並在性能上和閉源模型 GPT-4o 以及 Claude-3.5-Sonnet 不分伯仲。

作為一款開源的 MoE 混合專家模型,DeepSeek-V3 當時獲得了業內人士不少的關注,但是還並沒有「出圈」。

不過,在 DeepSeek 官方的手機應用 1 月上旬上線之前,已經有一些山寨 App 準備湊熱度了。

▲ 極速推出的的山寨應用

▲ 極速推出的的山寨應用而 1 月 20 日發佈的推理模型 DeepSeek-R1,則在性能上實現了對 OpenAI-o1 正式版的對標。

此外,DeepSeek 也並沒有藏著掖著,同期公開了 DeepSeek-R1 的訓練技術,並且開源了模型權重。

而且對我們普通用戶來說,DeepSeek-R1 直接在其官網免費開放使用。

而且,DeepSeek-R1 還可以聯網搜索信息,增加了不少使用上的靈活性。

要知道,去年 10 月 31 號上線的 ChatGPT Search 搜索功能目前還不支持與 ChatGPT o1 模型協同使用,我們只能退而求其次選擇 4o 模型。

此外,作為一款採用 CoT 思維鏈技術的推理模型,DeepSeek-R1 直接把其思考過程顯示給用戶,這一點令我們可以直觀感受到目前大模型技術的實力。

在海內外全網爆火的同時,DeepSeek 也承受了非常大的壓力,相信我們不少家友都對下面這句話非常熟悉。

除了大量用戶的湧入,DeepSeek 甚至還承受了大規模的惡意攻擊。

要知道,即便是 ChatGPT,也經常出現宿機事件,這方面也希望大家可以「理解萬歲」。

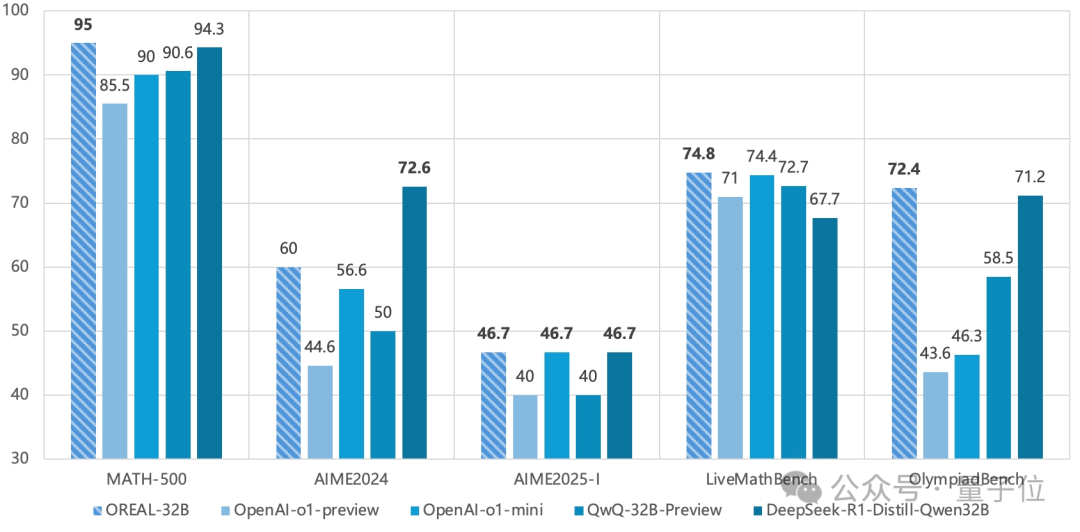

除了 671B 參數的完整模型,DeepSeek 還蒸餾了好幾款小模型,32B 和 70B 模型也在多項能力上實現了對標 OpenAI o1-mini 的效果。

而這些蒸餾後的模型,我們已經可以嘗試在自己的設備上,本地進行運行。

02. 兩把殺手鐧

– MoE 混合專家模型

DeepSeek-R1 的成本優勢,便在其官方 API 服務定價中體現了出來:

-

每百萬輸入 tokens:1 元(緩存命中)/ 4 元(緩存未命中)

-

每百萬輸出 tokens:16 元

其輸出 API 價格,甚至只是 ChatGPT o1 的約 3%,這就要聊到 MoE 混合專家模型了。

IT之家前面提到,DeepSeek-R1 是一款 671B 參數的模型,從傳統的角度來看,運行起來絕不會輕鬆。

而 MoE 架構的核心思想,其實就是將一個複雜的問題分解成多個更小、更易於管理的子問題,並由不同的專家網絡分別處理。

這樣,當我們向 MoE 模型輸入提示時,查詢不會激活整個 AI,而只會激活生成響應所需的特定神經網絡。

因此,R1 和 R1-Zero 在回答提示時激活的參數僅為 37B,不到其總參數量的十分之一,「讓專業的人幹專業的事」,推理成本大大降低。

其實,MoE 並不是一個新概念,最早起源於 1991 年的論文《Adaptive Mixture of Local Experts》。

不過這一思路的「起飛」,還要等到 2023 年 12 月 Mixtral 8x7B 模型的推出。

外界普遍認為 GPT-4 就使用了 MoE 模型,但對於已經變成「CloseAI」的 OpenAI 來說,其旗艦模型的許多技術細節,我們無從得知……

– RL 強化學習

傳統的 AI 大模型訓練,使用的是 SFT 監督微調過程,在精心策劃的數據集上訓練模型,教會它們逐步推理。

而 DeepSeek-R1 則使用 RL 強化學習的方法,完全依賴環境反饋(如如問題的正確性)來優化模型行為。

它也第一次證明了通過純 RL 訓練,即可提升模型的推理能力。模型在 RL 訓練中自主發展出自我驗證、反思推理等複雜行為,達到 ChatGPT o1 級別的能力。

這項技術,說明我們未來在訓練的過程中,可能不再需要付出極為高昂的成本,獲取大量經過詳細標註的高質量數據。

03. 多模態,補短板

儘管 DeepSeek-V3 和 DeepSeek-R1 十分強大,但他們還都是名副其實的「大語言模型」,並不具有多模態的能力。

也就是說,我們目前還沒發把圖片、音頻等信息丟給他們,他們也不具備生成圖片的能力,只能通過文字的方式來進行信息交流。

目前 DeepSeek 官方提供的文件上傳能力,其實只是走了一遍文字 OCR 識別。

不過,就在 1 月 28 日淩晨,DeepSeek 開源了全新的視覺多模態模型 Janus-Pro-7B。

與以往的方法不同,Janus-Pro 通過將視覺編碼過程拆分為多個獨立的路徑,解決了以往框架中的一些局限性,同時仍採用單一的統一變換器架構進行處理。

這一解耦方式不僅有效緩解了視覺編碼器在理解和生成過程中可能出現的衝突,還提升了框架的靈活性。

Janus 的表現超越了傳統的統一模型,並且在與任務特定模型的比較中也同樣表現出色。憑藉其簡潔、高靈活性和高效性的特點,Janus-Pro 成為下一代統一多模態模型的有力競爭者。

其在 GenEval 和 DPG-Bench 基準測試中擊敗了 Stable Diffusion 和 OpenAI 的 DALL-E 3。

不過作為一款僅有 7B 參數的「小」模型,Janus-Pro 目前只能處理 384 x 384 解像度的圖像。

但我們相信,這隻是一道開胃菜,我們期待在新思路下,DeepSeek 未來多模態大模型的表現。

04. 除夕不眠夜

DeepSeek 的爆火,讓不少 AI 大模型領域的「友商」,都沒法無視這樣一家「小公司」。

今天(1 月 29 日)淩晨,農曆新年的鍾聲剛剛敲響,阿裡通義團隊帶來了他們的「新年禮物」—— Qwen2.5-Max 模型。

通義千問團隊,也在 Qwen2.5-Max 模型的介紹中提到了 DeepSeek-V3。

近期,DeepSeek V3 的發佈讓大家瞭解到超大規模 MoE 模型的效果及實現方法,而同期,Qwen 也在研發超大規模的 MoE 模型 Qwen2.5-Max,使用超過 20 萬億 token 的預訓練數據及精心設計的後訓練方案進行訓練。

與業界領先的模型(包括 DeepSeek V3、GPT-4o 和 Claude-3.5-Sonnet)相比,Qwen2.5-Max 的性能表現也相當有競爭能力。

在基座模型的對比中,與目前領先的開源 MoE 模型 DeepSeek V3、最大的開源稠密模型 Llama-3.1-405B 相比,Qwen2.5-Max 在大多數基準測試中都展現出了優勢。

目前 Qwen2.5-Max 已經面向用戶開放,不過作為「Max」定位的模型,Qwen2.5-Max 暫未開源。

而與 DeepSeek-R1 的直接對決,我們可能要等到未來新版的 QwQ、QVQ 模型。

OpenAI 的 CEO 阿爾特曼也對 DeepSeek-R1 進行了評價:

▲ 很「官方」的標準回答

▲ 很「官方」的標準回答面對大家價格上的抱怨,阿爾特曼也表示未來的 ChatGPT o3-mini 模型將會開放給免費用戶使用,Plus 會員則每天有 100 條請求的額度。

此外,新的 ChatGPT Operator 功能也將盡快向 Plus 會員開放,而 OpenAI 的下一款模型也不會由每月 200 美元的 Pro 會員獨佔,Plus 會員就能用

這究竟是來自於 DeepSeek 等競爭對手的壓力,還是 OpenAI 自身的成本優化,我們不得而知。

我們期待著在 2025 年,還會有哪些關鍵領域的突破,AGI 通用人工智能是不是也離我們越來越近了。