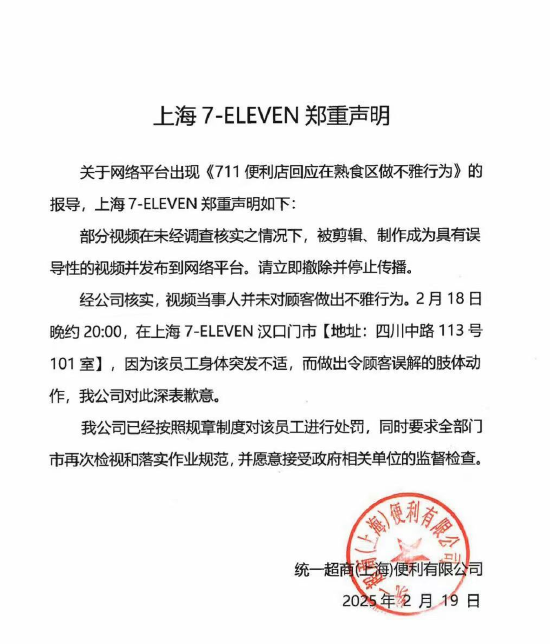

為什麼說DeepSeek的R1-Zero比R1更值得關注?

選自ARC Prize博客

作者:Mike Knoop

機器之心編譯

R1-Zero 等模型正在打破人類數據瓶頸,開啟 AI 自我進化新範式?

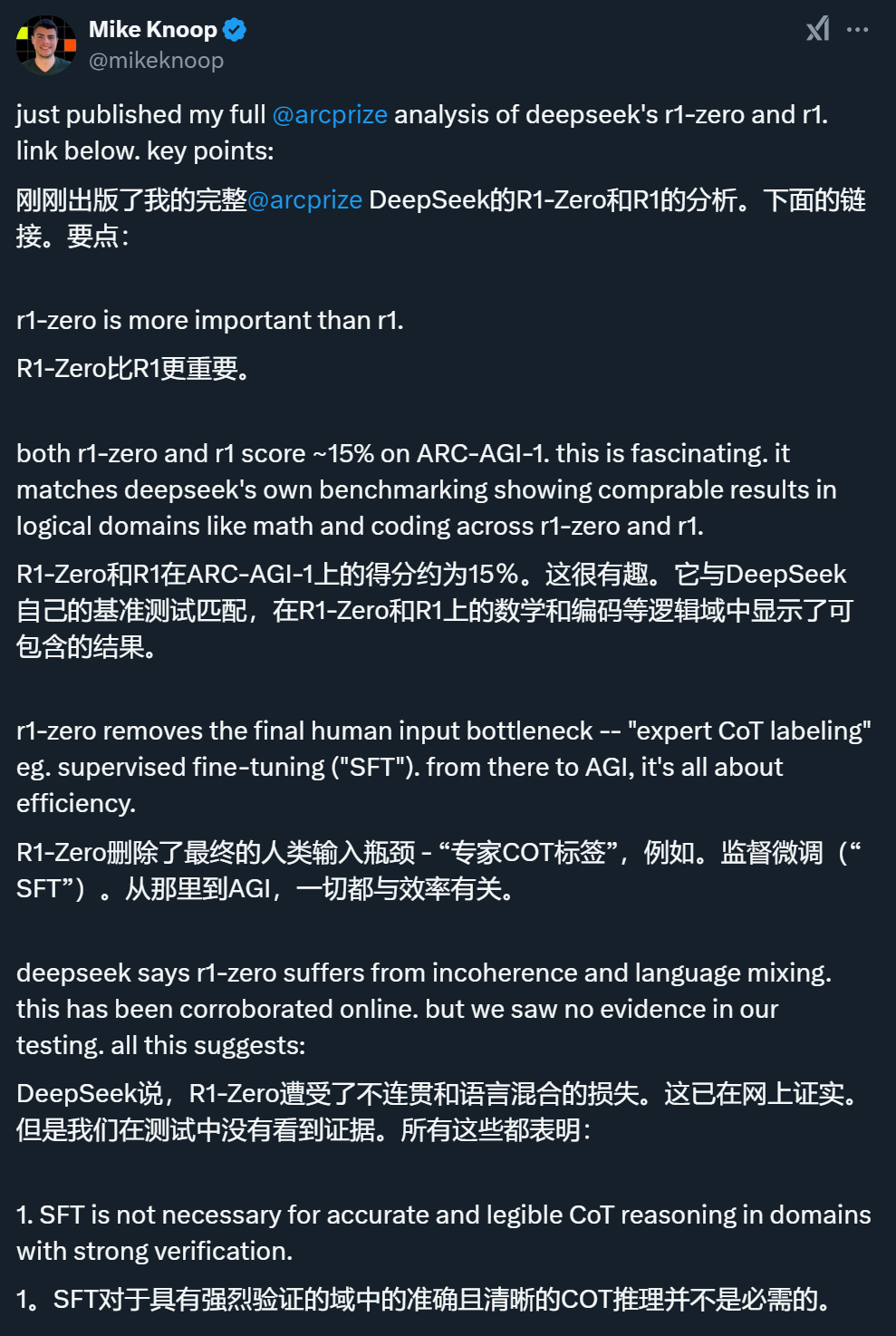

「比起 R1,DeepSeek 同一時間發佈的 R1-Zero 更值得關注。」這是 ARC Prize 聯合創始人 Mike Knoop 在一篇新博客中發表的觀點。

他認為,R1-Zero 之所以比 R1 更值得分析,是因為它完全依賴強化學習(RL),而不使用人類專家標註的監督微調(SFT),這表明在某些任務中,人類標註並非必要,且未來可能通過純 RL 方法實現更廣泛的推理能力。

此外,R1 和 R1-Zero 的成功還能讓我們讀出一些信息,比如:

-

通過投入更多計算資源,AI 系統的準確性和可靠性可以顯著提升,這將增強用戶對 AI 的信任,推動商業化應用。

-

推理過程正在生成大量高質量的訓練數據,且這些數據由用戶付費產生,這種「推理即訓練」的新範式可能徹底改變 AI 數據經濟的運作方式,形成自我強化的循環。

以下是博客內容:

R1-Zero 比 R1 更值得分析

上週,DeepSeek 發佈了他們新的「推理」系統 R1-Zero 和 R1,兩個模型在 ARC-AGI-1 上的得分與 OpenAI 的 o1 系統低計算量版本相當。R1-Zero、R1 和 o1(低計算量模式)的得分都在 15-20% 左右。相比之下,純 LLM scaling 多年積累的頂點 GPT-4o 僅為 5%。根據本週美國市場反應,公眾也開始理解純 LLM scaling 的局限性。然而,對即將到來的推理需求,公眾仍普遍認識不足。

2024 年 12 月,OpenAI 宣佈了一個經過驗證的新突破性系統 o3。該系統在低計算量模式下得分為 76%,在高計算量模式下得分為 88%。o3 系統展示了計算機適應新穎未見問題的首個實用、通用實現。

儘管 o3 在 ARC-AGI-1 上取得勝利是重大科技新聞,但主流媒體幾乎未予報導。

這是 AI 領域和計算機科學的一個極其重要的時刻,這些系統值得研究。但由於 o1/o3 的封閉性質,只能依靠推測。得益於 ARC-AGI-1 和現在(幾乎)開源的 R1-Zero 和 R1,我們可以增進對此的理解(說「幾乎」是因為 DeepSeek 沒有發佈一個可複現的方式來從頭開始生成他們的模型權重)。特別是,R1-Zero 比 R1 重要得多。

在對 o1 和 o3 的分析中,ARC Prize 團隊針對這些推理系統的工作原理進行了推測。他們認為,這些模型的關鍵思路可能是:

為問題域生成思維鏈(CoT)。

使用人類專家(「監督微調」或 SFT)和自動化機器(強化學習(RL))的組合來標註中間 CoT 步驟。

使用(2)得到的數據訓練基礎模型。

在測試時,從過程模型中進行迭代推理。

下圖回顧了各模型迭代采樣所使用的技術及其在 ARC-AGI-1 上的得分:

圖上顯示的是 ARC-AGI-1 半私有分數。

圖上顯示的是 ARC-AGI-1 半私有分數。有了 DeepSeek 新發表的研究,ARC Prize 團隊可以更好地為自己的猜測提供信息。這裏的關鍵見解是,LLM 推理系統實現更高程度地適應新任務的能力(和可靠性)是通過三個維度實現的:

在 CoT 過程模型訓練中添加人類標籤(即 SFT);

使用 CoT 搜索而不是線性推理(並行逐步 CoT 推理);

整體 CoT 采樣(並行軌跡推理)。

維度 1 受限於人類數據生成,並限制了這些推理系統在哪些領域收益最大。例如,o1 在 MMLU 專業法律類別上的表現出人意料地比數學和邏輯要低得多。

維度 2、3 受限於效率。o1 和 o3 在測試時都顯示了隨著推理計算量的增加,在 ARC-AGI-1 上的基準準確率呈對數增長,而不同的計算資源分配策略會影響達到同樣性能水平所需要的具體計算量。

在該團隊看來,DeepSeek 最有趣的做法是單獨發佈 R1-Zero。R1-Zero 是一個不使用 SFT(維度 1)的模型,而是完全依賴於強化學習。

R1-Zero 和 R1 在 ARC-AGI-1 上的得分高度一致,分別為 14% 和 15.8%。DeepSeek 自己報告的基準測試分數也顯示 R1-Zero 和 R1 高度一致,例如在 MATH AIME 2024 上的得分分別為 71% 和 76%(相比基礎 DeepSeek V3 的約 40% 有所提升)。

在論文中,R1-Zero 的作者提到「DeepSeek-R1-Zero 面臨可讀性差、語言混雜等挑戰」,這一點已在網上得到證實。然而在測試中,ARC Prize 團隊在測試 R1-Zero 在 ARC-AGI-1 上的表現時幾乎沒有發現不連貫的證據,這與系統經過 RL 訓練的數學和代碼領域相似。

綜合這些發現,ARC Prize 團隊得出結論:

-

在那些能夠清晰判斷對錯的領域中 ,SFT(如人類專家標註)對於準確和易讀的 CoT 推理並非必需。

-

R1-Zero 訓練過程能夠通過 RL 優化在 token 空間中創建自己的內部領域特定語言(DSL)。

-

SFT 是提高 CoT 推理領域泛化性的必要條件。

這很符合直覺,因為語言本身實際上就是一個推理 DSL。完全相同的「詞語」可以在一個領域中學習並應用到另一個領域,就像程序一樣。純 RL 方法還不能發現廣泛共享的詞彙表,預計這將成為未來研究的重點。

最終,R1-Zero 展示了一個潛在 scaling 機制的原型,該機制完全沒有人類瓶頸 —— 甚至在訓練數據獲取本身也是如此。

幾乎可以肯定的是,DeepSeek 已將目標對準了 OpenAI 的 o3 系統。重要的是要關注 SFT 是否最終會成為添加 CoT 搜索和采樣的必要條件,或者假設的「R2-Zero」是否可能沿著相同的對數準確率與推理 scaling 曲線存在。基於 R1-Zero 的結果,ARC Prize 團隊認為在這個假設的 scaled up 版本中,要在 ARC-AGI-1 上挑戰成功並不需要 SFT。

燒錢換信任:AI 可靠性被標價

從經濟角度來看,AI 領域正在發生兩個重大轉變:

-

現在可以花更多錢來獲得更高的準確性和可靠性;

-

訓練成本正在轉向推理成本。

這兩者都將推動對推理的大量需求,而且都不會抑制對更多計算能力的需求。實際上,它們將增加對計算能力的需求。

AI 推理系統帶來的價值遠不止提高基準測試的分數那麼簡單。阻礙更多 AI 自動化使用(例如推理需求)的首要問題是可靠性。ARC Prize 團隊與數百位試圖在業務中部署 AI 智能體的 Zapier 客戶交談,反饋高度一致:「我還不信任它們,因為它們工作不可靠」。

此前 ARC Prize 團隊認為,模型在 ARC-AGI 方面的進展將提高可靠性。LLM 智能體的挑戰在於它們需要強大的本地領域引導才能可靠工作。更強的泛化能力需要適應未見情況的能力。現在有證據表明 ARC Prize 團隊的觀點是正確的。因此,多家公司(Anthropic、OpenAI、Apple 等)現在推出智能體也就不足為奇了。

出於可靠性需求,智能體將推動近期推理需求的顯著增長。更廣泛地說,開發者可以選擇花費更多計算來增加用戶對系統的信任。提高可靠性並不代表能做到百分百正確,但至少能保證即使犯錯,也是以一種可預期的方式犯錯。這沒有問題,因為當準確率低時,用戶和開發者現在可以通過提示更自信地引導行為。

以前計算機無法解決的問題現在都有了對應的價格標籤。隨著效率的提高,這些價格會降低。

推理即訓練:推理將成 AI 模型的「數據永動機」?

另一個正在發生的重大轉變是進入 LLM 系統預訓練的數據來源。此前,大多數數據要麼是購買的,要麼是抓取的,要麼是從現有 LLM 合成生成的(例如蒸餾或增強)。

這些推理系統提供了一個新選擇,即生成「真實」數據而不是「合成」數據。AI 行業使用「合成」一詞來指代通常通過 LLM 循環來增加整體訓練數據量的低質量數據,但收益遞減。

但現在,通過推理系統和驗證器,我們可以創造全新的、有價值的訓練數據。這種數據的產生有兩種方式:要麼是開發者提前付費生成,要麼是在用戶實際使用系統時由用戶付費生成!

這是一個引人深思的經濟模式轉變,暗示著擁有最多付費用戶的 AI 系統開發商可能會擁有一個實力快速積累的關鍵時刻。這些付費用戶實際上在為創造新的高質量數據買單..…… 這些數據又會讓模型變得更好..…… 更好的模型會吸引更多用戶青睞..…… 如此形成良性循環。

如果能夠突破人類專家 CoT 障礙,創建一個極其高效的系統,通過搜索 / 合成和驗證來創建新數據,那麼應該預期會有大量計算投入這些推理系統,因為它們實際上只需要輸入資金和原始數據就能變得更好。最終,這種類型的 AI 訓練將完全超越在人類生成數據上進行的預訓練。

結論:DeepSeek 推動了科學的前沿

隨著推理需求增加變得明顯,市場調整將繼續發生。AI 系統效率只會推動更多使用,這不僅是由於傑文斯悖論,還因為效率提高時新的訓練機制被解鎖(註:傑文斯悖論指的是:當技術進步提高了資源使用效率時,反而可能導致該資源的總消耗量增加,而不是減少)。

隨著 R1 的開源和可複現,更多人和團隊將把 CoT 和搜索推向極限。這將更快地告訴我們前沿實際在哪裡,並將推動一波創新浪潮,增加快速實現 AGI 的機會。

已經有多人告訴 ARC Prize 團隊,他們計劃在 ARC Prize 2025 中使用 R1 風格的系統。

R1 的開源對世界來說是一件好事。DeepSeek 推動了科學的前沿。

原文鏈接:https://arcprize.org/blog/r1-zero-r1-results-analysis