模態GAP不存在了?圖文領域首個token級大一統基座誕生

CLIP、DINO、SAM 基座的重磅問世,推動了各個領域的任務大一統,也促進了多模態大模型的蓬勃發展。

然而,這些經過圖像級監督或弱語義訓練的基座,並不是處理細粒度密集預測任務的最佳選擇,尤其在理解包含密集文字的文檔圖像上。

為解決這一限制,上交聯合美團實現了圖文對齊粒度的新突破,其具備三大核心優勢:

-

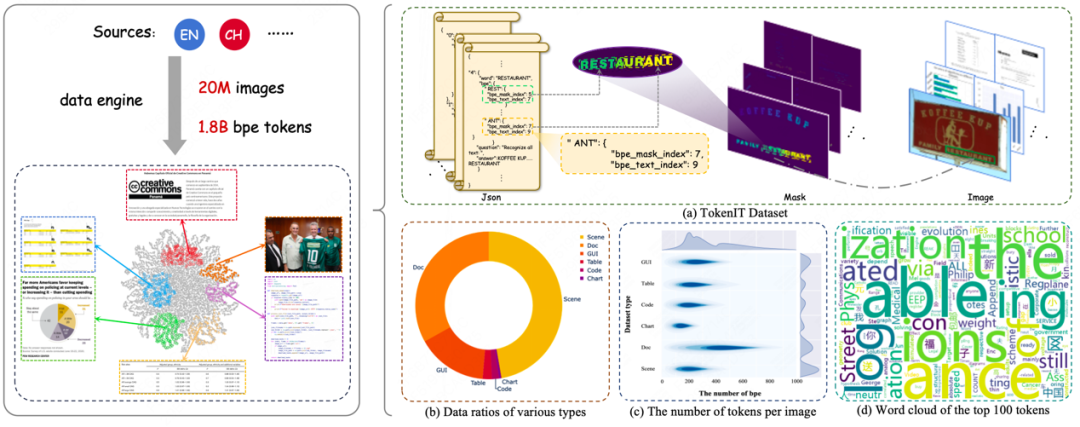

構建業內首個 token 級圖文數據集 TokenIT:該數據集包含 2000 萬條公開圖像以及 18 億高質量的 Token-Mask 對。圖像中的每個 BPE 子詞均對應一個像素級掩碼。數據體量是 CLIP 的 5 倍,且比 SAM 多出 7 億數據對。

-

構建圖文領域首個細粒度大一統基座 TokenFD:僅需通過簡單的一層語言編碼,依託億級的 BPE-Mask 對打造出細粒度基座 TokenFD。真正實現了圖像 Token 與語言 Token 在同一特徵空間中的共享,從而支持 Token 級的圖文交互和各種下遊任務。

-

TokenVL 打通模態 GAP:進一步開放圖像即文本的語義潛力,首次實現在大語言模型中進行 token 級的模態對齊,賦能密集型的多模態文檔理解任務。

論文和 demo 已發佈,相關數據、模型及代碼資源將陸續向社區全面開放。

-

項目主頁:https://token-family.github.io/project_page/

-

體驗地址:https://huggingface.co/spaces/TongkunGuan/Token-level_Text_Image_Foundation_Model

-

GitHub:https://github.com/Token-family/TokenFD

-

論文地址: https://arxiv.org/pdf/2503.02304

首個 Token 級圖文數據集 TokenIT

據不完全統計,大約 30% 至 40% 的互聯網圖像包含可識別的文字,而這一比例在社交媒體平台上更為顯著。

如何有效利用這些數據來增強行業基礎 AI 生態的發展,一直是研究者們持續探索的方向。然而,目前真實場景數據中的文字標籤多為單詞級或行級,這與大語言模型所採用的 BPE token 編碼規則不完全兼容。

此類數據集的不足,不僅限制了視覺基礎模型在細粒度視覺感知方面的表現,也影響了多模態大語言模型在視覺與語言模態間的對齊能力。

為瞭解決這一限制,他們採用自研的 token 級的視覺語言分詞打標技術,提出了業內首個 token 級別的圖像文本數據集,填補了這一領域的數據空白,其亮點包括:

規模與多樣性

-

包含 2000 萬張圖像與 18 億 Token-Mask 對,覆蓋自然場景、文檔、圖表、代碼截圖、圖形用戶界面等全場景文本圖像類型。

-

數據量遠超 CLIP(5 倍)、SAM(多 7 億),提供更豐富的語義信息。

細粒度對齊

-

首創 BPE 分詞 + 像素級掩碼標註:將文本分割為 BPE 子詞(如「un-」、「-able」),每個子詞(token)精確對應圖像中的局部區域。

-

支持「圖像即文字」的語義映射,為多模態大模型理解字符、公式、表格等複雜結構奠定基礎。

首個細粒度基座 TokenFD

先前的視覺基座模型(如 CLIP、DINO)依賴圖像級監督,難以捕捉文檔、表格等場景中的密集小文本語義,導致下遊任務(如 OCR、視覺問答)性能受限。

SAM 具備像素級的分割能力,其受限的語義表示限制了其在文本圖像場景的全生態應用。依託自主研發的數億級 BPE-Mask 對,他們首次實現了 token 級的視覺和語言模態對齊,支持細粒度交互,填補了這一技術空白。

在實現上,TokenFD 並不依賴複雜的語言編碼器,而是通過簡化的 token embedding layer,將視覺編碼器提取的視覺特徵映射到語言編碼空間。

對於 token 級的視覺和語言特徵,正樣本對確保數值與方向相似,而負樣本對則相反。在百億級 token-mask 數據的顯式監督下,TokenFD 真正實現了「圖像即文字」,其亮點包括:

支持多任務

-

文本分割(Zero-Shot 性能提升 18.78%)

-

文本理解(Zero-Shot 性能提升 1.48%)

-

文本檢索(Zero-Shot 性能提升 50.33%)

-

未來盼望他們支持可控文本生成/擦除等更多任務

推動 MLLM 發展

-

賦能多模態大模型(例如 TokenVL)細粒度文字感知能力,顯著提升 OCR、文檔解析等任務表現。

商業化應用

-

圖像安全審查

-

基於文字的圖像檢索(適用於搜索引擎、電商平台、社交平台)

-

知識檢索增強的大模型

據瞭解,demo 已在 Hugging Face 上線,歡迎體驗。它突破了傳統基於文字識別的圖文檢索方式,通過特徵空間直接進行相似度匹配,支持任意文字輸入進行圖像內容查找。

文檔理解多模態大模型 TokenVL

通用視覺基礎模型在多模態大語言模型中作為圖像編碼器被廣泛應用,推動了圖像理解能力的快速發展。

然而,現有的視覺模型在涉及圖像中細粒度文本(如密集小文本)的下遊任務中仍面臨顯著挑戰,例如文本感知、理解與推理的準確性不足。

這一問題的根源在於當前基座模型缺乏針對文本密集場景的細粒度語義監督,導致在文檔理解、圖文問答等實際場景中頻繁出現預測偏差。

因此作者們系統性地探索了 TokenFD 作為基座模型在通用文檔智能領域的潛力。

-

基座適配度百分百

無需額外訓練,TokenFD 可直接替換其他多模態大模型的基座,各項評估基準都得到了提升。

-

文檔理解多模態大模型對齊新範式

基於 TokenFD 作為視覺基礎模型,作者們進一步推出了 TokenVL,一種全新的多模態大模型圖文對齊預訓練範式。

通過利用 TokenIT 作為預訓練數據,創新性地通過索引方法提取大語言模型(LLM)中的語言 token,並將其與圖像特徵圖中對應的圖像 token 直接匹配,在此過程中引入約束函數以實現精準對齊。

這一方法允許 LLM 在回答問題時能夠更直接地參考圖像內容,而不僅僅依賴於其強大的語義上下文理解能力,尤其在理解答案的空間位置時更具優勢。在多個 UDV 數據集上進行了評測,結果顯示出卓越的性能和令人滿意的效果。

更多方法和實驗細節請參照論文。