全棧自研,理想發佈下一代自動駕駛架構 MindVLA

【編者按】理想汽車發佈下一代自動駕駛架構MindVLA,這是一個融合視覺、語言和行為智能的機器人大模型新範式。MindVLA賦予車輛強大的3D空間理解、邏輯推理和行為生成能力,使其能夠感知、思考並適應環境。該架構通過3D高斯表示、MoE混合專家架構的LLM基座模型、Diffusion軌跡優化等關鍵技術,實現了模型參數規模與實時推理性能的平衡。

2025年3月18日,理想汽車自動駕駛技術研發負責人賈鵬在NVIDIA GTC 2025發表主題演講《VLA:邁向自動駕駛物理智能體的關鍵一步》,分享了理想汽車對於下一代自動駕駛技術MindVLA的最新思考和進展。

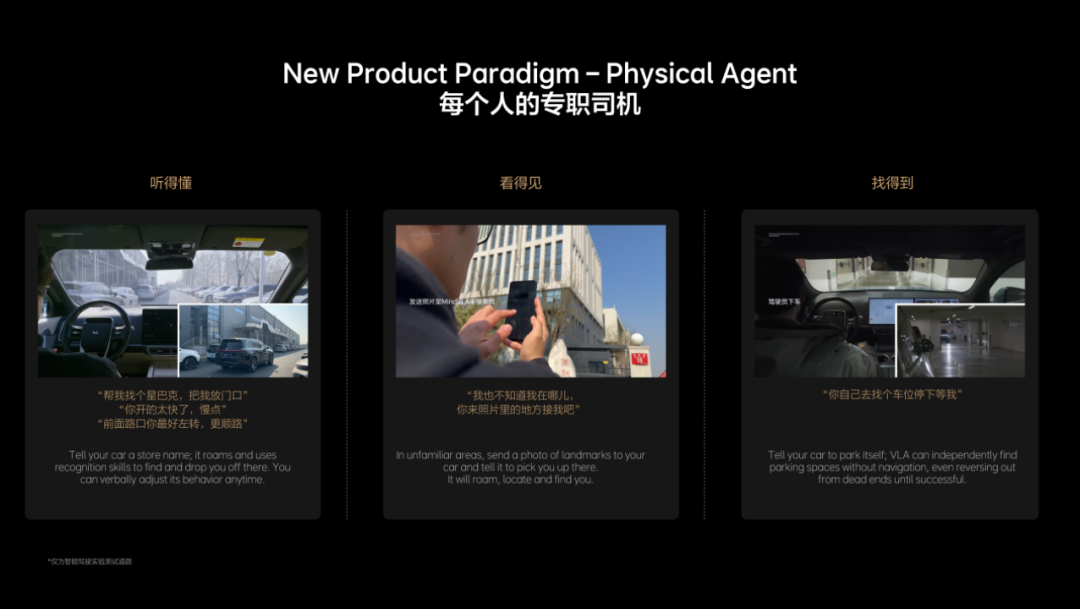

賈鵬表示:「MindVLA是機器人大模型,它成功整合了空間智能、語言智能和行為智能,一旦跑通物理世界和數字世界結合的範式後,將有望賦能更多行業。MindVLA將把汽車從單純的運輸工具轉變為貼心的專職司機,它能聽得懂、看得見、找得到。我們希望MindVLA能為汽車賦予類似人類的認知和適應能力,將其轉變為能夠思考的智能體。」

理想全棧自研MindVLA 深度融合空間、語言及行為智能

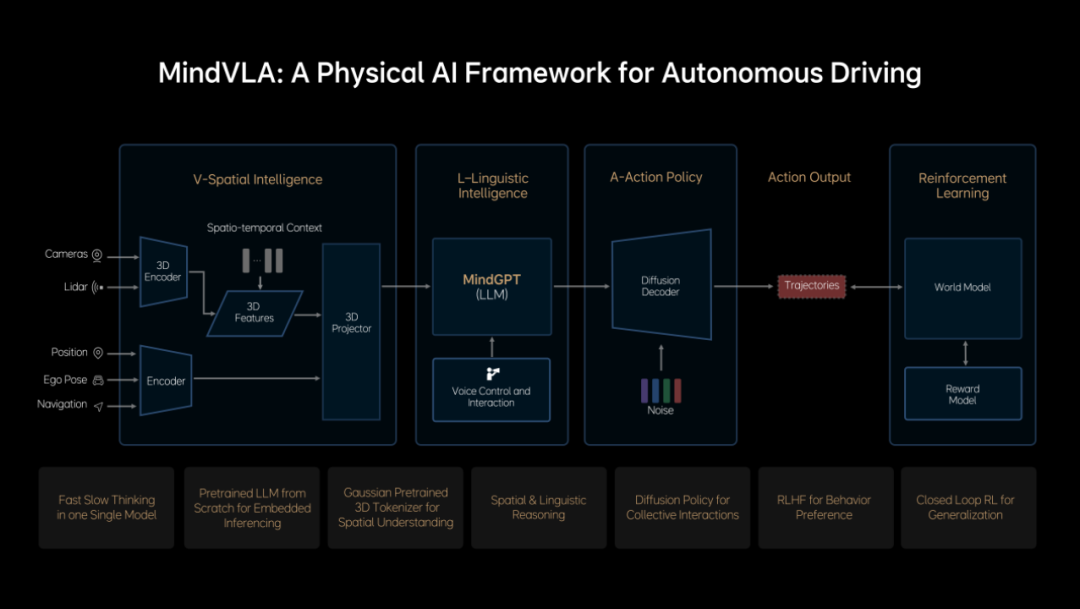

基於端到端+VLM雙系統架構的最佳實踐,及對前沿技術的敏銳洞察,理想自研VLA模型——MindVLA。VLA是機器人大模型的新範式,其將賦予自動駕駛強大的3D空間理解能力、邏輯推理能力和行為生成能力,讓自動駕駛能夠感知、思考和適應環境。

MindVLA不是簡單地將端到端模型和VLM模型結合在一起,所有模塊都是全新設計。3D空間編碼器通過語言模型,和邏輯推理結合在一起後,給出合理的駕駛決策,並輸出一組Action Token(動作詞元),Action Token指的是對周圍環境和自車駕駛行為的編碼,並通過Diffusion(擴散模型)進一步優化出最佳的駕駛軌跡,整個推理過程都要發生在車端,並且要做到實時運行。

MindVLA六大關鍵技術 樹立全新技術範式

MindVLA打破自動駕駛技術框架設計的傳統模式,使用能夠承載豐富語義,且具備出色多粒度、多尺度3D幾何表達能力的3D高斯(3D Gaussian)這一優良的中間表徵,充分利用海量數據進行自監督訓練,極大提升了下遊任務性能。

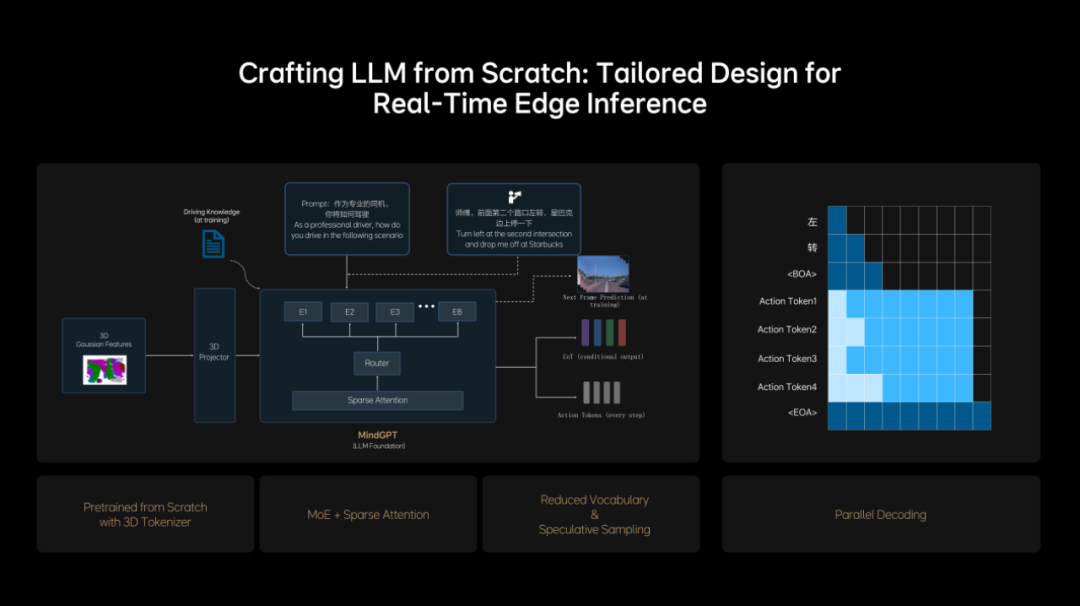

理想從0開始設計和訓練了適合MindVLA的LLM基座模型,採用MoE混合專家架構,引入Sparse Attention(稀疏注意力),實現模型稀疏化,保證模型規模增長的同時,不降低端側的推理效率。基座模型訓練過程中,理想加入大量3D數據,使模型具備3D空間理解和推理能力。為了進一步激發模型的空間智能,理想加入了未來幀的預測生成和稠密深度的預測等訓練任務。

LLM基座模型獲得3D空間智能的同時,還需要進一步提升邏輯推理能力。理想訓練LLM基座模型學習人類的思考過程,讓快慢思考有機結合到同一模型中,並可以實現自主切換快思考和慢思考。為了把NVIDIA Drive AGX的性能發揮到極致,MindVLA採取小詞表結合投機推理,以及創新性地應用並行解碼技術,進一步提升了實時推理的速度。至此,MindVLA實現了模型參數規模與實時推理性能之間的平衡。

MindVLA利用Diffusion將Action Token解碼成優化的軌跡,並通過自車行為生成和他車軌跡預測的聯合建模,提升在複雜交通環境中的博弈能力。同時Diffusion可以根據外部條件,例如風格指令,動態調整生成結果。為瞭解決Diffusion模型效率低的問題,MindVLA採用Ordinary Differential Equation(常微分方程)采樣器,實現了2-3步就能完成高質量軌跡的生成。面對部分長尾場景,理想建立起人類偏好數據集,並且創新性地應用RLHF(基於人類反饋的強化學習)微調模型的采樣過程,最終使MindVLA能夠學習和對齊人類駕駛行為,顯著提升安全下限。

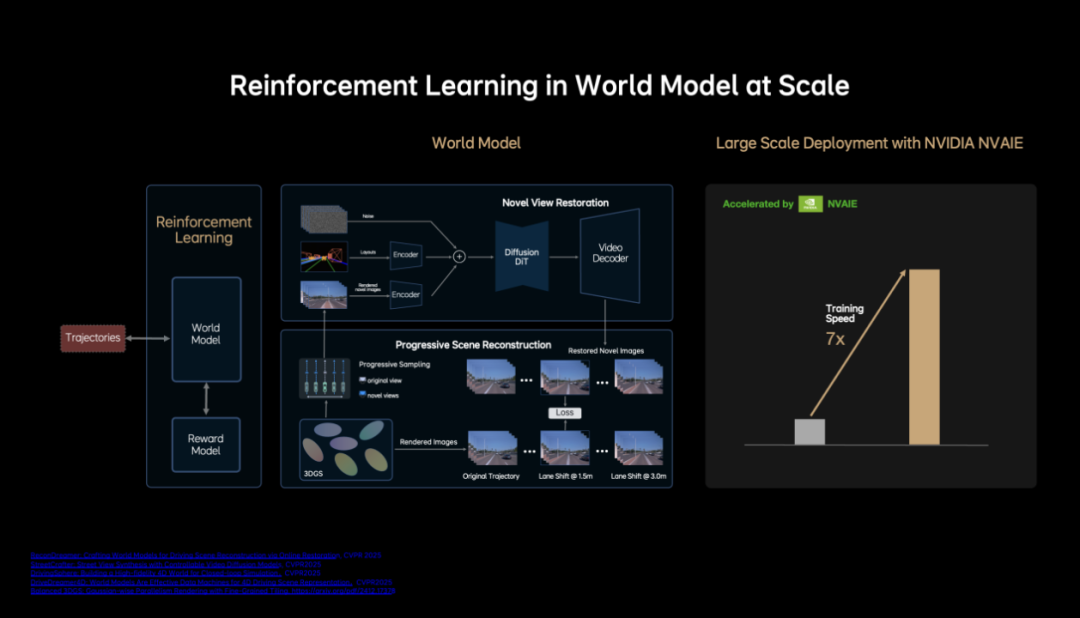

MindVLA基於自研的重建+生成雲端統一世界模型,深度融合重建模型的三維場景還原能力與生成模型的新視角補全,以及未見視角預測能力,構建接近真實世界的仿真環境。源於世界模型的技術積累與充足計算資源的支撐,MindVLA實現了基於仿真環境的大規模閉環強化學習,即真正意義上的從「錯誤中學習」。過去一年,理想自動駕駛團隊完成了世界模型大量的工程優化,顯著提升了場景重建與生成的質量和效率,其中一項工作是將3D GS的訓練速度提升至7倍以上。

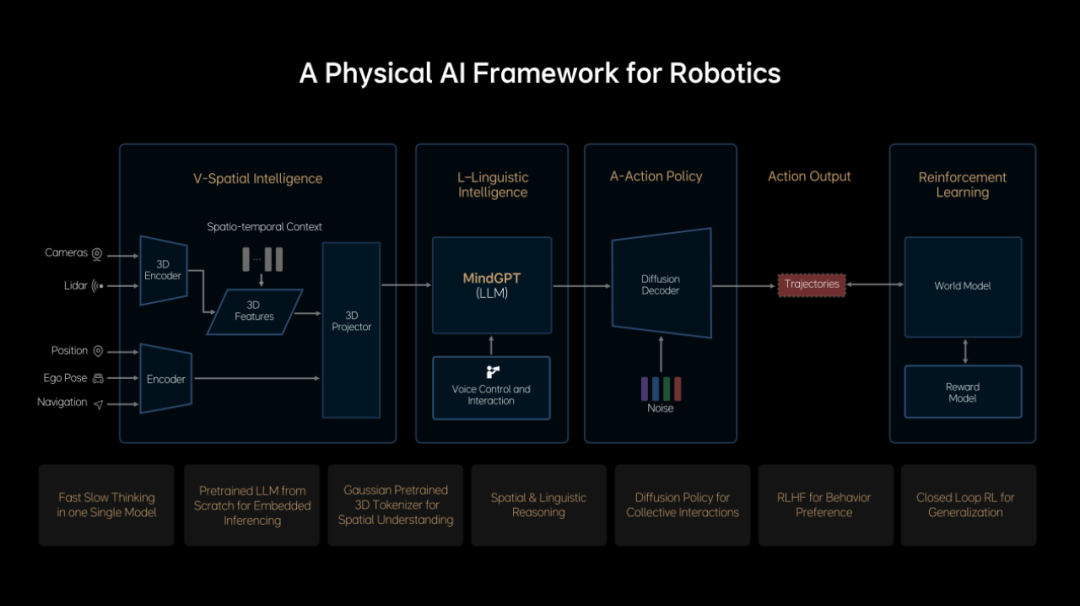

理想通過創新性的預訓練和後訓練方法,讓MindVLA實現了卓越的泛化能力和湧現特性,其不僅在駕駛場景下表現優異,在室內環境也展示出了一定的適應性和延展性。

MindVLA賦能汽車變為專職司機 重塑用戶體驗

MindVLA將為用戶帶來全新的產品形態和產品體驗,有MindVLA賦能的汽車是聽得懂、看得見、找得到的專職司機。「聽得懂」是用戶可以通過語音指令改變車輛的路線和行為,例如用戶在陌生園區尋找超市,只需要通過理想同學對車輛說:「帶我去找超市」,車輛將在沒有導航信息的情況下,自主漫遊找到目的地;車輛行駛過程中,用戶還可以跟理想同學說:「開太快了」「應該走左邊這條路」等,MindVLA能夠理解並執行這些指令。

「看得見」是指MindVLA具備強大的通識能力,不僅能夠認識星J.巴克、肯德基等不同的商店招牌,當用戶在陌生地點找不到車輛時,可以拍一張附近環境的照片發送給車輛,擁有MindVLA賦能的車輛能夠搜尋照片中的位置,並自動找到用戶。

「找得到」意味著車輛可以自主地在地庫、園區和公共道路上漫遊,其中典型應用場景是用戶在商場地庫找不到車位時,可以跟車輛說:「去找個車位停好」,車輛就會利用強大的空間推理能力自主尋找車位,即便遇到死胡同,車輛也會自如地倒車,重新尋找合適的車位停下,整個過程不依賴地圖或導航信息,完全依賴MindVLA的空間理解和邏輯推理能力。

總結來說,對於用戶而言,有MindVLA賦能的車不再只是一個駕駛工具,而是一個能與用戶溝通、理解用戶意圖的智能體;對於汽車行業而言,像iPhone 4重新定義了手機,MindVLA也將重新定義自動駕駛;對於人工智能領域而言,汽車作為物理人工智能的最佳載體,未來探索出物理世界和數字世界結合的範式,將有望賦能多個行業協同發展。

由 CSDN&Boolan 聯合舉辦的「2025 全球機器學習技術大會」將於 4 月 18-19 日在上海隆重舉行。大會雲集院士、10 所高校科研工作者、近 30 家一線科技企業技術實戰專家組成的超 50 位重磅嘉賓。他們將以獨特的視角,解讀智能體、聯邦學習、多模態大模型、強化學習等前沿議題。無論你是科研學者、技術專家,還是行業從業者,都將在這裏收穫前沿洞見和實踐經驗,共同推動 AI 時代的技術變革與應用落地。