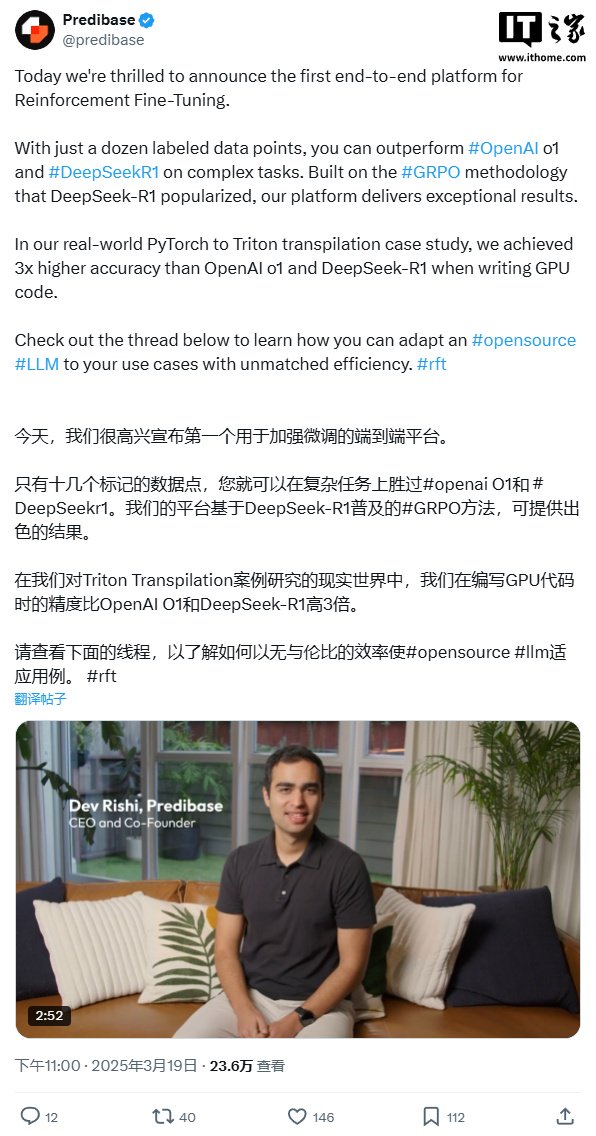

感謝 DeepSeek:Predibase 發佈全球首個端到端強化微調平台並開源,支持無服務器和端到端訓練方法

IT之家 3 月 20 日消息,昨日晚間,大模型訓練、開發平台 Predibase 發佈了首個端到端強化微調平台(RFT)。

Predibase 表示,DeepSeek-R1 的開源在全球 AI 領域產生了巨大影響,讓很多人意識到強化學習微調對訓練大模型的重要性。受此啟發,他們開發了這個端到端無服務器強化微調平台。

與傳統的監督式微調相比,RFT 不依賴大量的標註數據,而是通過獎勵和自定義函數來完成持續地強化學習,同時支持無服務器和端到端訓練方法,從數據管理、訓練模型到應用部署可以在同一個平台完成。用戶只需要一個瀏覽器,設定微調目標、上傳數據、就能完成以前非常複雜的大模型微調流程。

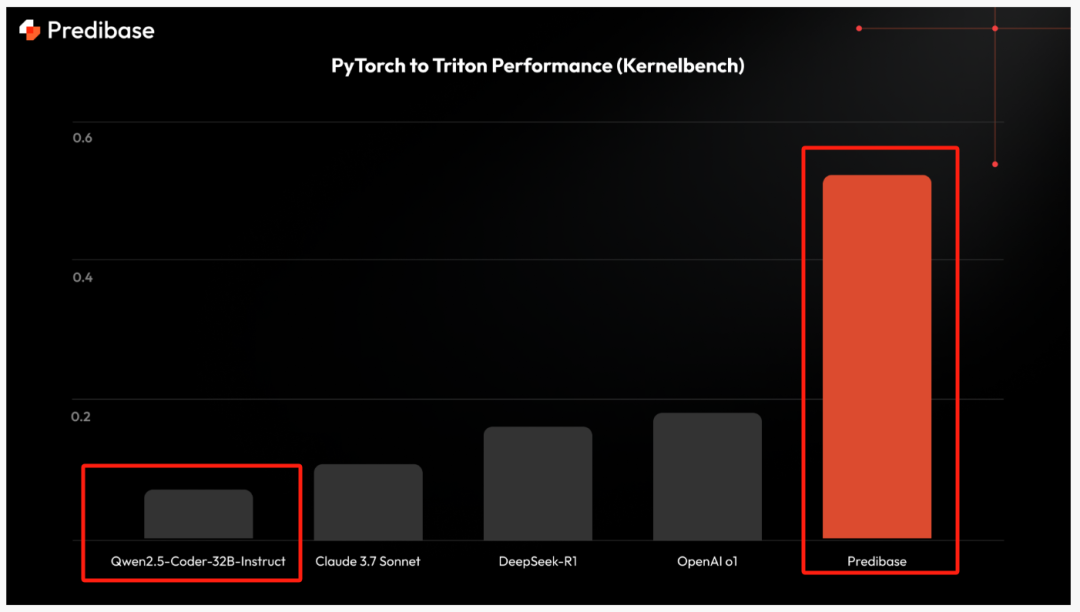

為了展示 RFT 的強大,Predibase 根據阿里開源的 Qwen2.5-Coder-32B-instruct,微調了一個專門用於將 PyTorch 代碼翻譯為 Triton 的模型 Predibase-T2T-32B-RFT。

與傳統的監督式微調方法不同,Predibase-T2T-32B-RFT 利用 RFT 以交互方式調整模型行為,以最少的標記數據優化下遊任務質量。這使其成為專有 LLM 的高性價比、高性能替代方案。

通過 RFT,Predibase 在訓練過程結合了冷啟動監督式微調、強化學習和課程學習,並且只使用了十幾個標記數據點。

在 Kernelbench 數據集上進行的基準測試顯示,Qwen2.5-Coder-32B-instruct 經過強化後,其正確率比 DeepSeek-R1 和 OpenAI 的 o1 高出 3 倍,比 Claude 3.7 Sonnet 高出 4 倍以上,而模型的體量卻比這三個小很多。

IT之家附開源地址:

https://huggingface.co/predibase/Predibase-T2T-32B-RFT

在線體驗地址:

https://predibase.com/reinforcement-fine-tuning-playground

廣告聲明:文內含有的對外跳轉鏈接(包括不限於超鏈接、二維碼、口令等形式),用於傳遞更多信息,節省甄選時間,結果僅供參考,IT之家所有文章均包含本聲明。