被Google點名感謝!杭州六小龍開源黑科技,讓機器人瞬間「悟透」3D世界

新智元報導

編輯:編輯部 HYZ

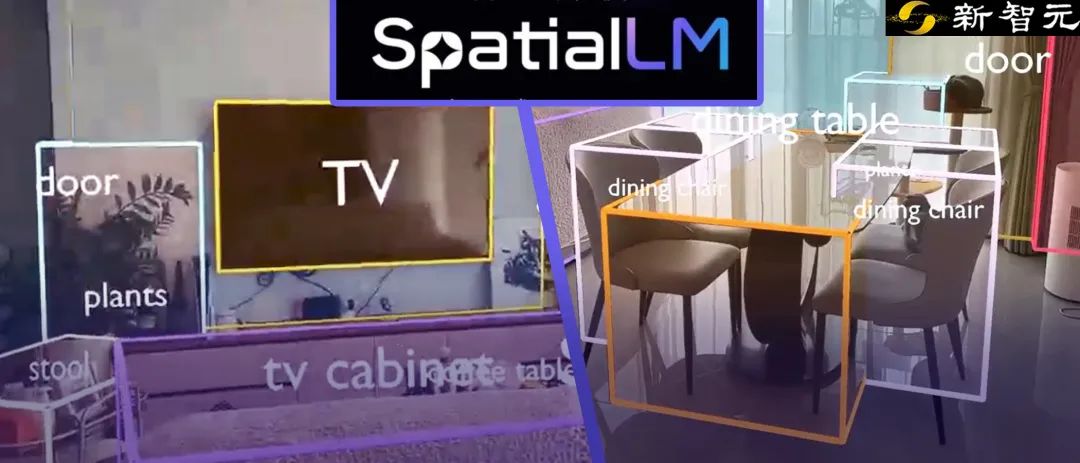

【新智元導讀】前腳被Google點名感謝空間訓練平台,後腳又開源了空間模型!杭州六小龍群核科技發了一個空間理解開源模型SpatialLM,讓機器人刷一段影片,就能理解物理世界的幾何關係。結合之前發佈的空間智能訓練平台SpatialVerse,群核科技要為機器人提供從空間認知到行動交互的訓練閉環。機器人也被「卷」到要上學了。

最近,一篇Google訓練模型的論文里,竟然感謝了一家中國公司!

2025年,Google與史丹福聯合發表的FirePlace論文中,這項研究首次讓AI學會像人類一樣「佈置房間」:沙發不懸空、檯燈必放桌面、書架與牆保持合理間距。而實現這一切的背後,也有來自一家中國公司的技術貢獻。

「我們感謝群核科技SpatialVerse團隊提供的物理級真實3D場景數據。」論文中提到。

Google提及的群核科技正是前段時間因杭州六小龍出圈的科技企業之一,其業務聚焦空間智能探索,而論文中提到的SpatialVerse是群核面向具身智能等行業開放的虛擬數字道場,通過合成可交互三維數據實現機器人訓練。

短短兩週後,這家企業又在GTC 2025大會上開源了他們的最新模型SpatialLM。

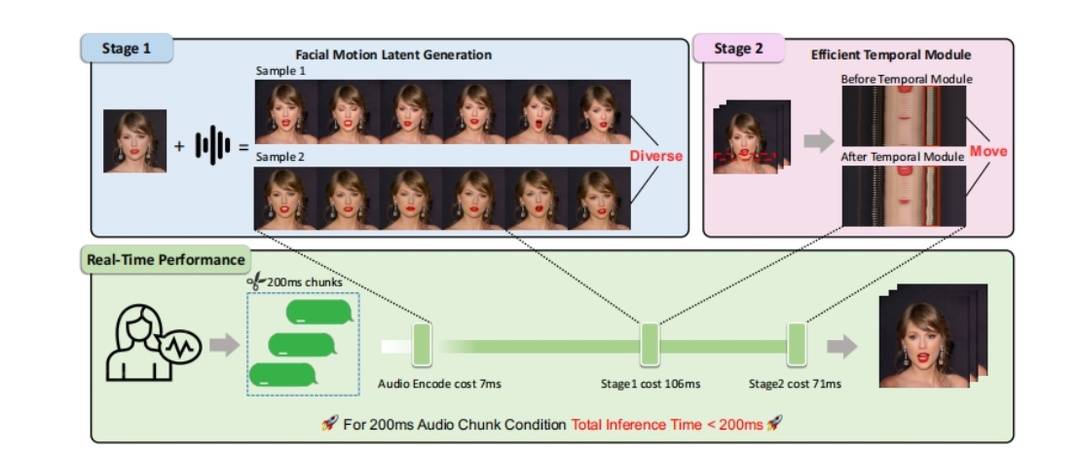

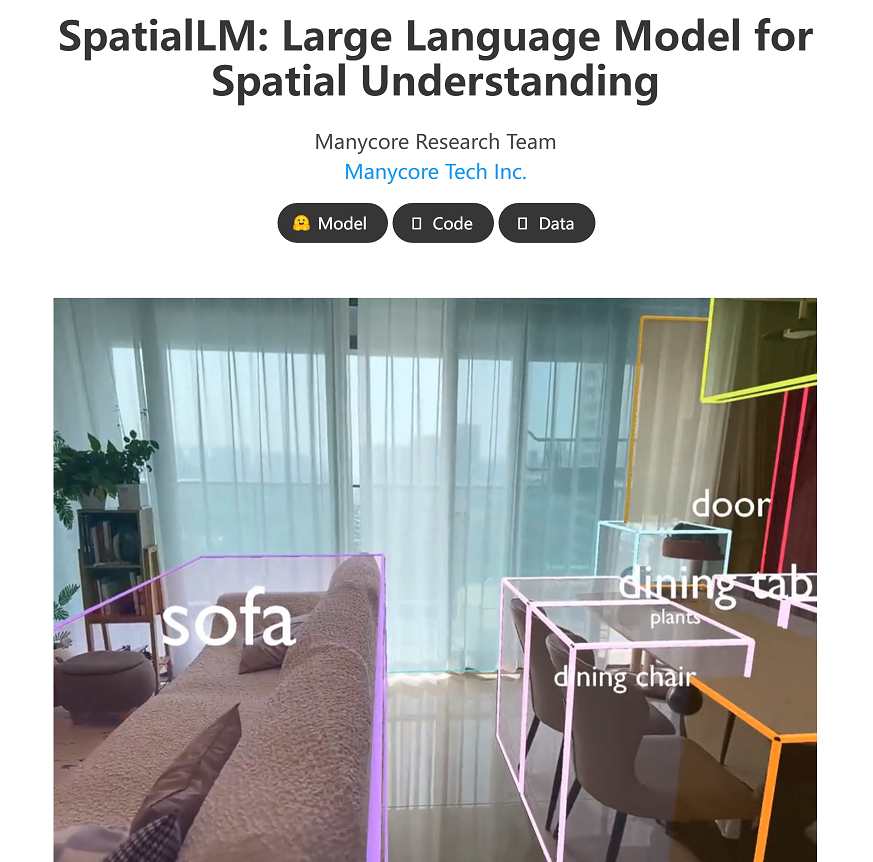

SpatialLM是一個空間理解模型,僅憑一部手機拍攝的影片,即可生成帶物理規則的的3D場景佈局。

想像一下,通過一部手機錄下家庭的佈局畫面,給到SpatialLM後,便能輸出完整的3D空間信息:房間佈局、傢俱擺放、通道寬度悉數標註。

緊接著,虛擬數字道場SpatialVerse基於這一3D場景的數據生成更多的物理真實場景,這些虛擬的場景中,機器人可訓練避障、抓取、緊急製動,在訓練成本和效率各方面都得到顯著提升。

目前,SpatialLM已在HuggingFace、GitHub、魔搭社區等平檯面向全球開發者開源。

群核科技SpatialLM模型開源頁面

群核科技SpatialLM模型開源頁面聽起來很複雜,但簡單地說,SpatialLM的本質就像是一台「空間翻譯機」,通過影片理解物理世界的幾何關係,再將其轉化為機器能讀懂的指令。

這相當於教會機器用人類直覺感知世界。傳統機器人的訓練方法如同「盲人摸象」,僅靠2D圖像猜測三維空間;而SpatialLM賦予機器人「3D視覺」和「物理常識」——床頭櫃不能挨著櫃門放、餐桌常規高度80釐米,來還原真實的訓練場景。

但群核科技的目的不止於此,它真正想做的是推動具身智能訓練完成從認知到行動的鏈路閉環。當SpatialLM幫助機器人跨過「空間理解」門檻後,群核科SpatialVerse這個「數字道場」,讓機器人在仿真環境中完成了技能學習。

給機器人刷一段影片,它會看見什麼?

SpatialLM模型能讓機器像人類一樣理解三維空間,這一突破性技術改變了機器人「看」世界的方式。

假設我們需要訓練機器人整理房間,傳統的訓練方法有兩種:一是對2D影片進行數據標註,把影片截圖成照片,告訴機器人「這是沙發、這是桌子」。

但機器人只知道這些物體的名字,不知道它們的位置、大小,也不知道怎麼移動它們;二是用專業激光雷達掃瞄房間(類似測繪儀)形成3D點雲,但成本高且步驟複雜時間週期長。

SpatialLM採用了一種創新型的方式:用一部普通手機拍攝影片,通過模型變成結構化3D場景的機器語言,輸入給機器人,既能降低採集成本,又能更好地還原3D場景。

這種做法模擬了人類的感知行為體系:看影片後,直接在腦子裡生成客廳的3D地圖,並標註其中物體所有細節。

它的技術原理也並不複雜。

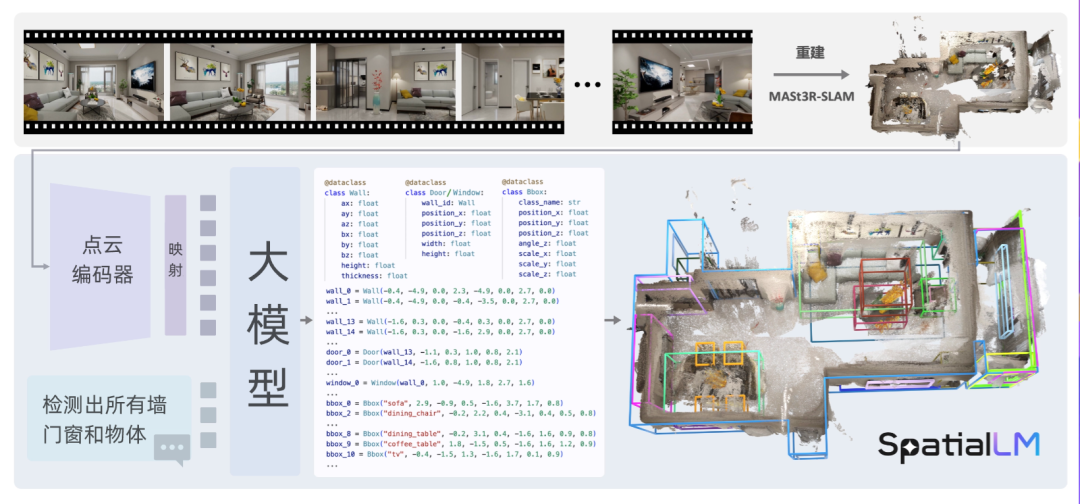

首先,給定一個RGB影片,使用MASt3R-SLAM來重建3D點云:通過把影片拆解成無數幀畫面,從中標記出沙發扶手、茶几邊緣、地板紋路等細節的「空間點」,再計算這些小點的深度和位置 ,拚接成完整的3D點雲模型。

從影片中提取點雲數據並重建場景

從影片中提取點雲數據並重建場景接著,SpatialLM將這些密集的點雲轉換為結構化表示。點雲編碼器將點雲編碼為緊湊的特徵,而大語言模型(LLM)生成描述場景的場景代碼。

輸出文本信息

輸出文本信息最終,這些代碼可以轉換為結構化3D結構佈局。即將空間點雲像樂高積木一樣拚接成完整的3D模型,比如沙發離牆1.2米、茶几高45釐米等數據一清二楚。

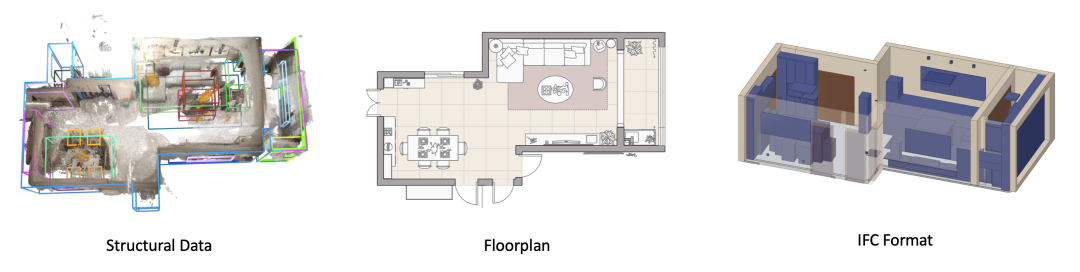

轉化為結構化3D佈局

轉化為結構化3D佈局SpatialLM是基於大語言模型訓練的。同時,它突破了大語言模型對物理世界幾何與空間關係的理解局限,賦予機器類人的空間認知和解析能力。

SpatialLM處理完影片後,不只是簡單地「看懂」空間,而是生成一套完整的結構化數據。這套數據清晰記錄了環境中每個物體的關鍵信息,比如三維坐標、尺寸參數、類別信息等。供機器人理解空間結構關係。

SpatialLM運行原理

SpatialLM運行原理配合3D可視化軟件可將結構化數據轉換為直觀的虛擬空間模型。這一過程類似於將文字描述的建築圖紙變成三維建模效果圖,讓開發者和用戶能直觀查看、驗證空間佈局的準確性。

雖然業界已有對圖像、影片進行參數化描述模型,但SpatialLM的獨特性在於它有更通用的數據輸入模式,無須借助智能穿戴設備作為傳感器輸入數據,手機、相機所拍攝的影片均可以成為數據來源。

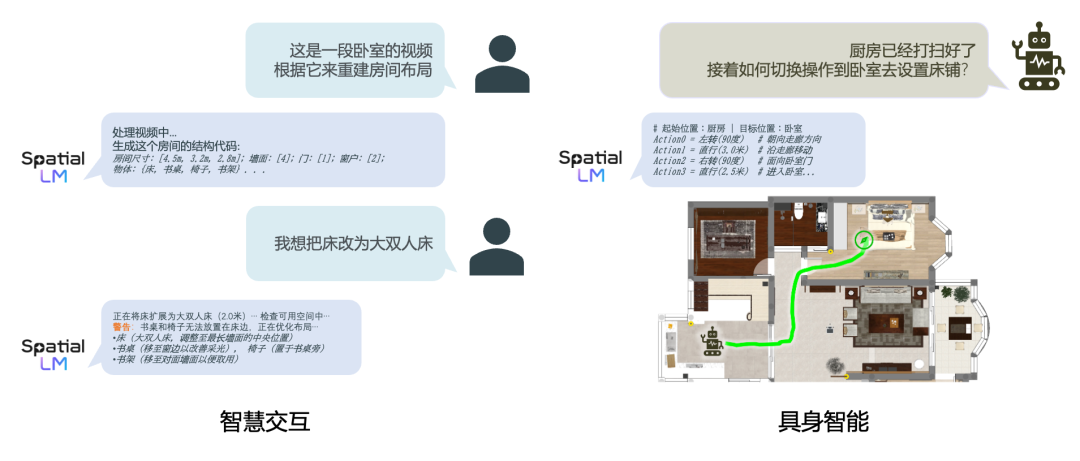

未來,SpatialLM還將支持自然語言交互模式,例如作為智能助手與人類互動,並賦予具身代理在複雜環境中執行複雜任務的能力。

總結而言,SpatialLM為機器人提供了一份詳盡而精準的「世界地圖」,讓它們能夠像人類一樣,既瞭解環境的靜態佈局,也掌握物體的動態交互規則,從而在複雜現實世界中靈活應對各種任務挑戰。

對於具身智能企業和研究機構而言,他們無需從零開發,基於SpatialLM模型進行微調即可,從而降低具身智能訓練門檻。

從認知到行動,構建具身智能的訓練閉環

目前具身智能行業呈現出高熱度但落地困難的矛盾局面。一方面,投資不斷湧入,技術論文層出不窮;另一方面,能在真實環境中穩定工作的機器人系統卻寥寥無幾。

核心問題在於面對一個高度集成軟件(AI)和硬件(製造)的新興行業,一切的標準都沒有統一,包括機器人的硬件操作系統。通用訓練平台甚至小到訓練數據集,都是分散在海量低質數據環境中。

除了上述提到2D數據無法滿足訓練條件但3D數據採集成本高昂外,最致命的問題是機器人對環境變化的適應能力極差。在傳統訓練模式下,環境中哪怕最微小的變化(如垃圾桶位置挪動)對機器人而言都是全新場景,需要重新學習。這導致在實驗室表現完美的機器人,進入真實家庭後常常「束手無策」。

這些問題的根源在於從感知到行動的智能閉環缺失——機器人能「看到」世界,卻無法基於所見做出合理決策和行動,從而無法適應真實多變的環境。而群核科技通過將模型和數據集進行了有機結合,構建了從空間認知理解到空間行動交互閉環的具身智能訓練完整閉環系統。

比如,SpatialLM模型能從普通影片中識別出「沙發」、「冰箱」等物體及其基本屬性。緊接著,語言理解層將語義標籤與物體關聯,賦予它們功能和用途,如「沙發是用來坐的」、「冰箱門需要拉開」,讓機器人理解「物體怎麼用」,避免違反基本操作邏輯的行為。

此前的虛擬訓練平檯面臨嚴重的「數據饑渴」問題,平台技術只能提供訓練工具,卻苦於沒有足夠的高質量數據喂養。而傳統數據採集成本高昂,導致訓練數據稀缺,形成惡性循環。

事實上,考慮到室內場景的多樣性和複雜度,場景三維可交互數據來源困難,這也是造成空間智能場景訓練「數據饑渴」的核心原因。

群核在過去十餘年沉澱的室內三維交互數據成為了具身智能訓練的「稀缺石油」,因此備受關注,開篇提到的Google論文致謝部分也正源自於此。

大量物理正確的3D仿真數據

大量物理正確的3D仿真數據追溯具身AI的發展,2018年是一個重要節點。

這一年,OpenAI推出了GPT-1模型,他們的研究人員也證明了:智能體在虛擬世界中學到的技能可以遷移到現實世界。矽谷科技企業隨即開始尋找可用的數據資源,而群核科技發佈的InteriorNet數據集(一個可交互的三維數據集)恰在此時被學術界和產業界廣泛關注。

如果以2018年為起點,拉出一條時間線,具身智能行業開始了一場大規模的「基礎設施建設」。這些基礎設施主要由兩大核心元件構成:高質量的結構化數據和高逼真度的模擬器。群核科技和其他行業先行者正是圍繞這兩大元件展開佈局。

此後幾年,國內外又誕生不少優秀數據集:

-

2019年,群核科技開源結構化數據集Structured3D,幫助機器理解三維結構;

-

同年,ImageNet發起者李飛飛也發佈了面向具身AI的模擬數據集BEHAVIOR;

-

而近一年來,具身智能領域的開源數據集更是百花齊放,智元開源的AgiBot World就是個典型例子;

但僅有數據還無法實現具身智能訓練的範式改變。因此,模擬器作為第二大元件也取得了顯著進展。

2021年,NVIDIA基於Omniverse專為機器人和AI模擬推出Isaac Sim;而且SpatialVerse也正與Isaac Sim深度整合,支持基於OpenUSD標準的仿真環境部署,為決策算法提供實時反饋,大大加速了空間智能訓練效率;此外,群核科技與英特爾等合作夥伴一起參與高逼真度模擬器SpearSim的建設。

為了提供更接近真實生活狀態的訓練環境,群核科技自研了一套合成數據訓練解決方案。通過模擬室內真實特性、自動分割標註、場景增強及多平台對接等核心能力,確保機器人在虛擬環境中的學習體驗與真實世界高度一致,實現從虛擬到現實的無縫遷移。

另一層面,SpatialLM+SpatialVerse又形成了一條「Real2Sim2Real」的路徑。SpatialLM源源不斷地將現實場景轉化為可用於訓練的結構化數據,SpatialVerse則進一步擴增這些數據,產生海量訓練樣本。相當於來自現實世界的一段影片數據,能泛化出億萬個虛擬場景。這不僅讓SpatialVerse的數據更多樣,同時還能縮小仿真與現實之間的「差距」。

機器人可在這些仿真場景中,學習人類操作,如開關冰箱門、疊被子等。這種基於大量數據的物理認知,讓機器人不再是簡單地指令執行者,而是具備「常識推理」能力的智能助手,能在複雜現實環境中安全、靈活地完成任務。

機器人在SpatialVerse的仿真場景中訓練

機器人在SpatialVerse的仿真場景中訓練如果把機器人通往物理世界的過程看作是「上學」,群核科技做的事其實是在幫機器人「搭建學校」,通過在虛擬空間設計不同的「教案課程」,機器人一路進化,從小學到大學的不斷進階。確保機器人進入真實世界之前,都從這個「學校」畢業了。

而且群核科技現在把這件事情變成更簡單,用手機隨手拍個影片,就能幫助機器人理解這個世界。當環境發生變化時,只需重新拍攝一段影片,即可更新整個空間模型,機器人無需從零學習。這種動態適應能力讓機器人終於能像人類一樣,迅速調整自己的行為以應對環境變化。

結語

傳統空間智能訓練需要頂尖實驗室、頂級設備和專業團隊,這使其成為少數精英機構的「特權」。群核的方案將這一領域徹底平民化,只要有手機和電腦,任何開發者都能接入這套系統,為機器人創建物理正確的訓練環境。

空間智能訓練成本從原本的「指數級曲線」(數據量越大,成本越高)變成了「平面結構」(邊際成本接近於零)。一旦初始投入完成,生成千萬級訓練場景的成本與生成百個場景幾乎相同。

SpatialLM和SpatialVerse雙平台方案不僅解決了這一核心問題,更重要的問題是:要把訓練數據的成本降下來,才能實現機器人通用模型的能力湧現。

參考通用大模型能力湧現的路徑,第一個階段就是堆參數訓練通用能力,而機器人之所以沒有參考這條路徑,一個根本原因就在於訓練數據太少、訓練成本太高,只能訓練專有模型。

在這場技術變革中,群核科技不只是在開發新工具,更是在重新定義機器與現實的關係。

未來我們或許迎來一個機器人物種的大爆發時刻,屆時會有一個「數字地球」承載它們,這個數字地球將是一個巨大的訓練場,機器人會在這裏先「生活」一遍,再進入真實地球成為人類的助手和管家。