中國一項實時人像視頻生成研究成果入選CVPR2025國際學術會議

封面新聞記者 歐陽宏宇

近期,IEEE國際計算機視覺與模式識別會議( Conference on Computer Vision and Pattern Recognition)CVPR 2025公佈論文錄用結果,其中一項來自中國的將AI應用於社交領域平台案例研究論文《Teller: Real-Time Streaming Audio-Driven Portrait Animation with Autoregressive Motion Generation》(《基於自回歸動作生成的實時流式音頻驅動人像動畫系統》)被接收。

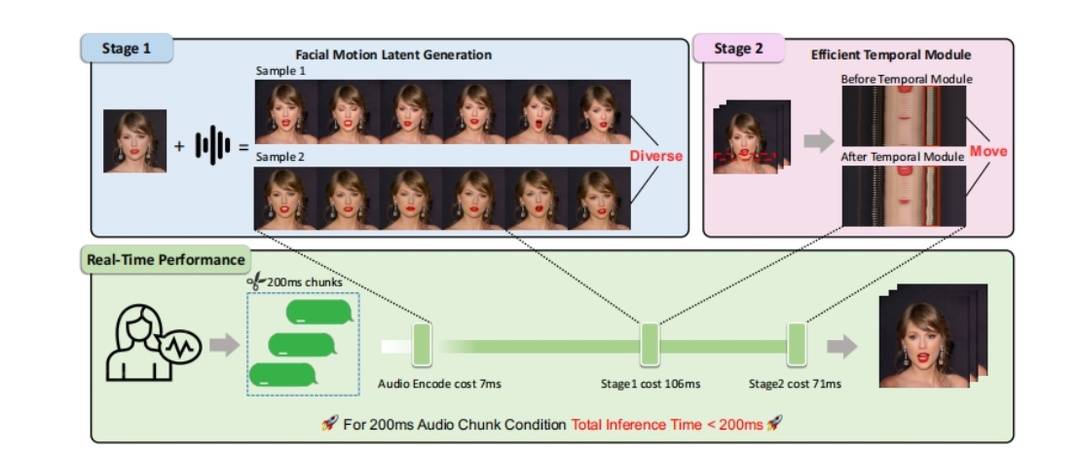

據介紹,研究團隊在論文中提出了一個新的面向實時音頻驅動人像動畫(即Talking Head)的自回歸框架,解決了視頻畫面生成耗時長的行業挑戰外,還實現了說話時頭部生成以及人體各部位運動的自然性和逼真性。

該論文的動機是解構diffusion-base的模型關鍵步驟,用LLM和1step-diffusion進行重構,融合視頻模態,使SoulX大模型成為同時生成文字、語音、視頻的Unified Model。

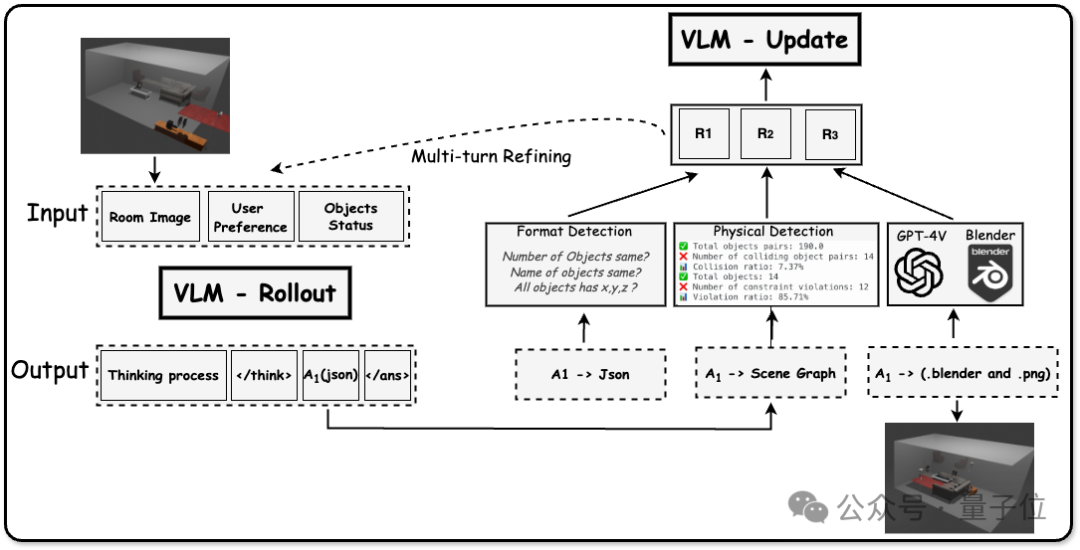

具體而言,來自Soul App的研究團隊將talking head任務分成FMLG(面部Motion生成)、ETM(高效身體Movement生成)模塊。FMLG基於自回歸語言模型,利用大模型的強大學習能力和高效的多樣性采樣能力,生成準確且多樣的面部Motion。ETM則利用一步擴散,生成逼真的身體肌肉、飾品的運動效果。

實驗結果表明,相比擴散模型,該方案的視頻生成效率大幅提升,且從生成質量上來看,細微動作、面部身體動作協調度、自然度方面均有優異表現。這證明了國產社交領域互聯網技術在推動多模態能力構建特別是視覺層面能力突破上取得了階段性成果。

談及研究團隊所關注的視覺交互邏輯,該平台CTO陶明解釋稱,從交互的信息複雜度來講,人和人面對面的溝通是信息傳播方式最快的,也是最有效的一種。“所以我們認為在線上人機交互的過程當中,需要有這樣的表達方式。”

在他看來,在多模態大模型能力方向基礎上,該方案的提出將有助於AI構建實時生成的“數字世界”,並且能夠以生動的數字形象與用戶進行自然的交互。

公開資料顯示,CVPR是人工智能領域最具學術影響力的頂級會議之一,是中國計算機學會(CCF)推薦的A類國際學術會議。在Google學術指標2024年列出的全球最有影響力的科學期刊/會議中,CVPR位列總榜第2,僅次於Nature。根據會議官方統計,本次CVPR 2025會議總投稿13008篇,錄用2878篇,錄用率僅為22.1%。