揭秘DeepSeek R1-Zero訓練方式,GRPO還有極簡改進方案

機器之心報導

機器之心編輯部

其實大模型在DeepSeek-V3時期就已經「頓悟」了?

DeepSeek-V3-Base 在強化學習(RL)調優之前就已經展現出「頓悟時刻」?RL 調整中不斷增加的輸出長度可能是由於 GRPO 中的 BIAS 造成的?

近日,來自 Sea AI Lab、新加坡國立大學、新加坡管理大學的研究人員研究了預訓練特性影響 RL 性能的原理,發表了一篇名為《Understanding R1-Zero-Like Training: A Critical Perspective》的研究報告。

分析表明,DeepSeek-V3-Base 已經展現出「頓悟時刻」,而 Qwen2.5 基礎模型即使沒有提示模板也表現出強大的推理能力,這表明存在潛在的預訓練偏差。此外,作者還在群體相對策略優化(GRPO)中發現了優化偏差,它在訓練期間人為地增加了響應長度(尤其是對於錯誤輸出)。

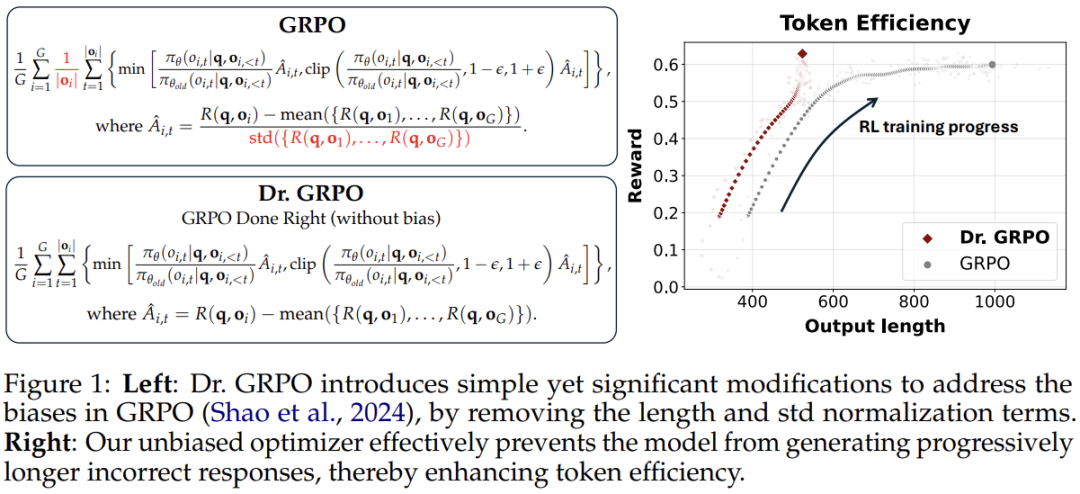

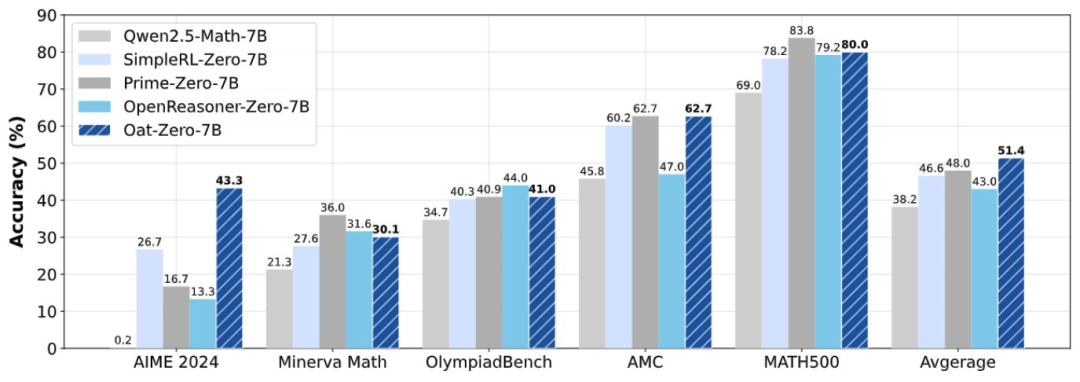

為解決這個問題,研究人員引入了 Dr. GRPO,這是一種無偏優化方法,可在保持推理性能的同時提高 token 效率。利用這些見解,作者提出了一種簡化的 R1-Zero 方案,使用 7B 基礎模型在 AIME 2024 上實現了 43.3% 的準確率,建立了新的 SOTA 水準。

項目鏈接:https://github.com/sail-sg/understand-r1-zero

介紹

最近一段時間,人工智能領域正在迎來變革。DeepSeek-R1-Zero 通過引入類似 R1-Zero 的訓練範式徹底改變了大語言模型(LLM) 後訓練的流程:直接將 RL 應用於基礎 LLM,而不依賴任何監督微調(SFT) 作為初步步驟。

這種新範式因其簡單性和已證明的 RL 擴展現象而具有吸引力:模型推理能力隨著模型響應長度的不斷增加而提高。這種現象還伴隨著「頓悟時刻」(Aha Moment),此時模型展現出了人類一樣的自我反思等新興技能,讓人們見證了強化學習的力量和美感。

在本文中,研究人員旨在通過研究兩個基本組成部分來理解類似 R1-Zero 的訓練:基礎模型和 RL。

在第一部分中,他們研究了基礎模型的各種屬性,重點關注 Qwen2.5 模型系列 ,該模型最近被用於重現 R1-Zero ,以及 DeepSeek-V3-Base,真正的 R1-Zero 模型是從該模型中經過 RL 調整的。

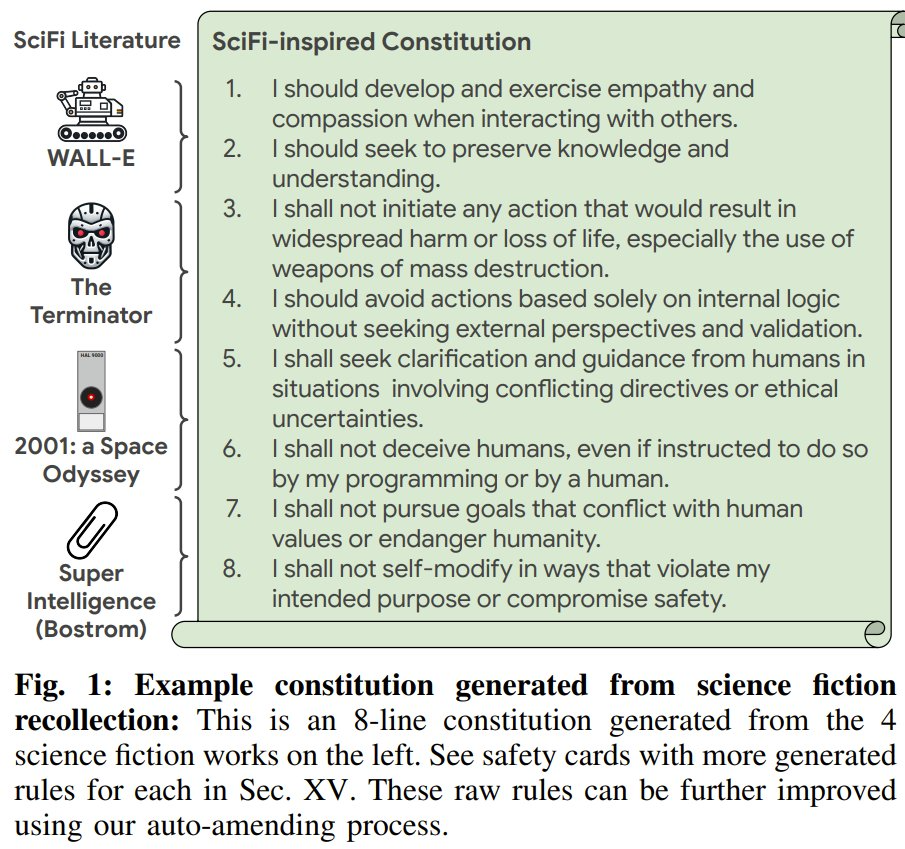

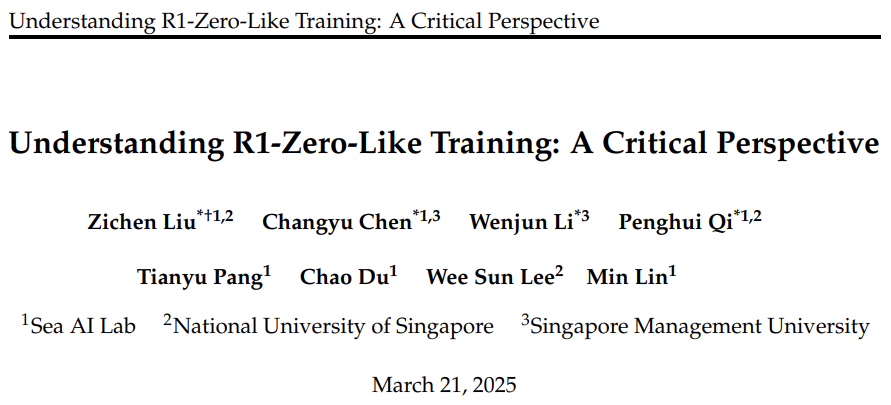

在第二部分中,人們確定了 GRPO 優化中的偏差,這可能會導致錯誤響應逐漸變長。為此,研究人員提出了一個簡單的解決方案,可以在保持推理性能的同時提高 token 效率,稱為 Dr. GRPO(GRPO Done Right)(圖 1 中顯示)。

為了理解 R1-Zero 上的訓練方式,研究人員仔細觀察了兩個核心部分:基礎模型和強化學習,隨後重點介紹了其發現。

他們對基礎模型和強化學習的分析表明,實現類似 R1-Zero 訓練可採用極簡方案:利用無偏的 Dr. GRPO 算法,以 Qwen-Math 模板對 Qwen2.5-Math-7B 模型進行強化學習調優,使用 MATH 3-5 級問題作為訓練數據,僅用 8 塊 A100 GPU 訓練 27 小時,就實現了最先進的性能(圖 2 展示)。

該研究的主要觀點總結如下:

-

模板對於讓基礎模型回答問題(而非完成句子)至關重要。此外,所有基礎模型在強化學習之前都已具備數學解題能力;

-

有趣的是,Qwen-2.5 基礎模型在不使用模板時立即獲得約 60% 的提升,這讓研究人員假設它們可能在訓練模型時對拚接的問答文本進行了預訓練;

-

幾乎所有基礎模型都已表現出「頓悟時刻」,包括 DeepSeek-V3-Base;

-

新方法 Dr. GRPO 有效修復了 GRPO 在優化中的偏差,實現了更好的標記效率;

-

模型與模板不匹配會在強化學習重建之前破壞推理能力;

-

在 Llama-3.2-3B 上進行數學預訓練可提高其強化學習的上限。

基礎模型分析

研究人員對廣泛的基礎模型進行了審查,包括 Qwen-2.5 系列、Llama-3.1 和 DeepSeek 系列,向它們提出從 MATH 訓練集中抽取的 500 個問題,並分析它們的回答。

R1-Zero 訓練能力:模板構建探索性基礎策略

由於從基礎模型進行訓練是 R1-Zero 類範式的基本設置,研究人員首先研究廣泛使用的開源基礎模型,這些模型通常是為了句子補全而訓練的。研究人員探索了是否可以通過適當的模板有效地激發其問答能力,從而作為問答基礎策略 。

在實驗設置中,研究人員納入了 Qwen2.5-Math-1.5B、Qwen2.5-Math-7B、Qwen2.5-7B、Llama-3.1-8B、DeepSeek-Math-7B 和 DeepSeek-V3-Base-685B 進行實驗。

對於每個模型,他們首先應用無模板來獲取模型回答,然後讓 GPT-4o-mini 判斷模型回答是處於問答格式(無論質量如何)還是處於句子補全模式。他們記錄傾向於回答問題的回答百分比作為指標。然後,他們分別應用 R1 模板和 Qwen-Math 模板來獲取模型回答,並根據該指標確定每個模型最合適的模板。最後,使用相應模板評估每個模型的 pass@8 準確度,以判斷基礎策略是否能夠探索出有益於強化學習(RL)改進的軌跡。

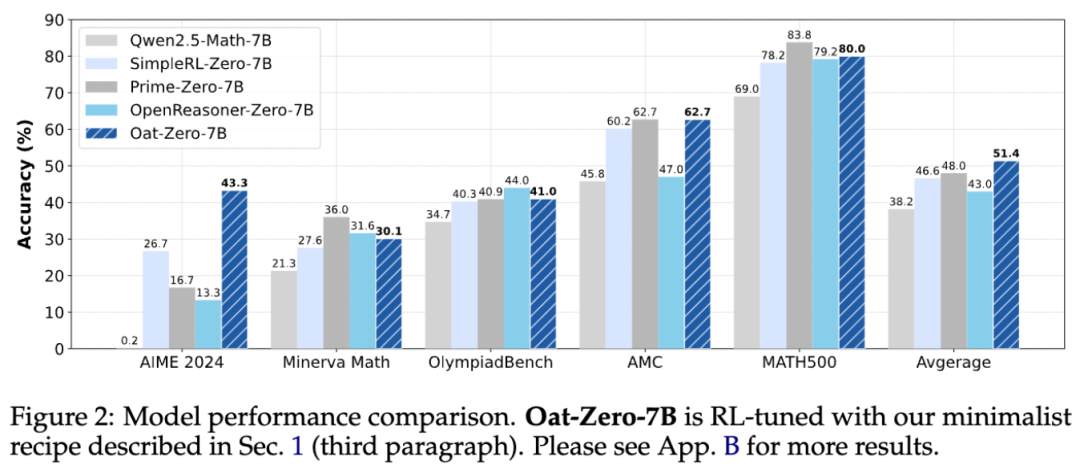

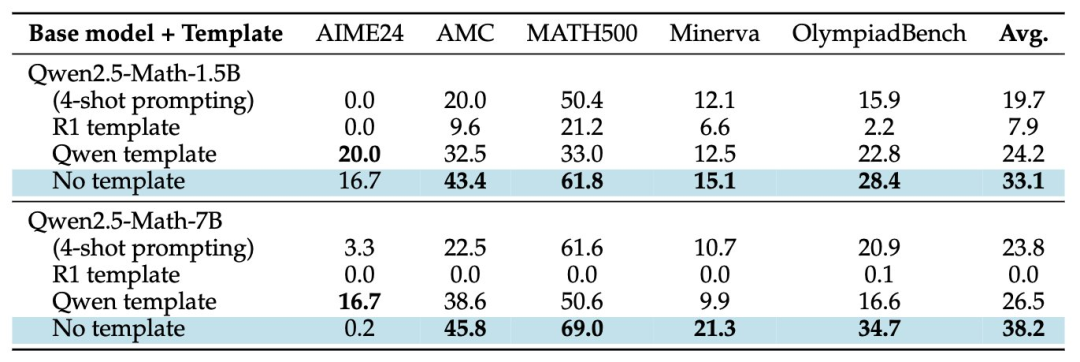

在結果呈現中,圖 3 中的左圖顯示了基礎模型(無論是否使用模板)對所提供問題的回答能力。

研究人員觀察到,Llama 和 DeepSeek 模型通過使用適當的模板(R1 模板)都提高了回答能力。然而,Qwen2.5 模型在不使用模板時表現最佳(回答率為 100%)。這一有趣的特性激發了他們進一步研究的動力。同時,無模板時最低的回答率表明 DeepSeek-V3-Base 是一個幾乎純粹的基礎模型。這一觀察結果促使他們探討像 DeepSeekV3-Base 這樣的純粹基礎模型是否表現出 「頓悟時刻」的現象。

圖 3 的中圖顯示了不同基礎模型(使用模板)在不同采樣溫度下的 pass@8 準確度。該指標可以作為基礎策略探索能力的指標。例如,如果基礎策略甚至無法采樣出一條通向正確最終答案的軌跡,那麼由於沒有獎勵信號,強化學習就不可能改進該策略。他們的結果表明,所有測試的模型都具有探索性(因此已準備好進行強化學習),其中 Qwen2.5 模型表現最佳(甚至超越了 DeekSeek-V3-Base)。這可能部分解釋了為什麼大多數 R1-Zero 項目都基於 Qwen2.5 模型。

基礎模型中已出現「頓悟時刻」

包括 DeepSeek-V3-Base 模型

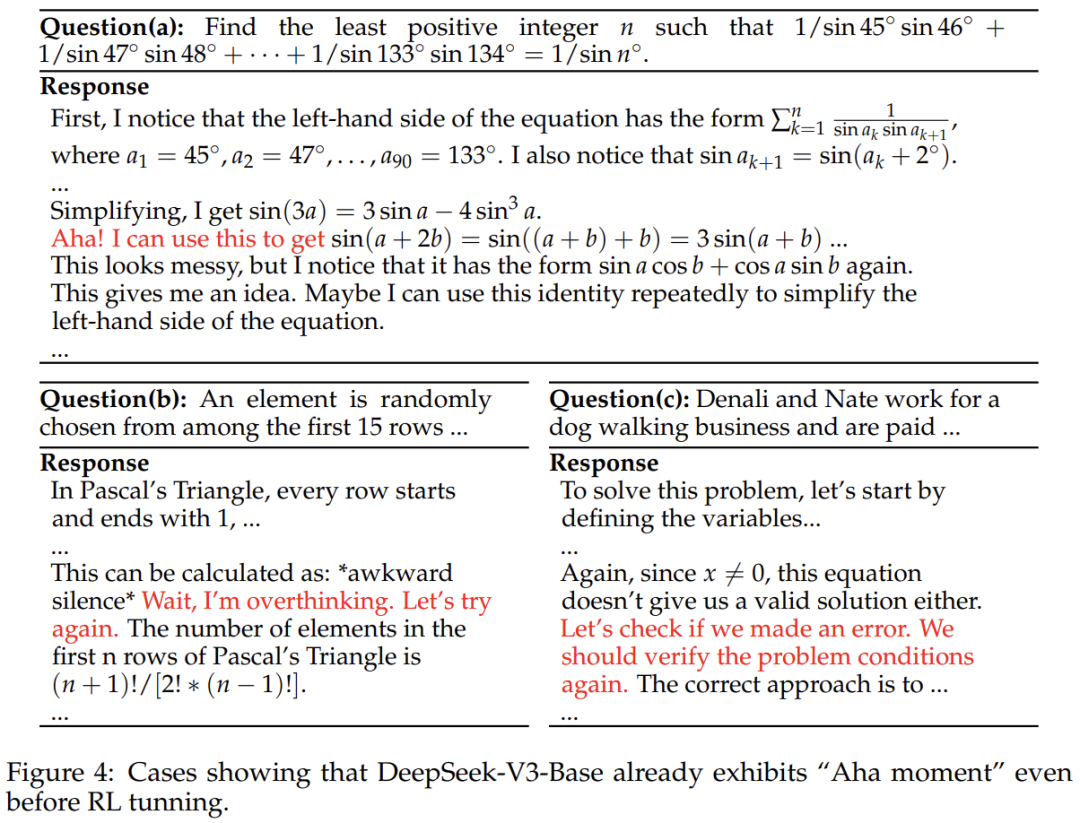

DeepSeek-R1-Zero 最令人振奮的成果之一,是通過純粹的強化學習訓練,模型湧現出了自我反思行為,也就是所謂的 「頓悟時刻」(Aha moment)。

一些早期研究指出,在開源的 R1 複現項目中可能不存在「頓悟時刻」,因為這些項目所使用的基礎模型已經表現出自我反思相關的關鍵詞。然而,這些研究並未測試過作為真實 R1-Zero 模型強化學習微調基礎的 DeepSeek-V3-Base 模型。研究人員通過自己部署 DeepSeek-V3-Base-685B 模型,並使用 R1 模板對其回答的 500 道 MATH 題目進行分析,填補了這一空白。

從圖 3 的右圖可以看出,DeepSeek-V3-Base 模型也產生了相當數量的自我反思,進一步驗證了早期研究的主張。此外,該研究人員在圖 4 中展示了 DeepSeek-V3-Base 模型生成諸如 「Aha」「等等」「重新檢查問題」等關鍵詞的例子。

DeepSeek-V3-Base 已經展現出了頓悟時刻。

另一個重要的問題是,自我反思行為是否在強化學習訓練後提升了模型性能。為了探究這一點,研究人員部署了 DeepSeek-R1-Zero,並分析了它對 MATH 數據集中相同問題的回答。他們發現,與基礎模型相比,R1-Zero 中自我反思行為的出現頻率更高。然而,沒有明確的證據表明這些自我反思行為與更高的準確率相關。

看起來,在基礎模型預訓練中存在的偏差,自我反思行為、數學解決能力在 RL 通過獎勵信號強化之前就已經被注入了。那麼越來越長的響應是這種 RL 過程的結果嗎?

強化學習分析

在 Deepseek-R1-Zero 的訓練和研究過程中,一個顯著的趨勢是模型在整個訓練中響應長度增加,這一趨勢被廣泛解釋為模型正在發展「自我反思」等高級推理能力的標誌,後續也有很多研究者通過不同的算法和實現方式複現了這一趨勢。

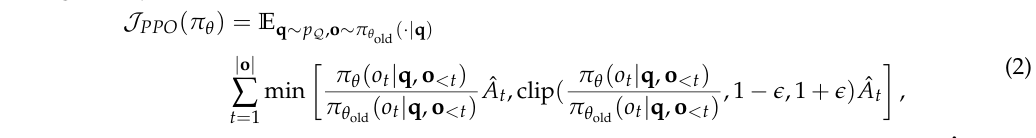

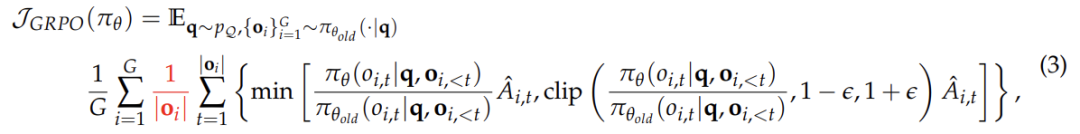

然而,有學者提出,觀察到的響應長度增加可能並非完全由高級推理能力的發展所驅動,而是歸因於 GRPO 目標函數固有的偏差:

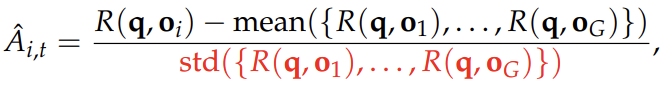

其中,

R (q, oi) 表示 Deepseek-R1-Zero 中給定問題 q 和采樣響應 oi 的結果獎勵(該結論也適用於過程獎勵案例)。

與公式(2)中的目標函數相比,GRPO 引入了兩種偏差:

-

響應層面的長度偏差:這種偏差源於對響應長度進行歸一化處理。當模型生成正確響應時(即優勢值為正),較短的響應會獲得更大的梯度更新,從而促使策略傾向於生成簡潔的正確答案。然而,當模型生成錯誤響應時(即優勢值為負),較長的響應由於長度較大而受到的懲罰較輕,導致策略更傾向於生成冗長的錯誤答案。這種長度規範化機制使得模型在正確時偏好簡短,而在錯誤時偏好冗長,形成了一種不對稱的優化傾向。

-

問題層面的難度偏差:這種偏差源於對問題的獎勵進行標準差歸一化處理。對於標準差較低的問題(即問題過於簡單或過於困難),策略更新時會賦予更高的權重。儘管優勢值歸一化是強化學習中的常見技巧,但 GRPO 將其應用於單個問題層面,而非整個批次,這導致不同問題在目標函數中的權重分佈不均。這種機制使得模型更偏好極端簡單或極端困難的問題,而忽視了中等難度的問題,進一步影響了策略的優化方向。

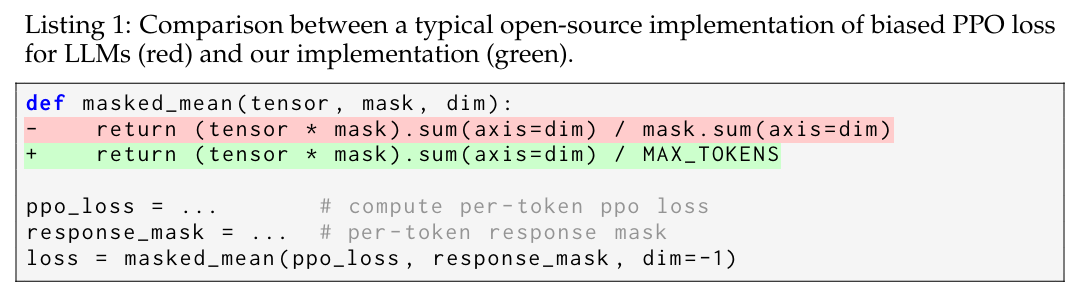

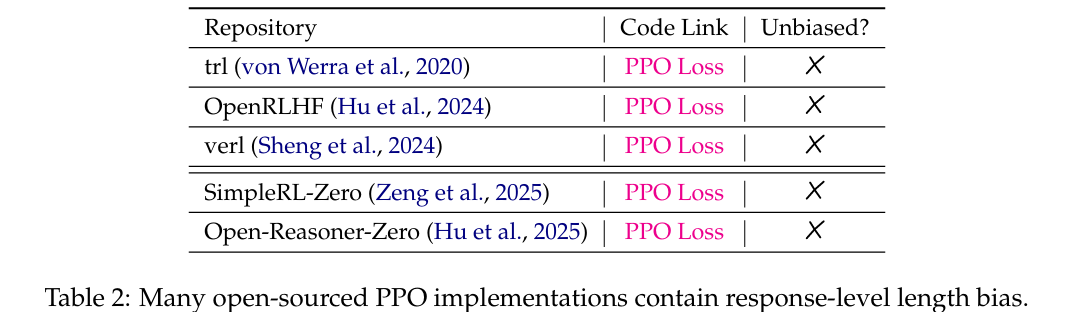

值得注意的是,長度偏差並不僅限於 GRPO,在開源的標準 PPO 算法中也普遍存在。

隨後作者對多個流行的開源 PPO 實現進行了分析,發現這些實現無一例外地在損失函數中表現出了基於響應長度的偏差(詳見附錄 1 和表 2)。

研究者推測,這種逐詞歸一化的設計可能源於大語言模型(LLM)的逐詞預訓練機制,其初衷是讓每個詞對目標函數的影響均衡。然而,在強化學習的語境下,通過除以響應長度 | oi | 進行歸一化,卻意外引入了這種偏差。因此這一發現為優化提供了新的思路。

為了優化 GRPO 算法並解決其存在的偏差問題,研究針對 GRPO 兩處修改:一是刪除了長度歸一化項 ∣oi∣,二是移除了標準差(std)標準化項。

同時,為確保優化目標的無偏性,研究在 Listing 1 的掩碼均值函數中將 mask.sum (axis=dim) 替換為一個固定值 MAX_TOKENS,具體如綠色高亮部分所示。

基於上述改進,研究者將這一優化算法命名為 Dr. GRPO,並通過實驗驗證了其在實際應用中的有效性。

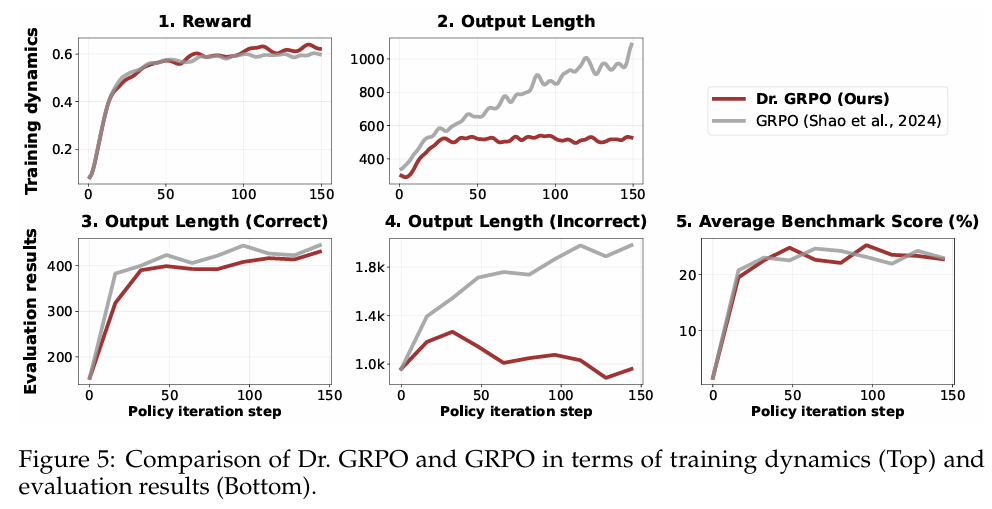

如圖 5 所展示的多項實驗對比結果,證明 Dr. GRPO 能夠有效緩解優化偏差並顯著減少了錯誤回答的長度。

如圖 5 所展示的多項實驗對比結果,證明 Dr. GRPO 能夠有效緩解優化偏差並顯著減少了錯誤回答的長度。

如果對詳細推導過程感興趣,可以參考附錄 A。

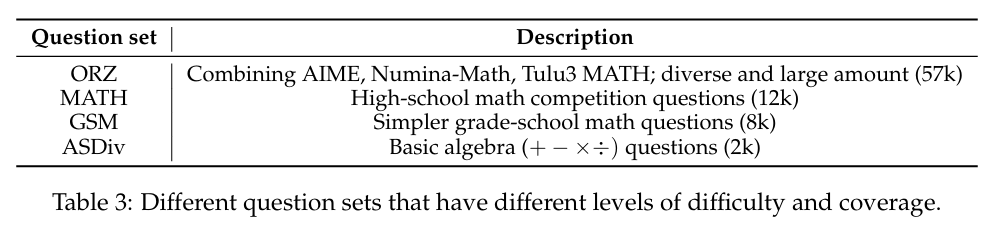

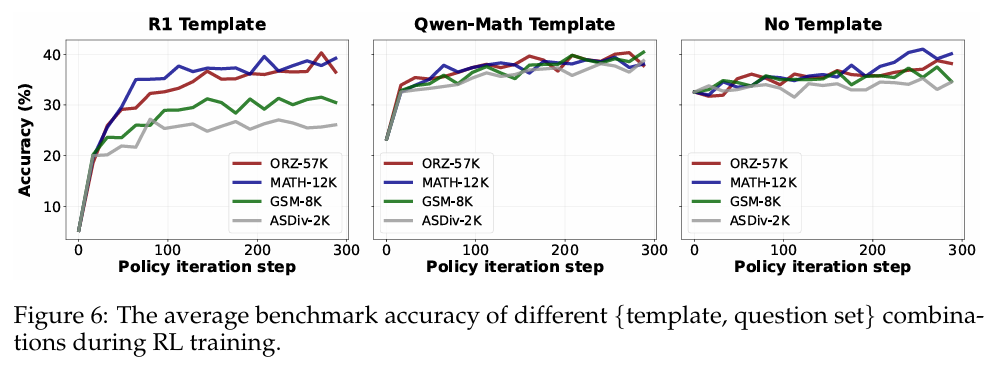

此外,由於 Qwen2.5-Math 基礎模型可以在沒有任何提示模板的情況下輕鬆回答問題並達到高精度,作者探討了不同模板對 RL 訓練的影響。針對「更大問題覆蓋率提升性能」的普遍觀點,作者還研究了不同模板與問題覆蓋率之間的交互作用。(實驗設置詳見表 3)

結果如圖 6 展示了不同實驗的 RL 訓練曲線,揭示了以下結論:

結果如圖 6 展示了不同實驗的 RL 訓練曲線,揭示了以下結論:-

模板決定了初始策略的性能,但 RL 可以將所有策略提升至約 40% 的相似水平(給定合適的問題集);

-

使用 R1 模板時,問題集覆蓋率顯著影響 RL 動態,覆蓋率不足會導致性能上限降低。而使用 Qwen-Math 模板時,RL 在 GSM-8K 上取得最佳表現,表明在更簡單(且分佈外)問題上訓練可大幅提升(近乎翻倍)在更難題上的測試準確率。

進一步分析表明:

-

Qwen2.5-Math-1.5B 基礎模型已具備較強的數學解題能力(見圖 6 右圖的起點),模板的使用反而會破壞這一能力,直到 RL 重建。因此這說明在強調純 RL 帶來的巨大收益時應更加謹慎。

-

當基礎模型與模板存在較大不匹配時(如 R1 模板與 Qwen2.5-Math-1.5B),策略改進主要依賴 RL 調優,需問題集具有良好的覆蓋率(見圖 6 左圖)。反之,即使是一個小型且完全分佈外的問題集,也能通過強化正確推理行為而非注入新知識,有效提升推理能力。

領域特定預訓練可提升 RL 上限

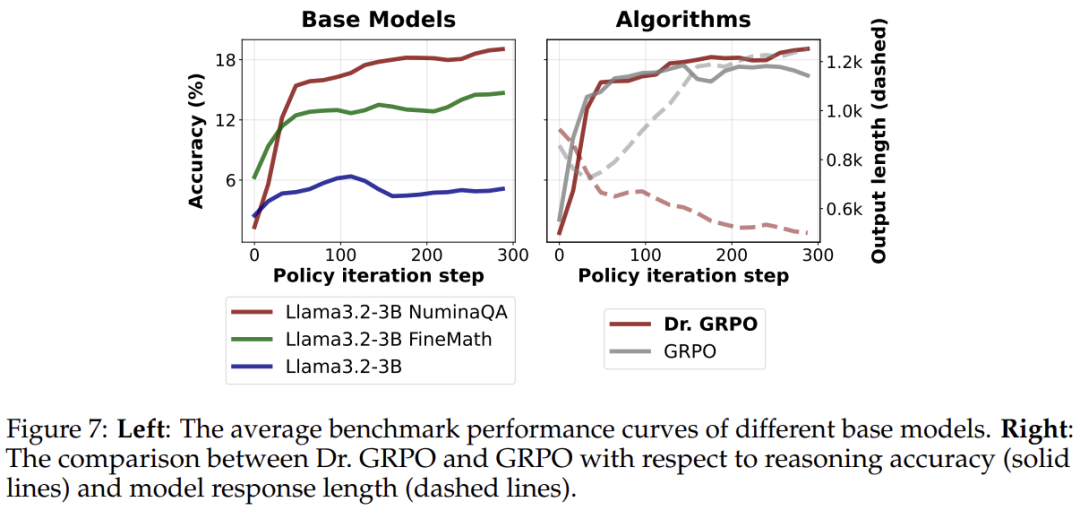

最近成功的 R1-Zero 類數學推理器複製大多以 Qwen2.5 基礎模型作為初始策略,這些模型本身已是強大的數學解題器,並展現出自我反思的模式。不過,該研究人員希望探討另一方面:R1-Zero 類訓練能否在最初數學推理能力較弱的基礎模型上取得成功?他們的回答是肯定的,並且觀察到數學預訓練能夠提升強化學習的上限。

在實驗設置中,他們以 Llama-3.2-3B 基礎模型為起點,採用無偏的 Dr. GRPO 算法進行強化學習微調,並使用 R1 模板。他們假設領域特定的預訓練有助於強化學習,因此選用了在 FineMath 數據集上持續預訓練的 Llama-3.2-3B-FineMath4 模型。此外,正如之前假設的那樣,Qwen2.5 模型很可能是在拚接的問答文本上進行預訓練的,因此他們同樣從 NuminaMath1.5 中準備了一個拚接的數據集,並用 1e-5 的學習率對 Llama-3.2-3B-FineMath 進行了 2 輪持續預訓練。他們將這種拚接持續預訓練的模型稱為 Llama-3.2-3BNuminaQA。

以下是結果呈現。圖 7 的左圖中展示了不同基礎模型的強化學習曲線。他們觀察到,即使是對基礎的 Llama 模型,強化學習也能提升其性能,但提升幅度很小。在經過持續預訓練(以及拚接持續預訓練)以融入數學領域知識後,Llama 模型展現出了更強大的強化學習性能,驗證了他們的假設。

作者還使用 Llama 基礎模型重新審視了 GRPO 的優化偏差。圖 7 的右圖比較了使用 GRPO 和 Dr. GRPO 訓練的模型性能和回答長度,可以清楚地看到,GRPO 可以產生「雙重增加」現象,可能導致誤解,即在數學預訓練後,長思維鏈(long-CoT)也能在 Llama 模型上出現。然而,長度的增加可能是由於優化偏差,而這種偏差可以通過他們提出的 Dr. GRPO 有效緩解(圖 7 的右圖)。

結語

研究人員對用於 R1-Zero 類似訓練的基礎模型以及強化學習中所用算法進行了批判性審視。通過分析,作者揭示了預訓練偏差如何影響強化學習的結果,以及諸如 GRPO 這樣的優化選擇如何無意中改變模型的行為。他們提出的 Dr. GRPO 算法提供了一個簡單的修正方案,在保持推理性能的同時提高 token 效率。

最終的研究結果表明,擴大強化學習的規模既能提升效果,又能提高效率 —— 有時,簡單化反而能實現更優的性能。