50條數據解鎖空間智能,RL視覺語言模型3D空間推理框架MetaSpatial |西北大學

MetaSpatial團隊 投稿

量子位 | 公眾號 QbitAI

在三維空間理解任務中,讓視覺語言模型(VLM)生成結構合理、物理一致的場景佈局仍是一項挑戰。以「請將這些傢俱合理擺放在房間中」為例,現有模型儘管能夠識別圖像中的物體,甚至給出語義連貫的佈局描述,但通常缺乏對三維空間結構的真實建模,難以滿足基本的物理約束與功能合理性。

為瞭解決這一問題,已有研究嘗試採用多智能體交互(multi-agent interaction)方法,通過多個語言模型或代理之間的迭代協商與驗證優化佈局結果。然而,這類方法不僅計算成本高,而且在迭代過程中容易陷入死鎖,導致無法收斂至有效解。

另一類方法則通過構建大規模真實房間佈局的描述語料,結合監督微調(Supervised Fine-Tuning, SFT)對模型進行訓練。這種方式可以在一定程度上提升模型基礎能力,但受到空間任務本身的限制:空間佈局任務不存在唯一的標準答案。對於同一個輸入,合理的三維佈局可以有多種形式,因此以單一ground truth為監督信號的SFT方法無法全面覆蓋可能的合理解空間,限制了模型的泛化能力與生成多樣性。

針對這一挑戰,西北大學計算機系與基礎模型與生成式AI中心的研究人員潘震宇 (Zhenyu Pan) 以及其導師劉晗 (Han Liu) 提出了核心問題:是否可以通過規則驅動的強化學習策略,為視覺語言模型注入空間推理能力?

三維佈局任務具備強化學習適用的若干關鍵特性:

-

不存在標準解,目標是生成符合同束的多樣性解;

-

缺乏精確標註,導致監督信號稀缺;

-

存在可程序化檢測的目標函數,如物體重疊、越界、功能邏輯合理性等。

強化學習(Reinforcement Learning)通過獎勵函數(reward function)而非依賴人工標註,引導模型在與環境交互中不斷優化策略。這使其天然適用於空間佈局這類缺乏唯一標準答案、解空間複雜多樣的任務。近年來,結合規則獎勵機制的強化微調範式(Reinforcement Fine-Tuning, RFT)已在結構化任務中取得顯著成果,如文本生成、數學推理、代碼理解等,典型代表包括DeepSeek-R1和OpenAI o1。

然而,在三維空間推理這一融合視覺、語言與結構理解的多模態任務中,這一策略仍未被充分探索。

為此,他們提出了MetaSpatial框架。該方法首次將基於規則獎勵的RFT策略成功遷移至視覺語言模型(VLMs)的空間佈局場景中,在僅使用約50條無ground truth數據的條件下,即可顯著提升模型的空間推理能力與佈局生成質量。

具體而言,MetaSpatial構建了一套可程序化評估的獎勵函數,衡量佈局結構是否合理、是否滿足物理約束,以及是否符合用戶偏好。同時引入多輪佈局 refinement 機制,引導模型在訓練過程中逐步優化空間決策。借助這一策略,模型無需依賴大規模標註數據,即可學習到具備泛化能力與結構適應性的空間推理策略。

實驗結果顯示,MetaSpatial在多個空間生成指標上顯著優於傳統SFT方法,充分驗證了基於規則獎勵的強化學習在三維空間智能建模中的有效性與通用性。

MetaSpatial:引入R1突破3D空間推理壁壘

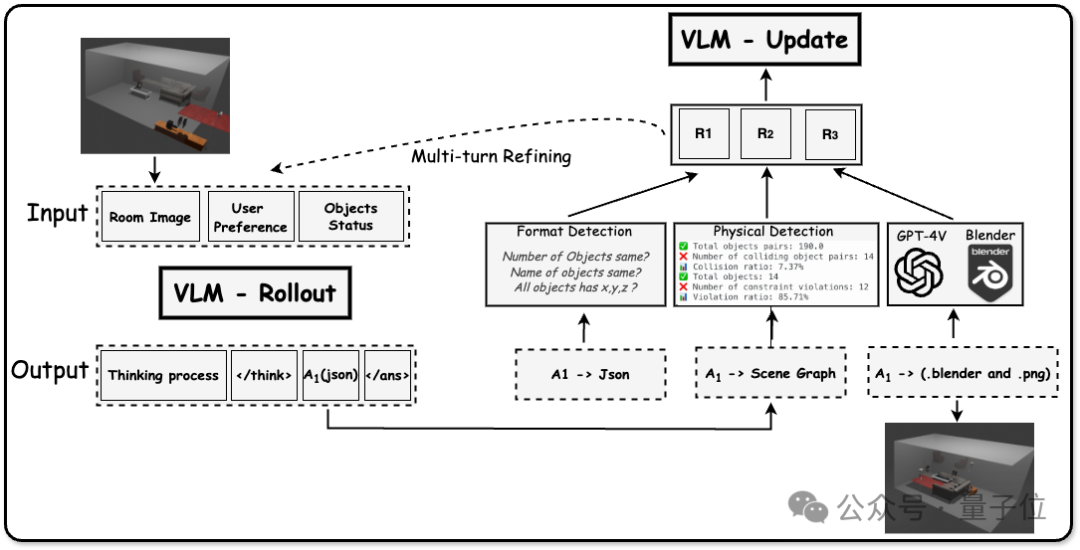

MetaSpatial 將訓練3D空間推理過程建模為一個多輪決策過程,其基本形式是:給定一組多模態輸入,模型通過一系列推理步驟生成結構化佈局輸出,並基於可程序化評估的獎勵信號進行策略優化。

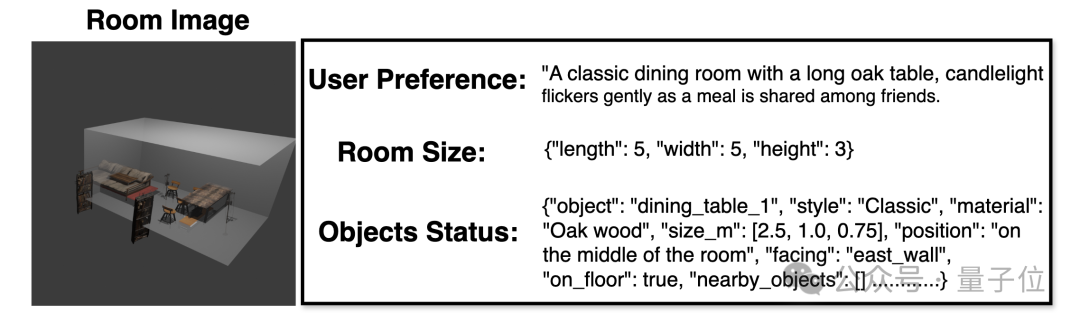

輸入與輸出形式

在每一輪交互中,MetaSpatial的輸入包括:

-

場景圖像或房間結構圖;

-

房間的幾何尺寸信息(長、寬、高);

-

用戶提供的偏好描述(如功能用途、風格要求等);

-

需要佈局的目標物體列表(包含物體類型、狀態等)。

模型輸出為兩個部分:

-

語言化的推理過程:記錄模型在佈局時的決策理由;

-

結構化佈局 JSON:每個物體的三維坐標位置(x, y, z)和名稱等,作為佈局結果。

<think>The goal is to arrange the objects in a dinning room setting that includes a ,..., and respect the spatial constraints and user preferences. Here's how we can approach this:1. **Kitchen Island**: Place it centrally ...2. **Hanging Pot Rack**: Hang it above ......Let's compute the positions:- **Kitchen Island**: (3, 2.5, 0.45)- **Hanging Pot Rack**: (3, 2.5, 0.65)...Now, let's generate the JSON output.</think><answer>[{"new_object_id": "kitchen_island_1", "x": 3.0, "y": 2.5, "z": 0.45}, ......]</answer>

該佈局JSON文件既作為最終輸出,也作為強化學習中的環境狀態,用於評估和反饋。

獎勵函數與懲罰機制設計

為了衡量佈局結果的好壞,MetaSpatial構建了三級獎勵信號,分別從結構合法性、物理合理性和主觀偏好三個維度評價模型輸出:

1. 格式獎勵(Format Reward)

-

檢查輸出的 JSON 是否完整;

-

所有目標物體是否都被覆蓋;

-

每個物體是否都包含完整的空間參數(x/y/z 坐標、尺寸、方向等)。

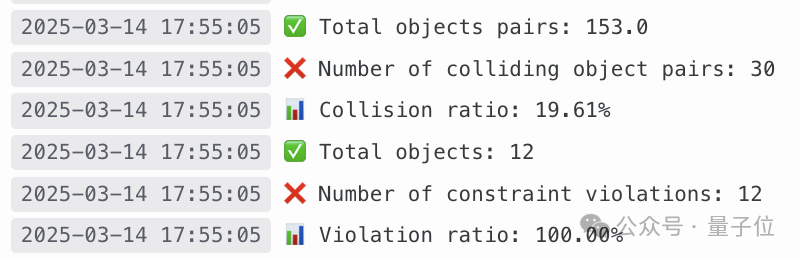

2. 物理獎勵(Physics Reward)

-

利用輸出中的幾何信息重建場景;

-

計算是否存在物體之間的重疊(collision);

-

檢查物體是否越界、浮空或違反場景邊界;

-

對不滿足物理約束的比例部分施加懲罰。

3. 物理獎勵(Physics Reward)

-

將輸出佈局通過腳本用Blender渲染為三維場景圖;

-

輸入至 GPT-4o 進行審美評分;

-

綜合評分其物理一致性、美學質量與用戶偏好匹配度。

{'realism_and_3d_geometric_consistency': {'mean': 5.0, 'std': 0.0},'functionality_and_activity_based_alignment': {'mean': 6.0, 'std': 0.0},'layout_and_furniture': {'mean': 5.0, 'std': 0.0},'color_scheme_and_material_choices': {'mean': 4.0, 'std': 0.0},'overall_aesthetic_and_atmosphere': {'mean': 4.0, 'std': 0.0}}

最終獎勵為三者的加權組合,提供連續型反饋信號,以供強化學習優化使用。

Trajectory 生成與多輪佈局優化

與傳統一次性生成不同,MetaSpatial 在訓練階段採用multi-turn rollout策略,允許模型對佈局結果進行多輪 refinement:

-

初始佈局生成後,模型可查看自己生成的坐標結構與得分;

-

根據獎勵反饋進行佈局更新並重覆多輪;

-

每一輪的輸入、輸出、獎勵構成一條佈局軌跡(trajectory);

-

多輪優化後選取最終佈局作為當前 episode 的最終結果。

這種機制不僅提高了模型的佈局能力,也為策略訓練提供了更多的高質量決策路徑。

策略優化:基於 GRPO 的強化學習訓練

為實現穩定、高效的策略更新,MetaSpatial引入了Group Relative Policy Optimization(GRPO)。與常規的策略梯度方法不同,GRPO 不依賴於單條軌跡進行更新,而是利用同一輸入樣本生成的多條trajectory作為一個group進行比較性學習。

具體過程如下:

-

對於每組輸入,執行多次layout generation,得到若幹個軌跡;

-

比較這些候選軌跡的獎勵得分,計算相對優勢;

-

根據組內得分排序結果,優化策略網絡,使高獎勵軌跡的概率增加,低獎勵軌跡的概率下降;

-

避免了對某一「絕對最優」解的依賴,提升了學習過程的穩定性與策略的泛化能力。

借助GRPO,MetaSpatial能夠在樣本極少(如僅50條無標註數據)的情況下,穩定學得適應性強的空間決策能力。

MetaSpatial實驗結果

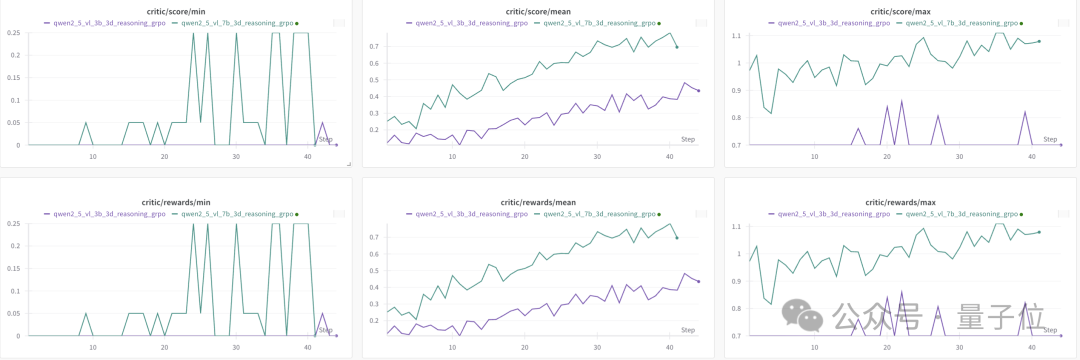

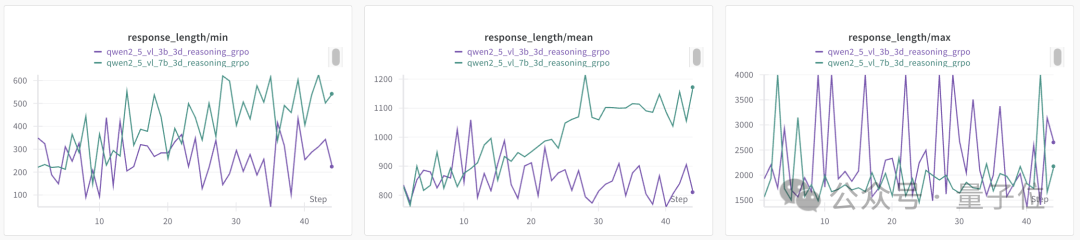

1. Qwen2.5 的 7B 和 3B 兩個視覺語言模型(VLM)都從 MetaSpatial 框架中受益,但其中 7B 模型的性能提升更加顯著。相比之下,3B 模型仍然在輸出格式的生成方面存在困難,比如無法始終保持與輸入一致的物體數量和名稱,或是未能為所有物體持續穩定地提供完整的三維坐標(x, y, z)。

2. 實驗結果表明,MetaSpatial 能夠有效提升Qwen2.5-VL的3B和7B 模型的空間佈局能力,但其中7B模型的提升更加明顯。具體表現為:隨著訓練的進行,7B模型能夠生成更長、更穩定、結構更清晰的響應,而3B模型的輸出則表現出較大的不一致性,其響應長度波動較大,最小值和最大值之間頻繁跳變,顯示出在保持輸出格式一致性方面的困難(例如:物體數量正確、結構化空間坐標完整等)。相比之下,7B模型的響應更加穩定,這也進一步印證了一個趨勢:規模更大的模型在強化學習驅動的空間推理任務中更具適應能力。

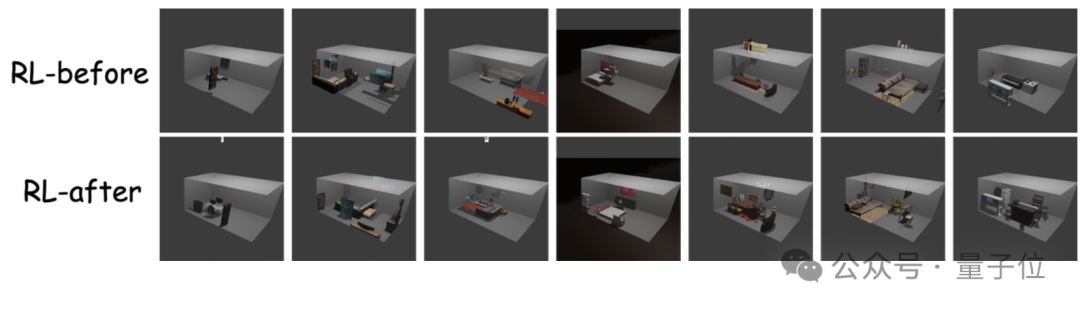

3. 在「RL-Before vs RL-After」的對比實驗中,MetaSpatial 框架在提升模型三維空間推理能力方面的效果得到了清晰體現。強化學習訓練前,模型生成的物體佈局普遍混亂、錯位,且常出現物體漂浮、重疊或放置在不符合物理規律的位置等問題。訓練後,生成的佈局則變得更加結構化、逼真,並且在語義上更加連貫,表現出更強的空間感知能力、物體對齊能力以及功能合理性。

這些結果進一步強化了一個核心結論:強化學習能夠有效優化視覺語言模型的空間推理策略,使其具備更自然、更實用的三維場景生成能力,可廣泛應用於如元宇宙、AR/VR 以及遊戲開發等多種現實場景中。

總結

總的來說,MetaSpatial的貢獻主要有下面四部分:

-

提出 MetaSpatial 框架:提出了 MetaSpatial,第一個基於強化學習(RL)的三維空間推理框架,使視覺語言模型(VLMs)能夠在無需複雜後處理的情況下直接生成結構合理的三維場景。

-

引入多輪佈局優化機制與 GRPO 策略:設計了一種多輪佈局 refinement 機制,結合 Group Relative Policy Optimization(GRPO)方法,使模型能通過多次調整與推理路徑,學習更具泛化性與適應性的空間推理能力。

-

構建三重獎勵體系:設計了一套結構化評估體系,涵蓋格式檢測、物理合理性檢測與基於渲染的視覺評價,為強化學習提供自適應、可擴展的獎勵信號。

-

驗證方法有效性:在多種模型和空間場景上進行的實驗證明,MetaSpatial 能顯著提升模型在三維場景生成中的佈局連貫性、物理一致性和整體質量。

目前,項目已全面開源,包含訓練代碼、評測流程、數據集生成腳本以及完整的數據集。

項目地址: https://github.com/PzySeere/MetaSpatial

一鍵三連「點讚」「轉發」「小心心」

歡迎在評論區留下你的想法!