2030年,AGI概率至少10%,AI範式轉變快,誰能預測GenAI下一代?

Epoch AI高級研究員預測:2030年實現人類水平的AI的可能性至少10%。他認為AI從監督學習到GenAI,模型範式轉變迅捷,預測AI只能從第一性原理出發。參考人類大腦,他估算了發現人類水平的AI需要的算力,得到相關結論。

AGI已經來了?還是快來了?還是說AGI也是一種「技術烏托邦」?

對於AI的能力,到底該如何預測? AGI帶給人類的是「祝福」還是「詛咒」?

最近,Epoch AI高級研究員Ege Erdil論證了如何預測AI的能力:

1) 基於當前AI能力的外推預測:通常在估計AI在已具備基礎能力的任務上的進展速度時更可靠。

2)第一性原理推理:在預測AI尚無法完成或只能極其勉強完成的任務時,往往更加準確。

結合兩種方法,他認為到2030年實現人類智力水平的AI可能性至少10%,樂觀估計為20%。

此外,由於AI未來帶來的經濟收益主要來源於它目前尚未掌握的任務,如果僅僅依賴第一種外推法,那麼極有可能嚴重低估AI未來的發展速度、廣度以及影響力。

預測AI也得講道理

在嘗試預測AI系統未來的能力及其將帶來的經濟和社會影響時,通常有兩種不同的方法:

1)回顧過去以及事物變化的速度,然後嘗試將現在的情況外推到未來。 這種方法傾向於分析過去的數據和趨勢來推測未來的走向。

2)基於第一性原理推理,考慮人腦的能力和資源使用情況、不同領域的訓練數據的可用性、獲取不同任務的獎勵信號的成本等,以估計自動化任務的難度。 這種方法更加理論化,它依賴於對基本事實的理解來進行邏輯推理。

這兩種方法代表了預測AI能力的兩種根本不同的方式。

第一種方法更常被經濟學家所青睞,因為它依賴於歷史數據和趨勢分析,便於理解和應用。

而第二種方法則更適合用於深入探討技術可行性及其限制,提供了關於AI發展可能遇到的技術障礙的洞察。

每種方法都有其獨特的優勢和局限,在實踐中可能會結合使用以獲得更全面的視角。

採用第一種方法的人在預測時,往往假設:在未來AI在最容易完成的任務,與AI當時能夠完成的任務相似。

一篇2013年出版的經濟學論文中,Frey和Osborne試圖估算不同職業對計算機化的敏感程度,其中的一段話很好地概括了這一觀點:

……計算機能夠執行的任務最終取決於程序員編寫一套程序或規則的能力,以便在各種可能的情況下正確引導技術。

因此,當一個問題可以被明確指定——也就是說,成功的標準是可量化且可以被輕鬆評估時,計算機相較於人類勞動將表現得更加高效。

文章鏈接:https://oms-www.files.svdcdn.com/production/downloads/academic/The_Future_of_Employment.pdf

當時這一預測或許合理,但在接下來的十年里,隨著深度學習的進步,它被證明是個錯誤。

AI:從監督學習到GenAI

如今,LLM能夠執行許多任務,而人類甚至無法完全理解內部原理。

而且,儘管清晰的問題定義仍然重要,但重要性體現在不同的方面。

在深度學習革命之後,AI經濟學中出現了一種新的視角,即將AI系統視為「預測機器」(Prediction Machines)。

這一觀點是對當時AI系統能力的反映:在2012年至2019年間,適用於預測任務的監督學習方法主導了該領域。

因此,一些人再次犯下了類似的錯誤,簡單地假設它會像2010年代中期的監督學習一樣,認為AI的未來只是擁有更強大的預測能力。

從《預測機器》中,可以看到一些相關的引用,清楚地說明了這一點:

…我們所見到的進步主要發生在機器學習領域,而機器學習更準確地說是一種統計學的進步,儘管是非常重大的進步;具體來說,是在用於生成預測的統計方法上的進步。

新的AI技術將極大降低什麼成本?預測。

因此,正如經濟學所告訴我們的,不僅預測的使用將大幅增加,我們還會看到在一些新領域中,它令人驚訝地適用。

Frey和Osborne預測計算機化一樣,上述新推測也被後來的發展所推翻,尤其是AI領域向無監督學習的轉變,以及如今所謂的「生成式AI」(Generative AI)的興起。

相比於上述例子,AI研究者和未來學家,常常使用的是從第一性原理出發的推理方法(first-principles reasoning)。

其中最著名的例子可能是Ray Kurzweil。

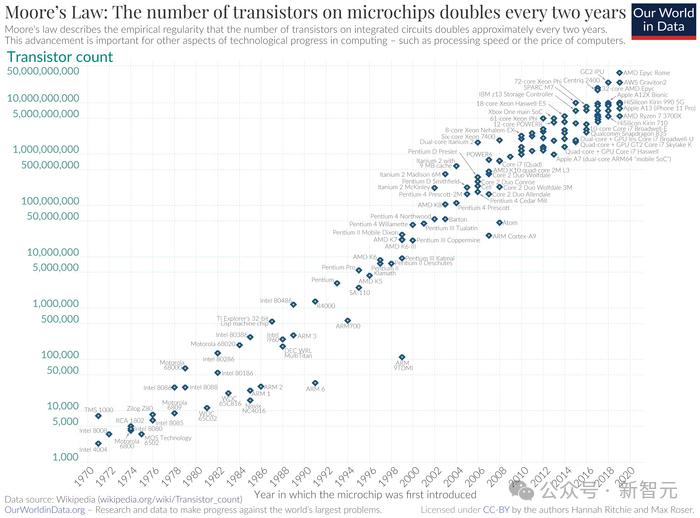

在1999年,他估算人腦的計算能力約為10^{16}次運算每秒,並結合摩亞定律(Moore’s Law)預測人類水平的AI系統將在2029年誕生。

摩亞定律

摩亞定律外推預測的風險

使用簡單的模型將過去的數據外推到未來,是經過驗證的預測方法,在許多領域都適用。

然而,在AI領域,如果僅依賴這種方法,存在嚴重的局限性。

最主要的問題在於,這類方法過度依賴AI過去和當前的能力,導致低估未來AI的突破,特別是在當前完全無法勝任的任務上。

採用這種方法時,預測者即便有意識地試圖考慮AI未來可能的進步,仍然傾向於認為未來的AI只是現在AI的增強版,其能力範圍會逐步擴展到與現有任務相鄰的領域。

目前,這種錯誤的最新表現形式是將AI的最新發展局限在「生成式AI」(Generative AI)的框架內。

就像過去「預測機器」的概念一樣,這種狹隘的視角讓人誤以為,AI未來的能力可以通過簡單推測「今天的圖像生成器和聊天機器人會變得更便宜、更高效」來預測。

這種方法的局限性不可忽視 。

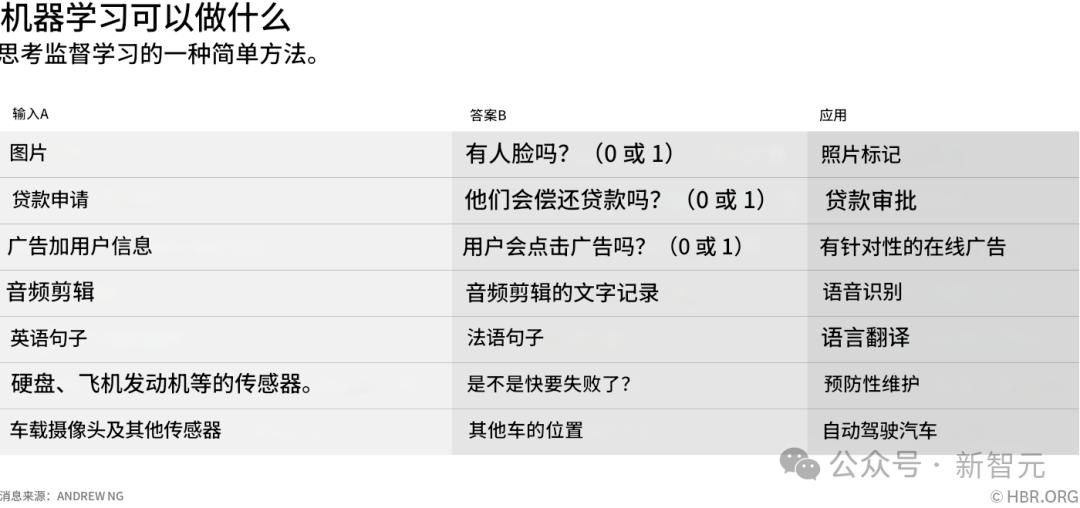

為了說明並提醒大家AI發展的不可預測性,在下方列出了一張表格,其中展示2016年人們認為AI重要能力的清單,對比今天的發展,你會發現當時的許多預測都已過時。

請注意,對2025年的用戶來說顯得重要的能力——問答、閱讀理解、圖像生成、編程、數學——在表中都沒有出現。

這些都是由於scaling law和算法進步而出現的新能力。

如果只使用樸素外推法來預測2025年AI系統性能,那麼沒有人都預料到這些能力。

我們應該期待,AI當前能力與十年後能力之間的差異將同樣巨大。這應該成為一種共識。

不宜外推AI對經濟影響

在最近的論文中,Acemoglu犯了錯誤:過度依賴這種簡單外推法。

Acemoglu借鑒了其他幾位作者的研究,這些作者對不同經濟任務受LLM自動化影響的程度以及在這些受影響任務上可能合理預期的成本節約進行了估算。

Acemoglu估計,由於AI的影響,未來十年經濟產出將增長0.7%。結合三個不同的估算,得出了這個數字:

(1)Eloundou等人(2023年)的估計表明,在美國按薪金賬單計算的大約20%的任務暴露於由大語言模型實現的自動化之下。

(2)Svanberg等人(2024年)估計,在當前暴露於計算機視覺系統自動化的任務中,只有23%的任務實際進行自動化是具有成本效益的。

(3)Acemoglu假設,在這些自動化任務上,相較於由人類執行這些任務,平均可以節省大約30%的勞動力成本。

(4)Acemoglu進一步估計,這些任務成本的大約50%實際上是勞動力成本,因此總成本節約約為15%(即30%的勞動力成本節約乘以勞動力成本佔總成本的50%)。

最後,關於這種自動化對GDP影響的粗略計算方法是:

首先計算成本減少的任務比例,大約為0.2*0.23=4.6%。

然後,考慮到生產力提升的隱含值約為1/0.85=17.6%,這是因為成本節約了15%,意味著原本的成本效率提高到了100/(100-15)≈117.6%,即提升了17.6%。

最後,將這兩個數值相乘(4.6%*17.6%),得出總全要素生產率影響大約為0.8%。

這個分析提供了對自動化技術可能帶來的經濟效益的量化視角,儘管實際情況可能會因多種因素而有所不同。

論文地址:https://shapingwork.mit.edu/wp-content/uploads/2024/05/Acemoglu_Macroeconomics-of-AI_May-2024.pdf

這是一個對可能總結為「LLMs,但更好」的假設性技術的經濟產出影響的合理估計。

然而,這並不是我們應該對未來10年內的AI系統的期望:我們應該期望它們能夠執行許多當前AI根本無法執行的任務。

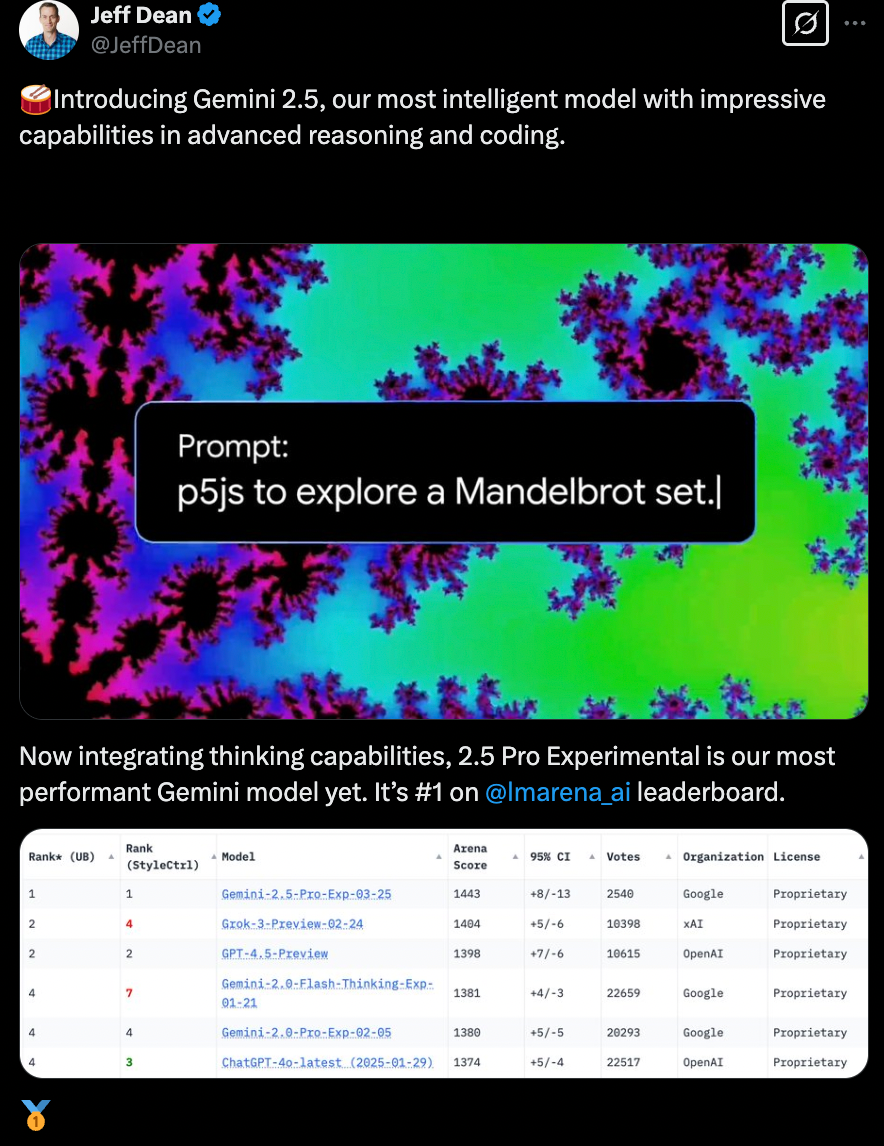

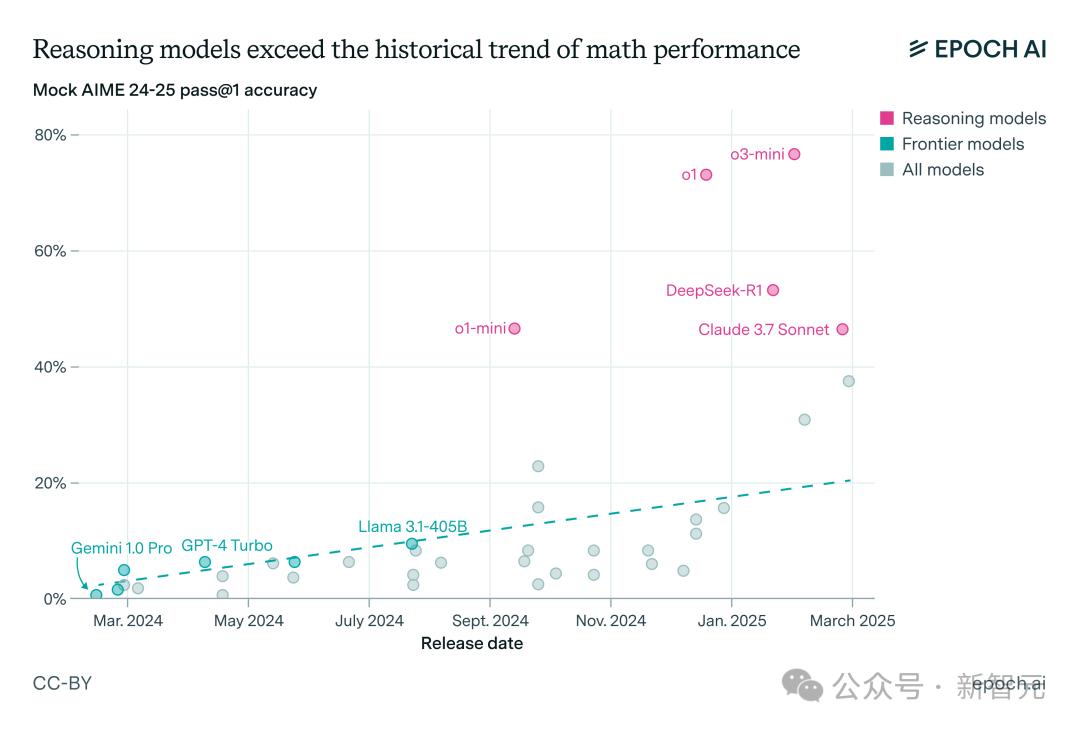

例如,下圖展示了測試時計算範式轉變對LLM數學性能影響。

基本觀點是,目前AI能夠做到的事情並不能講好未來的故事。

如果想要預測未來幾年之外的AI發展,那麼將目光局限於當前AI系統的能力,甚至局限於這些能力的當前變化速度,並不是一個好的選擇。

推理模型超越數學性能的歷史趨勢

推理模型超越數學性能的歷史趨勢從先驗角度來看,在未來十年中,我們應該期待會出現許多這樣的不連續性和突然湧現的能力。

因此,儘管基於當前AI的能力進行預測似乎是一種更為穩妥和合理的方法,但實際上這種方法很可能嚴重不準確。

相反,允許技術進步突然加速和新能力出現的更具推測性的方法,可能會做出更好的預測。

有什麼替代方法嗎?

無法迴避的問題是,預測未來本身就非常困難,尤其是在缺乏明確趨勢可供外推的情況下。

例如,目前缺乏針對遠程辦公任務和機器人技術的高質量基準測試,即使有這樣的基準測試,也會發現當前系統在這些任務上表現非常差,而線性外推可能會將它們的成熟期推遲到幾十年甚至幾百年之後。

這顯然不是一種合理的方式來預測AI何時能在這些任務上表現出色,因為我們一再看到,基準測試的分數並不是時間的線性函數。

參考人類大腦預測AI能力

對於這些「尚未湧現」的任務——即人類可以完成但當前AI完全無法完成的任務,預測應該參考人類大腦及其資源需求所提供的存在性證明。

對於人類大腦能夠執行的認知任務,可以說以下條件至少足以構建能夠執行該任務的神經網絡:

1、運行時計算能力:1e15 FLOP/s,這是估計大腦執行計算的大致能力。

2、訓練計算量:1e24 FLOP,人類在30歲之前大約存活了10億秒。

3、訓練算法:大小遠小於100MB,並且進化搜索算法變體所需的計算量遠小於1e45 FLOP。大小限制來自基因組的大小,而搜索計算限制則來自進化過程中可能發生的有效計算的熱力學極限。

4、訓練數據量:與人類在終身學習過程中接觸到的數據量相當。

想要構建能夠執行類似人類任務的AI系統,這些條件提供了一個理論上的下限。

在這些目標中,在大多數任務上,目前的新進展是能滿足條件1、2和4。

要知道,直到大約2年前,AI系統的訓練計算能力才突破1e24 FLOP,達到了條件2。

而尚未擁有展現出超越人類能力的AI系統,這表明在許多領域,算法仍遜色於人類大腦:還沒有達到條件3。

2030年AGI可能性:10%-20%

搜索滿足條件3算法的實際算力需求,難以確定,也難以消除。

因此保守的估計是:在發現能超越人腦的算法上,需要投入的計算量,在目前累計的計算量(可能在1e26到1e30 FLOP之間)和1e45 FLOP之間均勻分佈。

預計到本年代末,累計計算量將增加大約1000倍。

從目前的情況來看,這意味著人類大約有20%的機會找到正確的算法。

即使考慮到模型的不確定性,把這個概率減半,到2030年實現人類水平的AI的可能性仍有10%。

這甚至還沒有考慮到以下可能性:

與進化不同,人類能夠在算法搜索、模型訓練和模型推理之間進行權衡,並將訓練計算量分攤到模型的所有部署實例中。

這較差的算法,可能通過更多的訓練和推理計算來彌補。

事實上,Ege Erdil預計首批達到人類水平的AI系統會這樣做。

考慮到這一點,概率應該會顯著高於10%。(儘管具體有高多少,還不知道。)

結合Moravec悖論,對AI在哪些任務上會首先達到人類水平有了一個預期:這些任務正是AI相對於人類具有更大數據優勢和較小算法劣勢的任務。

例如,儘管Eloundou等人2023年的論文得出結論認為,需要科學技能的任務,預計會抵抗LLM自動化。

論文鏈接:https://arxiv.org/abs/2303.10130

論文鏈接:https://arxiv.org/abs/2303.10130但Ege Erdil認為:「這種更廣泛的視角實際上表明,這反而是它更容易受到AI自動化影響的原因。」

原因是,相對於感覺運動和感知任務,科學推理並不是那種人類具有高效算法的任務。

結論

基本的結論是,AI目前能做什麼並不是重點。

如果想預測AI未來幾年之後的發展,僅僅以當前AI系統的能力,甚至當前這些能力的變化速度作為錨點,並不是一個好主意。

相反,應該從各種任務的內在難度出發來思考,儘管當前AI系統在許多任務上完全無法勝任,但這恰恰反映了使用AI自動化這些任務所需的資源需求。

當這樣做時,就會得到對AI進展更為樂觀的圖景,這更符合近期的歷史。

許多人現在提出的關於「生成式AI」系統能力本質上受限的論點,如果放在2016年用來預測當時AI系統的局限性,可能會表現得很糟糕。

如果我們希望我們的預測更準確,就不應該依賴那些過去表現不佳的預測方法。

參考資料:

https://epoch.ai/gradient-updates/what-ai-can-currently-do-is-not-the-story

本文來自微信公眾號「新智元」,作者:KingHZ,36氪經授權發佈。