Stable Diffusion變身3D神器,一個LoRA將2D圖像轉3D模型

在Stable Diffusion當中,只需加入一個LoRA就能根據圖像創建3D模型了?

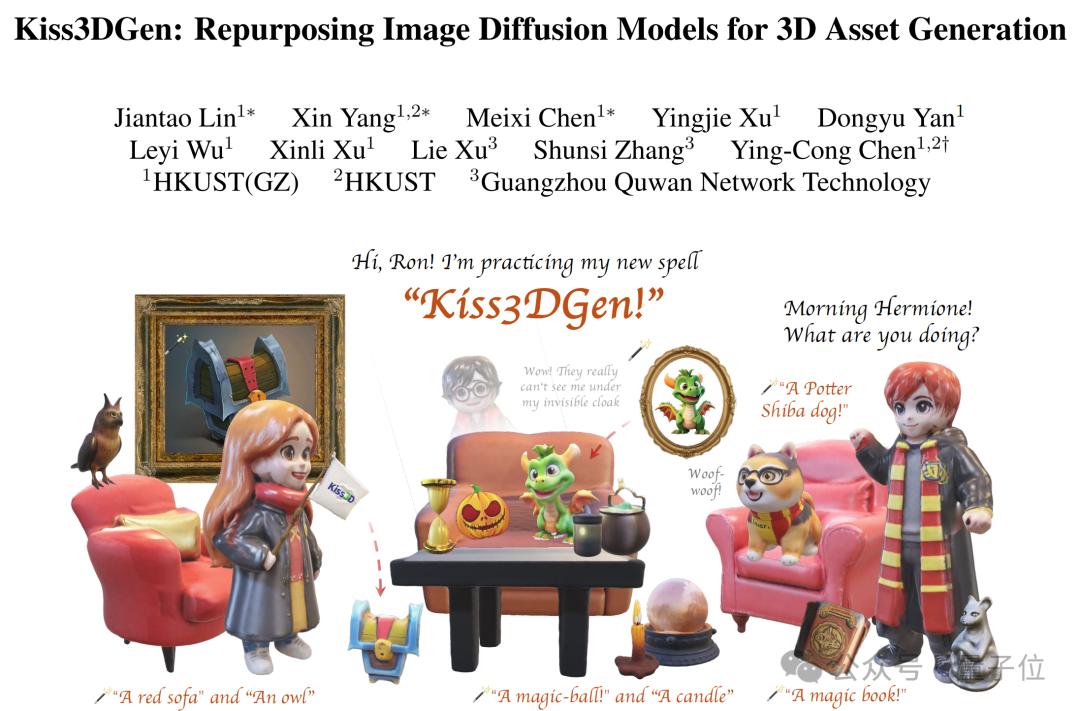

港科大(廣州)與趣丸科技合作推出了全新三維生成大模型——Kiss3DGen,創新性地將3D生成與成熟的圖像生成模型進行了對齊。

並且與主流2D擴散模型技術(如ControlNet、Flux-Redux)兼容協同,無需額外訓練即可即插即用。

△由Kiss3DGen生成的場景

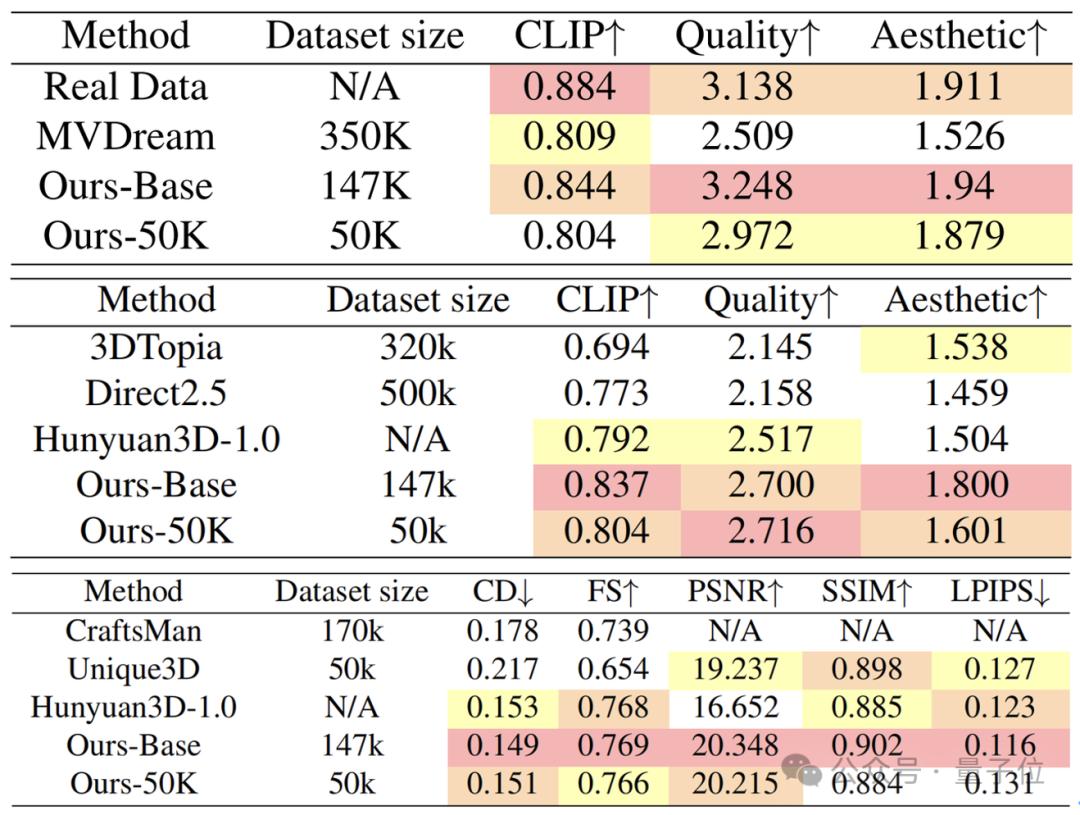

△由Kiss3DGen生成的場景即使在有限的訓練數據條件下,Kiss3DGen仍能生成高質量的3D資產,減少對大規模數據的依賴,同時在靈活性和性能方面表現出色。

目前,Kiss3DGen單獨使用效果已優於現有開源方法,而且在與現有方法相結合後,性能可進一步增強。

將3D生成轉換為2D生圖

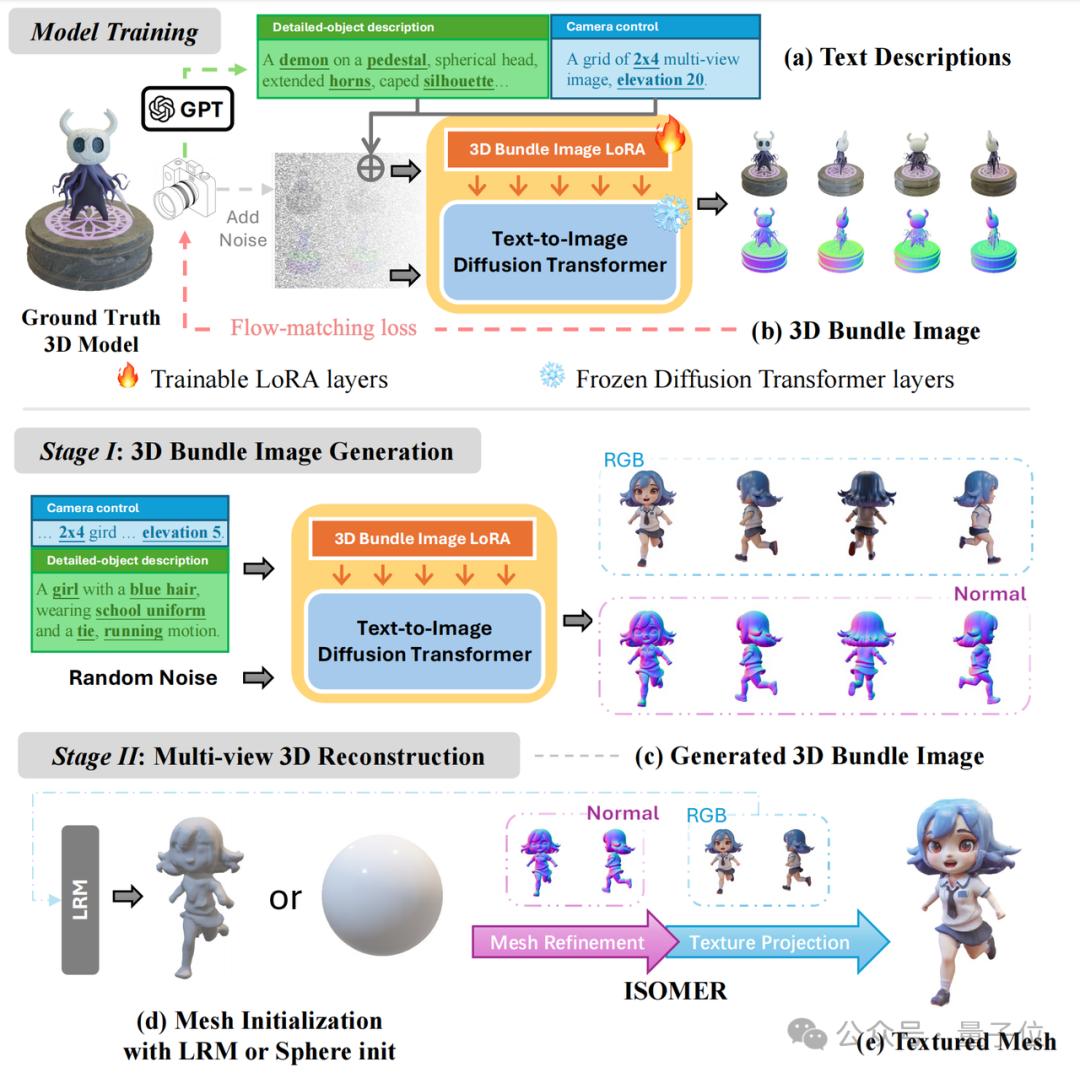

Kiss3DGen的核心創新點在充分利用現有2D圖像生成模型的知識與框架,將多視圖圖像和對應法線貼圖拚接成三維聚合圖(3D Bundle Image),把傳統3D生成問題轉化為2D圖像生成任務。

這種方式無需調整現有2D模型的結構,能夠最大程度繼承其成熟的技術優勢。

具體流程可分為兩大步驟:

- 三維聚合圖生成:利用DiT(Diffusion Transformer)模型的全局感知能力,高效生成高度對齊的多視圖圖像及對應法線貼圖,無需調整2D模型結構,即可繼承其成熟技術優勢。

- Mesh與紋理重建:利用生成的法線貼圖進行Mesh重建,通過圖像部分生成對應的貼圖。整個過程無需額外訓練,可直接使用現有重建方法完成高質量3D資產生成。

在訓練階段,需要構建高質量文本-3D數據集,使用LoRA技術對預訓練的文本-圖像擴散模型(如Flux或SD3.5)進行微調,生成高度符合文本描述的三維聚合圖。

而生成階段又可以分為兩個環節——

首先利用訓練好的模型,根據輸入文本提示,生成包含3D模型多視角信息的三維聚合圖。

然後,通過LRM或球體初始化方法粗略重建幾何和紋理,再通過網格優化與紋理投影技術(如ISOMER),精確重建3D模型的幾何形狀和紋理細節。

團隊簡介

該研究的作者為林堅濤、楊鑫以及陳美羲,他們是來自於香港科技大學(廣州)ENVISION實驗室的碩博生。

本工作由趣丸科技資助,由陳穎聰教授帶領碩博研究團隊與趣丸科技聯合打造。

陳穎聰,香港科技大學(廣州)人工智能學域助理教授,博導,受國家人才計劃青年項目資助,他長期致力於計算機視覺和視覺生成模型的研究,已在TPAMI、CVPR、ICCV、ECCV等頂級會議和期刊發表五十餘篇論文。

陳教授的研究方向包括三維生成與重建、圖像影片生成等,並多次以第一作者身份在頂級會議上做口頭報告。

他的研究成果屢獲大獎,包括ICCV 2023最佳論文提名和中國圖像圖形學會自然科學獎一等獎。

同時,陳教授也在多個學術會議和期刊中擔任程序委員會成員或審稿人,並與多個科技公司建立了深入的合作關係。

論文:

https://arxiv.org/abs/2503.01370

代碼:

https://github.com/EnVision-Research/Kiss3DGen

項目主頁:

https://ltt-o.github.io/Kiss3dgen.github.io

在線體驗:

https://gen3d.funnycp.com

實驗室主頁:

https://envision-research.hkust-gz.edu.cn/index.html

本文來自微信公眾號「量子位」,作者:關注前沿科技,36氪經授權發佈。