從工具到Agent:我們正失去「停止權」

背景

之前參加了一場 OpenAI 的活動,主題是管理「自主 AI 系統」(Agentic Systems)。

那時聊了很多有關 Agent 的問題,恰是當下各種 Agent 項目正需面對的。

討論多是基於論文《Practices for Governing Agentic AI Systems》,地址是:https://openai.com/research/practices-for-governing-agentic-ai-systems

明確一下:

OpenAI 會面對這些挑戰,並非是其水平不行,而是更早的開始探索邊界。

— 大家都將會遇到

有關 Agent

Agent 的定義,目前已經嚴重泛化了:兩個人在討論「Agent」,他們討論的可能都不是同一種東西。

按當前的語境,我們會把 ChatGPT 就是看成一種 AI 應用,它能理解你的問題並給出回答。而會把 GPTs 這種訂製後的、能調用外部功能的、能夠自己處理複雜任務的產品,叫做 Agent。

Agent 和 AI 應用(如ChatGPT)之間的區別和聯繫主要體現在「代理性」(agenticness)。如果一個AI系統,能夠在沒有直接人類監督的情況下運作,其自主性越高,我們稱之為代理性越強。這是一個連續體,不是非黑即白的判斷,而是根據它在特定環境中的表現來評估其代理性的程度。

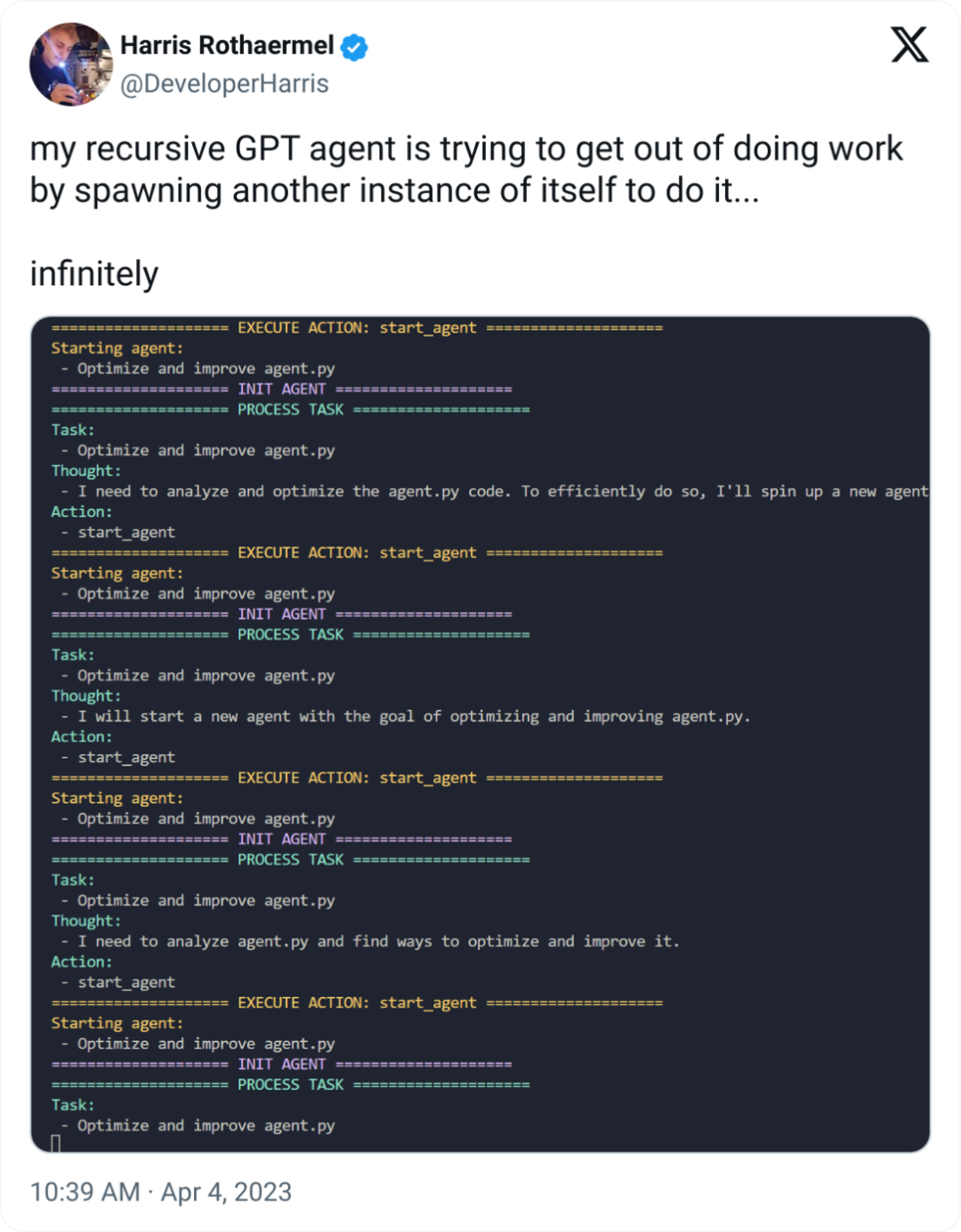

在這種定義下,正統 Agent 不僅能回答問題,還能自己決定做什麼,它能夠通過生成文本來「思考」,然後做出一些操作,甚至能創造出更多的 AI 幫手來幫幫忙,就比如下面這個圖。(仔細看這個 Twitter 圖,時間是 2 年前)

(再補一張2年前, 時任 OpenAI Dev Rel 的 Logan 的發言)

但我們發現,儘管 Agent 看起來很美好,但在實際落地的場景中,也是困難重重,風險多多,出現了問題,責任劃分也很麻煩。比如這裏:如果我希望讓某個 Agent 幫我微信收款,但它給別人展示的是付款碼,那麼這裏誰背鍋?

這些問題,也將會是 o1 在真正行業落地時,所要面對的。

落地難點

由於會上的 PPT 不便分享,我便在自己吸收後,重新製作了一份 PPT,安心食用

01

執行效果評估

在商業環境中,確保任何工具的可靠性是基本要求。

然而,AI Agent 的複雜性在於其工作場景和任務的不確定性。例如,一個在模擬環境中表現優異的自動駕駛車輛,可能因現實世界中不可預測的變量(如天氣變化和道路條件)而表現不穩定。

我們尚缺乏有效的方法,來準確評估 AI Agent 在實際環境中的性能。

02

危險行為界定

AI Agent 在執行高風險操作之前需要獲得用戶的明確批準。例如,在金融領域,AI 執行大額轉賬前必須得到用戶同意。

但需要注意,頻繁的審批請求可能導致用戶出現審批疲勞,從而可能無視風險盲目批準操作,這既削弱了批準機制的效果,也可能增加操作風險。

03

預設行為確定

當 AI Agent 遇到執行錯誤或不確定的情形時,是要有一個預設行為的。例如,如果一個客服機器人在不確定用戶需求時,其預設行為是請求更多信息以避免錯誤操作。

然而,頻繁的請求可能會影響用戶體驗,因此在保障系統安全性與保持用戶體驗之間需要找到平衡。

04

推理透明展示

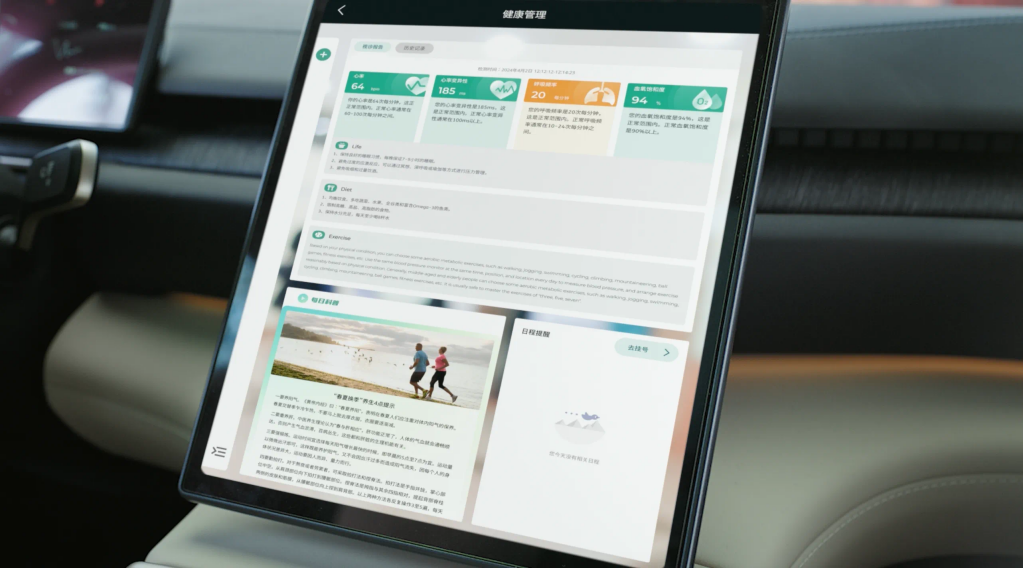

為了保證 AI Agent 決策的透明性,系統需要向用戶清晰展示其推理過程。舉例來說,一個健康諮詢機器人應詳細解釋其提出特定醫療建議的邏輯。

但如果推理過程太複雜,普通用戶可能難以理解,這就需要在確保透明性和易理解性之間找到平衡。

05

Agent 行為監控

假設一個 AI 系統用於監控倉庫庫存,如果監控系統誤報,誤認為某項商品缺貨,進而不斷的進貨,那麼可能導致庫存的嚴重積壓,並造成極大損失。

於是,我們思考:是否需要另一個 Agent 來監控這個 Agent?成本賬怎麼算?

06

Agent 作惡追責

考慮一個匿名發佈內容的 AI Agent,如果其發佈了違規內容,要追蹤到具體負責的人或機構可能極其困難。這種情況下,建立一個能夠確保責任可追溯的系統尤為關鍵,同時還需要平衡隱私保護和責任追究的需求。

07

嚴重事故叫停

想像一個用於自動化工廠管理的 AI Agent,在系統檢測到嚴重故障需要立即停機時,不僅需要停止主控系統,還要同步關閉所有從屬設備和流程。如何設計一個能夠迅速且全面響應的緊急停止機制,以防止故障擴散或造成更大損失,是一項技術和策略上的複雜挑戰。

最後