3D版DeepSeek捲起開源月:兩大基礎模型率先SOTA!又是VAST

衡宇 魚羊 發自 凹非寺

量子位 | 公眾號 QbitAI

3D生成版DeepSeek再上新高度!

國產、易用、性能強且開源——

新模型一露面就刷新SOTA,並且第一時間加入開源全家桶。

順時針轉個圈圈給大家看,效果是這樣:

加上「皮膚」是這樣:

再來一個,效果是這樣:

肉眼可見,這次妥妥升級變成了更細節的細節控~

以上效果,都來自3D大模型明星初創公司VAST,其剛剛上新的兩個基礎模型,TripoSG和TripoSF,為團隊的最新研發成果。該團隊去年3月開源了TripoSR,在開源3D生成基礎模型中爆火全球。

TripoSG,發佈即開源,一露面就刷新開源3D生成模型SOTA,讓廣大開發者第一時間享受技術進步的成果。

TripoSF,目前為開源第一階段,已經用實力證明了自己:橫掃一切開源和閉源的現有方法,拿下新SOTA。

你就說秀不秀吧(手動狗頭)?!

——但基礎模型還只是VAST最近大秀一波技術肌肉的上半程表演。

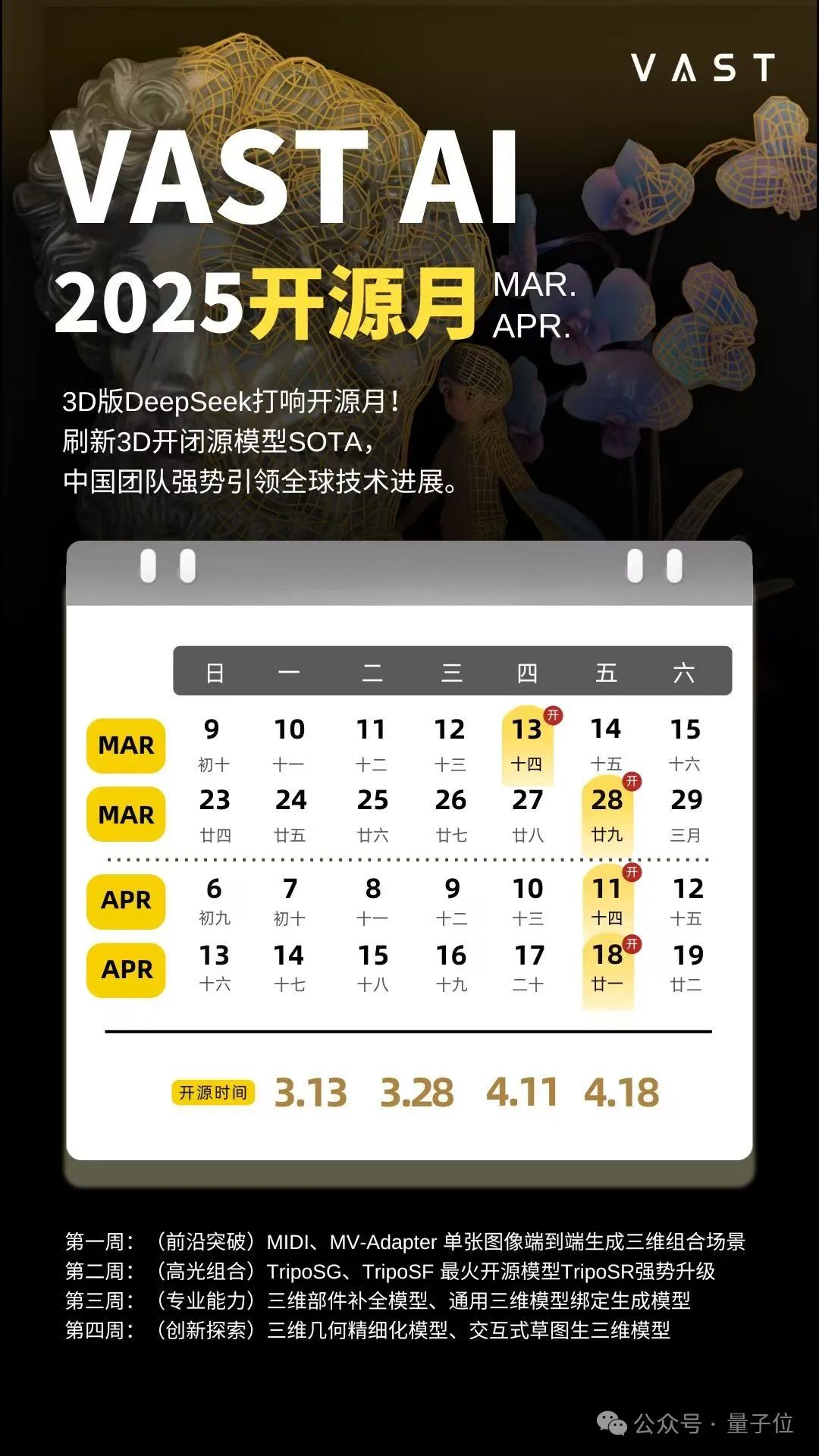

量子位獲悉,接下來VAST要連續開源一個月,每週都有新開源項目公佈。而TripoSG和TripoSF是開源月裡第二周的項目。

在整個開源月裡,除了第一波單張圖像端到端生成三維組合場景、第二波3D基礎模型,接下來還有三維部件補全模型、通用三維模型綁定生成模型、三維幾何精細化模型以及SIGGRAPH Asia 2024 RTL收錄的交互式草圖生三維模型等等技術將與大家見面。

港真,我的胃口已經被吊起來了。

在DeepSeek之後,各領域的國產之光們紛紛開啟了開源大秀。而VAST,就是領先的3D大模型領域公司率正選起的攻勢。

並且這個開源攻勢,持續一個月!

開源月第一彈,兩個基礎模型拿下開閉源新SOTA

3D版DeepSeek登場,一出手就是開源月;第二波出擊比第一波更猛,開源2個強大的基礎模型,很有誠意的那種。

它們分別是:

-

TripoSG:開源的3D模型新SOTA;目前開源1.5B版本。

-

TripoSF:以開源之身,刷新閉源3D模型SOTA;目前階段性開源部分成果。

都沿用了VAST最著名的Tripo系列來命名,但各有偏重——

TripoSG

對於TripoSG,官方介紹是這樣的:

一款在質量、細節和保真度上實現重大突破的基礎3D生成模型。

其開源內容,包括1.5B版本TripoSG的模型權重、推理代碼以及交互式演示Demo。

讓我們從技術側來剖析一下TripoSG的廬山真面目。

簡單來說,TripoSG身上體現了VAST針對3D領域特性,引入的多項關鍵設計創新。

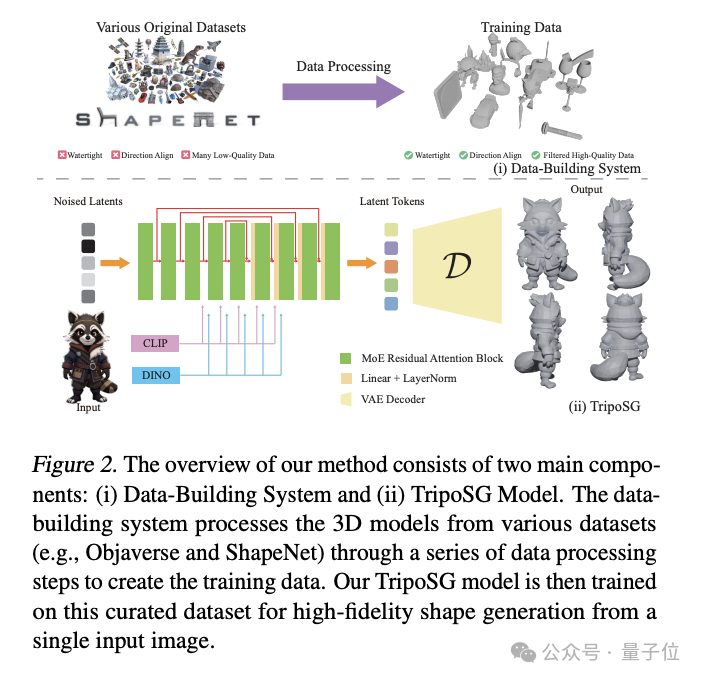

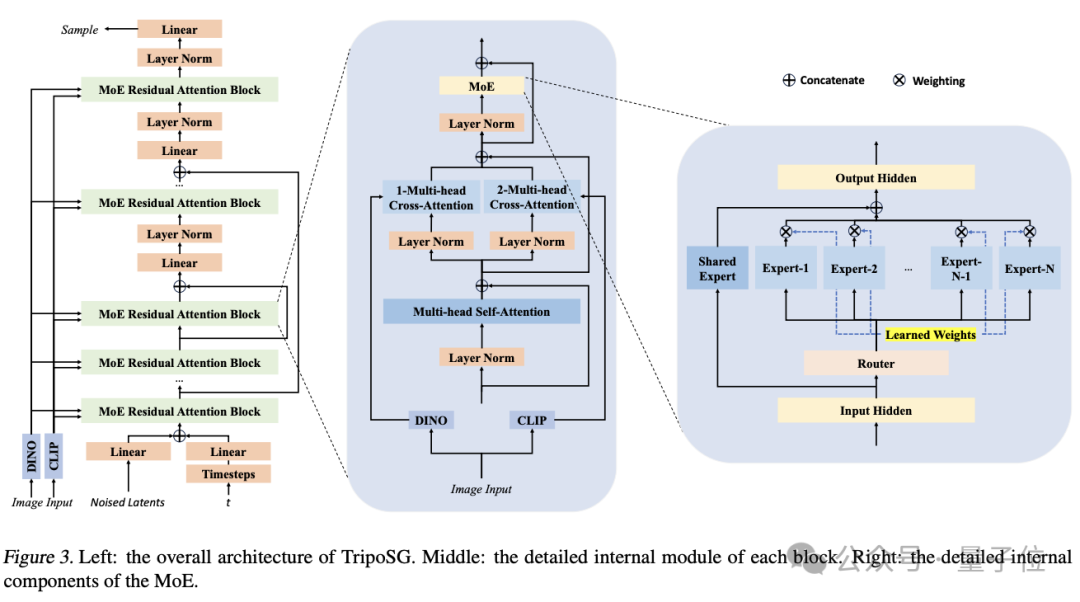

第一,率先將基於校正流(RF,Rectified Flow)的Transformer架構應用於3D形狀生成。

之所以選擇基於矯正流來做,是因為VAST在研究過程中發現,相較於傳統的擴散模型(Diffusion Model),矯正流在噪聲和數據之間提供了更簡潔的線性路徑建模,有助於實現更穩定、高效的訓練。

拿它結合已被驗證的可擴展性和卓越性能的Transformer架構(如DiT),屬於強強結合,讓TripoSG擁有很穩定的強大內核。

第二,TripoSG是首個在3D領域發佈的MoE Transformer模型。

以Transformer為基礎,TripoSG融合了包括跳躍連接(skip-connections)在內的關鍵增強設計,以改善跨層特徵融合。

此外,獨立的交叉注意力(cross-attention)機制能夠高效地注入全局(CLIP)和局部(DINOv2)圖像特徵,讓輸入的2D圖像和輸出的3D形狀之間精準對齊。

這還不夠,VAST團隊為了實現TripoSG的高效Scaling——從1.5B拓展到4B那種——團隊在Transformer中集成了MoE層。

這個辦法此前都只在大語言模型領域實踐過,VAST發現3D領域同樣適用。

這樣一來,可以在幾乎不增加推理計算成本的前提下,顯著提升模型參數容量,並重點應用於網絡中更深、更關鍵的層級。

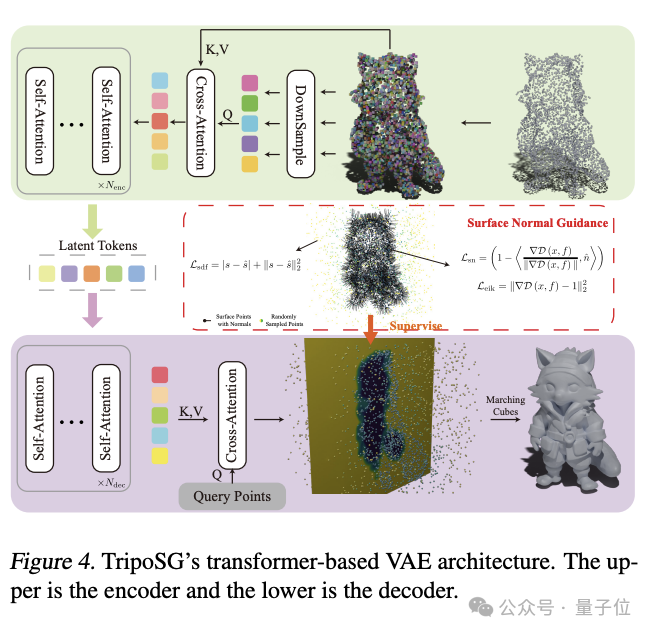

第三,開發了高質量VAE與創新幾何監督。

VAST開發了一種採用符號距離函數(SDFs,Signed Distance Functions)進行幾何表示的VAE,相較之下,比此前常用的體素佔用柵格(occupancy grids)具有更高的精度。

需要注意的是,基於Transformer的VAE架構在解像度上有很強的泛化性,無需重新訓練,即可處理更高解像度的輸入。

與此同時,TripoSG還引入了一種混合監督訓練策略,將標準的SDF損失與表面法線引導 (surface normal guidance)和 程函方程損失 (eikonal loss) 相結合。

讓VAE能學習到幾何上更準確、細節更豐富的表示,又能為後續的流模型提供了質量更高的潛空間。

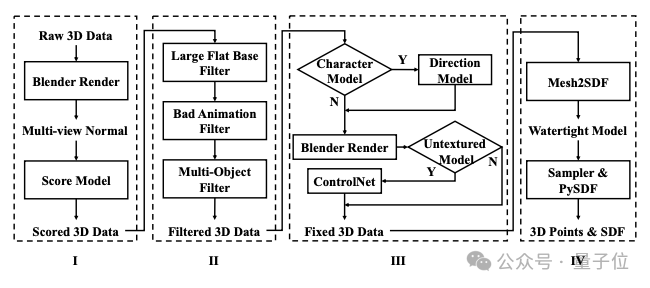

第四,重視數據治理,特意開發一套完善、精細的數據構建與治理流水線。

流程各階段如下:

質量評分(Scoring)——數據篩選(Filtering)——修復與增強(Fixing & Augmentation)——SDF 數據生產(SDF Production)

通過這一流程,VAST為TripoSG構建了一個包含200萬高質量「圖像-SDF」訓練樣本對的數據集。

消融實驗明確證明,在此高質量數據集上訓練的模型性能顯著優於在更大規模、但未經過濾的原始數據集上訓練的模型(這一點凸顯了數據質量與數量同等重要,甚至更為關鍵)。

集以上四點於一身的TripoSG,經Normal-FID等量化指標評估,以及基於大型多模態模型(如基於GPTEval3D框架的Claude 3.5)的定性評估,輕鬆拿下3D開源模型界的新SOTA。

讓我們來看看3D模型開源界新王的表現——

首先,TripoSG為什麼能拿下新SOTA,必然是在語義一致性上有超出現有模型的表現。

簡單來說,TripoSG輸出的3D形狀,能準確反映輸入圖像的語義內容和視覺外觀。

當你告訴它你想要一個三鬥櫃,既寫實又稍微Q一點那種,你將得到:

不渲染可能視覺上沒那麼明顯,但一上色,你就能發現「哎喲不錯哦」,確實是古樸寫實但又兼具可愛風。

還有一些日常生活的使用痕跡:

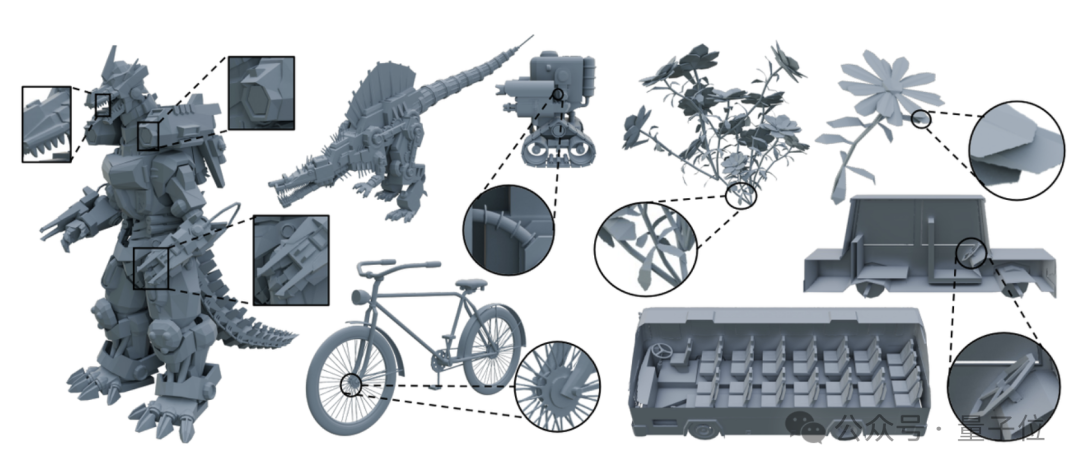

非常能直觀感受到的一點是,即使面對具有複雜拓撲結構或包含精細元素的挑戰性輸入,TripoSG也能生成連貫、合理的形狀。

TripoSF

再來看TripoSF。

研發TripoSF,VAST有專門的針對性目標,旨在突破傳統3D建模在細節、複雜結構和擴展性上的瓶頸。

具體來說,3D模型雖然也在不斷髮展之中,但現有方法仍有不足。比如預處理帶來的細節損失、對複雜幾何形狀表達能力的不足,或在高解像度下面臨高昂的內存和計算成本……

令人頭禿。

據VAST官方表示,此前一直在研究中尋找3D模型的tokenizer,現在終於有所進展——

沒錯,就是TripoSF的核心表示方法,SparseFlex。這傢伙拉高了3D生成任務的上限。

它借鑒了Flexicubes(可微分地提取帶尖銳特徵的網格)的優勢,並創造性地引入了稀疏體素結構,僅在物體表面附近的區域存儲和計算體素信息。

帶來的效果很顯著,約有以下三點:

-

大幅降低內存佔用,讓TripoSF能夠在1024³的高解像度下進行訓練和推理。

-

原生支持任意拓撲處理:不僅通過省略空白區域的體素,自然地表示開放表面(如布料、葉片),還有效捕捉內部結構。

-

支持基於渲染損失的直接優化:SparseFlex是可微分的,允許TripoSF使用渲染損失進行端到端訓練,避免了數據轉換(如水密化)導致的細節退化。

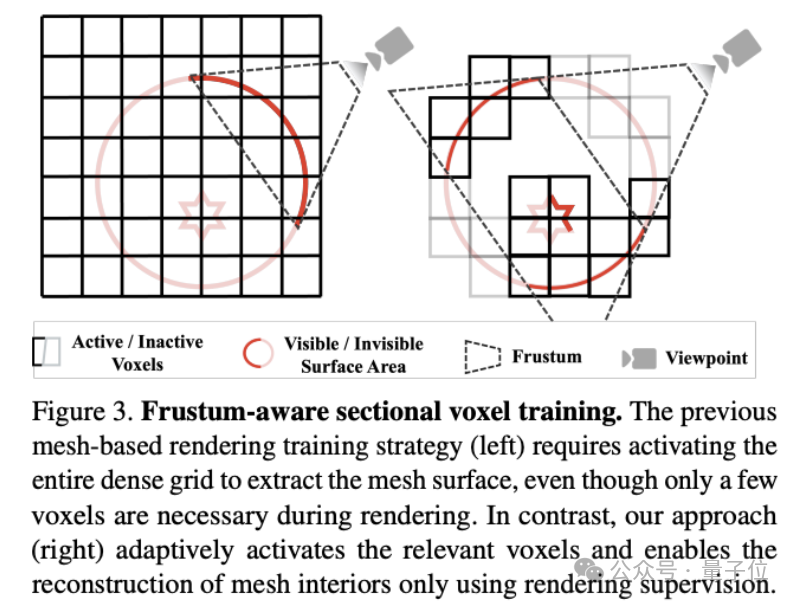

為了實現上述第一點,VAST還做了很多功課,最終推出一種叫「視錐體感知的分區體素訓練」的策略。

視錐體感知的分區體素訓練借鑒了實時渲染中的視錐體剔除思想,在每次訓練迭代中,僅激活和處理位於相機視錐體內的SparseFlex體素。

有針對性和選擇性的激活,顯著降低訓練開銷,讓1024³這樣高解像度下的高效訓練成為可能。

另一邊,視錐體感知的分區體素訓練策略首次使僅通過渲染監督即可重建模型的內部精細結構——在此之前,依賴水密表面數據的方法沒法完成這個任務。

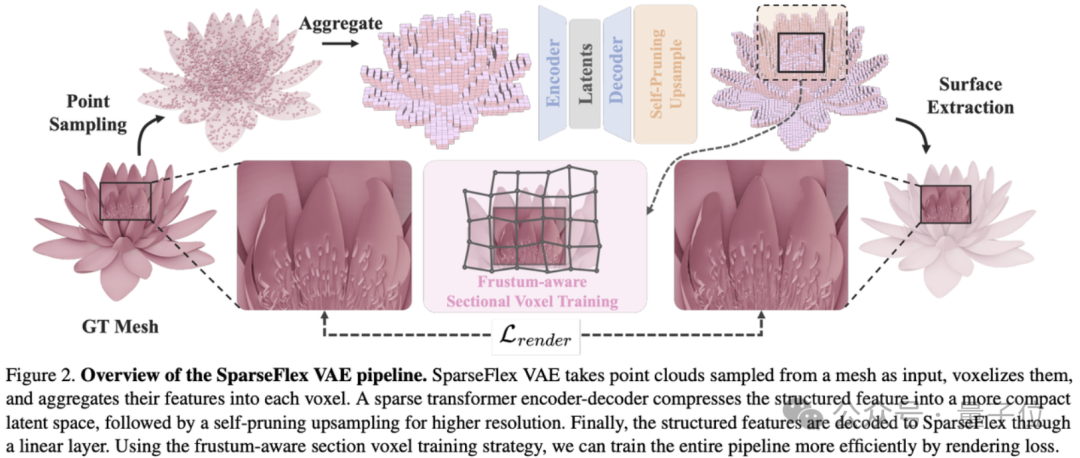

當然,還有不得不提的關鍵一步,即基於SparseFlex表示和高效的訓練策略,VAST還構建了TripoSF VAE(變分自編碼器),它成為了TripoSF重建和生成能力的基礎。

具體到輸入到輸出,是醬嬸兒的:

-

輸入:處理從三維網格采樣得到的點雲數據。

-

編碼:使用稀疏Transformer將輸入幾何映射為緊湊的隱空間編碼。

-

解碼:從隱編碼重建高解像度的SparseFlex參數,並採用自剪枝上采樣模塊 (self-pruning upsampling) 來保持稀疏性並精確定義邊界,尤其對開放表面效果顯著。

-

輸出:生成SparseFlex參數,可用於提取高質量的三維網格。

一頓操作過後,來看TripoSF的實戰表現——

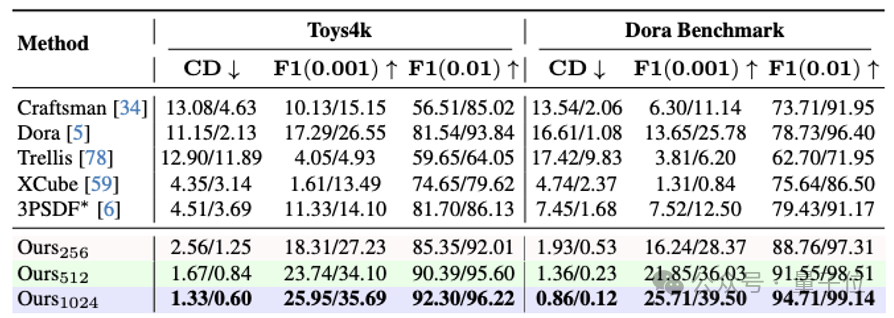

實驗結果表明,TripoSF的質量達到了新SOTA。

在多個標準基準測試中,TripoSF與先前方法相比,實現了約82%的Chamfer Distance降低和約88%的F-score提升。

而用TripoSF得到的模型,是這樣的:

多看幾個項目效果也能發現,確如論文中表述的那樣,有了SparseFlex的TripoSF,解像度高,細節退化情況大幅降低。

就,獲得的3D模型真的更真實了!我們多看幾個Case:

BTW,與TripoSG的開源策略不同,TirpoSF選擇了階段性開源的方法。

現在,TirpoSF開源了TripoSF VAE的預訓練模型及相關的推理代碼。

不過滿血版開源應該也不遠了!VAST官方表示,滿血版預計將在Tripo 3.0時開放。

且按耐住著急的心多等一會兒吧~

開源全家桶,從基礎模型到創新應用全覆蓋

開源月第二周發佈兩個基礎模型之外,量子位也搶先打聽到了VAST開源月的後續內容。

主打一個3D生成全流程技術覆蓋。

下週的開源月第三彈,主打3D生成模型的專業能力——

三維部件補全模型、通用三維模型綁定生成模型。

開源月最後一週的壓軸好戲,主打在3D生成領域的前沿探索——

三維幾何精細化模型以及SIGGRAPH Asia 2024 RTL收錄的交互式草圖生三維模型。

至於開源質量嘛,我們可以通過今天的TripoSG和TripoSF,以及近期VAST的其它動作,窺一斑而知全豹。

這次開源月正式啟幕的第一週,VAST第一發是在3月13日開源了兩個項目:

一個是MV-Adapter,VAST和北航、上海交大聯合出品。

雖於去年12月第一次問世,但3月13日又有新一步的進展,開放了幾何控制下的多視圖生成模型權重。

它是第一個基於適配器的多視圖圖像生成解決方案,可以在不改變原始網絡結構或特徵空間的情況下,增強文生圖模型及其衍生產品。

另一個開源的項目叫MIDI。

它能僅憑單張圖像,創建高保真3D場景,論文已中CVPR 2025。

這一系列開源屬於是既有技術深度,又有覆蓋廣度了。

實際上,作為全球領先的3D生成技術提供方,VAST一直很看重在技術前沿的探索。

單在2024年一年里,就發表了幾十篇新論文;同時積極投身開源社區,此前的開源項目還包括:

世界最大3D生成算法框架threestudio、圖生3D的Wonder3D,和Stable Diffusion背後公司Stability AI一起開源的TripoSR……

憑藉技術上的活躍度,VAST旗下的Tripo系列在全網社交媒體上,也屬於是3D生成領域的當紅炸子雞(doge)。

不僅業餘玩家玩得起勁,也獲得了不少專業藝術工作者的認可,可以說是3D生成版的國產之光了。

對了,關於技術,此前VAST的CTO梁鼎還給量子位分享過他們的總體目標:

第一步是靜態的內容生成,就像生成一個個雕塑。

第二步是動態的內容生成,讓原本靜態的雕塑動起來,和用戶互動。

他還認為,在今年(2025年)年底之前,每個人都可以零門檻、零成本地進行實時3D內容創作。

現在,VAST用開源月,讓每個人朝向這個目標更進一步。

而一系列技術新成果和開源推進之下,VAST也越來越受到關注,正在成為3D大模型賽道最具代表性的明星公司。

有個VC和技術招聘領域的江湖套梗是這樣說的:

語言、圖像和影片之後,3D是AIGC領域的下一個未來……那3D大模型賽道,究竟有誰在啊?

VAST。

【 TripoSG 】

Homepage:https://yg256li.github.io/TripoSG-Page/

論文arXiv:https://arxiv.org/abs/2502.06608

GitHub代碼:https://github.com/VAST-AI-Research/TripoSG

抱抱臉模型權重:https://huggingface.co/VAST-AI/TripoSG

抱抱臉演示:https://huggingface.co/spaces/VAST-AI/TripoSG

【 TripoSF 】

Homepage:https://xianglonghe.github.io/TripoSF/

論文arXiv:https://arxiv.org/abs/2503.21732

GitHub代碼:https://github.com/VAST-AI-Research/TripoSF

抱抱臉模型權重:https://huggingface.co/VAST-AI/TripoSF