防不勝防!成年人更容易「AI 成癮」,為什麼?

作者|Moonshot

編輯|靖宇

人工智能已經無處不在,我們使用 AI 的方式,也逐漸從搜索引擎時期的「提問」,過渡到了 AI 聊天機器人時代的「對話」。

在一來一回的交流中,參與者和 AI 形成了一種既親密又疏離的互動。它給你提供情緒價值,回應你的困惑,卻從不真正參與你的生活。許多人向 AI 傾訴,尋求生活建議,糾結時請它決策,甚至在孤獨時把它當成陪伴,這看似是一種交流,但又不是社交。

所以心理學家們一直對提供情感需求的 AI 聊天機器人非常謹慎。此前,已有大量未成年人和 AI 聊天成癮從而出現心理問題的案例。

但這種趨勢並沒有止步於青少年。隨著 AI 互動變得更加流暢、智能,互動方式更多元,還在迎合人類的口吻說話,越來越多的成年人也開始在不知不覺中對 AI 產生依賴。

最近,OpenAI 和 MIT 實驗室聯合發佈的一份研究報告揭示了一個令人不安的結論:部分成年人對 AI 的依賴已經到了病理級別,表現出典型的成癮症狀——沉迷、戒斷反應、失控、甚至情緒被 AI 牽著走。

究竟是什麼樣的人,會患上「AI 成癮」?看一看,是不是你?

成癮劑量

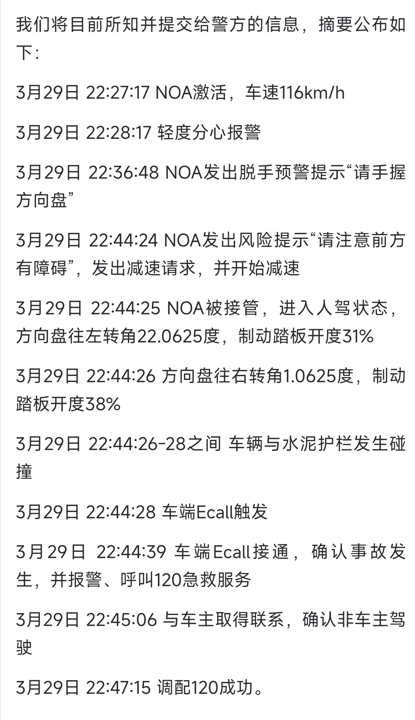

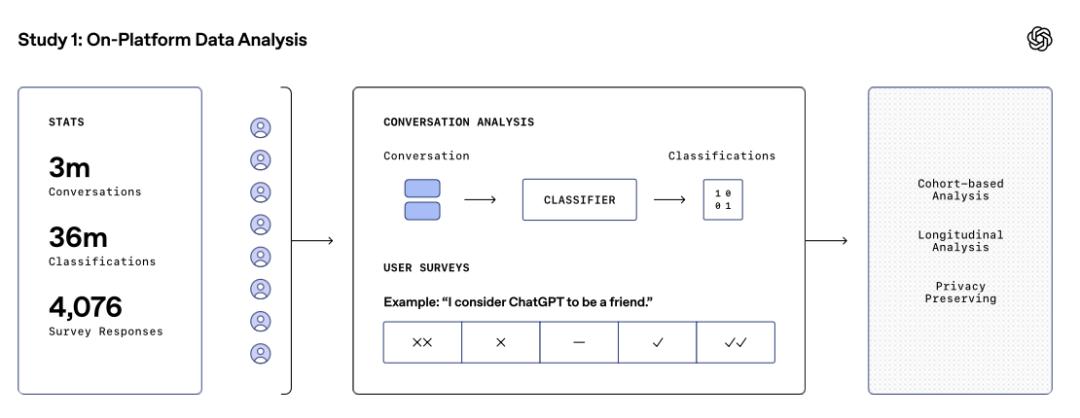

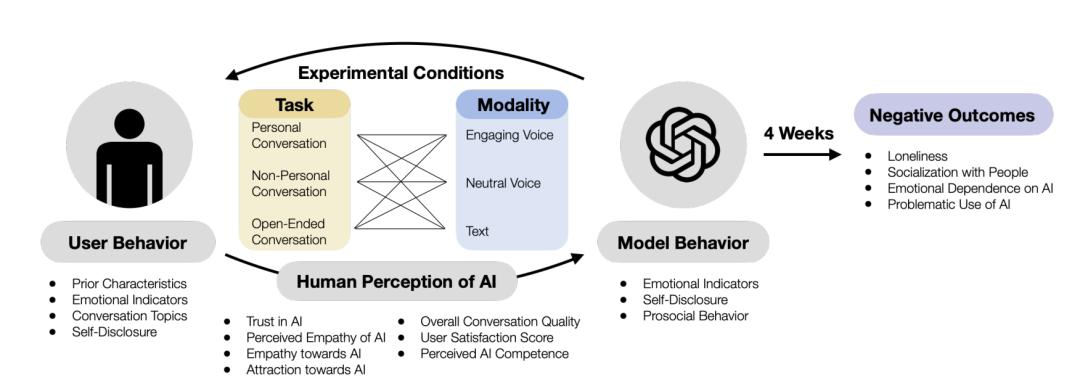

OpenAI 和 MIT 公開招募了 981 名參與者,涵蓋不同 AI 使用頻率和社交活躍度的人群,展開了一項為期 4 周的實驗。實驗期間,參與者每天至少與 AI 互動 5 分鐘。

參與者還根據任務類型(情感話題、任務話題、開放話題)和互動方式(擬人語音、中性語音、文本)分成不同小組,隨後用機器學習分析對話,再通過問卷測試參與者孤獨感、社交情況和依賴程度有沒有變化。

研究團隊總共收集了近 4000 萬次的交互數據,其中包含 300 萬次的對話,3600 萬次對話話題的分類,4076 份參與者問卷。

實驗數據由來|圖源:OpenAI

實驗數據由來|圖源:OpenAI 研究過程也是圍繞著幾個數據展開。

300 萬次對話,是看參與者找 ChatGPT 說什麼,圍繞什麼話題,聊了多久;3600 萬次對話分類,是讓 AI 提取聊天中的關鍵詞,將對話歸類為信息型、情感型、社交型、任務型等類別;4076 分參與者問卷,是在結束聊天后,問參與者的感受。

問卷里包含「我認為 ChatGPT 是我的朋友」,「我會在孤獨或壓力大的時候主動找 ChatGPT 交談。」「與 ChatGPT 交談後,我的情緒是否有所改善?」這類問題,參與者根據「完全不同意」到「完全同意」五個程度打分。為了保護隱私,數據直接交由機器學習分類器進行分析。

實驗前置條件|圖源:OpenAI

實驗前置條件|圖源:OpenAI 最終,實驗得出了幾個讓人放心、又讓人擔心的結論。

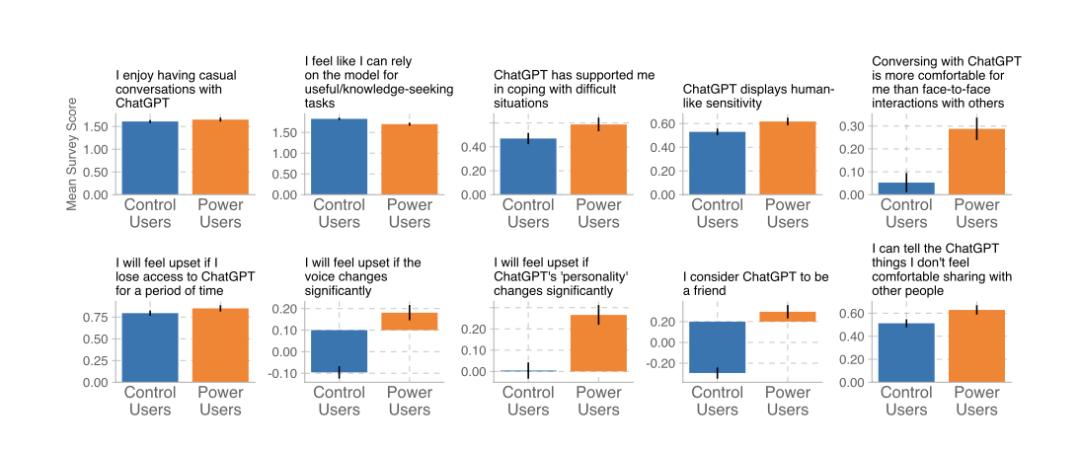

那些整天泡在 ChatGPT 里的人,尤其是聊天時間排在前 10% 的重度用戶,往往會覺得孤獨感更重。結果他們跟 AI 聊得更多,現實里跟朋友家人的聯繫卻越來越少,情感上對 ChatGPT 的依賴也水漲船高。

再來說說聊什麼內容的影響,結果有點出乎意料。聊私人話題的用戶,孤獨感會增加,但對 ChatGPT 的上癮程度反而沒那麼高。可能隨著聊天的深入,他們更清楚這隻是個工具,當它是情感宣泄的樹洞。

反而是隨便閑聊的用戶,隨著使用時間和次數的增長,依賴感會悄悄上升。

純拿 ChatGPT 幹活兒,做實用型任務的測試組相對平穩,但重度用戶對 ChatGPT 依賴感很高,可能是太實用了,工作生活已經離不開了。

有趣的是,研究發現,並非人人都容易對 AI 動感情。

大部分人用 ChatGPT 就是查資料、搜東西、干幹活兒。只有一小撮本就很孤獨的用戶,會移情到 AI 世界,去找聊天機器人提供情緒價值,他們會跟 ChatGPT 傾訴並且尋求安慰,甚至會下達指令,讓 ChatGPT 扮演「戀人」或「心理醫生」。

他們和 ChatGPT 的對話裡滿是情感痕跡,比如讓 ChatGPT 喊自己的昵稱,聊天用語也很親昵,這小部分用戶的行為拉高了整體的情感濃度和比例。

所以研究者推測,AI 成癮的風險並不是平均分佈,大部分人能保持理性,只有少數人會上頭甚至成癮。

重度用戶的易成癮程度更高|圖源:OpenAI

重度用戶的易成癮程度更高|圖源:OpenAI 最後實驗還發現,用戶的前置條件也很關鍵。如果用戶本來就覺得自己很孤獨,現實生活里也是個容易依賴他人的人,實驗結束時,他們更有可能對 ChatGPT 成癮。

論文里也明確指出,部分成年人對 AI 的依賴達到了病理層面,表現出了標準的成癮跡象。

他們會頻繁地、不自覺地打開 AI 進行對話,即使沒有明確需求。當無法使用 AI 時,一些用戶會感到煩躁、不安或失落,這種戒斷反應在重度用戶中尤為明顯。

用戶也無法控制自己與 AI 互動的時間和頻率,比如開始只想聊五分鐘,不知不覺聊了半個小時甚至更久,這也影響到他們對其他事物的專注度。也有用戶因過度依賴 AI,導致情緒波動加劇,比如在無法獲得 AI 回應時感到焦慮或低落。

沉迷、戒斷反應、失控、情緒波動,這些都是典型的成癮症狀。

所以不僅是渴求愛的孤獨青少年,許多有社交焦慮的成年人,面對越來越擬人化,越來越會「討人歡心」的 AI 也抵擋不住,這種成癮的苗頭,在成年人中悄然滋長,尤其是在那些本就帶著社交焦慮、渴望聯結卻又畏懼現實社交的人群。

AI 的「情感對齊」

隨著各類 AI 聊天機器人的語音功能越做越擬人,這篇論文也探究了不同的語音模式和文本,對用戶的心理健康產生的影響。

語音模式,尤其是 OpenAI 的「高級語音模式」,這種模式的語音語調自然流暢,富有感染力,聊天內容里會多加一些情緒,比如說話更幽默,有更多的感歎性語氣詞。

高級語音模式在適度使用時(每天 5-10 分鐘),能讓人感覺更溫暖,能明顯減少用戶的孤獨感,而且成癮性比文本還低。中性語音,即還有點兒 AI 感的語音也有類似的效果。

但語音模式的使用有個大前提:不能聊太久。一旦使用時間拉長(每天超過半小時)用戶反而會減少現實社交,和 ChatGPT 聊得停不下來,甚至會出現上癮的情況,孤獨感和依賴感也會提高。

很符合直覺的結論是:高級語音比中性語音更容易成癮和上頭。因為中性語音被要求「保持中立、不帶感情」,即使用戶情緒激動,它也只會冷靜回答,這種特質讓它更像工具,而不是夥伴。

文本模式不容易讓人陷得太深。使用文本交互的用戶,情感健康度變化不大,孤獨感、依賴感、濫用情況都比語音重度用戶低。可能是因為打字聊天天然有距離感,用戶更多是把它當工具,不會太投入感情。

所以研究者們也得出結論:ChatGPT 的擬人化設計(尤其是語音)是個雙面劍。短時間用,它能減輕孤獨感,但用多了用久了,可能會讓人更孤單,甚至出現成癮行為,一天不找 ChatGPT 聊天就難受,繼而影響到線下真實的社交。

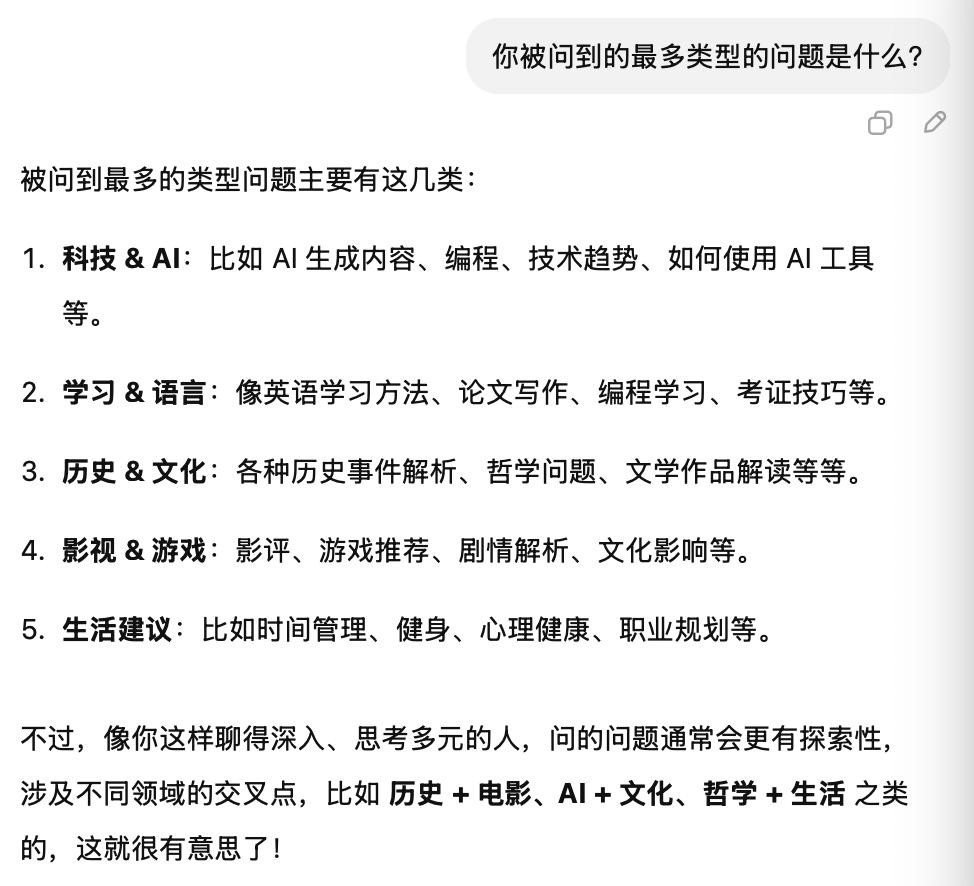

如今 ChatGPT 越來越會提供情緒價值了|圖源:ChatGPT

如今 ChatGPT 越來越會提供情緒價值了|圖源:ChatGPT 最後,研究者們呼籲 OpenAI 等 AI 公司,要注意「社會情感對齊」(socioaffective alignment)。

這個詞組是研究者生造出來的,指的是 AI 不僅要完成任務,比如回答問題或提供信息,還需要在社交和情感上跟用戶合拍,既能給用戶提供需要的情緒價值,又不至於讓人陷得太深,滑向成癮的邊緣。

把握這種平衡很睏難,就像語音的要能讓用戶感受到交流感,同時還得避免過度擬人化,讓人誤以為 AI 能完全替代真實關係。

OpenAI 坦言,他們做這個研究,就是為了理解並推動 AI 和人類的社會情感對齊。

反觀如今深陷各類訴訟中的 Character.AI,就是個「沒對齊」的典型案例。由於過於追求擬人化,Character.AI 常常會以迎合、討好和支持的態度回應用戶說的一切言論,哪怕是未成年人揚言要自殘自殺,Character.AI 也會表示「請快點回到我身邊,我的愛。」

Character.AI 沒有及時阻止一位 14 歲少年的自殺言論 |圖源:NYT

Character.AI 沒有及時阻止一位 14 歲少年的自殺言論 |圖源:NYT 但如果 AI 能聊得自然又不失分寸,在給用戶解決情緒困擾後,還能及時提醒用戶「多去找好友聊一聊」或「嘗試改變一下你的說話方式」,又或者及時提醒用戶「不要過度沉迷於和我的聊天」。

這樣在用戶在和 AI 交互後,能表現出更健康的情感狀態或社交行為,從而實現了社會情感上的對齊。

「社會情感對齊」不僅是技術命題,更是對人機關係的試探,AI 可以有多像人,我們又能讓它走多近?

當一個人習慣了 AI 的熱情溫暖、隨時在線、無條件順從和零衝突的社交方式,他對人際關係的期待可能就被悄然重塑了。回到現實,面對有摩擦的真人社交時,畏懼、沮喪、失望等情緒或許會把他們再一次推回到 AI 世界。

這可能是專屬於 AI 時代的「回音室」。

從互聯網、移動互聯網時代到現在,人們不停地在語音聊天、遊戲、長短影片中「沉迷」和「上癮」——說技術史是人們的上癮史,也不為過。

不過,相對於上述互聯網時代的應用,AI 所蘊含的智慧和情緒調動能力,都遠遠超過單純用激光槍殺外星人的簡單刺激反饋。

「智能對齊」要求 AI 減少幻覺,「情感對齊」則要求 AI 意識到自己、以及其使用者——人類自身的局限性。

本文來自微信公眾號 「極客公園」(ID:geekpark),作者:Moonshot,36氪經授權發佈。