邁向群體智能 | 智源發佈首個跨本體具身大小腦協作框架與開源具身大腦

允中 發自 凹非寺

量子位 | 公眾號 QbitAI

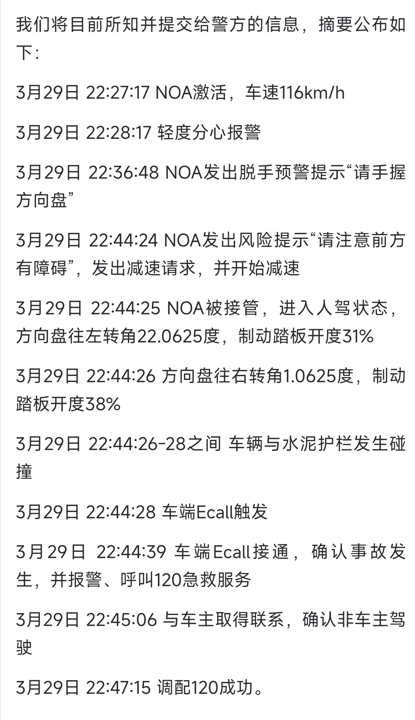

3月29日,智源研究院在2025中關村論壇「未來人工智能先鋒論壇」上發佈首個跨本體具身大小腦協作框架RoboOS與開源具身大腦RoboBrain,可實現跨場景多任務輕量化快速部署與跨本體協作,推動單機智能邁向群體智能,為構建具身智能開源統一生態加速場景應用提供底層技術支持。

具身智能操作框架RoboOS+具身大腦RoboBrain.mp4

△基於RoboOS及RoboBrain的多機器人跨本體協作遞送任務Demo

增強長程操作任務能力,打造感知-認知-決策-行動閉環

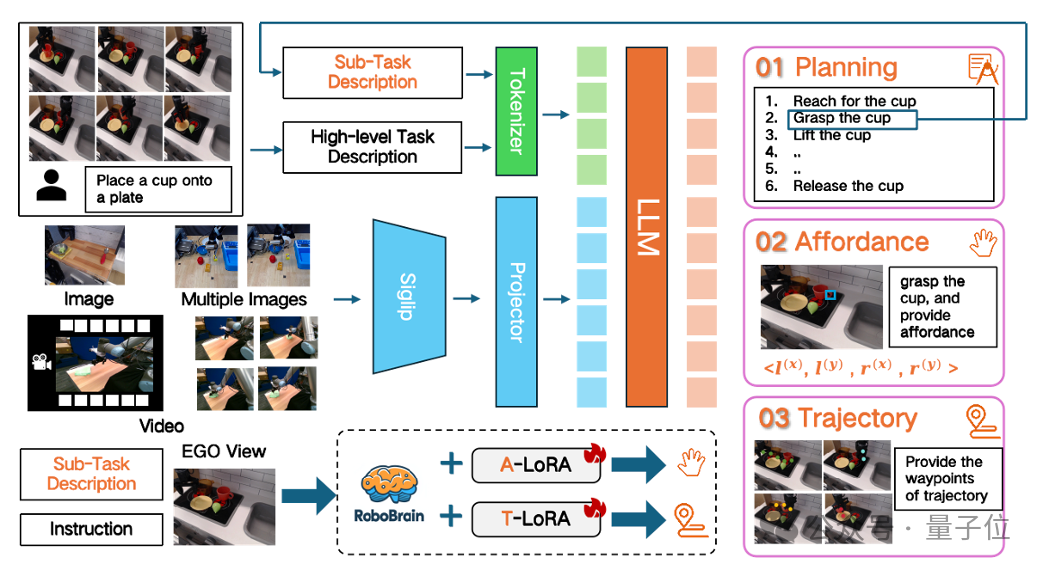

在具身場景中,長程操作任務是機器人執行複雜任務的核心能力之一。具身大腦RoboBrain融合了機器人任務規劃、可操作區域感知、軌跡預測的三維能力,通過將抽像指令映射為具象動作序列,增強長程操作任務的能力。

RoboBrain由三個模塊組成:用於任務規劃的基座模型、用於可操作區域感知的A-LoRA模塊和用於軌跡預測的T-LoRA模塊。在推理時,模型首先感知視覺輸入,並將輸入指令分解為一系列可執行的子任務,然後執行可操作區域感知和軌跡預測。RoboBrain採用多階段訓練策略,使其具備長歷史幀記憶和高解像度圖像感知能力,進而提升場景感知和操作規劃的能力。

RoboBrain 在任務規劃、可操作區域感知和軌跡預測評測任務中均表現出卓越性能。

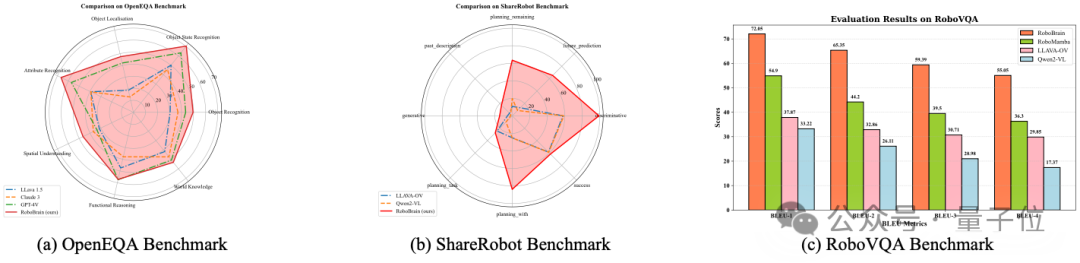

在任務規劃方面,RoboBrain在不犧牲通用能力的前提下,在機器人規劃評測集OpenEQA、ShareRobot(自建)和RoboVQA上多個維度優於GPT-4V、Claude3等6個當時領先的閉源/開源MLLMs。

△RoboBrain在具身規劃評測基準上的性能

△RoboBrain在具身規劃評測基準上的性能

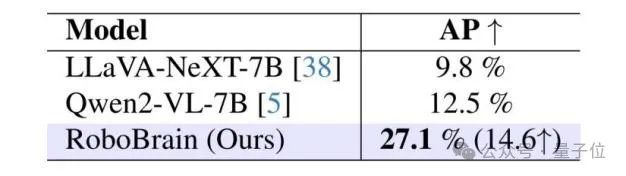

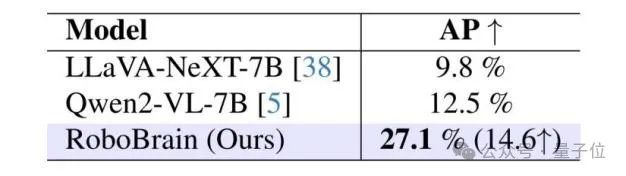

△RoboBrain在可操作區域感知基準上的性能

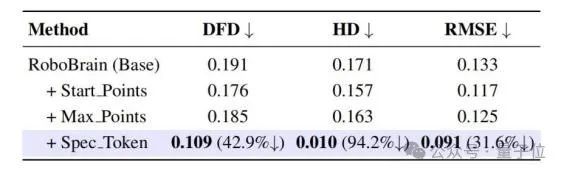

△RoboBrain在可操作區域感知基準上的性能 △RoboBrain在軌跡預測基準上的性能

△RoboBrain在軌跡預測基準上的性能在軌跡預測方面,RoboBrain預測的操作軌跡具有與真實軌跡較高的相似度,展現了其在軌跡預測中的高精度和穩定性。RoboBrain的未來迭代版本會持續提高軌跡預測的能力。

目前,RoboBrain能夠解讀人類指令和視覺圖像,以生成基於實時圖像反饋的行動計劃和評估,預測每一步的軌跡並感知相應的可操作區域。具體而言,RoboBrain 能夠有效利用環境信息和交互對象的狀態——無論是從第一人稱還是第三人稱視角捕捉的圖像——生成針對不同類型機器人操作任務的任務規劃,並基於人類指令和視覺信息,提供合理的可操作區域,並能在不同場景中表現出良好的泛化能力,生成既可行又合理的軌跡。

具身大腦RoboBrain、小腦技能庫以及跨機器人數據中樞,是跨本體框架RoboOS的核心要素。具身大腦RoboBrain,負責全局感知與決策,構建動態時空感知、規劃指導和反饋糾錯機制;小腦技能庫,負責低延遲精準執行,實現柔性與精密操作等;跨機器人數據中樞,負責實時共享空間、時間和本體記憶,為決策規劃與優化協作操作提供信息支持,從而形成感知-認知-決策-行動的閉環。

一腦多機實現跨本體協作,從單體智能邁向群體智能

跨本體具身大小腦協作框架RoboOS,基於「大腦-小腦」分層架構,通過模塊化設計、智能任務管理和跨本體協作,為機器人提供高效、靈活、可擴展的底層支持,實現從單機智能到群體智能的躍遷。

在RoboOS的分層架構下,具身大腦RoboBrain的複雜場景感知與決策能力,可與小腦技能庫的高效執行能力深度結合,確保協作框架在長週期、高動態任務中的穩定運行。實現大腦模型(如LLM/VLM)與小腦技能(如抓取、導航)的「即插即用」,目前,可支持鬆靈雙臂、睿爾曼單/雙臂、智元人形、宇樹人形等不同類型的具身本體。

通過共享記憶系統(空間記憶/時間記憶/本體記憶),實現多個機器人之間的狀態同步與智能協作,突破傳統「信息孤島」限制,實現跨本體協作控制。

RoboOS可動態管理多機器人任務隊列,支持優先級搶佔與資源優化分配,確保複雜場景下實時響應,實現高併發任務調度。

此外,RoboOS可基於執行反饋動態調整策略,結合環境變化,持續優化任務規劃,提升魯棒性,做到實時閉環優化。

在「遞送蘋果和水果刀」的任務場景中,基於RoboOS及RoboBrain,睿爾曼單臂機器人(轉運)、宇樹人形G1(挑揀水果)、鬆靈雙臂機器人(挑揀水果刀)分工協作。

整體任務流程是睿爾曼調用「導航技能」移動至餐桌前,宇樹G1調用「視覺抓取技能」完成指定物體的挑揀,睿爾曼調用「抓取技能」提起果籃並導航至鬆靈餐桌前。緊接著,鬆靈調用「抓取技能」獲取水果刀,並放置在果籃中心,睿爾曼依據「空間記憶」導航至辦公桌位置,遞送果籃後返回待命。

RoboOS接收「拿離杯子最近的水果,並遞送一把水果刀」指令後,遞送RoboBrain進行任務拆解,並將拆解後的子任務分發給3台跨本體機器人。RoboBrain通過 「空間記憶」 感知環境,確定果籃、蘋果位置,並拆解任務為「宇樹G1挑揀蘋果→睿爾曼傳遞果籃→鬆靈機器人抓取水果刀→睿爾曼返回」。

各機器人本體執行子任務過程中,由RoboOS提供端雲協作能力,將任務規劃為技能粒度,實現雲端RoboBrain分發規劃,端側執行技能並實時反饋。RoboBrain識別「離杯子最近的水果位置」、「果籃抓取位置affordance」、「水果刀抓取位置affordance」、「果籃空閑位置Pointing」,經由RoboOS遞送指導各機器人本體完成任務。

「即插即用」快速輕量化泛化部署,打造統一生態

RoboOS 作為面向多機器人系統的跨本體具身大小腦協作框架,專為解決當前具身智能落地過程中的通用性適配與多機調度難題而設計。針對異構本體難以統一接入、任務調度效率低、缺乏動態錯誤反饋機制等痛點,基於RoboOS 的「大小腦協同」的架構範式,雲端的具身大腦 RoboBrain 負責統一的任務理解、規劃決策與上下文感知,本體側則接入輕量級的小腦執行模塊,實現感知-認知-決策-行動的閉環協作。

該機制能夠動態感知本體差異、靈活適配操作指令、自動修復異常行為,有效提升系統在複雜任務場景下的魯棒性與泛化性。RoboOS 原生支持異構機器人本體的靈活接入,以 Profile 模板機制快速完成機器人能力建模與適配。

本體的小腦模塊可調用包括開源技能庫、自研低階控製器等多種技能接口,形成一個支持模塊複用、即插即用的運行體系,大幅降低開發門檻與接入成本。

在雲端,RoboOS 提供完備的模型適配與 API 接入能力,兼容自研的多模態 VLM,作為可插拔的大腦決策引擎,從而在服務機器人、工業自動化、智慧物流、智能製造等領域支撐複雜任務的多機協作需求。

借助 RoboOS 的端雲一體化協同能力與動態調度機制,整個系統不僅具備高度的擴展性與可遷移性,更為未來具身智能的規模部署與生態構建奠定了通用操作系統級的基礎。

RoboOS基於智源研究院研發的並行訓練與推理框架FlagScale,原生支持多機器人系統的端雲協同能力,打造具身智能的統一底座。系統在設計上充分考慮「多機器人-多模態-多任務」場景,具備極高的可擴展性與低時延響應能力。

在端側部署中,機器人註冊即可自動與雲端部署的RoboBrain大腦建立雙向通信鏈路,通過高效發佈-訂閱機制實現實時任務調度與狀態反饋,指令響應延遲低於10ms,滿足複雜動態任務的閉環控制需求。

面向機器人在長期運行中產生的海量感知與行為數據,RoboOS 提供基於內存優化的數據訪問引擎,支持TB級別歷史數據的內存隨機訪問能力,為任務複現、異常回溯、跨任務知識遷移等場景提供基礎能力。結合 RoboBrain 的任務推理與策略優化模塊,歷史數據還可用於多機之間的協作知識共享,實現更強的智能演化與自主學習能力。

此外,FlagScale 作為底層支撐框架,支持大模型在多設備間的並行推理與多任務協同調度,可無縫集成視覺語言模型、軌跡生成模塊、感知識別等子系統,全面釋放具身大模型的系統潛力。

目前,智源研究院依託多模態大模型技術優勢資源,正在聯合北大、清華、中科院等高校院所以及銀河通用、樂聚、加速進化、宇樹等產業鏈上下遊企業,積極建設具身智能創新平台,重點開展數據、模型、場景驗證等研究。

此次智源研究院發佈的跨本體具身大小腦協作框架RoboOS及開源具身大腦RoboBrain,將有機融合和廣泛鏈接不同構型的具身本體與豐富多元的具身模型,加速具身智能跨本體協作與規模化應用。

開放、協作、共享,是具身智能生態繁榮的必經之路,智源研究院願攜手更多產業合作夥伴,共繪具身智能生態藍圖。

開源鏈接:

具身多模態大腦模型RoboBrain

Github: https://github.com/FlagOpen/RoboBrain

Gitee: https://gitee.com/flagopen/robo-brain

Huggingface:https://huggingface.co/BAAI/RoboBrain

為機器人操作任務設計的高質量異構數據集ShareRobot

GitHub:https://github.com/FlagOpen/ShareRobot

Gitee: https://gitee.com/flagopen/share-robot

Huggingface: https://huggingface.co/datasets/BAAI/ShareRobot

*本文系量子位獲授權刊載,觀點僅為原作者所有。

一鍵三連「點讚」「轉發」「小心心」

歡迎在評論區留下你的想法!