卷積網絡又雙叒叕行了?OverLoCK:一種仿生的卷積神經網絡視覺基礎模型

作者是香港大學俞益洲教授與博士生婁蒙。

你是否注意過人類觀察世界的獨特方式?

當面對複雜場景時,我們往往先快速獲得整體印象,再聚焦關鍵細節。這種「縱觀全局 – 聚焦細節(Overview-first-Look-Closely-next)」的雙階段認知機制是人類視覺系統強大的主要原因之一,也被稱為 Top-down Attention。

雖然這種機制在許多視覺任務中得到應用,但是如何利用這種機制來構建強大的 Vision Backbone 卻尚未得到充分研究。

近期,香港大學將這種認知模式引入到了 Vision Backbone 的設計中,從而構建了一種全新的基於動態卷積的視覺基礎模型,稱為 OverLoCK (Overview-first-Look-Closely-next ConvNet with Context-Mixing Dynamic Kernels)。該模型在 ImageNet、COCO、ADE20K 三個極具挑戰性的數據集上展現出了強大的性能。例如,30M 的參數規模的 OverLoCK-Tiny 模型在 ImageNet-1K 達到了 84.2% 的 Top-1 準確率,相比於先前 ConvNet, Transformer 與 Mamba 模型具有明顯的優勢。

-

論文標題:OverLoCK: An Overview-first-Look-Closely-next ConvNet with Context-Mixing Dynamic Kernels

-

論文鏈接:https://arxiv.org/abs/2502.20087

-

代碼鏈接:https://github.com/LMMMEng/OverLoCK

動機

Top-down Attention 機制中的一個關鍵特性是利用大腦獲得的反饋信號作為顯式的信息指導,從而在場景中定位關鍵區域。然而,現有大多數 Vision Backbone 網絡(例如 Swin, ConvNeXt, 和 VMamba)採用的仍然是經典的金字塔架構:從低層到高層逐步編碼特徵,每層的輸入特徵僅依賴於前一層的輸出特徵,導致這些方法缺乏顯式的自上而下的語義指導。因此,開發一種既能實現 Top-down Attention 機制,又具有強大性能的卷積網絡,仍然是一個懸而未決的問題。

通常情況下,Top-down Attention 首先會生成較為粗糙的全局信息作為先驗知識,為了充分利用這種信息,token mixer 應該具備強大動態建模能力。具體而言,token mixer 應當既能形成大感受野來自適應地建立全局依賴關係,又能保持局部歸納偏置以捕捉精細的局部特徵。然而我們發現,現有的卷積方法無法同時滿足這些需求:不同於 Self-attention 和 SSM 能夠在不同輸入解像度下自適應建模長距離依賴,大核卷積和動態卷積由於固定核尺寸的限制,即使面對高解像度輸入時仍局限於有限區域。此外,儘管 Deformable 卷積能在一定程度上緩解這個問題,但其可變的 kernel 形態會犧牲卷積固有的歸納偏置,從而會弱化局部感知能力。因此,如何在保持強歸納偏置的前提下,使純卷積網絡獲得與 Transformer 和 Mamba 相媲美的動態全局建模能力,同樣是亟待解決的關鍵問題。

方法

讓 Vision Backbone 網絡具備人類視覺的「兩步走」機制

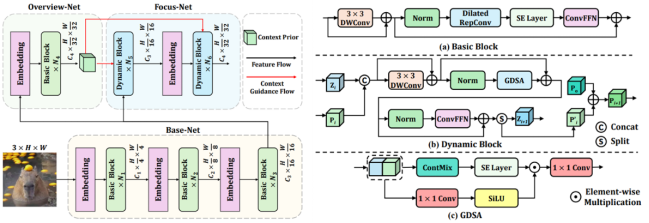

研究團隊從神經科學獲得關鍵啟發:人類視覺皮層通過 Top-down Attention,先形成整體認知再指導細節分析(Overview-first-Look-Closely-next)。據此,研究團隊摒棄了先前 Vision Backbone 網絡中經典的金字塔策略,轉而提出了一種新穎的深度階段分解(DDS, Deep-stage Decomposition) 策略來構建 Vision Backbone 網絡,該機制構建的 Vision Backbone 具有 3 個子模型:

-

Base-Net:聚焦於提取中低層特徵,相當於視覺系統的「視網膜」,利用了 UniRepLKNet 中的 Dilated RepConv Layer 來作為 token mixer,從而實現高效的 low-level 信息感知。

-

Overview-Net:提取較為粗糙的高級語義信息,完成「第一眼認知」。同樣基於 Dilated RepConv Layer 為 token mixer,快速獲得 high-level 語義信息作為 Top-down Guidance。

-

Focus-Net:在全局先驗知識的引導下進行精細分析,實現「凝視觀察」。基於一種全新的動態卷積 ContMix 和一種 Gate 機制來構建基本 block,旨在充分利用 Top-down Guidance 信息。

來自 Overview-Net 的 Top-down Guidance 不僅會在特徵和 kernel 權重兩個層面對 Focus-Net 進行引導,還會沿著前向傳播過程在每個 block 中持續更新。具體而言,Top-down Guidance 會同時參與計算 Gate 和生成動態卷積權重,還會整合到 feature map 中,從而全方位地將 high-level 語義信息注入到 Focus-Net 中,獲得更為魯棒的特徵表示能力。

圖 1 OverLoCK 模型整體框架和基本模塊

圖 1 OverLoCK 模型整體框架和基本模塊 圖 2 ContMix 框架圖

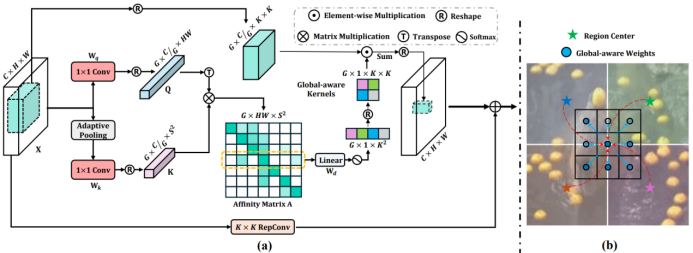

圖 2 ContMix 框架圖具有強大 Context-Mixing 能力的動態卷積 — ContMix

為了能夠更好地適應不同輸入解像度,同時保持強大的歸納偏置,進而充分利用 Overview-Net 提供的 Top-down Guidance,研究團隊提出了一種新的動態卷積模塊 — ContMix。其核心創新在於通過計算特徵圖中每個 token 與多個區域的中心 token 的 affinity map 來表徵該 token 與全局上下文的聯繫,進而以可學習方式將 affinity map 轉換為動態卷積核,並將全局上下文信息注入到卷積核內部的每個權重。當動態卷積核通過滑動窗口作用於特徵圖時,每個 token 都會與全局信息發生調製。簡言之,即便是在局部窗口進行操作,ContMix 仍然具備強大的全局建模能力。實驗中,我們發現將當前輸入的 feature map 作為 query,並將 Top-down Guidance 作為 key 來計算動態卷積核,相較於使用二者級聯得到的特徵生成的 query/key pairs 具有更好的性能。

實驗結果

圖像分類

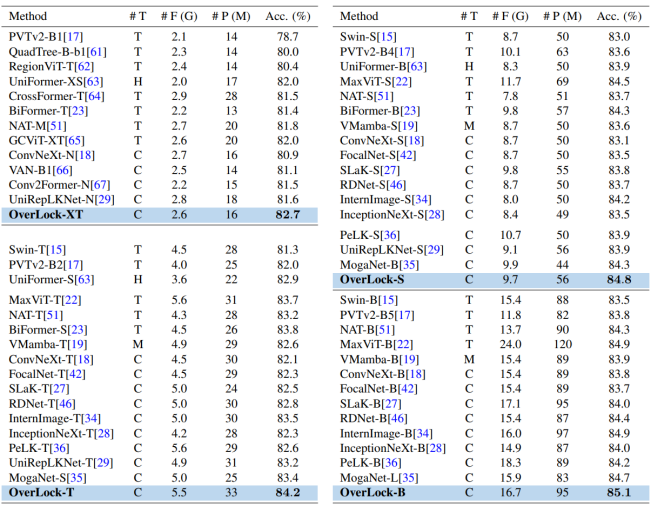

OverLoCK 在大規模數據集 ImageNet-1K 上表現出了卓越的性能,相較於現有方法展現出更為出色的性能以及更加優秀的 tradeoff。例如,OverLoCK 在近似同等參數量的條件下大幅超越了先前的大核卷積網絡 UniRepLKNet。同時,相較於基於 Gate 機制構建的卷積網絡 MogaNet 也具有非常明顯的優勢。

表 1 ImageNet-1K 圖像分類性能比較

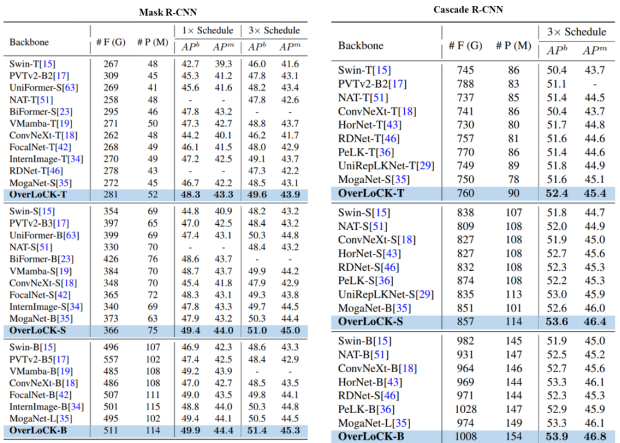

表 1 ImageNet-1K 圖像分類性能比較目標檢測和實例分割

如表 2 所示,在 COCO 2017 數據集上,OverLoCK 同樣展示出了更優的性能。例如,使用 Mask R-CNN (1× Schedule) 為基本框架時,OverLoCK-S 在 APb 指標上相較於 BiFormer-B 和 MogaNet-B 分別提升了 0.8% 和 1.5%。在使用 Cascade Mask R-CNN 時,OverLoCK-S 分別比 PeLK-S 和 UniRepLKNet-S 提升了 1.4% 和 0.6% APb。值得注意的是,儘管基於卷積網絡的方法在圖像分類任務中與 Transformer 類方法表現相當,但在檢測任務上卻存在明顯性能差距。以 MogaNet-B 和 BiFormer-B 為例,兩者在 ImageNet-1K 上都達到 84.3% 的 Top-1 準確率,但在檢測任務中前者性能明顯落後於後者。這一發現有力印證了我們之前的論點 — 卷積網絡固定尺寸的卷積核導致有限感受野,當採用大解像度輸入時可能會性能下降。相比之下,我們提出的 OverLoCK 網絡即使在大解像度場景下也能有效捕捉長距離依賴關係,從而展現出卓越性能。

表 2 目標檢測和實例分割性能比較

表 2 目標檢測和實例分割性能比較 表 3 語義分割性能比較

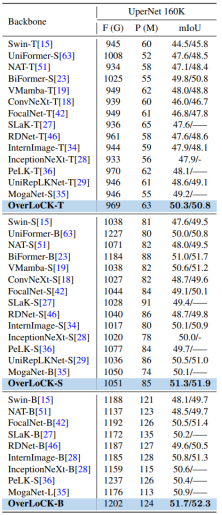

表 3 語義分割性能比較語義分割

如表 3 所示,OverLoCK 在 ADE20K 上也進行了全面的評估,其性能在與一些強大的 Vision Backbone 的比較中脫穎而出,並且有著更優秀的 tradeoff。例如,OverLoCK-T 以 1.1% mIoU 的優勢超越 MogaNet-S,較 UniRepLKNet-T 提升 1.7%。更值得一提的是,即便與強調全局建模能力的 VMamba-T 相比,OverLoCK-T 仍保持 2.3% mIoU 的顯著優勢。

消融研究

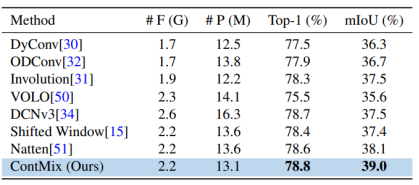

值得注意的是,所提出的 ContMix 是一種即插即用的模塊。因此,我們基於不同的 token mixer 構建了類似的金字塔架構。如表 4 所示,我們的 ContMix 相較於其他 mixer 具有明顯的優勢,這種優勢在更高解像度的語義分割任務上尤為明顯,這主要是因為 ContMix 具有強大的全局建模能力(更多實驗請參見原文)。

表 4 不同 token mixer 的性能比較

表 4 不同 token mixer 的性能比較可視化研究

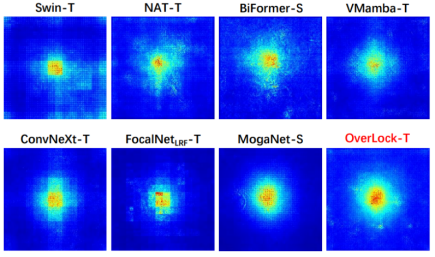

不同 vision backbone 網絡的有效感受野對比:如圖 3 所示,OverLoCK 在具有最大感受野的同時還具備顯著的局部敏感度,這是其他網絡無法兼備的能力。

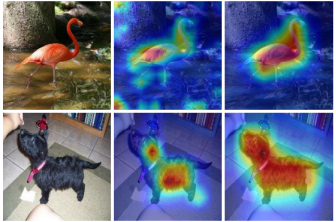

Top-down Guidance 可視化:為了直觀呈現 Top-down Guidance 的效果,我們採用 Grad-CAM 對 OverLoCK 中 Overview-Net 與 Focus-Net 生成的特徵圖進行了對比數析。如圖 4 所示,Overview-Net 首先生成目標物體的粗粒度定位,當該信號作為 Top-down Guidance 注入 Focus-Net 後,目標物體的空間定位和輪廓特徵被顯著精細化。這一現象和人類視覺中 Top-down Attention 機制極為相似,印證了 OverLoCK 的設計合理性。

圖 3 有效感受野比較

圖 3 有效感受野比較 圖 4 Top-down guidance 可視化

圖 4 Top-down guidance 可視化