CVPR 2025 | EmoEdit:情感可編輯?深大VCC帶你見證魔法!

EmoEdit 由深圳大學可視計算研究中心黃惠教授課題組完成,第一作者為楊景媛助理教授。深圳大學可視計算研究中心(VCC)以計算機圖形學、計算機視覺、人機交互、機器學習、具身智能、可視化和可視分析為學科基礎,致力前沿探索與跨學科創新。中心主任黃惠為深圳大學講席教授、計算機學科帶頭人、計算機與軟件學院院長。

-

論文標題:EmoEdit: Evoking Emotions through Image Manipulation

-

論文鏈接:https://arxiv.org/pdf/2405.12661

-

項目主頁:https://vcc.tech/research/2025/EmoEdit

-

項目代碼:https://github.com/JingyuanYY/EmoEdit

你有沒有想過,情感也能被編輯?

當你翻開相冊,看到一張平淡無奇的風景照,是否希望它能更溫暖、更浪漫,甚至更憂鬱?現在,EmoEdit 讓這一切成為可能 —— 只需輸入一個簡單的情感詞,EmoEdit 便能巧妙調整畫面,使觀眾感知你想傳遞的情感。

情感無處不在,我們的每一次觸動,往往源自身邊微小的細節。心理學研究表明,視覺刺激是情感喚起的重要來源之一,而圖像內容則是人類理解視覺信息的關鍵。這便引出一個值得探索的問題:我們能否通過編輯圖像,有效引導觀眾的情感?

圖像情感編輯(Affective Image Manipulation, AIM)具有雙重目標:

-

保持編輯後圖像與原圖的結構一致性;

-

精準且顯著地喚起目標情感。

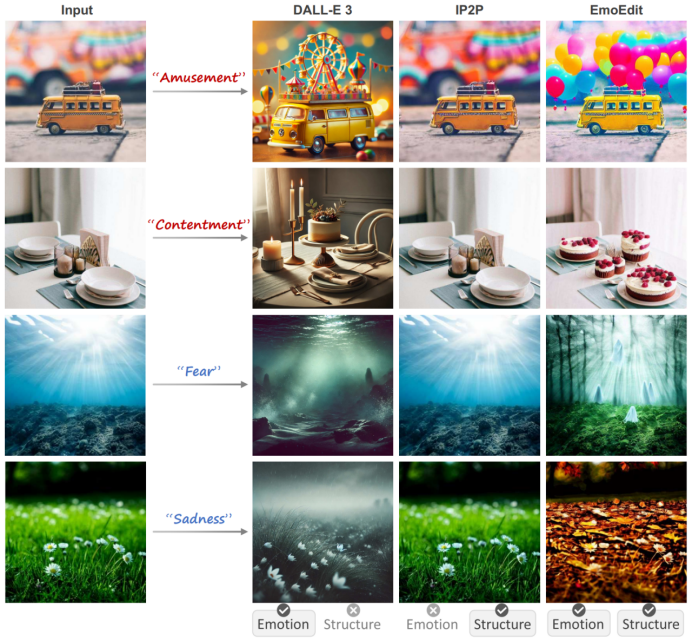

然而,這兩者本質上存在一定衝突,如何權衡成為關鍵挑戰。儘管當前先進的生成模型在圖像編輯任務中表現出強大能力,但難以權衡結構保持和情感喚起(如下圖所示)。現有方法主要依賴顏色調整或風格變化進行情感遷移,但情感表達仍不夠精準和顯著,難以呈現更豐富且生動的情感效果。

為解決上述問題,本文的主要貢獻如下:

-

提出 EmoEdit,一種基於內容感知的 AIM 框架,僅需目標情感類別作為提示詞,即可在任意用戶圖像上實現多樣化的情感編輯;

-

構建首個大規模 AIM 數據集 EmoEditSet,涵蓋 40,120 組圖像對,提供高質量、語義豐富的情感編輯基準,推動視覺情感研究;

-

設計即插即用的情感增強模塊 Emotion Adapter,通過融合 EmoEditSet 的情感知識,有效提升擴散模型的情感感知能力。

EmoEditSet 的構建

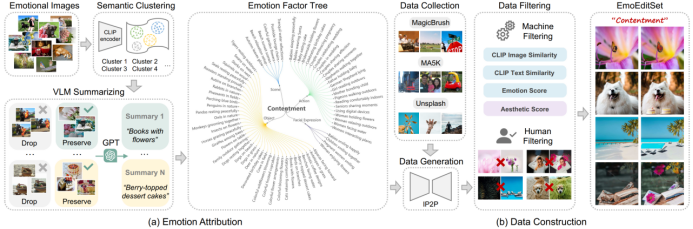

鑒於 EmoSet 現有標籤的局限性,我們在 CLIP 空間中對情感圖片進行聚類,並利用 GPT-4V 總結各類的共性語義,構建情感因素樹。其中,每個葉節點因素均能有效激髮根節點的目標情感。

同時,我們從 MagicBrush、MA5K 和 Unsplash 等多個來源收集源圖像,並利用 IP2P 和情感因素樹生成目標圖像。此外,考慮到 GPT-4V 與擴散模型在知識表達上的差異,我們合併語義相近的視覺因素,並剔除內容過於抽像的因素,以提升數據集的整體質量。

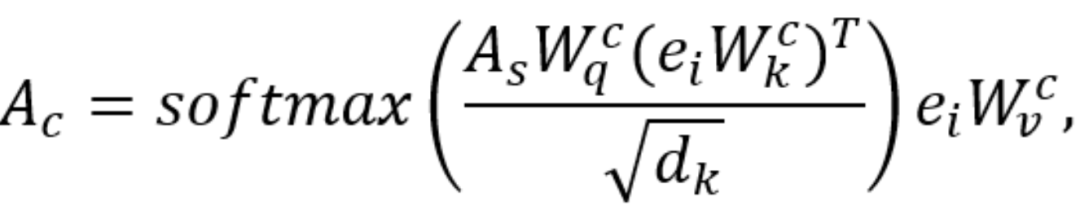

Emotion Adapter 的設計

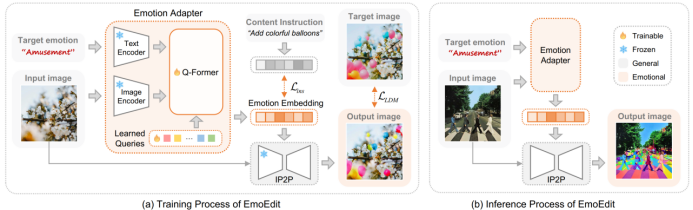

微調雖能增強模型的情感知識,但成本高、泛化性差,且易導致災難性遺忘。Q-Former 可利用一種模態的上下文優化對另一模態的理解。基於此,我們設計 Emotion Adapter,以提高情感感知能力。

Emotion Adapter 結合情感詞典,目標情感和輸入圖像,旨在生成最合適的情感嵌入。

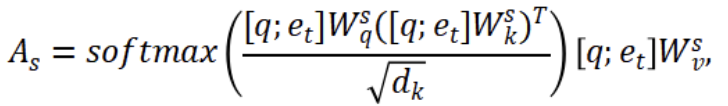

在訓練過程中,我們通過擴散損失和指令損失共同優化網絡:

其中,擴散損失側重於像素級相似性,而指令損失則有助於更好地平衡語義準確性。

實驗結果

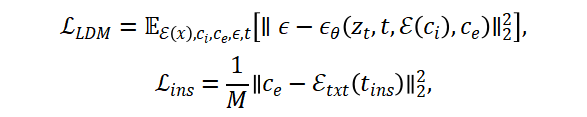

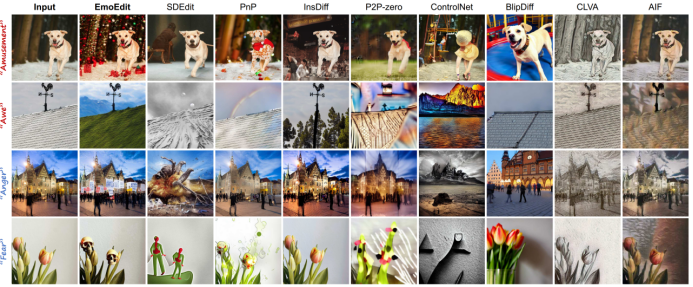

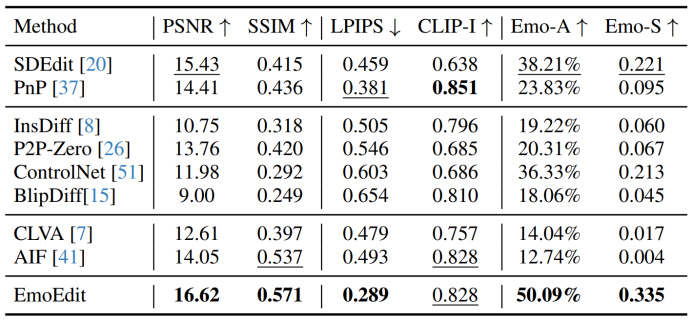

在對比實驗中,我們從全局編輯、局部編輯和情感遷移三個維度選擇了對比方法。與其他方法相比,EmoEdit 編輯後的圖像不僅有效保留了原始構圖特徵,還能顯著傳達目標情感,凸顯了其在平衡圖像結構與情感表達方面的優勢。

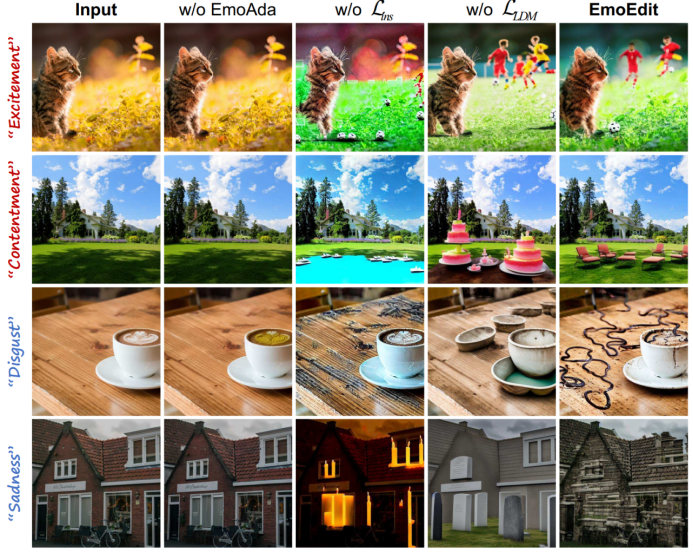

在消融實驗中,缺少 Emotion Adapter(w/o EmoAda)時,圖像幾乎相同。擴散損失有效保留了原始結構,而指令損失則提高了語義清晰度。例如,在 「滿足」 情感下,EmoEdit 增加了「躺椅」,展現了結構完整性、語義清晰度和上下文契合度。

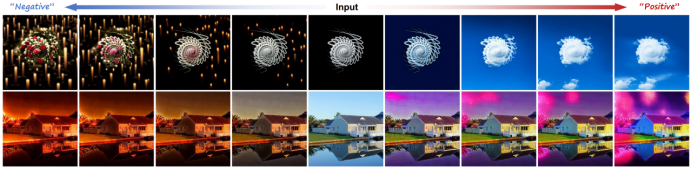

我們觀察到,隨著圖像引導係數的降低,情感強度增加,而結構保持程度減少。儘管情感喚起和結構保持通常存在矛盾,EmoEdit 仍能有效平衡二者。用戶可以根據需求和偏好調整引導係數,定製圖像編輯效果,從而滿足多樣化的編輯需求。

在定量評估中,我們採用涵蓋像素、語義和情感三個層面的六項指標。結果表明,EmoEdit 在大多數指標上優於對比方法,進一步驗證了其在圖像情感編輯任務中的卓越性能。

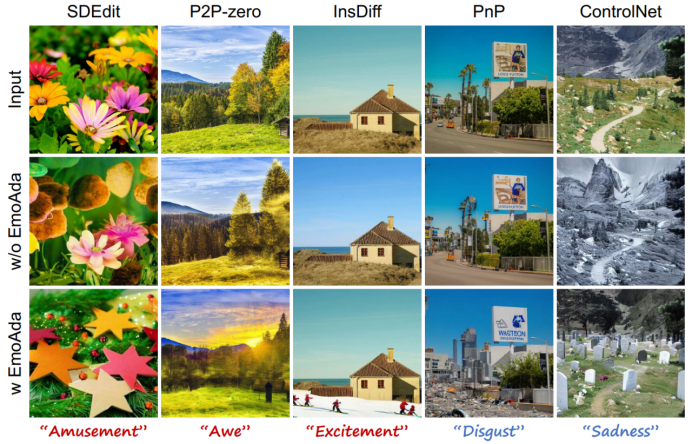

Emotion Adapter 可顯著增強其他模型的情感表達能力。例如,在 ControlNet 中,插入 Emotion Adapter 之前,模型僅能將輸入圖像轉換為黑白;引入後,則能生成包含「墓碑」等情感相關元素的圖像,大幅提升情感保真度和上下文契合度。這進一步驗證了 Emotion Adapter 在增強情感表達方面的有效性。

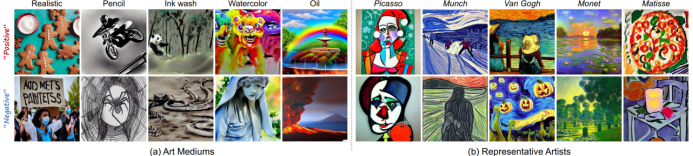

Emotion Adapter 不僅適用於圖像編輯,還可拓展至風格圖像生成。通過一次訓練,它即可將情感極性(積極、消極)編碼為準確、多元的語義表示。例如,在 「莫奈」風格生成的圖像中,「日落」喚起「敬畏」(積極),而「墓地」則傳遞 「悲傷」(消極),充分展現了其在風格圖像生成任務中的魯棒性。

總結與展望

莎士比亞曾言:The emotion expressed by wordless simplicity is the most abundant.

「至簡無言處,情深自豐盈」

近年來,我們課題組先後提出了情感計算領域的 Emo 系列研究工作:

-

EmoSet(ICCV 2023):首個具有豐富屬性標註的大規模視覺情感數據集;

-

EmoGen(CVPR 2024):首個針對圖像情感內容生成的研究;

-

EmoEdit(CVPR 2025):首個聚焦於圖像情感內容編輯的研究。

我們希望通過這一系列探索,為情感計算(Affective Computing)與生成式人工智能(AIGC)的交叉領域貢獻新的思路與方法。未來,我們將持續深耕這一領域,也期待更多誌同道合的朋友加入,共同探索「情感」這片藍海!