李開複:零一萬物正基於 DeepSeek,打造 AI 2.0 時代的 Windows

3 月 30 日下午消息,在 2025 中關村論壇年會上,零一萬物 CEO、創新工場董事長李開複表示,「大模型的推理成本正在以每年降低十倍的速度快速下降,這為 AI-First 應用爆發提供了非常重要的條件。」

「兩年前模型性能不夠好的模型,現在已經夠好了;兩年前推理成本太貴的模型,現在已經是‘白菜價’了。」李開複認為,「AI-First 應用很快將井噴,2025 年將會是 AI-First 應用爆發、大模型‘落地為王’的元年。」

他指出,因為模型訓練所用的數據量已經觸及瓶頸,以及算力方面也存在著客觀製約因素,預訓練階段的 Scaling Law 正在放緩。好在行業內已經出現了新的曙光,Scaling Law(規模定律)正從預訓練階段轉向推理階段,也就是慢思考模式。過去,預訓練階段的 Scaling Law 指的是 —— 有更多的 GPU、更多的數據,模型就可以變得更聰明,但目前其增長趨勢放緩了。而新的慢思考 Scaling Law 是 —— 模型思考的時間更長,就會得出更優質的結果。

「目前看來,慢思考 Scaling Law 下,模型性能的成長速度非常快,而且還有很大的增長空間。」李開複表示,「結合這些新的技術創新,現在模型訓練的過程變得更像是先訓練一個‘文科生’,讓模型閱讀所有書籍,然後再向‘理科生’方向訓練,讓模型能夠證明數學題、會寫代碼,最終得到厲害的‘文理雙全’模型。」

在李開複看來,隨著現在企業和用戶已經經過「DeepSeek Moment」的市場教育,中國市場真正覺醒了,這也為中國 AI-First 應用的爆發掃清了一大障礙。今年人工智能的一個焦點問題應該是:Make AI Work,讓大模型真正賦能千行百業。

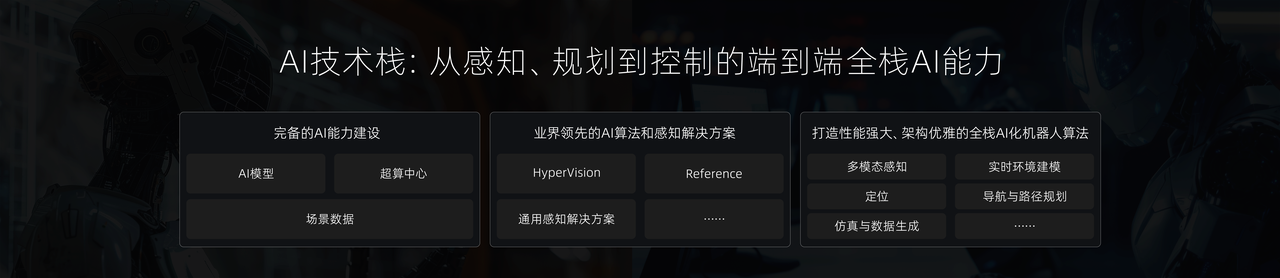

據他介紹,鑒於 DeepSeek 落地到企業生產力場景中仍存在許多需要克服的卡點困難。零一萬物在過去幾個月做了戰略調整,已經全面擁抱 DeepSeek,並且把大部分力量用於把 DeepSeek 優質基座模型轉變為企業級 DeepSeek 部署定製解決方案 —— 可以類比為零一萬物在打造 AI 2.0 時代的 Windows 系統,而 DeepSeek 就是驅動 Windows 的內核。

廣告聲明:文內含有的對外跳轉鏈接(包括不限於超鏈接、二維碼、口令等形式),用於傳遞更多信息,節省甄選時間,結果僅供參考,IT之家所有文章均包含本聲明。