視覺SSL終於追上了CLIP!Yann LeCun、謝賽寧等新作,逆轉VQA任務固有認知

機器之心報導

編輯:蛋醬、杜偉

擴展無語言的視覺表徵學習。

在視覺問題解答(VQA)等多模態環境中,當前視覺自監督學習(SSL)的表現還比不上語言圖像預訓練(CLIP)。這種差距通常歸因於語言監督引入的語義,儘管視覺 SSL 模型和 CLIP 模型通常在不同的數據上進行訓練。

在最近的一項研究中,Yann LeCun、謝賽寧等研究者探討了一個基本問題: 語言監督對於多模態建模的視覺表徵預訓練是否必要?

-

論文標題:Scaling Language-Free Visual Representation Learning

-

論文鏈接:https://arxiv.org/pdf/2504.01017

-

項目地址:https://davidfan.io/webssl/

「我們的目的不是要取代語言監督方法,而是要瞭解視覺自監督在多模態應用中的內在能力和局限性。為了進行公平的比較,我們在與最先進的 CLIP 模型相同的數十億規模的網絡數據(特別是 MetaCLIP 數據集)上訓練 SSL 模型。在比較視覺 SSL 和 CLIP 時,這種方法可以控制數據的分佈差異。」研究者表示。

論文共同一作 David Fan 表示,「視覺 SSL 終於可以在 VQA 任務上與 CLIP 匹敵了,即使在 OCR & Chart VQA 上也非常具有競爭力。我們的全新 Web-SSL 模型系列證明了這一點,並且僅僅基於網絡圖像訓練,沒有進行任何語言監督。」

在評估方面,研究者主要使用視覺問題解答(VQA)作為框架,大規模評估 SSL 模型的各種能力。具體來說,採用了 Cambrian-1 中提出的評估套件,跨越 4 個不同 VQA 類別的 16 項任務的性能: 通用、知識、OCR & 圖表以及 Vision-Centric。

然後,他們使用上述設置訓練了 Web-SSL,這是一個視覺 SSL 模型系列,參數範圍從 10 億到 70 億不等,以便與 CLIP 進行直接和可控的比較。

通過實證研究,研究者提出了一些見解:

-

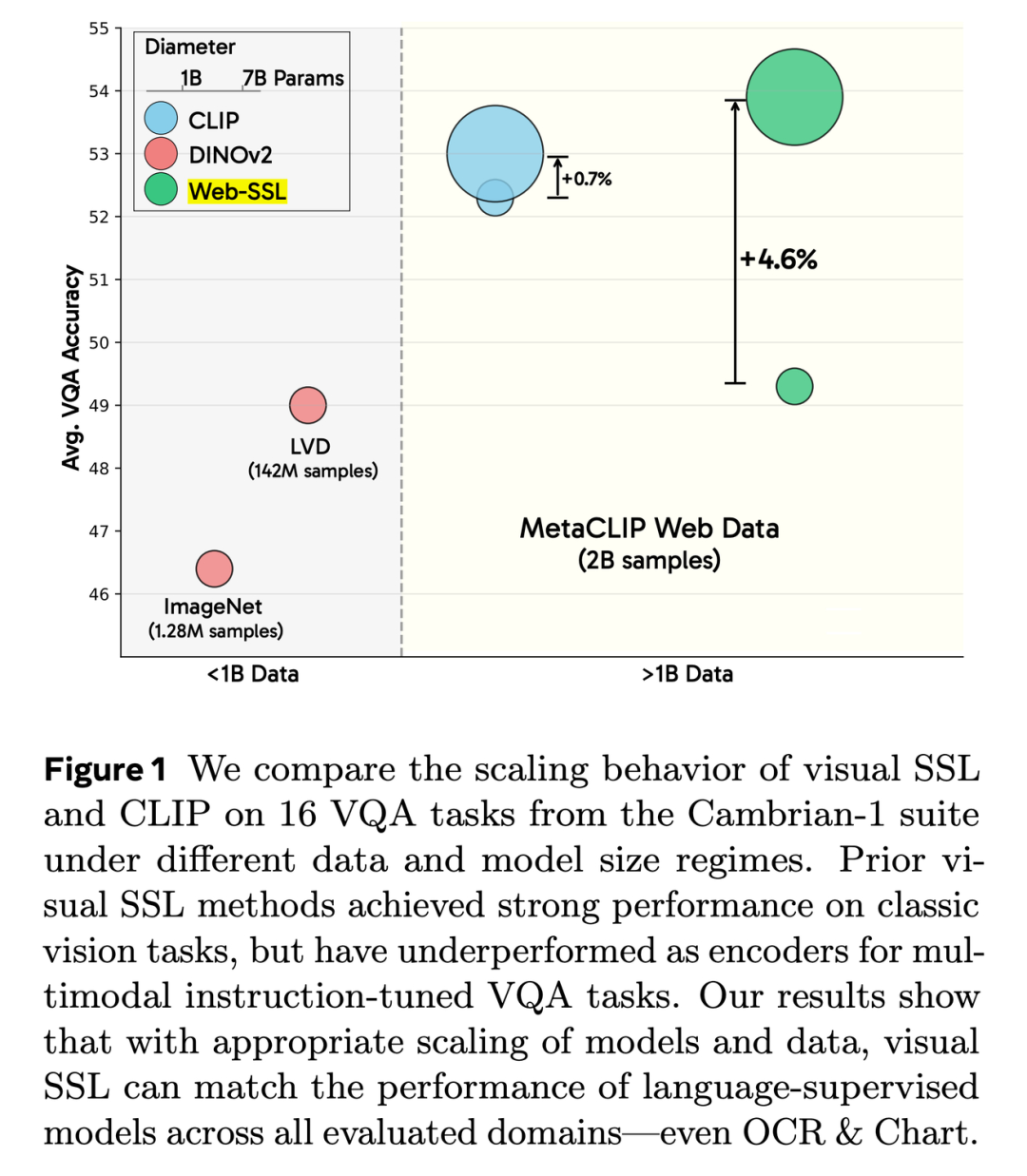

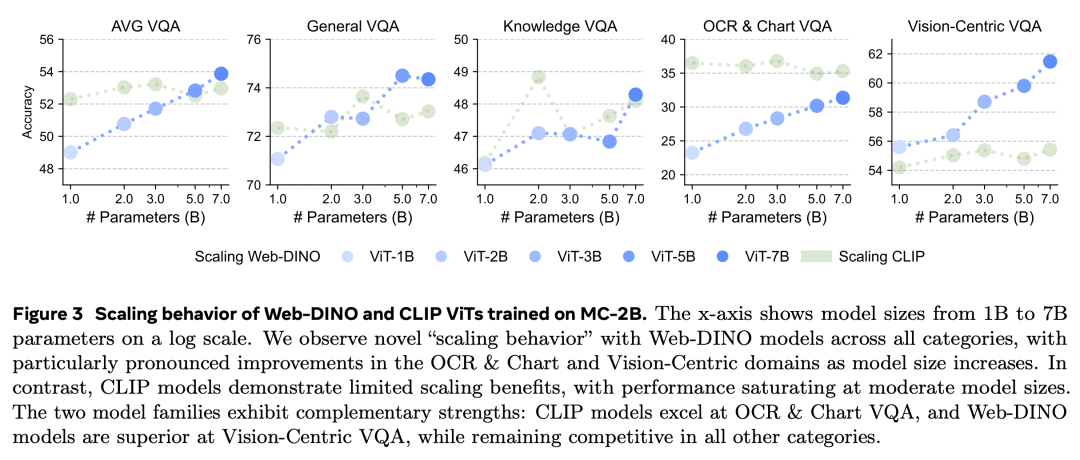

視覺 SSL 可以在廣泛的 VQA 任務中,甚至在 OCR & 圖表理解等語言相關任務中,匹配甚至超越語言監督的視覺預訓練方法(圖 3);

-

視覺 SSL 在模型容量(圖 3)和數據(圖 4)方面都有很好的擴展性,這表明 SSL 還有巨大的潛力有待挖掘;

-

視覺 SSL 可以在分類和分割方面保持傳統視覺性能的競爭力,同時在 VQA 方面也有所改進(圖 7);

-

對包含文本的圖像進行更高比例的訓練對於提高 OCR 和圖表性能尤為有效(問題 4)。探索數據構成是一個很有前景的方向。

隨後,研究者介紹了本文的實驗設置,它通過以下方式擴展了之前的 SSL 工作:

(1)將數據集規模擴展到十億級圖像(第 2.1 節);

(2)將模型規模擴展到 1B 參數以上(第 2.2 節);

(3)除了 ImageNet-1k 和 ADE20k 等經典視覺基準之外,還使用開放式 VQA 任務(第 2.3 節)評估視覺模型。

擴展 Visual SSL

研究者也探討了視覺 SSL 模型在模型和數據大小方面的擴展行為,這是僅對 MC-2B 圖像進行訓練的結果。這一部分重點討論 DINOv2 作為視覺 SSL 方法,下一部分會重點討論 MAE。

-

擴展模型大小:研究者將模型大小從 1B 增加到 7B,同時將訓練數據固定為 20 億張 MC2B 圖像。他們對每種方法都使用了現成的訓練代碼和配方,為了控制混雜變量,沒有因模型規模不同而改變配方。

-

擴展所見樣本:研究者將重點轉移到對固定模型大小的總數據進行縮放,並分析當訓練過程中看到的圖像數量從 10 億增加到 80 億時,性能是如何變化的。

擴展模型大小

研究者使用來自 MC-2B 的 20 億張 224×224 解像度的未標記圖像,並且沒有進行高解像度適應,對 DINOv2 ViT 模型進行了預訓練,參數範圍從 1B 到 7B,以確保與 CLIP 的公平比較。他們使用 VQA 來評估每個模型,結果如下圖 3 所示,包含了整體性能趨勢和特定類別性能。

研究者表示,這是僅使用視覺自監督訓練的視覺 encoder 第一次在 VQA 上取得與語言監督 encoder 相當的性能,即使是傳統上被認為高度依賴文本的 OCR 和 Chart 類別也是如此。

關於性能變化趨勢,圖 3 還比較了模型容量增延長的性能趨勢。WebDINO’s Average、DINOOCR & Chart 和 Vision-Centric VQA 的性能隨著模型大小的增加幾乎呈現對數線性提升,而通用(General)和知識(Knowledge)的提升程度較小。

相比之下,CLIP 在所有 VQA 類別中的表現在 3B 參數後基本飽和。這表明了,雖然較小規模的 CLIP 模型可以更高效地利用數據,但較大規模的 CLIP 模型基本喪失了這一優勢。

Web-DINO 模型增加帶來的持續性能提升表明了,視覺 SSL 會從更大規模的模型中受益,並且繼續將視覺 SSL 擴展到 7B 以上是一個有潛力的方向。

關於特定類別的性能,隨著模型大小的增加,DINO 在 Vision-Centric VQA 上的表現越來越優於 CLIP,在 OCR & Chart 和 Average VQA 上與 CLIP 的差距也大大縮小。

擴展所見樣本

研究者探究了訓練 Web-DINO ViT-7B 過程中增加所見樣本的數量對性能變化有哪些影響,並將來自 MC-2B 中的圖像數量從 1B 增加到 8B。

隨著所見樣本的增加,General 和 Knowledge VQA 的性能逐漸提升,並分別在 4B 和 2B 樣本時達到飽和。Vision-Centric VQA 的性能在樣本從 1B 增加到 2B 過程中急劇提升,並在 2B 以上達到飽和。相比之下,OCR & Chart 是唯一一個隨著所見樣本增加而持續改進的類別。

這表明了,隨著模型所見樣本的增加,它會學習到一種越來越適合文本任務的表徵,而其他能力不會明顯下降。

總的來說,上圖 3 和圖 4 的結果表明,隨著模型大小和樣本的增加,視覺 SSL 學習到的特徵對於 VQA 越來越有效,尤其是在 OCR & Chart 類別。並且,基於 CLIP 的模型相較於視覺 SSL 沒有絕對的優勢。

Web-SSL 模型系列

研究者使用 VQA 和經典視覺基準分析了整體性能最佳的視覺編碼器。表 3 展示了視覺編碼器在 VQA 和經典視覺任務方面與近期現成的視覺編碼器相比所取得的最佳結果。

在 VQA 和傳統視覺任務中,Web-DINO 的表現都優於現成的 MetaCLIP。在 VQA 上,Web-DINO 的性能甚至可以與 SigLIP 和 SigLIP2 相媲美,儘管它看到的數據少了 5 倍,而且沒有語言監督。總體而言,Web-DINO 在傳統視覺基準測試中的表現優於所有現成的語言監督 CLIP 模型。

在所有 VQA 類別中,Web-DINO 也優於現成的視覺 SSL 方法,包括 DINOv2。在傳統的視覺基準測試中,Web-DINO 也具有很強的競爭力。

從 224 解像度到 378 解像度再到 518 解像度,Web-DINO 在平均 VQA 上穩步提升,在 OCR 和圖表性能方面也有顯著提高。傳統視覺性能隨著解像度的提高而略有提高。在 384 解像度下,Web-DINO 落後於 SigLIP。在 518 解像度下,Web-DINO 在很大程度上彌補了這一差距。結果表明,Web-DINO 可從進一步提高高解像度適應性中獲益。

更多研究細節,可參考原論文。