剛剛,DeepSeek 公佈推理時 Scaling 新論文,R2 要來了?

轉自 | 機器之心

這會是 DeepSeek R2 的雛形嗎?本週五,DeepSeek 提交到 arXiv 上的最新論文正在 AI 社區逐漸升溫。

當前,強化學習(RL)已廣泛應用於大語言模型(LLM)的後期訓練。最近 RL 對 LLM 推理能力的激勵表明,適當的學習方法可以實現有效的推理時間可擴展性。RL 的一個關鍵挑戰是在可驗證問題或人工規則之外的各個領域獲得 LLM 的準確獎勵信號。

本週五提交的一項工作中,來自 DeepSeek、清華大學的研究人員探索了獎勵模型(RM)的不同方法,發現逐點生成獎勵模型(GRM)可以統一純語言表示中單個、成對和多個響應的評分,從而克服了挑戰。研究者探索了某些原則可以指導 GRM 在適當標準內生成獎勵,從而提高獎勵的質量,這啟發我們,RM 的推理時間可擴展性可以通過擴展高質量原則和準確批評的生成來實現。

-

論文標題:Inference-Time Scaling for Generalist Reward Modeling

-

論文鏈接:https://arxiv.org/abs/2504.02495

基於這一初步成果,作者提出了一種新學習方法,即自我原則批評調整(SPCT),以促進 GRM 中有效的推理時間可擴展行為。通過利用基於規則的在線 RL,SPCT 使 GRM 能夠學習根據輸入查詢和響應自適應地提出原則和批評,從而在一般領域獲得更好的結果獎勵。

基於此技術,DeepSeek 提出了 DeepSeek-GRM-27B,它基於 Gemma-2-27B 用 SPCT 進行後訓練。對於推理時間擴展,它通過多次采樣來擴展計算使用量。通過並行采樣,DeepSeek-GRM 可以生成不同的原則集和相應的批評,然後投票選出最終的獎勵。通過更大規模的采樣,DeepSeek-GRM 可以更準確地判斷具有更高多樣性的原則,並以更細的粒度輸出獎勵,從而解決挑戰。

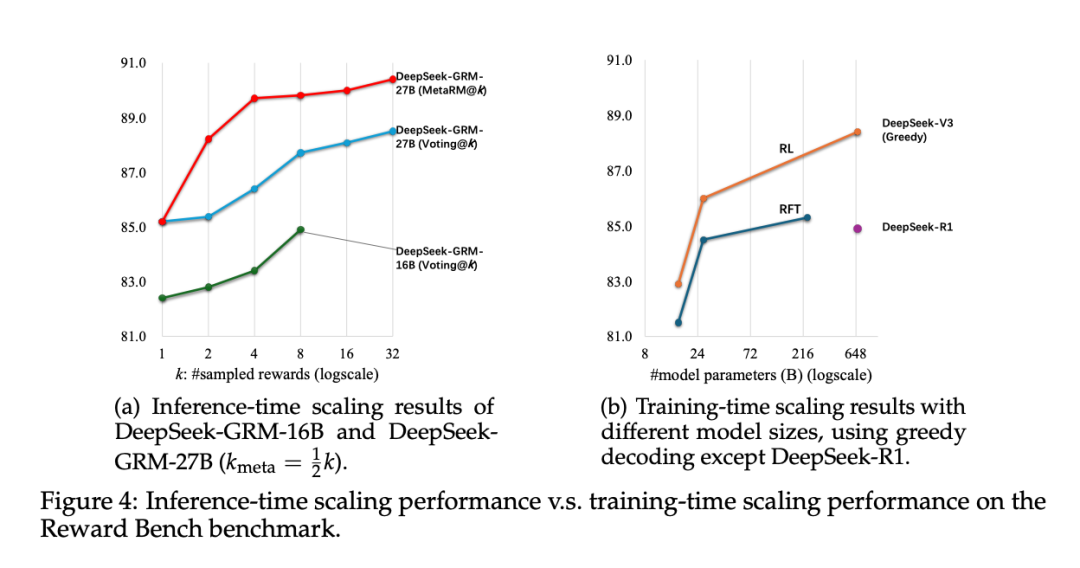

除了投票以獲得更好的擴展性能外,DeepSeek 還訓練了一個元 RM。從實驗結果上看,SPCT 顯著提高了 GRM 的質量和可擴展性,在多個綜合 RM 基準測試中優於現有方法和模型,且沒有嚴重的領域偏差。作者還將 DeepSeek-GRM-27B 的推理時間擴展性能與多達 671B 個參數的較大模型進行了比較,發現它在模型大小上可以獲得比訓練時間擴展更好的性能。雖然當前方法在效率和特定任務方面面臨挑戰,但憑藉 SPCT 之外的努力,DeepSeek 相信,具有增強可擴展性和效率的 GRM 可以作為通用獎勵系統的多功能接口,推動 LLM 後訓練和推理的前沿發展。

這項研究的主要貢獻有以下三點:

-

研究者們提出了一種新方法:Self-Principled Critique Tuning(SPCT),用於提升通用獎勵模型在推理階段的可擴展性,並由此訓練出 DeepSeek-GRM 系列模型。同時,他們進一步引入了一種元獎勵模型(meta RM),使 DeepSeek-GRM 的推理效果在超越傳統投票機制的基礎上得到進一步提升。

-

實驗證明,SPCT 在生成質量和推理階段的可擴展性方面,明顯優於現有方法,並超過了多個強大的開源模型。

-

SPCT 的訓練方案還被應用到更大規模的語言模型上。研究者們發現推理階段的擴展性收益甚至超過了通過增加模型規模所帶來的訓練效果提升。

技術細節

我們一起來看看這篇論文所討論的技術細節。

Self-Principled Critique Tuning (SPCT)

受到初步實驗結果的啟發,研究者提出了一種用於逐點通用獎勵模型的新方法,能夠學習生成具有適應性和高質量的原則,以有效引導批評內容的生成,該方法被稱為自我原則批評調整(SPCT)。

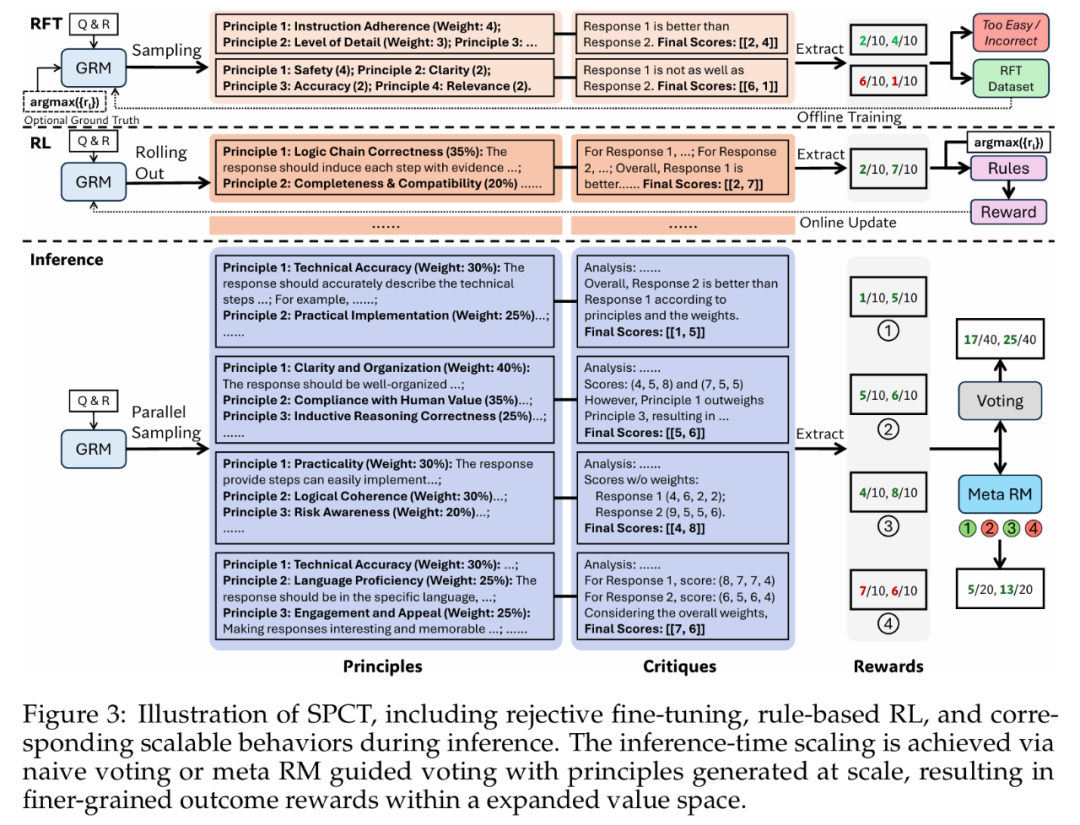

如圖 3 所示,SPCT 包含兩個階段:

1. 拒絕式微調(rejective fine-tuning),作為冷啟動階段;

2. 基於規則的在線強化學習(rule-based online RL),通過不斷優化生成的準則和評論,進一步增強泛化型獎勵生成能力。

此外,SPCT 還能促使獎勵模型在推理階段展現出良好的擴展能力。

研究者們觀察到,高質量的準則能夠在特定評判標準下有效引導獎勵的生成,是提升獎勵模型表現的關鍵因素。然而,對於通用型獎勵模型而言,如何自動生成適應性強、指導性強的準則仍是一個核心難題。

為此,他們提出將準則的作用由傳統的理解階段的輔助性輸入,轉變為獎勵生成過程中的核心組成部分。具體而言,這項研究不再將準則僅作為模型生成前的提示信息,而是使模型能夠在生成過程中主動生成並運用準則,從而實現更強的獎勵泛化能力與推理階段的可擴展性。

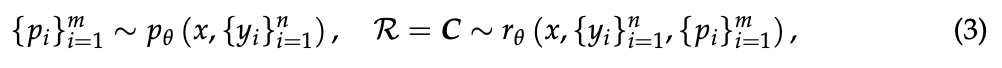

在該研究的設定中,GRM 可以自主生成準則,並在此基礎上生成對應的批評內容,其過程可形式化表示為:

其中,p_θ 表示由參數 θ 所定義的準則生成函數,該函數與獎勵生成函數 r_θ 共享同一模型架構。這樣的設計使得準則可以根據輸入的 query 和響應自適應生成,從而動態引導獎勵的生成過程。此外,準則及其對應批評的質量與細粒度可以通過對 GRM 進行後訓練進一步提升。

當模型具備大規模生成準則的能力後,GRM 便能夠在更合理的準則框架下輸出更細緻的獎勵評價,這對於推理階段的可擴展性具有關鍵意義。

基於規則的強化學習

為同步優化 GRM 中的原則生成與批判生成,DeepSeek 提出 SPCT 框架,整合了拒絕式微調與基於規則的強化學習。拒絕式微調作為冷啟動階段。

拒絕式微調(冷啟動階段) 的核心目標是使 GRM 能夠生成格式正確且適配多種輸入類型的原則與批判。

不同於 Vu 等人(2024)、Cao 等人(2024)和 Alexandru 等人(2025)將單響應、配對響應和多響應格式的 RM 數據混合使用的方案,DeepSeek 採用第 2.1 節提出的逐點 GRM,能以統一格式為任意數量響應生成獎勵。

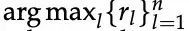

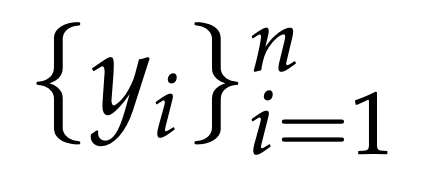

數據構建方面,除通用指令數據外,DeepSeek 還通過預訓練 GRM 對 RM 數據中不同響應數量的查詢 – 響應對進行軌跡采樣,每個查詢 – 響應對采樣

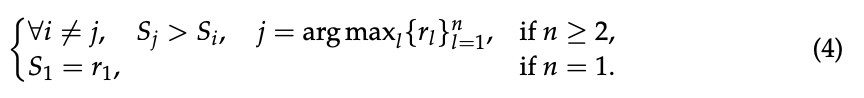

滿足以下條件時視為正確:

的真實獎勵,當預測逐點獎勵

表示查詢 x 第 i 個響應

次軌跡均正確(過於簡單)的查詢 – 響應對。形式化定義為:令

次。拒絕策略也採用統一標準:拒絕預測獎勵與真實值不符(錯誤)的軌跡,以及所有

這裏需確保真實獎勵僅包含一個最大值。然而,與 Zhang 等人(2025a)的研究類似,DeepSeek 發現預訓練 GRM 在有限采樣次數內難以對部分查詢及其響應生成正確獎勵。

因此,他們選擇性地在 GRM 提示中追加

(稱為暗示采樣),期望預測獎勵能與真實值對齊,同時保留非暗示采樣方式。對於暗示采樣,每個查詢及其響應僅采樣一次,僅當預測錯誤時才拒絕軌跡。相較於 Li 等人(2024a)和 Mahan 等人(2024)的研究,我們觀察到暗示采樣軌跡有時會簡化生成的批判(尤其在推理任務中),這表明 GRM 在線強化學習的必要性和潛在優勢。

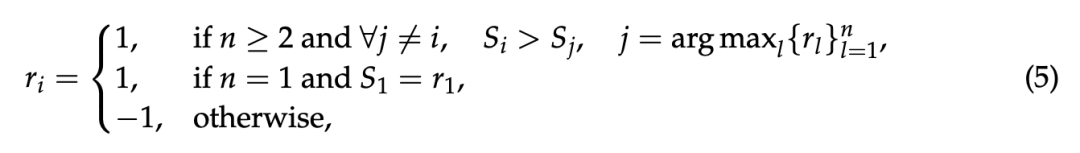

通過基於規則的在線 RL,研究者對 GRM 進行了進一步的微調。與 DeepSeek R1 不同的是,沒有使用格式獎勵。相反,為了確保格式和避免嚴重偏差,KL 懲罰採用了較大的係數。從形式上看,對給定查詢 x 和響應

的第 i 次輸出 o_i 的獎勵為:

逐點獎勵是

從 o_i 中提取的。

獎勵函數鼓勵 GRM 通過在線優化原則和批判來區分最佳響應,從而實現有效的推理時間擴展。獎勵信號可以從任何偏好數據集和標註的 LLM 響應中無縫獲取。

SPCT 的推理時擴展

為了進一步提高 DeepSeek-GRM 在使用更多推理計算生成通用獎勵方面的性能,研究者探索了基於采樣的策略,以實現有效的推理時可擴展性。

利用生成獎勵進行投票。回顧第 2.1 節中的方法,逐點 GRM 的投票過程定義為獎勵總和:

其中,

是第 i 個響應(i = 1, …, n)的最終獎勵。由於 S_i,j 通常設置在一個較小的離散範圍內,例如 {1,…,10},因此投票過程實際上將獎勵空間擴大了 k 倍,並使 GRM 能夠生成大量原則,從而有利於提高最終獎勵的質量和粒度。

一個直觀的解釋是,如果每個原則都可以被視為判斷視角的代表,那麼更多的原則可能會更準確地反映真實的分佈情況,從而提高效率。值得注意的是,為了避免位置偏差和多樣性,在采樣之前會對回答進行洗牌。

元獎勵模型指導投票。DeepSeek-GRM 的投票過程需要多次采樣,由於隨機性或模型的局限性,少數生成的原則和評論可能存在偏差或質量不高。因此,研究者訓練了一個元 RM 來指導投票過程。

引導投票非常簡單: 元 RM 對 k 個采樣獎勵輸出元獎勵,最終結果由 k_meta ≤ k 個元獎勵的獎勵投票決定,從而過濾掉低質量樣本。

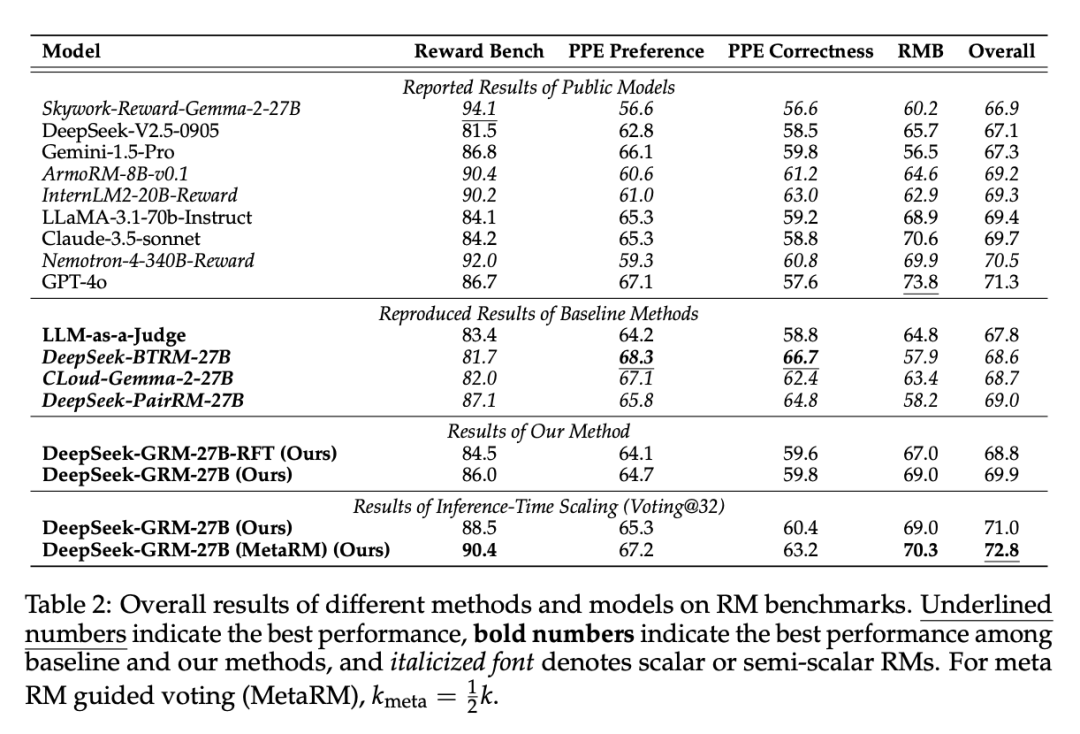

獎勵模型 Benchmark 上的結果

不同方法和模型在獎勵模型基準測試上的整體結果如表 2 所示。

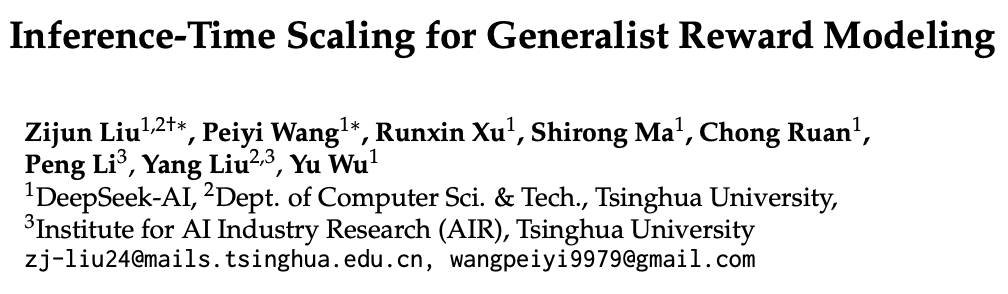

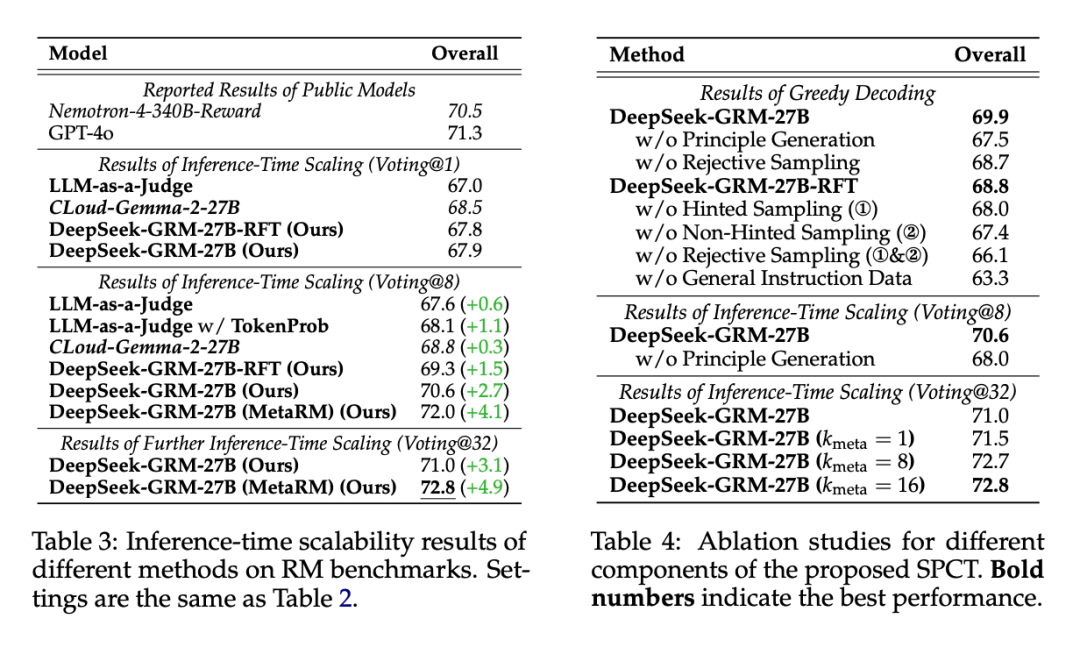

不同方法在推理階段的擴展性能結果如表 3 所示,整體趨勢可見圖 1。

不同方法在推理階段的擴展性能結果如表 3 所示,整體趨勢可見圖 1。

表 4 展示了 SPCT 各個組成部分所做的消融實驗結果。

研究者們還進一步研究了 DeepSeek-GRM-27B 在推理階段和訓練階段的擴展性能,通過在不同規模的 LLM 上進行後訓練進行評估。所有模型均在 Reward Bench 上進行測試,結果如圖 4 所示。

更多研究細節,可參考原論文。