Llama 4 發佈:我看到了 DeepSeek 的影子

Llama 4 發佈了。

https://huggingface.co/meta-llama

Llama 4 的三款模型

但這次,它沒有高調宣稱參數量「遙遙領先「,而是通過三款模型來重新佈局:

-

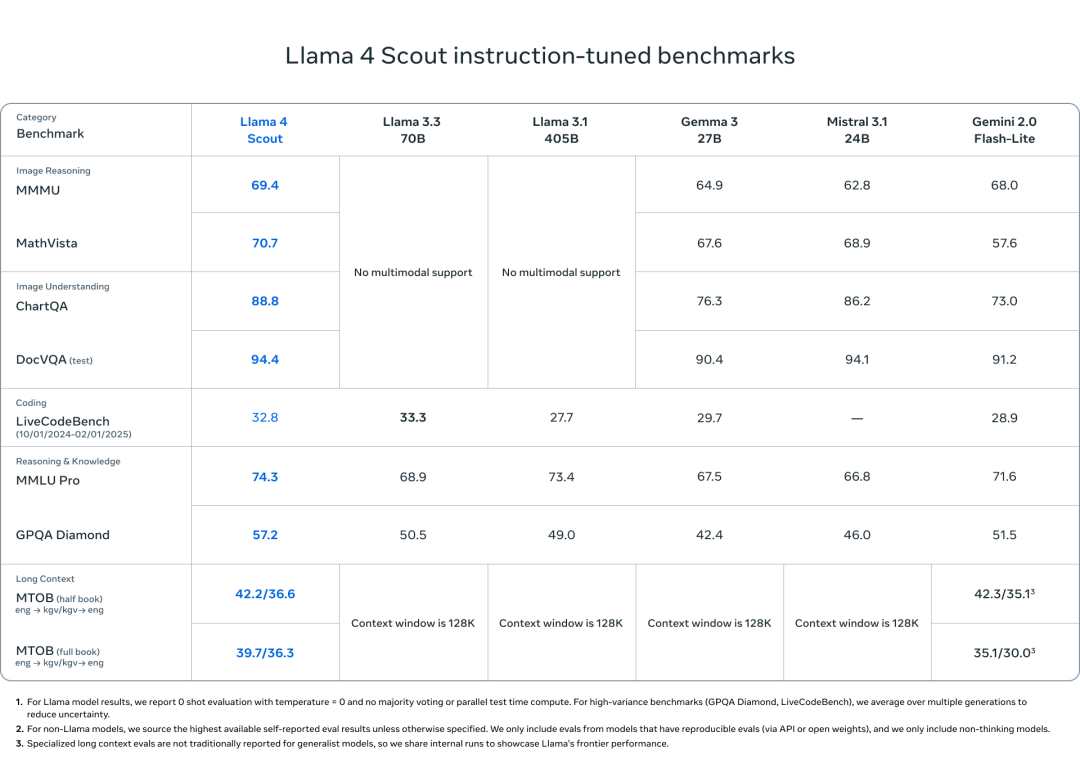

• Scout:109B 參數,17B 激活,16 專家 MoE,可部署在單張 H100 上,10M token 長上下文,適用於文檔分析、多輪對話、代碼等任務

-

• Maverick:400B 參數,17B 激活,128 專家 MoE,1M token 長上下文:400B 參數,128 專家,推理僅激活兩個。對標 GPT-4o,性能不遜色,推理成本僅為其十分之一

-

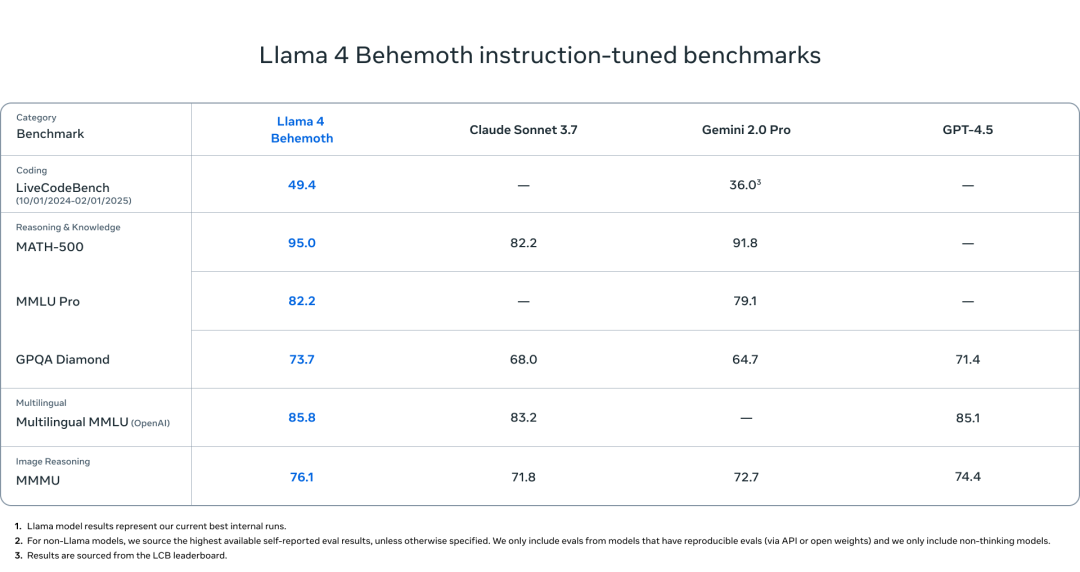

• Behemoth:2T 參數,288B激活,16 專家 MoE,不部署、不開放,僅用於訓練階段,為 Scout 和 Maverick 生成訓練數據

一個用、一主力、一教學,不卷彼此,也不試圖通吃所有任務。

講道理,看這個發佈的時候,我總隱隱有當時讀 DeepSeek V3 技術報告的感覺:擁抱 MoE,擁抱合成數據

架構轉向:MoE 登上主舞台

Lllma 3 是 Dense,哪怕 400B 的模型都是 Dense;而 Llama 4 是 MoE 架構。

MoE 大概就是這樣

MoE 大概就是這樣過去,MoE 更多還是「實驗室選項」,自 DeepSeek 大火後,很多廠商開始嘗試將其用於主力模型,比如這次的 Meta。在 Llama 4 中,模型 Scout 配置 16 專家,而 Maverick 則是 128 專家,推理時都只激活兩個,17B的量。

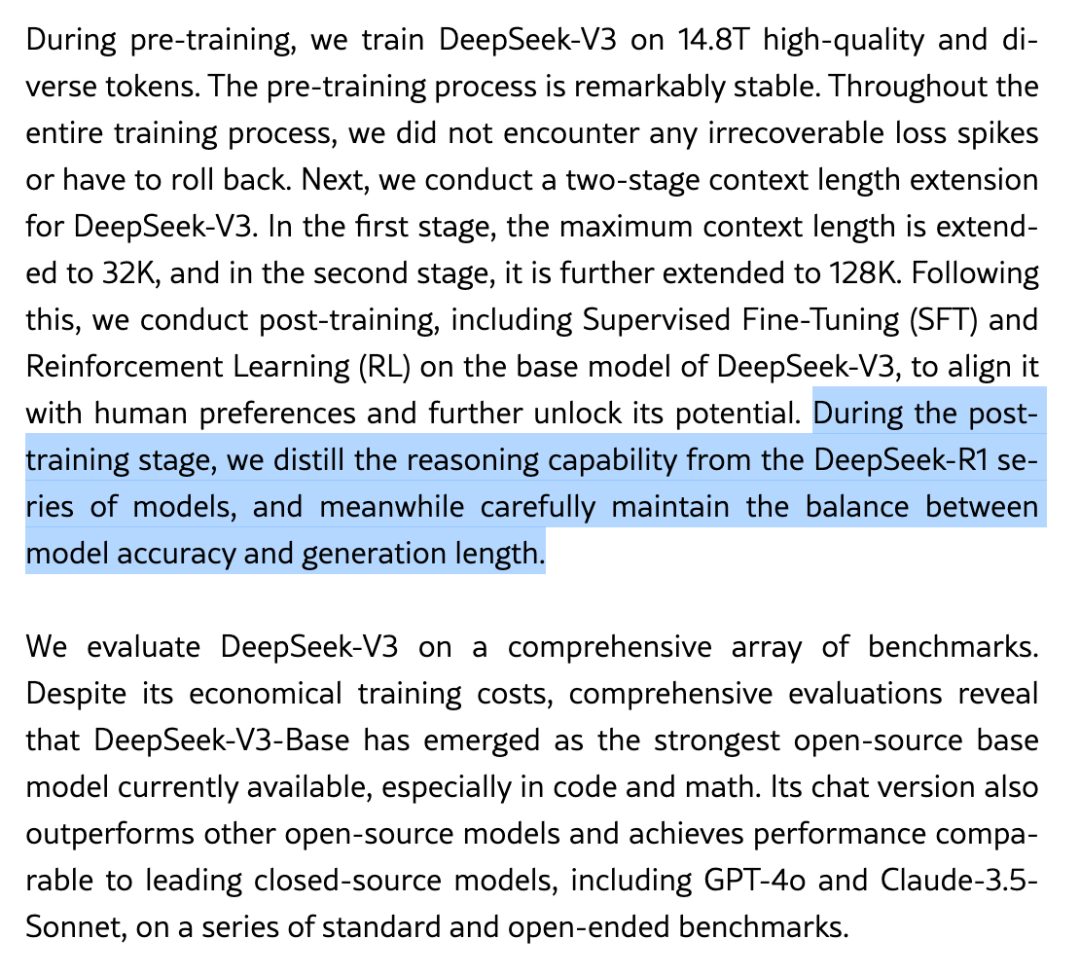

回顧一下,DeepSeek 在 R1 和 V3 中也是類似:671B 總參數,37B 激活,用更可控的計算開銷,換來模型能力密度的提升。

當然,得說一下,MoE 並不適合所有任務場景,也存在調度複雜、專家平衡等訓練難題。但它至少打開了一個現實維度:參數使用方式,和參數數量本身一樣值得被設計。

多模態:從外掛走向原生

Llama 3 時代,圖像輸入依賴外掛 encoder,與語言模型拚接;Llama 4 時代,圖像直接作為 token 輸入,參與語言上下文建模。

這意味著:圖文不是模型之後拚出來的,而是在訓練中就一體建模的語境單位。

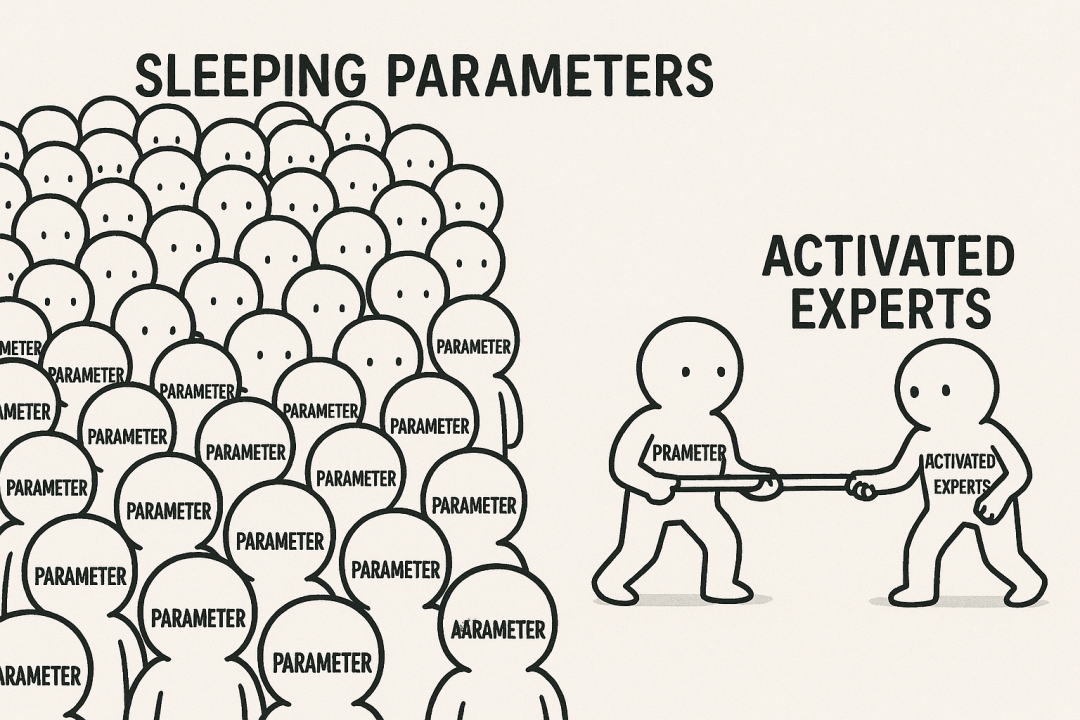

這種結構帶來的提升,在任務表現中非常直接:

-

• Maverick 在 DocVQA 拿下 94.4,超過 GPT-4o(92.8)

-

• ChartQA 達到 90.0,MathVista 73.7,均高於 GPT-4o

-

• 推理成本卻僅為 GPT-4o 的十分之一

Maverick 跑分成績

Maverick 跑分成績而原生多模態架構也體現在 Scout 身上——雖然是輕量模型,但在 DocVQA、ChartQA 上,Scout 依然打出了高於同尺寸模型(甚至部分大模型)的穩定表現。

Scout 跑分成績

Scout 跑分成績此處說一下, DeepSeek 的 V3/R1 仍未引入圖像 token

訓練轉向:大模型是過程

Behemoth 最大號的 Llama4,很強,但它不對外。

Behemoth:這是個不對外的模型

Behemoth:這是個不對外的模型Behemoth的全部作用,是生成訓練數據,為 Scout 和 Maverick 提供能力示範,並通過輕量 DPO 和 RLHF 進一步優化行為。換句話說,Meta 並不再執著於「最強模型」上線,而是選擇把最大資源投入到訓練系統本身。

這個事情,有點像:

-

• OpenAI 開發了「草莓」,來訓練新的 GPT

-

• DeppSeek 開發了 DeepSeek-R1-Light 來訓練 DeepSeek V3

《DeepSeek-V3 Technical Report》

《DeepSeek-V3 Technical Report》不是封神,而是轉向

在我看來,Llama 4 並沒有帶來參數最大、能力最強的單點突破。但它用一個更完整、更分工明確的體系,回應了模型設計正在發生的變化:

Scout 是部署,Maverick 是交付,Behemoth 是理解力的源頭

與其說是一次產品發佈,更像是宣告一次路線調整。