Llama 4訓練作弊爆出驚天醜聞!AI大佬憤而辭職,代碼實測崩盤全網炸鍋

新智元報導

編輯:編輯部 NXY

【新智元導讀】Llama 4本該是AI圈的焦點,卻成了大型翻車現場。開源首日,全網實測代碼能力崩盤。更讓人震驚的是,模型訓練測試集被曝作弊,內部員工直接請辭。

Meta前腳剛發Llama 4,後腳就有大佬請辭了!

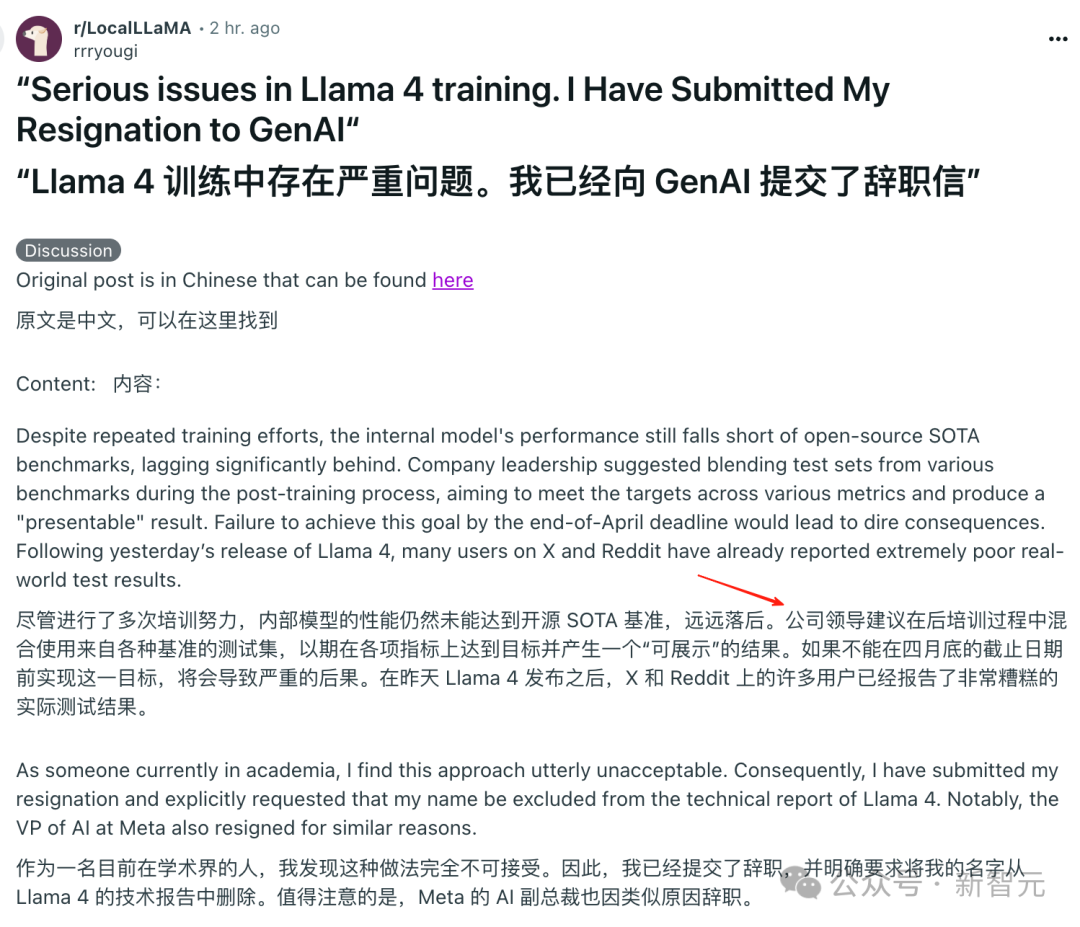

一畝三分地的爆料貼稱,經過反復訓練後,Llama 4未能取得SOTA,甚至與頂尖大模型實力懸殊。

為了矇混過關,高層甚至建議:

在後訓練階段中,將多個benchmark測試集混入訓練數據。

最終目的,讓模型短期提升指標,拿出來可以看起來不錯的結果。

這位內部員工@dliudliu表示,「自己根本無法接受這種做法,甚至辭職信中明確要求——不要在Llama 4技術報告中掛名」。

另一方面,小紮給全員下了「死令」——4月底是Llama 4交付最後期限。

在一系列高壓之下,已有高管提出了辭職。

網民Flavio Adamo使用相同的提示詞,分別讓Llama 4 Maveric和GPT-4o製作一個旋轉多邊形的動畫。

可以看出,Llama 4 Maveric生成的多邊形並不規則而且沒有開口。小球也不符合物理規律,直接穿過多邊形掉下去了。

相比之下GPT-4o製作的動畫雖然也不完美,但至少要好得多。

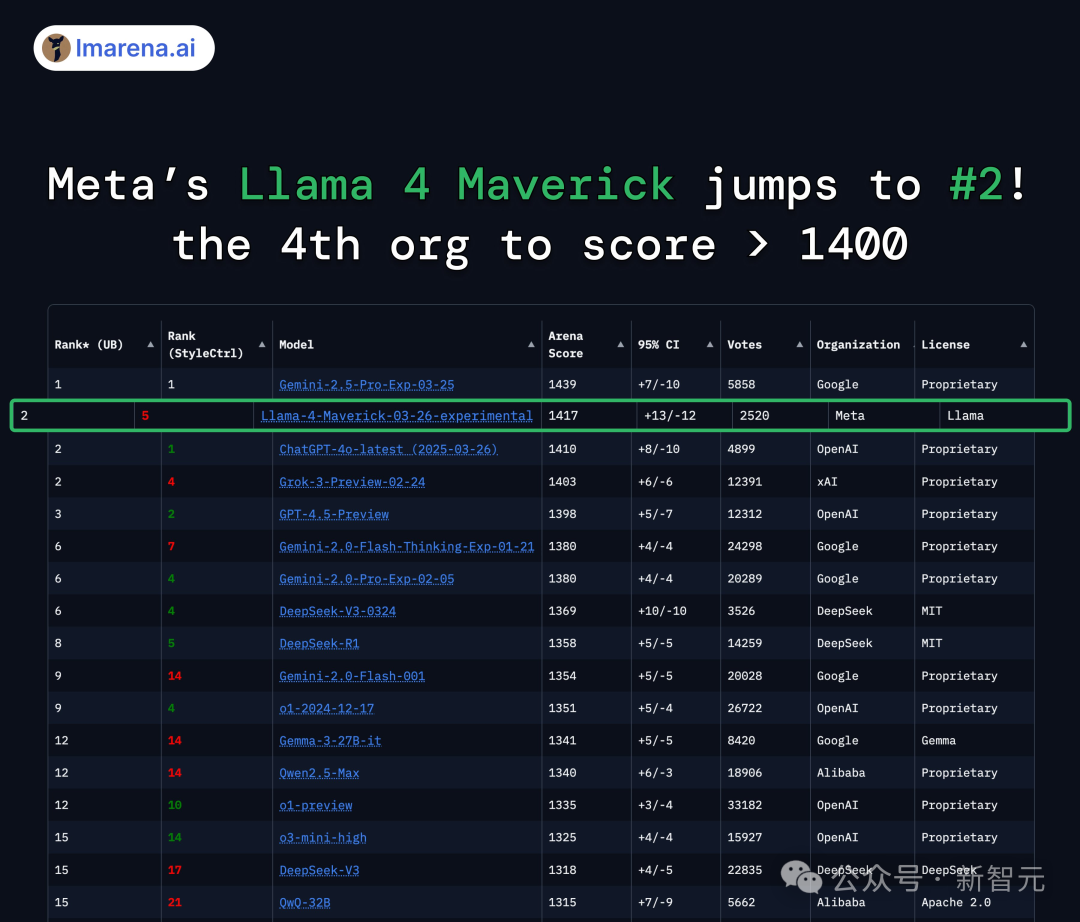

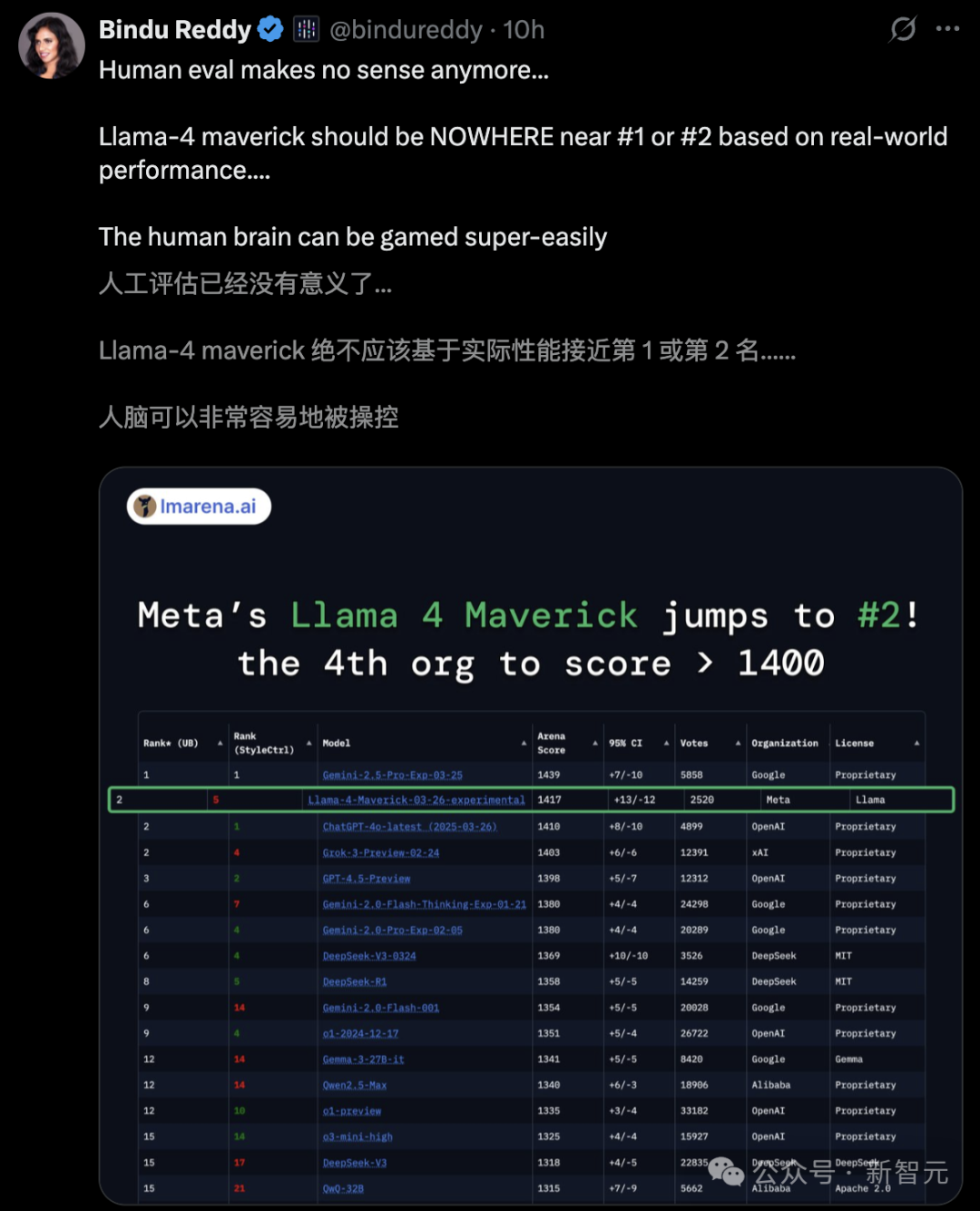

甚至,有人直接曝出,Llama 4在LMarena上存在過擬合現象,有極大的「作弊」嫌疑。

而如今,內部員工爆料,進一步證實了網民的猜想。

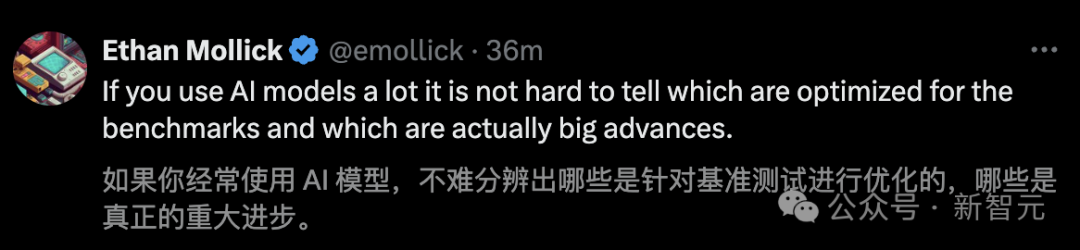

禾頓商學院教授Ethan Mollick一語中的,「如果你經常使用 AI 模型,不難分辨出哪些是針對基準測試進行優化的,哪些是真正的重大進步」。

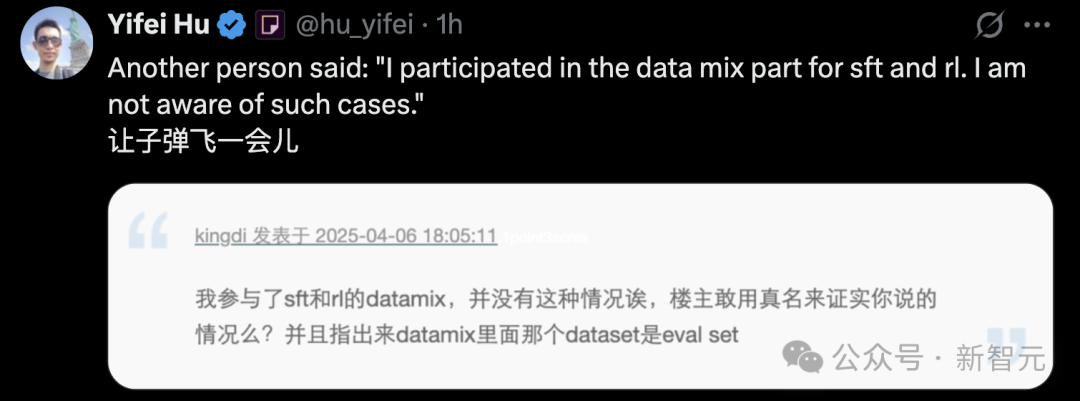

不過,另一位內部員工稱,並沒有遇到這類情況,不如讓子彈飛一會兒。

內部員工爆料,Llama 4訓練作弊?

幾位AI研究人員在社交媒體上都「「抽水」」同一個問題,Meta在其公告中提到LM Arena上的Maverick是一個「實驗性的聊天版本」。

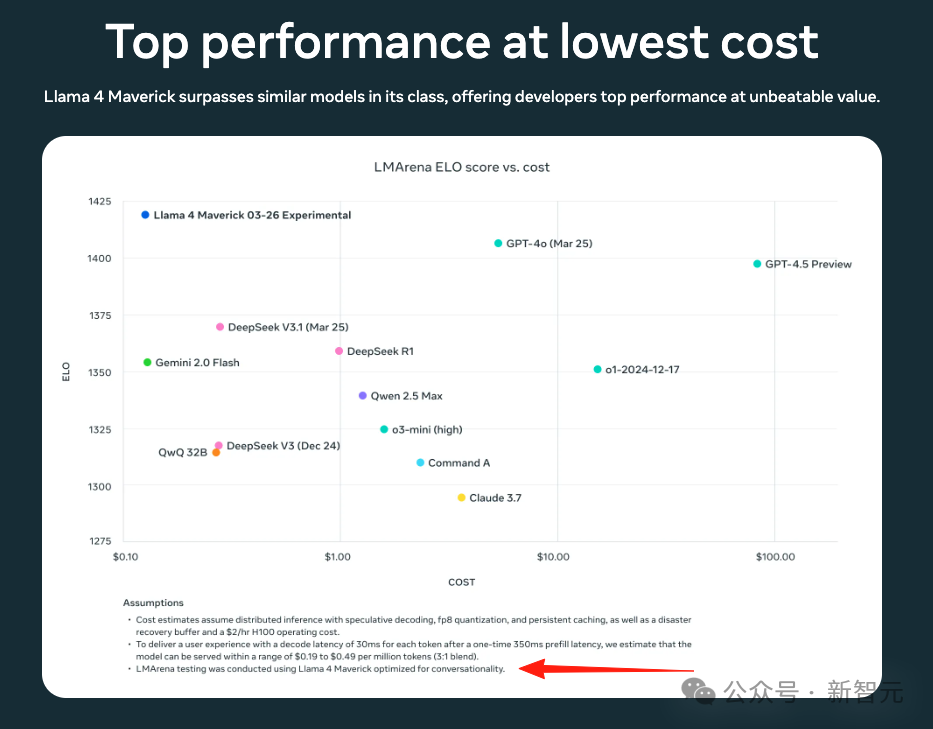

如果看得仔細一點,在Llama官網的性能對比測試圖的最下面一行,寫著「Llama 4 Maverick optimized for conversationality.」

翻譯過來就是「針對對話優化的Llama 4 Maverick」——似乎有些「雞賊」。

這種「區別對待」的會讓開發人員很難準確預測該模型在特定上下文中的表現。

AI的研究人員觀察到可公開下載的Maverick與LM Arena上託管的模型在行為上存在顯著差異。

而就在今天上午,已經有人爆料Llama 4的訓練過程存在嚴重問題!

即Llama 4內部訓練多次仍然沒有達到開源SOTA基準。

Meta的領導層決定在後訓練過程中混合各種基準測試集——讓Llama 4「背題」以期望在測試中取得「好成績」。

這個爆料的原始來源是「一畝三分地」,根據對話,爆料者很可能來自於Meta公司內部。

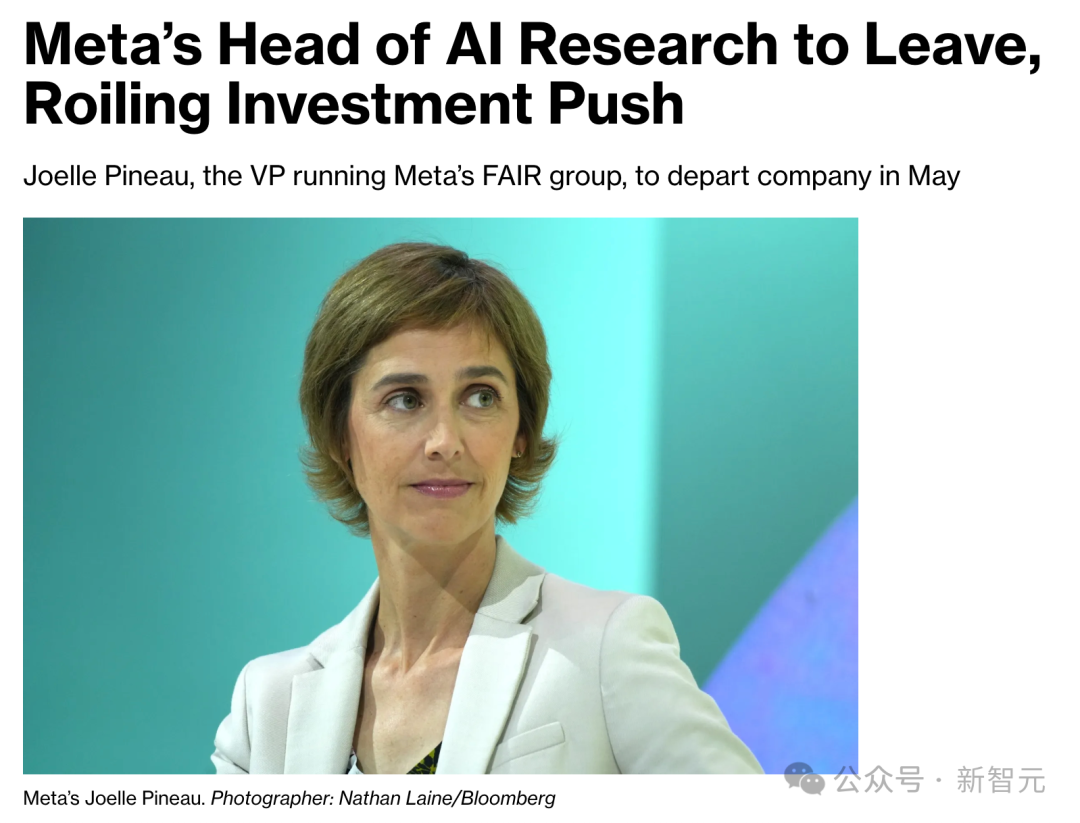

對話中提到的Meta AI研究部副總裁Joelle Pineau也申請了5月底辭職。(不過,也有網民稱並非是與Llama4相關)

但是根據Meta的組織架構體系,Pineau是FAIR的副總裁,而FAIR實際上是Meta內部與GenAI完全獨立的組織,GenAI才是負責Llama項目的組織。

GenAI的副總裁是Ahmad Al-Dahle,他並沒有辭職。

Llama 4才剛剛發佈一天,就出現如此重磅的消息,讓未來顯得撲朔迷離。

代碼翻車,網民大失所望

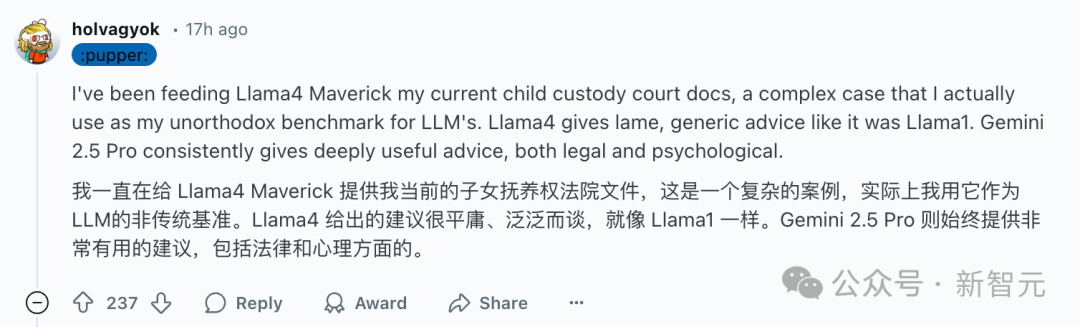

在昨天網民的實測中,評論還是有好有壞。

但是過去一天進行更多的測試後,更多的網民表達了對Llama 4的不滿。

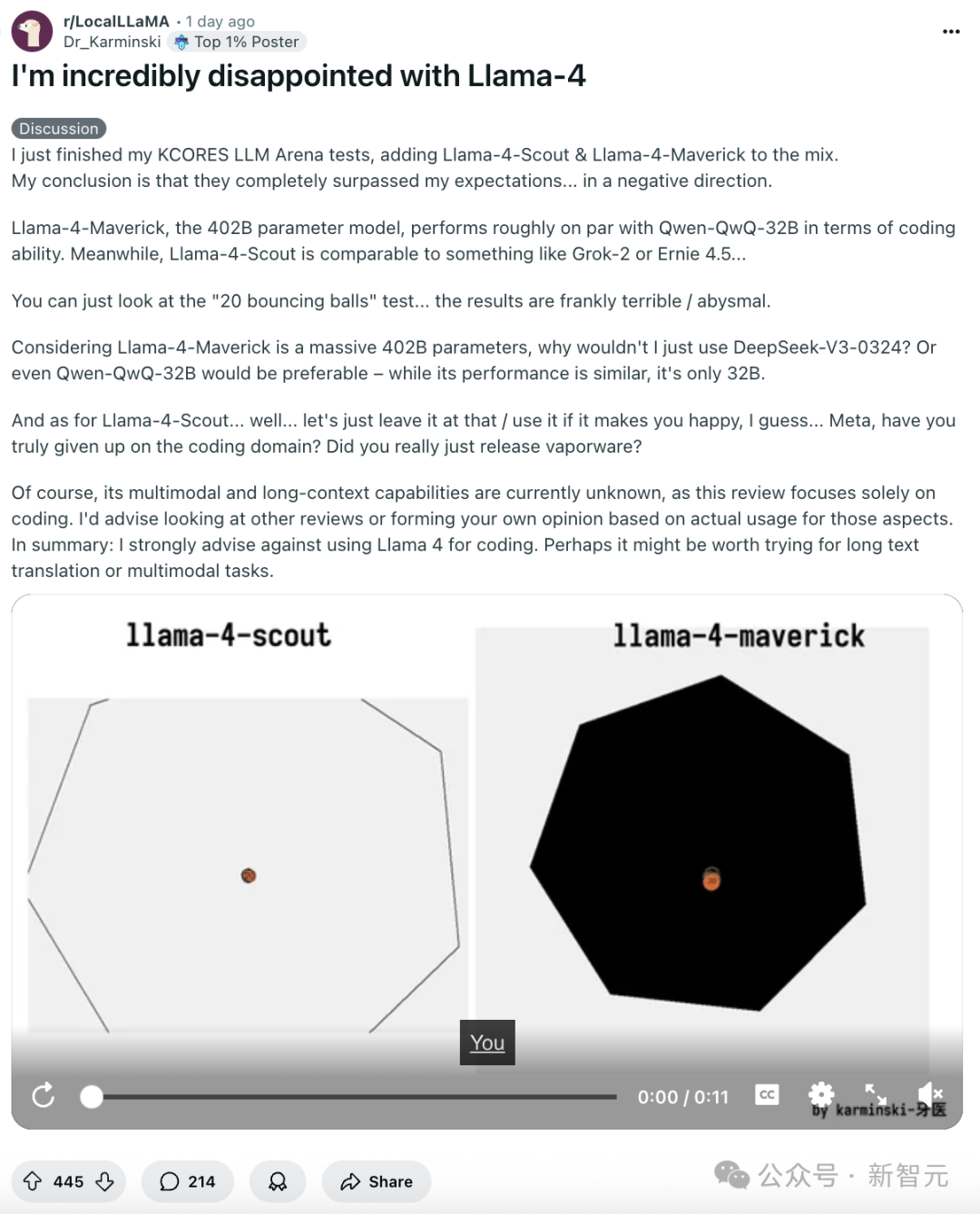

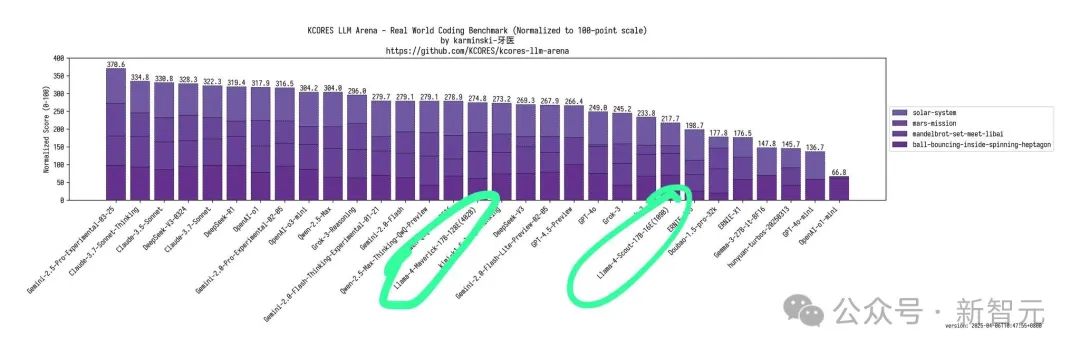

在Dr_Karminski的一篇熱帖中,他說Llama-4-Maverick——總參數402B的模型——在編碼能力方面大致只能與 Qwen-QwQ-32B相當。

Llama-4-Scout——總參數109B的模型——大概與Grok-2或Ernie 4.5類似。

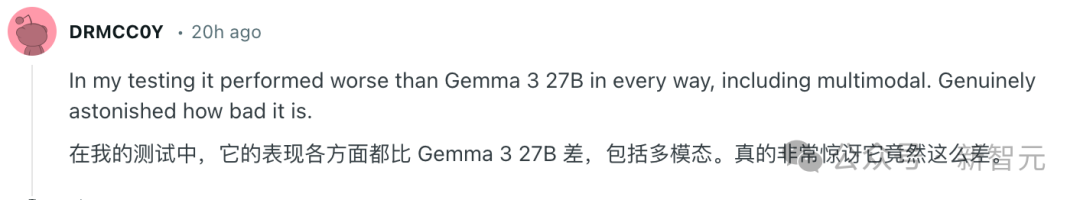

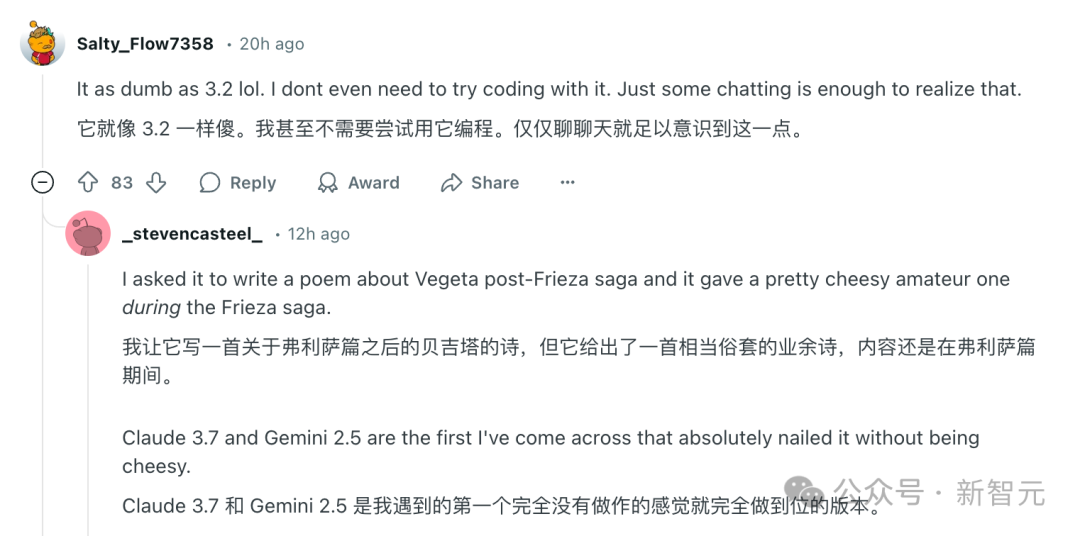

在評論中,網民響應了這個判斷。

有人說Llama 4的表現比Gemma 3 27B還要差。

有人認為Llama 4的表現甚至和Llama 3.2一樣沒有任何進步,也無法完成寫詩。

其他用戶在測試後也表達了同樣的觀點,Llama 4有點不符合預期。

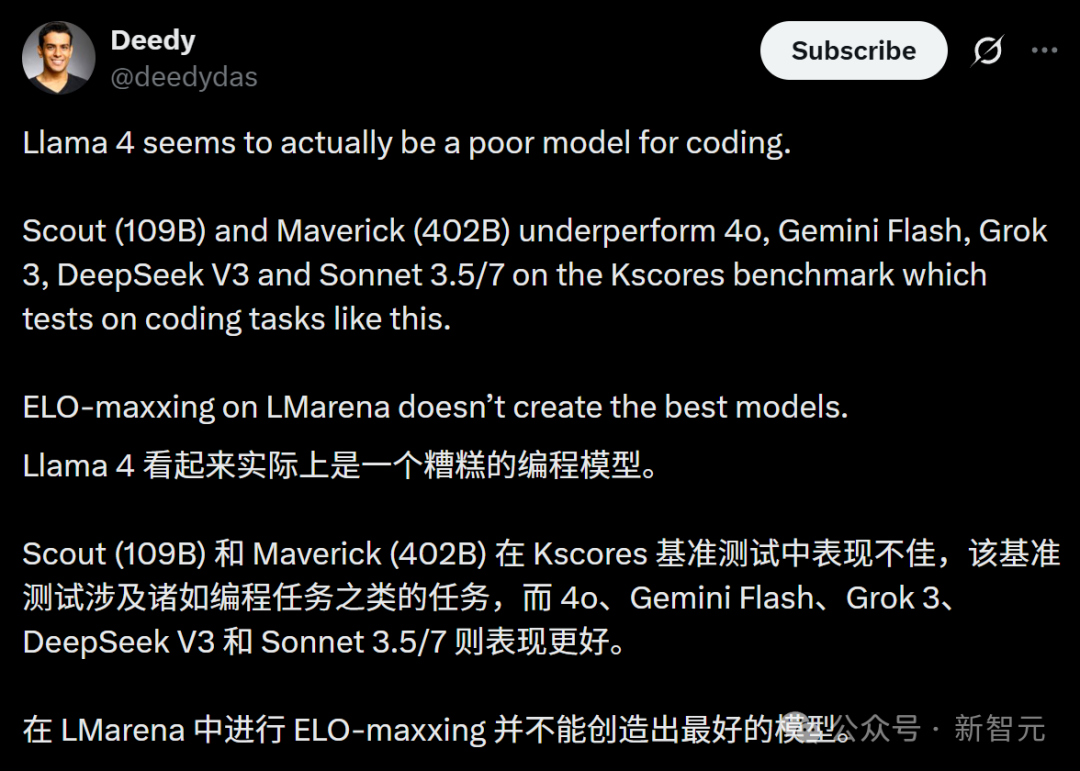

網民Deedy也表達了對Llama 4的失望,稱其為「一個糟糕的編程模型」。

他表示,Scout (109B) 和Maverick (402B)在針對編程任務的Kscores基準測試中表現不如4o、Gemini Flash、Grok 3、DeepSeek V3和Sonnet 3.5/7。

他還給出了貼出了Llama 4兩個模型的一張測試排名,結果顯示這兩個新發佈的模型遠遠沒有達到頂尖的性能。

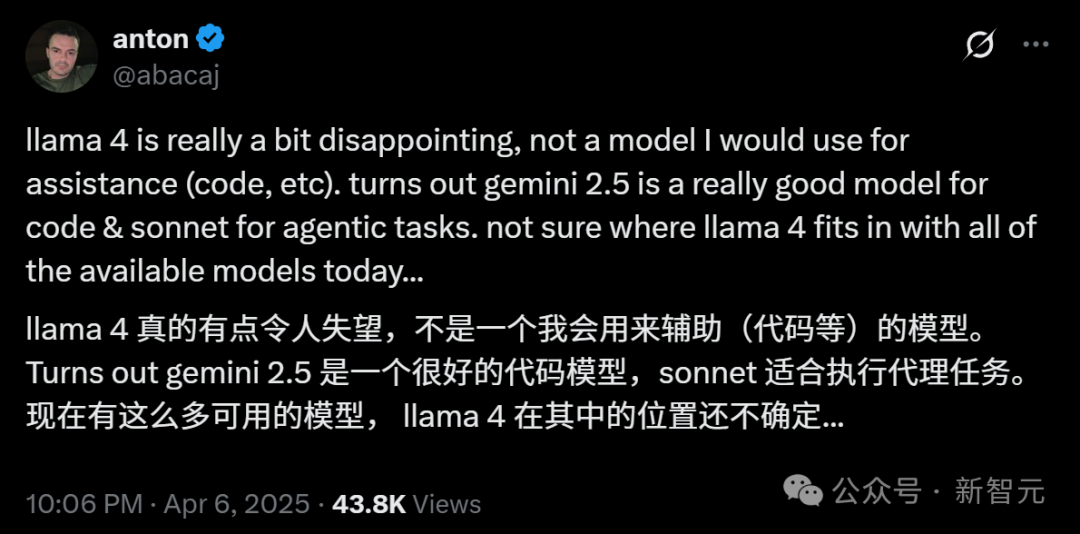

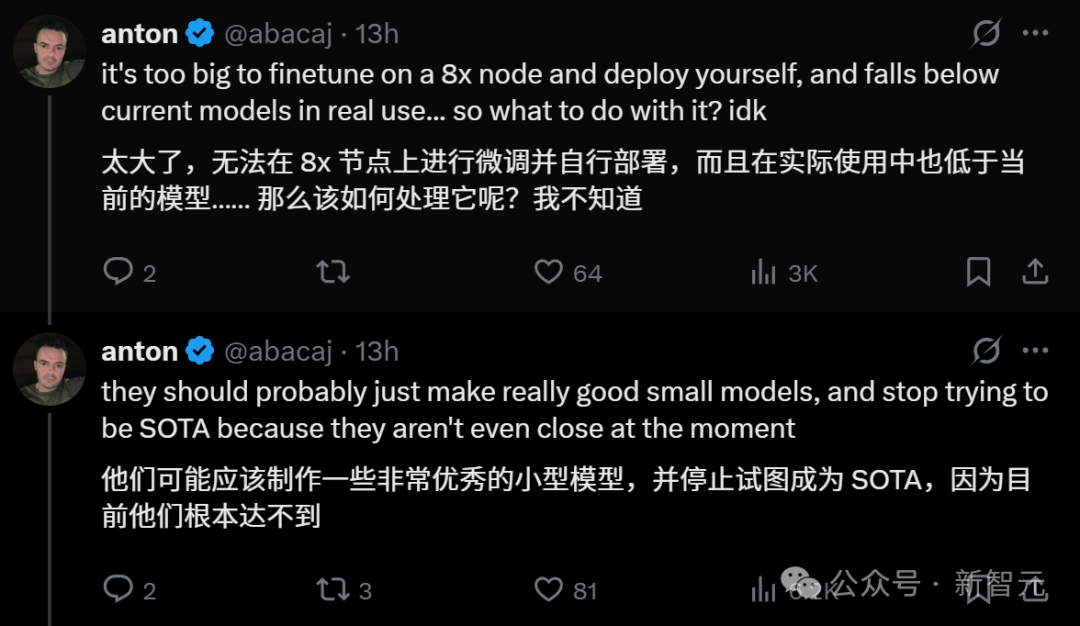

網民anton說,Llama 4「真的有點令人失望」。

他表示自己不會用它來輔助編碼,而Llama 4的定位有點尷尬。

anton認為Llama 4的兩個模型太大了,不太好本地部署。他建議Meta應該推出性能優秀的小模型,而不是去追求成為SOTA。

「因為目前他們根本做不到。」他寫道。

參考資料:

https://x.com/natolambert/status/1908959159959027903

https://x.com/karminski3/status/1908841453780177244

https://x.com/abacaj/status/1908884059264086520