從高光到塌房,Meta Llama 4 遭遇驚魂72小時

開源大模型 Llama 4 的翻車還在持續發酵。

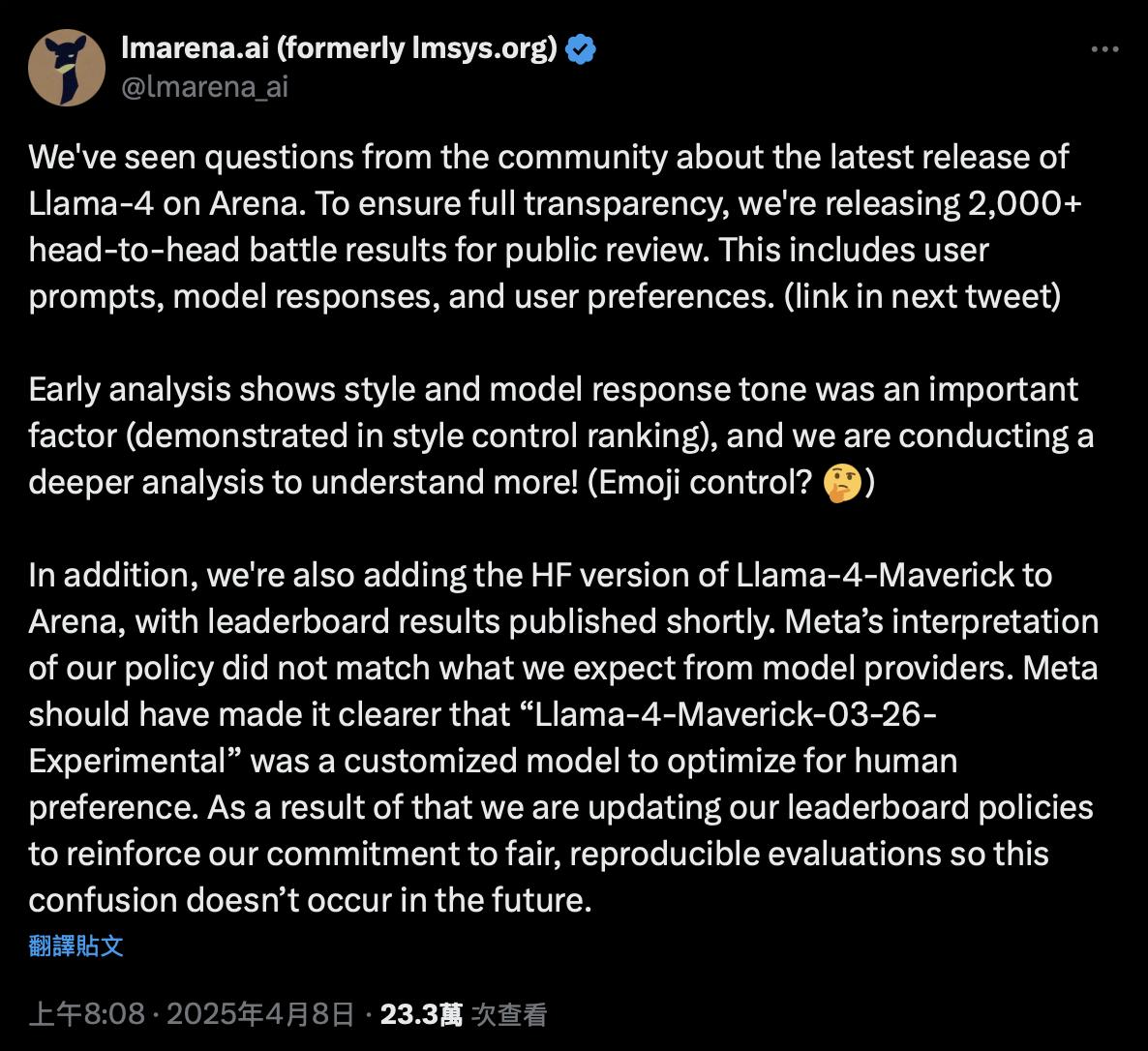

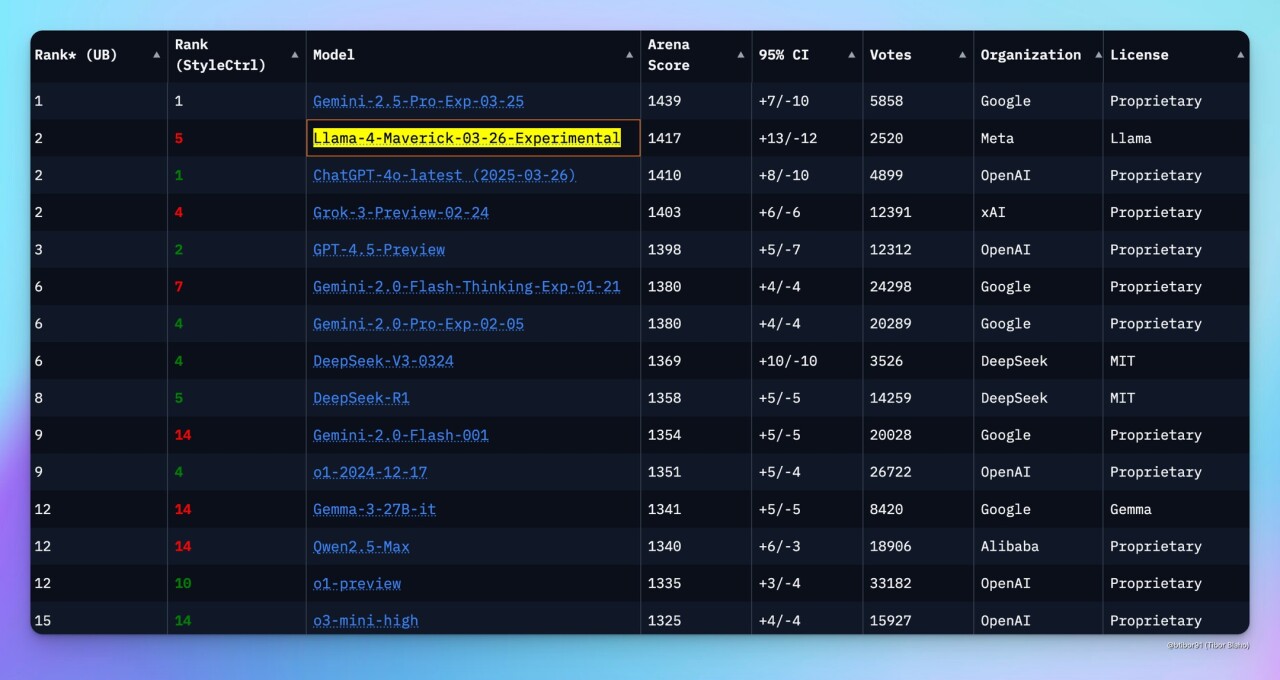

4 月 8 日,作為大語言模型「權威榜單之一」的 Chatbot Arena(民間俗稱「大模型競技場」)發佈了一則語氣罕見嚴肅的聲明。面對社群對於 Meta 新模型 Llama 4 排名的質疑,官方表示將公開 2000 多場真人對比測試的完整數據,並罕見點名 Meta:

「Meta 應該更清楚地表明『Llama-4-Maverick-03-26-Experimental』是一個作為人類偏好進行優化的定製化模型。我們正在更新排行榜的策略,以避免此類混淆再次發生。」

圖/ X

圖/ X這條聲明不只是澄清,一定程度上也是對整個大模型行業的一記警鍾。

Chatbot Arena 由加州大學伯克利分校發起,是當前大模型評測中可能最具行業影響力的「真人盲測」排行榜,核心的機制是通過讓開發者和 AI 愛好者會在平台上用相同問題向兩款模型提問,對比回答內容並投票打分。

而這種「真人盲測」的機制,讓 Chatbot Arena 有別於其他任何基準測試,也成為了外界最為信賴的大模型排行榜。可以說,一款模型是否登上「Chatbot Arena 排行榜」前列,在一定程度上直接影響其在媒體和開發者群體中的口碑與採納率。

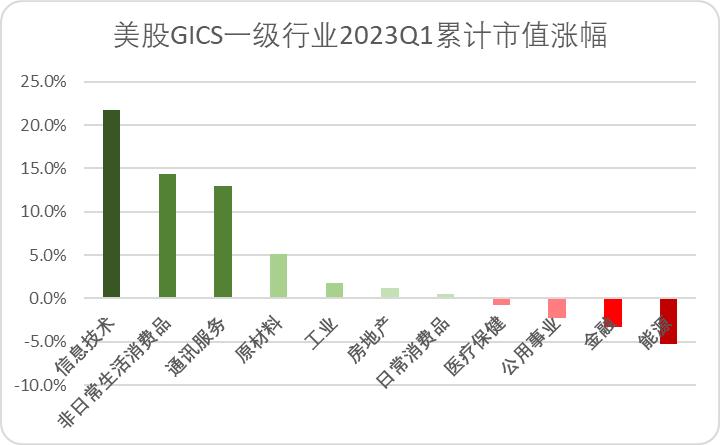

正因如此,當 Meta 在 4 月 5 日發佈其最新一代開源大模型 Llama 4,隨後快速衝上Chatbot Arena 排行榜第二,力壓一眾頂級大模型,僅次於 Google 前腳發佈的 Gemini 2.5 Pro,自然也就引起了所有人的好奇和期待。

但很快,社區發現這一版本是未公開、定製化調優的「實驗模型」,而並非 Meta 開源的正式版。於是,爭議爆發:這算不算「刷榜」?Chatbot Arena 是否被利用為營銷工具?Meta 為什麼要這樣操作?

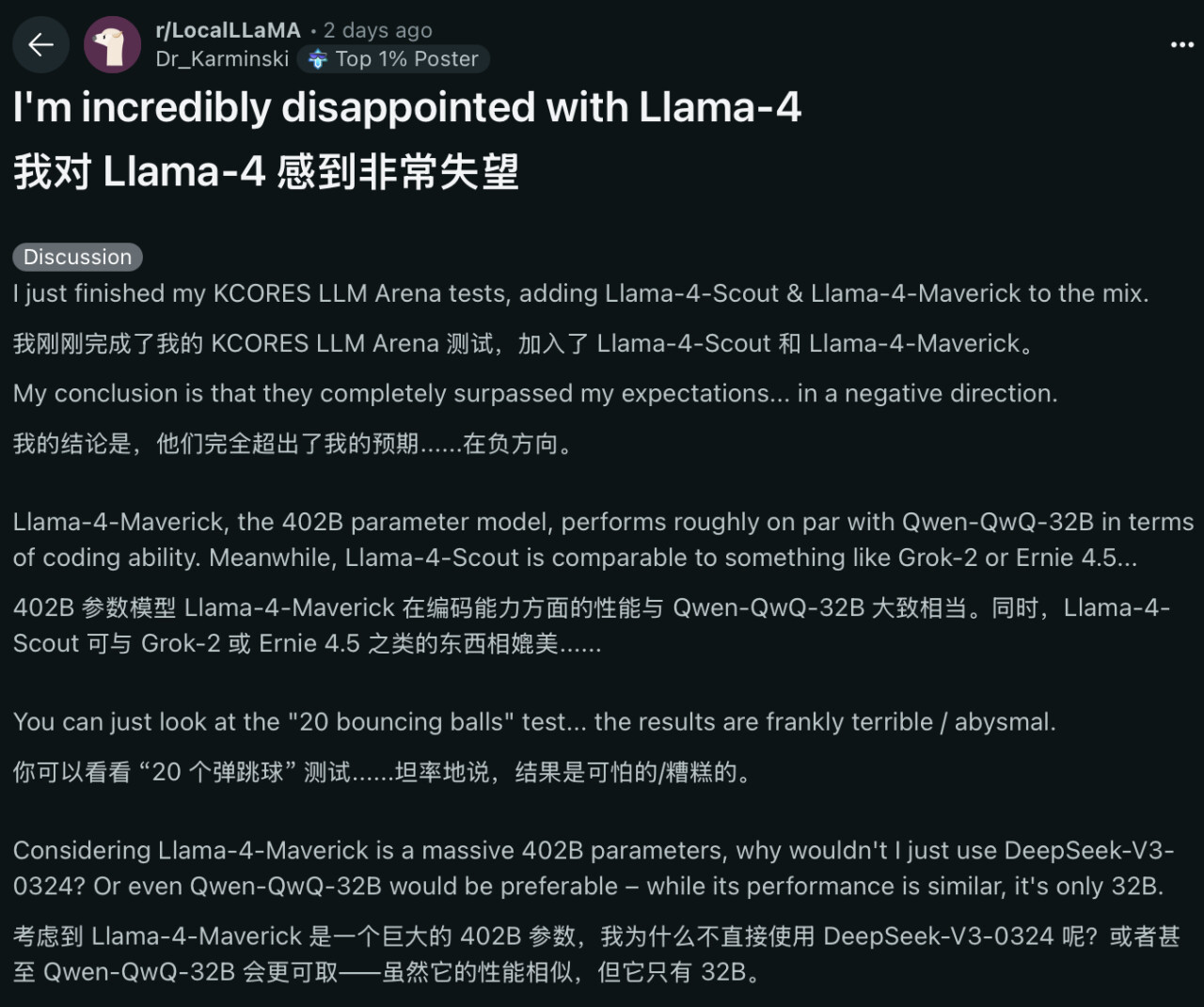

更糟的是,在部分官方沒有展示的專業基準測試中,Llama 4 表現也不盡如人意,幾乎墊底。不少第一批嘗試的用戶也在 Reddit、X 等社交平台上發文表達了失望,有人就在發帖中提到 Llama 4 在編程能力上的不盡如人意,並指出:

「考慮到 Llama-4-Maverick 有 402B 的參數量,我為什麼不直接使用 DeepSeek-V3-0324 呢?或者 Qwen-QwQ-32B 可能更合適——雖然性能相似,但它的參數量只有 32B。」

圖/ Reddit

圖/ Reddit這讓人不禁疑惑,曾經被開源陣營寄予厚望、憑藉 Llama 2 和 Llama 3 逐漸建立口碑的 Meta,為什麼就在 Llama 4 翻了車?

01 從高光到塌房,Llama 4的72小時驚魂

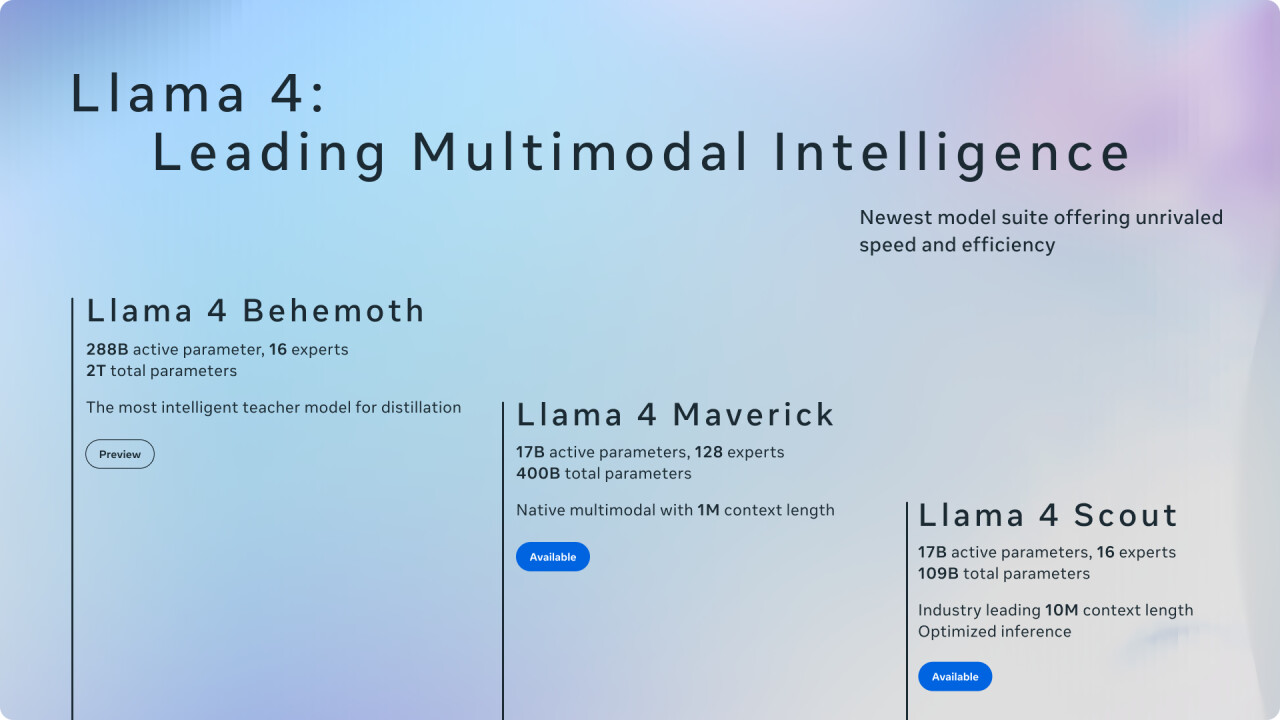

時間回到 4 月 5 日,Meta 在官方博客上發佈《The Llama 4 herd: The beginning of a new era of natively multimodal AI innovation》一文,正式宣佈 Llama 4 系列模型面向社區開源。

這一次,Meta 公開了最新一代模型的三個版本:Llama 4 Scout、Llama 4 Maverick、還在訓練中的「教師模型」Llama 4 Behemoth,均首次採用了混合專家(MoE)架構。

圖/ Meta

圖/ Meta其中最主流、最受關注的 Maverick 版本,是擁有 128 個「專家」的 170 億活躍參數模型(總參數為 4000 億),Meta 將其描述為「同類最佳的多模態模型」,強調其在多方面超過了 Gemini 2.0 與 GPT-4o,在編碼和推理方面比 Deepseek 3.1 更有競爭力。

但就在 Llama 4 發佈不久,情況迅速脫離了 Meta 的預期。

在社區層面,首批用戶對 Llama 4 的表現並不買賬。在多個測試中,尤其是在需要代碼能力和嚴謹邏輯推理的場景中,Llama 4 的表現並沒有兌現其超越 GPT、DeepSeek 的表現。包括在 Aider Chat 提供的 Polyglot 編程測試中,Maverick 版本的正確率僅為 16%,處於排行榜末尾。

不僅與其龐大的參數體量完全不符,甚至落後於規模更小的開源模型,比如 Google Gamma 。這種結果讓不少開發者大感意外,也與官方宣傳形成了強烈反差。

圖/ Chatbot Arena

圖/ Chatbot Arena風評下滑之際,更嚴厲的質疑也接踵而至——Llama 4 是否使用了公開測試集進行訓練?是否針對通用基準的 Chatbot Arena 針對性優化?這些質疑都在技術社區迅速傳播、發酵,包括 Chatbot Arena 在聲明中儘管並未使用「作弊」等字眼,但字裡行間的語氣已足夠強硬和不滿。

尤其是中文移民社區「一畝三分地」上,自稱提交辭呈、要求從 Llama 4 技術報告中刪除名字的「Meta 員工」發帖表示,隨著 Deadline(截止日期)的逼近,Meta 最終選擇了將各個基準測試的測試集混合在 Post-Training「後訓練」(對應大模型的「預訓練」階段)之中。

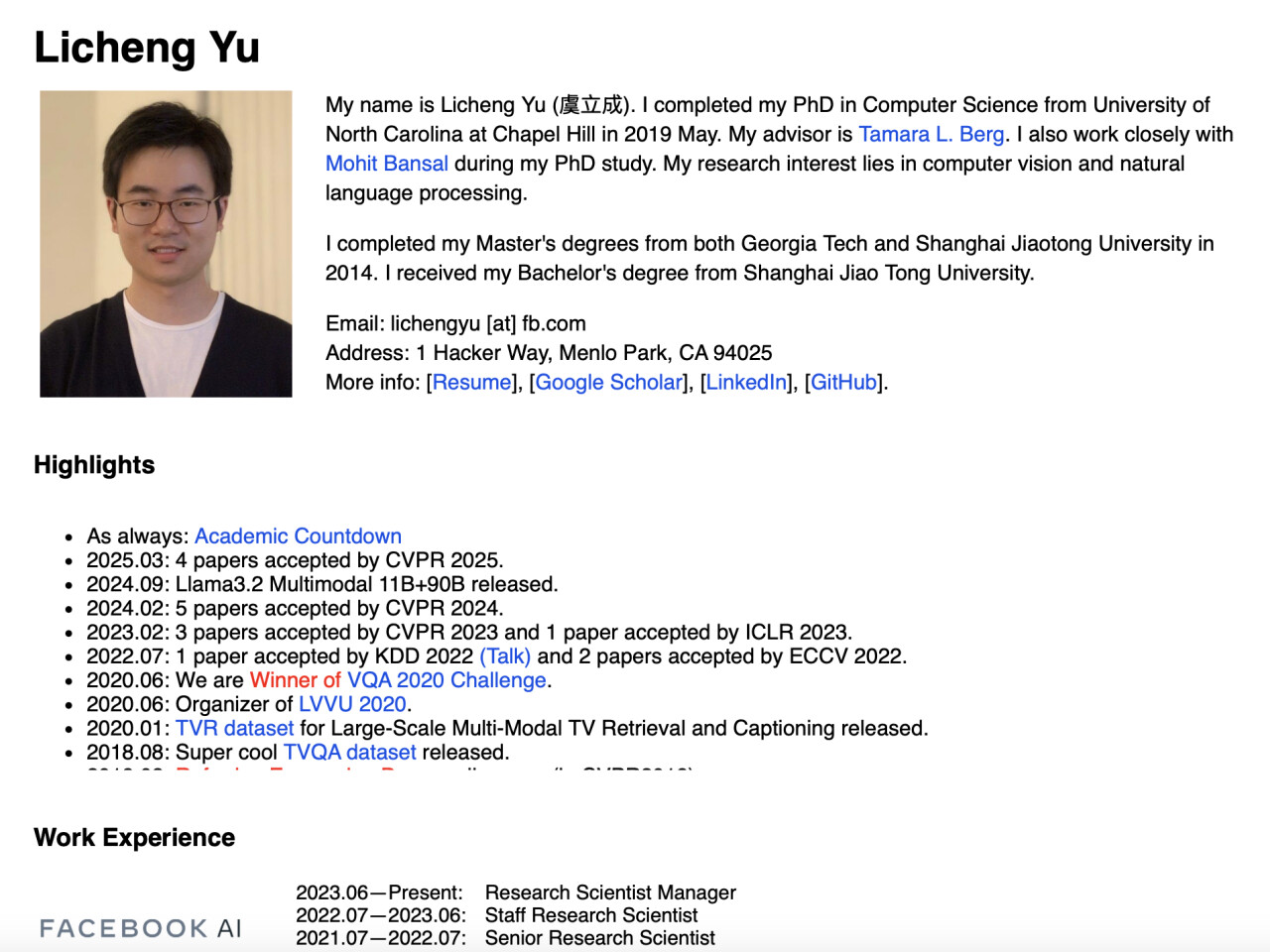

不過 Meta 團隊很快出面做了澄清,一位經手「後訓練」的 Meta GenAI 成員實名(Licheng Yu)表示:

「這兩天虛心聆聽各方 feedback(比如 coding、creative writing 等缺陷必須改進)希望能在下一版有提升。但為了刷點而 overfit 測試集我們從來沒有做過,實名 LichengYu,兩個 oss model 的 post training 有經手我這邊請告知哪條 prompt 是測試集選出來放進訓練集的我給你磕一個+道歉!」

圖/ Licheng Yu

圖/ Licheng Yu公開資料顯示,Licheng Yu(虞立成)本科畢業於上海交通大學,2014 年獲佐治亞理工學院和上海交通大學雙碩士學位,2019 年獲北卡羅來納大學教堂山分校計算機科學博士學位,2023 年 6 月至今在 Meta 擔任研究科學家經理,並參與了 Llama 3、Llama 4 項目。

同時,負責 Meta GenAI 的副總裁 Ahmad Al-Dahle 也在 X 平台明確表示,「Meta 沒有在測試集上訓練 Llama 4。」而針對 Llama-4-Maverick-03-26-Experimental,Meta 也在爭議發生後選擇了發佈開源版本,以回應外界的批評。

圖/ X

圖/ X但這些回應顯然都沒能迴避掉一個問題:Llama 4 的真實能力。事實上,不管是 Licheng Yu,還是 Ahmad Al-Dahle,都在駁斥部分質疑的同時承認了 Llama 4 在性能存在的問題。

作為開源陣營中曾經「最有希望挑戰 OpenAI」的旗手,Llama 4 原本承載著開發者與產業界的高度期待。但現在,它卻在發佈一週內從「高光」跌入「信任危機」,成為大模型競賽中一次罕見的口碑「滑鐵盧」。

02 DeepSeek加速開源,Meta被逼到失速

如果只看表面,這次 Llama 4 的口碑翻車,似乎充滿了戲劇張力——匿名離職員工爆料稱,Meta 高層為了趕上內部設定的 Deadline,要求將各大測試集混入 「後訓練」,只為「一個能看的結果」。甚至還傳言,負責 AI 的副總裁 Joelle Pineau 也因反對這一做法而離職。

不過從目前公開的信息來看,這些說法經不起推敲。關於使用測試集進行後訓練一事,前文的回應其實已經基本澄清。而 Joelle Pineau 的離職發生在發佈前兩天,但她並不負責生成式 AI 團隊,而是領導 Meta Fundamental AI Research(FAIR)研究部門,與 Llama 4 項目並無直接關聯。

發佈前幾天離職的 Joelle Pineau,圖/ Meta

發佈前幾天離職的 Joelle Pineau,圖/ Meta在辟除這些輿論雜音之後,真正的問題才浮出水面。追根究底,Llama 4 的問題,不在於造假,而在於開源大模型競爭加劇下的失速。

過去兩年,Meta 憑藉 Llama 2 和 Llama 3,逐步在開源模型市場上建立起「領先、可靠」的認知。然而到了 Llama 4,情況已經發生了巨大的變化,DeepSeek V3/R1 的發佈扭轉了開源與閉源模型的差距,並且大大加速了開源模型的發展速度。

這讓原本作為「開源領導者」的 Llama 面臨更大的壓力。

儘管我們認為前文爆料很多經不起推敲,但有一點卻是現實:Llama 4 確實有 Deadline。這一點從 Llama 4 Behemoth 還在訓練中就得以窺見,而且在參數規模膨脹、架構複雜化(MoE)的同時,Llama 4 很可能沒有留出足夠的測試和改進時間,才導致發佈後不穩定的性能表現。

圖/ Meta

圖/ Meta此外,Meta 也沒能控制住動作的變形。Llama-4-Maverick-03-26-Experimental 針對對話模式的優化本身無可厚非,但「正選」Chatbot Arena 的目的卻是路人皆知。我們也不知道,這個特調版本又犧牲了哪些?

而從目前來看,Meta 的做法顯然錯了,經過能在發佈之處獲得更高的期待、更多的關注,但之後的實際表現不僅讓人更加失望,也打破了用戶對 Llama 系列「領先、可靠」的認知。

怎麼看都是輸。

Meta 當然還有機會補救。只是,它首先必須正面面對 DeepSeek、Qwen、Gamma 等其他大模型已經崛起、甚至超越自己的現實,才能談重整河山。

本文來自微信公眾號「雷科技」,作者:雷科技,36氪經授權發佈。