從零搭一套可複現、可教學、可觀察的RL for VLM訓練流程,我們試了試

自 Deepseek-R1 發佈以來,研究社區迅速響應,紛紛在各自任務中複現 R1-moment。

在過去的幾個月中,越來越多的研究嘗試將 RL Scaling 的成功應用擴展到視覺語言模型(VLM)領域 —— 刷榜、追性能、製造 「Aha Moment」,整個社區正高速奔跑,RL for VLM 的邊界也在不斷被推遠。

但在這樣一個節奏飛快、聚焦結果的研究環境中,基礎設施層面的透明性、評估的一致性,以及訓練過程的可解釋性,往往被忽視。

這會帶來三個問題:

-

當底層實現依賴封裝複雜的 RL 庫時,整體流程往往難以看清,理解和修改成本高,不利於方法的教學與傳播;

-

缺乏一致、魯棒的評估標準,不同方法之間難以公平比較,也難以積累長期洞察;

-

訓練過程行為不可觀測,模型如何學習、學習出了什麼能力、訓練過程中出現了哪些行為變得難以分析。

於是,來自上海交通大學、MiniMax、複旦大學和 SII 的研究團隊選擇按下暫停鍵,進行了一次關於 RL Scaling 的重新思考(Rethinking):

他們提出 MAYE —— 一個從零實現的 RL for VLM 框架與標準化評估方案,希望為該領域奠定一個透明、可複現、可教學的研究起點。

-

論文標題:Rethinking RL Scaling for Vision Language Models: A Transparent, From-Scratch Framework and Comprehensive Evaluation Scheme

-

論文地址:https://arxiv.org/pdf/2504.02587

-

代碼地址:https://github.com/GAIR-NLP/MAYE

-

數據集地址:https://huggingface.co/datasets/ManTle/MAYE

三大核心貢獻

重塑 RL+VLMs 的研究範式

1. 簡潔透明的 RL for VLM 訓練架構:輕依賴、強可控

MAYE 的實現很「乾淨」:

-

沒有 Ray / DeepSpeed / TRL / Verl / OpenRLHF / AReaL

-

從零實現,無黑箱封裝,無多餘抽像

-

基於 Transformers / FSDP2 / vLLM 搭建,專為 VLM 設計

-

支持靈活改動,適合教學與研究場景

這樣的設計不僅提升了訓練過程的可解釋性,也極大降低了 RL for VLM 的入門門檻:每一行代碼、每一個環節都可見、可查、可改,研究者可以更清晰地理解模型是如何學習的,又為何能收斂。

我們並未採用當前 VLM-RL 社區常用的 GRPO,而是選擇探索 Reinforce++ 的替代可能性。整個項目的靈感來源於 OpenAI Spinning Up,我們希望 MAYE 能成為 VLM-RL 研究中的一個輕量、透明、可教學的入門底座。

相比市面上黑盒化程度較高的 RL 框架,MAYE 更像是一個透明的「教學級實驗框架」:既可直接運行,也可任意插拔、修改各個組件,非常適合用於方法對比、原理教學,甚至作為新手入門的第一課。

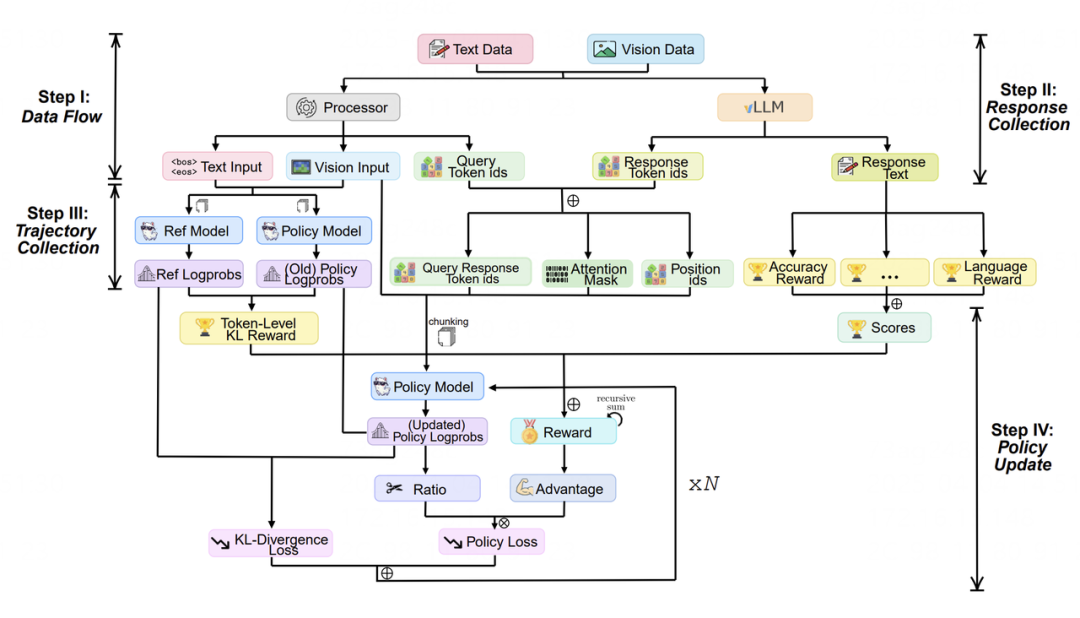

我們將完整的訓練流程解構為 4 個輕量模塊:

數據流動(data flow) → 響應採集 (response collection) → 軌跡構造 (trajectory generation)→ 策略更新 (policy update)

每一步都通過清晰的接口呈現,可以像樂高一樣自由拚接、替換,將原本複雜封裝的黑盒流程徹底 「白盒化」。

訓練過程不再是只能看 loss 和 accuracy 的黑箱,而是變成一條可以觀察、分析、干預的路徑。

RL for VLM,只需四步:結構清晰,可拆可查

RL for VLM,只需四步:結構清晰,可拆可查2. 標準化評估方案:看清訓練過程,看懂模型行為

RL 研究中,一直存在兩個老大難問題:訓練過程不穩定,評估過程不透明。

尤其在 VLM 場景下,很多 RL 工作只關注 「最後結果」,缺乏對學習曲線、行為演化的系統性觀察與分析。

那麼 —— 模型究竟是如何學會的?反思能力是如何出現的?長輸出真的等於更強推理嗎?過去缺乏統一的方式來回答這些問題。

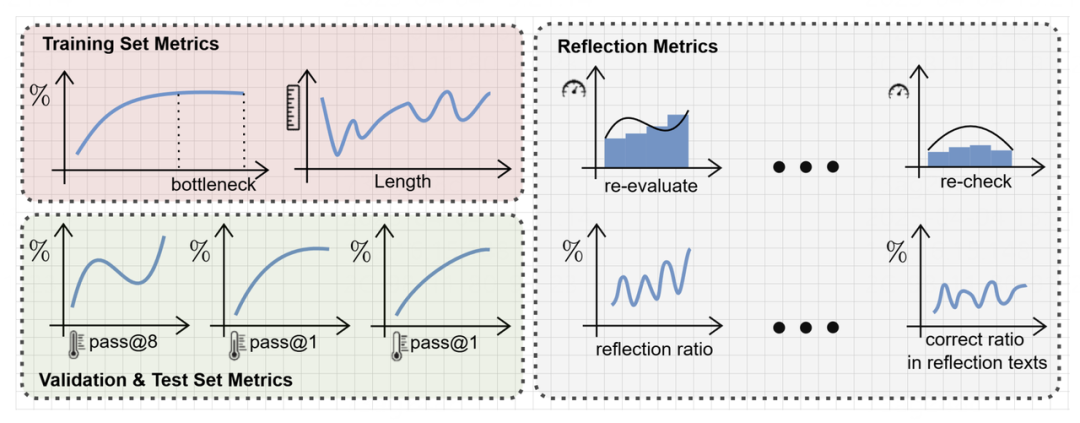

為此,MAYE 提出了一整套細緻、可複現的標準化評估方案(evaluation scheme),用於系統追蹤訓練動態和模型行為演化:

訓練集指標:

-

accuracy curve(準確率曲線)

-

response length(響應長度)

-

多次獨立運行取均值,展現真實學習趨勢

驗證 & 測試集指標:

-

pass@1 與 pass@8,在不同溫度設置下評估泛化能力

-

提供平均值 + 最大值,全面覆蓋性能變化

反思行為指標:

-

反思詞使用頻率統計(e.g., re-check, think again, verify)

-

五個比例指標,量化反思是否真正帶來了正確率提升

這些指標覆蓋了訓練全過程,既能用於算法開發,也適合橫向比較、機制研究。

無論你是做方法、做分析,還是做認知能力探測,MAYE 都能提供一套清晰可複現的過程視角。

準確率曲線、輸出長度、反思指標——三類視角還原 RL 全貌

準確率曲線、輸出長度、反思指標——三類視角還原 RL 全貌3. 實證發現與行為洞察:RL 不止有效,更值得被理解

MAYE 不只是一個框架和評估工具,也是一套可以產出研究發現的實驗平台。

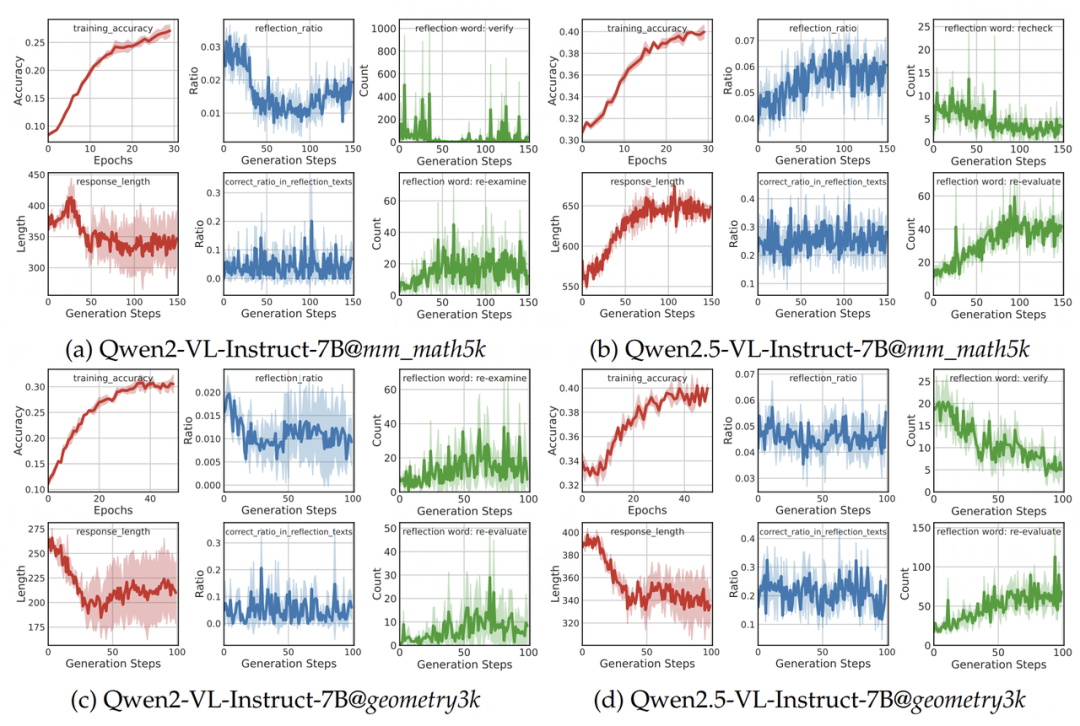

研究團隊在多個主流 VLMs(如 Qwen2 / Qwen2.5-VL-Instruct)和兩類視覺推理數據集(文本主導 / 圖像主導)上開展系統實驗,複現實驗足夠穩健:所有結果均基於 3 次獨立運行,並報告均值與標準差。

在此基礎上,我們觀察到了一些有代表性的現象:

-

輸出長度會隨著模型架構、數據分佈、訓練隨機種子而顯著變化,是判斷模型推理策略演化的重要觀測信號;

-

反思行為(Reflection)頻率與輸出長度高度相關,但大多數性能提升仍來源於非反思型推理。輸出變長 ≠ 模型變強。長文本可能意味著更豐富的推理,也可能只是訓練過程中的隨機漂移或複讀堆疊。只有當 「更長」 帶來 「更準」,才值得被認為是有效行為;

-

Aha Moment 並不是 RL 訓練憑空生成的,而是在 VLM 模型本身能力基礎上被進一步激發和強化;

在多個模型和數據集上,系統追蹤了訓練動態與反思行為

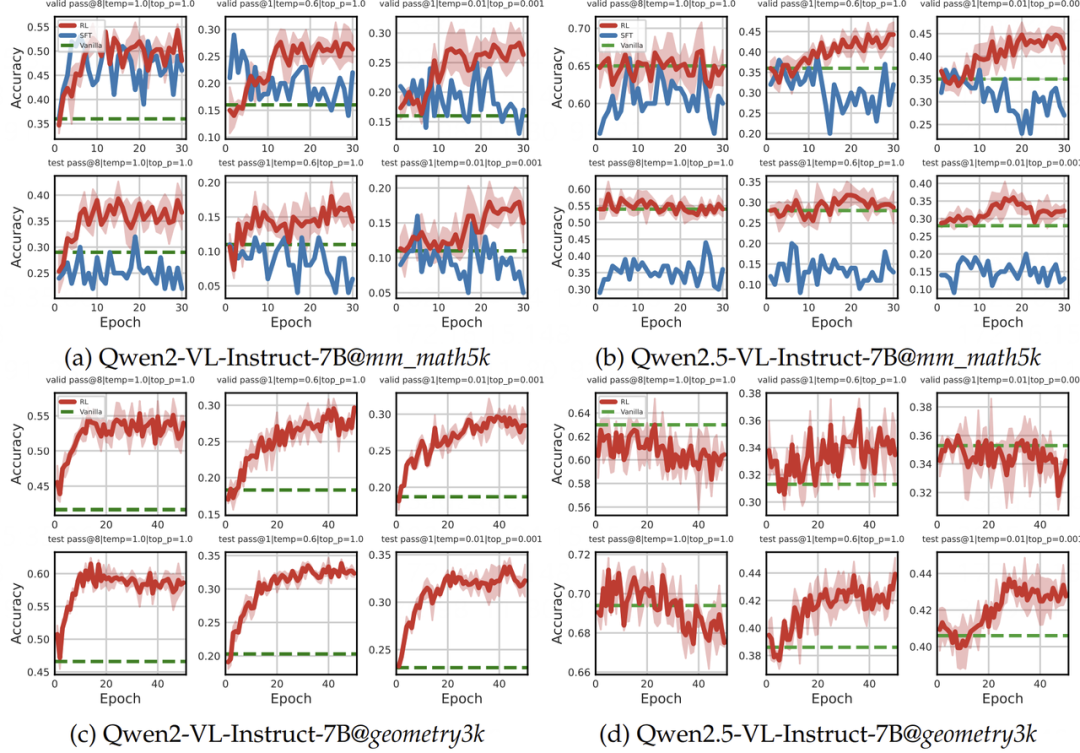

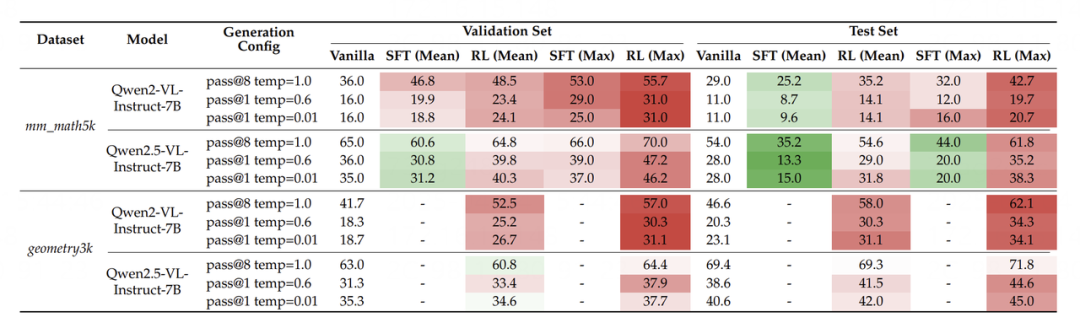

在多個模型和數據集上,系統追蹤了訓練動態與反思行為在相同高質量監督數據(來自 textbook-style CoT)下,RL 在驗證集和測試集上均顯著優於 SFT,且具有更強的 OOD 泛化能力。即便是 Qwen2.5-VL 這類強基座模型,也能從 RL 中獲得額外提升。

驗證集與測試集全維度對比:RL 展現出更強的泛化能力

驗證集與測試集全維度對比:RL 展現出更強的泛化能力 驗證集與測試集全維度對比:RL 展現出更強的泛化能力

驗證集與測試集全維度對比:RL 展現出更強的泛化能力這些實證結果不僅揭示了 RL 對模型行為的真實影響,也為後續研究者提供了穩定、可對照的 baseline 實驗結果。我們也呼籲社區更多採用多次獨立運行報告結果,推動 RL for VLM 從 「能跑通」 邁向 「可分析、可信任」。

結語

MAYE 並不是一項追求極致性能的框架優化工程,而是一套面向研究者與教學場景的基礎設施嘗試。

我們希望它能成為 RL-VLM 研究中一塊乾淨的起點,幫助社區更透明地理解訓練過程、更一致地衡量行為變化、也更高效地探索 RL Scaling for VLM 的邊界。

這隻是一個起步,希望它對你的工作有所幫助。歡迎反饋、改進、複用。論文與代碼資源全面開源,歡迎研究者探索和複現。