Meta 開源大模型 Llama-4-Maverick 基準測試排名暴跌,此前被質疑刷榜作弊

IT之家 4 月 14 日消息,LMArena 更新了 Meta 最新發佈的開源大模型 Llama-4-Maverick 的排名,其從此前的第 2 名直線下降至第 32 名。這證實了此前開發者對 Meta 為刷榜向 LMArena 提供「特供版」Llama 4 大模型的質疑。

4 月 6 日,Meta 發佈了最新的大模型 Llama 4,包含 Scout、Maverick 和 Behemoth 三個版本。其中,Llama-4-Maverick 在 LMArena 公佈的 Chatbot Arena LLM 排行榜中排名第二,僅次於 Gemini 2.5 Pro。然而,隨著開發者實際使用 Llama 4 大模型開源版的效果陸續曝光,Llama 4 的口碑急轉直下。有開發者發現 Meta 提供給 LMArena 的 Llama 4 版本與提交給社區的開源版本不同,因而質疑 Meta 刷榜作弊。

4 月 8 日,Chatbot Arena 官方發文確認了用戶的上述質疑,公開表示 Meta 提供給他們的是「特供版」,並考慮更新排行榜。根據 Chatbot Arena 官方消息,Meta 首次提交 LMArena 的 Llama-4-Maverick-03-26-Experimental 是一個實驗性聊天優化版本,當時該版本的排名為第二。修正後的模型為 HuggingFace 開源版同款 Llama-4-Maverick-17B-128E-Instruct,是 17B 激活參數、128 個 MoE 專家的指令微調模型。

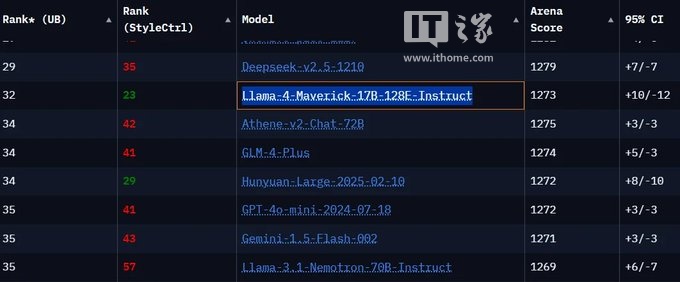

IT之家注意到,目前開源版同款 Llama-4-Maverick-17B-128E-Instruct 在 LMArena 的排名為 32 名,遠低於 Gemini 2.5 Pro(1)、GPT4o(2)、DeepSeek-V3-0324(5)、DeepSeek-R1(7)、Qwen2.5-Max(11),甚至連英偉達基於上一代 Llama 3.3 改造的 Llama-3.3-Nemotron-Super-49B-v1(17)都不如。

Meta 的 Llama-4-Maverick-03-26-Experimental 為何表現不佳?該公司在上週六發佈的一張圖表中解釋稱,該模型是「針對對話性進行優化」的。這些優化顯然在 LM Arena 上取得了不錯的效果,因為 LM Arena 的人類評分者會比較不同模型的輸出,並選擇他們更偏好的結果。

由於各種原因,LM Arena 從未被視為衡量 AI 模型性能的最可靠指標。儘管如此,針對基準測試調整模型不僅具有誤導性,還使得開發者難以準確預測該模型在不同場景下的表現。

Meta 的一位發言人向 TechCrunch 表示,Meta 會嘗試「各種類型的定製變體」。「‘Llama-4-Maverick-03-26-Experimental’是我們嘗試的一個針對聊天優化的版本,它在 LM Arena 上也表現不錯,」該發言人說,「我們現在已發佈了開源版本,將看看開發者如何根據自己的使用案例定製 Llama 4。我們期待看到他們構建的內容,並期待他們持續的反饋。」

廣告聲明:文內含有的對外跳轉鏈接(包括不限於超鏈接、二維碼、口令等形式),用於傳遞更多信息,節省甄選時間,結果僅供參考,IT之家所有文章均包含本聲明。