剛剛,智譜一口氣開源6款模型,200 tokens/秒解鎖商用速度之最

就在剛剛,智譜一口氣上線並開源了三大類最新的GLM模型:

- 沉思模型GLM-Z1-Rumination

- 推理模型GLM-Z1-Air

- 基座模型GLM-4-Air-0414

若是以模型大小(9B和32B)來劃分,更是可以細分為六款。

首先是兩個9B大小的模型:

GLM-4-9B-0414:主攻對話,序列長度介於32K到128K之間

GLM-Z1-9B-0414:主攻推理,序列長度介於32K到128K之間

還有四個32B大小的模型,它們分別是:

GLM-4-32B-Base-0414:基座模型,序列長度介於32K到128K之間

GLM-4-32B-0414:主攻對話,序列長度介於32K到128K之間

GLM-Z1-32B-0414:主攻推理,序列長度介於32K到128K之間

GLM-Z1-32B-Rumination-0414:主攻推理,序列長度為128K

而隨著一系列模型的開源,智譜也解鎖了一項行業之最——

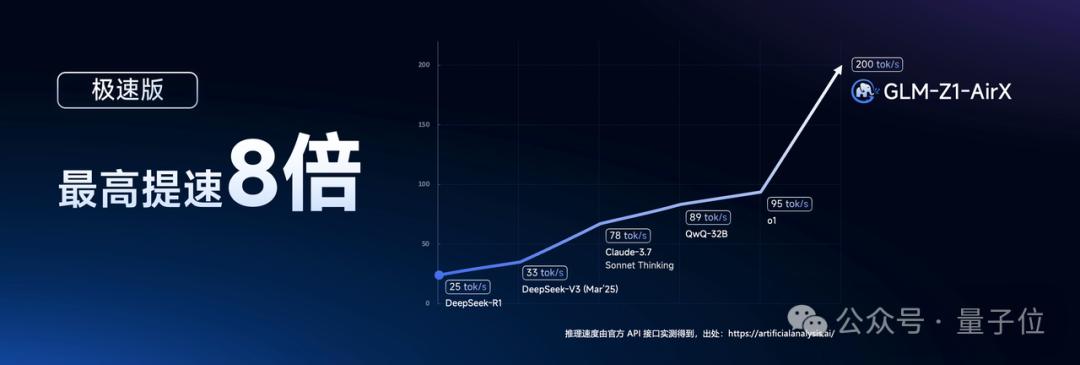

推理模型GLM-Z1-32B-0414做到了性能與DeepSeek-R1等頂尖模型相媲美的同時,實測推理速度可達200 tokens/秒。

如此速度,已然是目前國內商業模型中速度最快,而且它的高性價比版本價格也僅為DeepSeek-R1的1/30。

值得一提的是,本次開源的所有模型均採用寬鬆的MIT許可協議。

這就意味著上述的所有模型都可以免費用於商業用途、自由分發,為開發者提供了極大的使用和開發自由度。

那麼這些開源模型的效果又如何?

先看性能

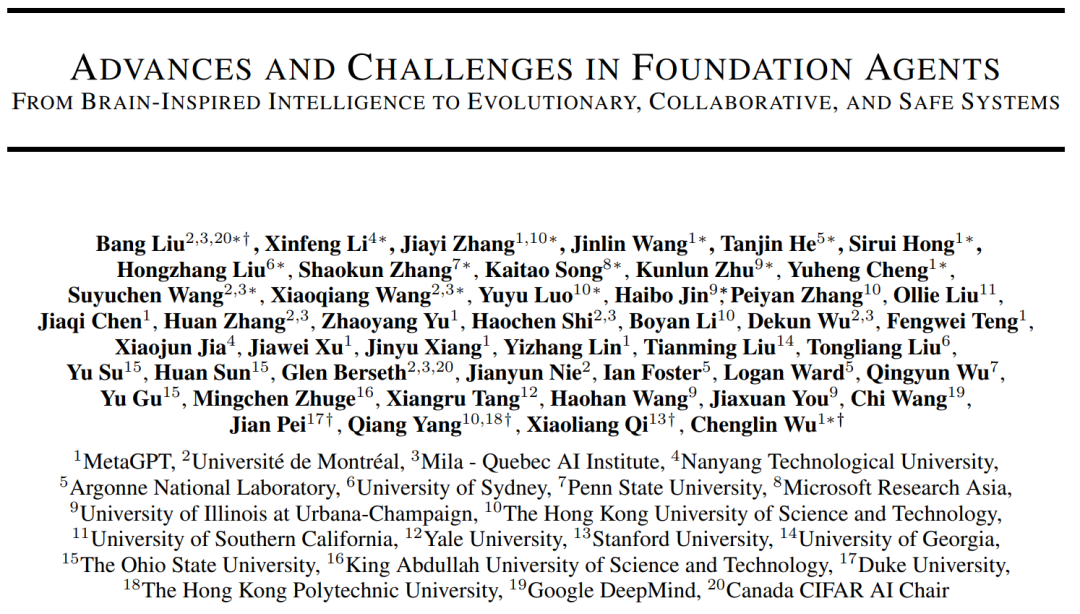

首先來看下GLM-4-32B-0414。

它是一款擁有320億參數的基座大模型,其性能足以比肩國內外規模更大的主流模型。

據瞭解,這個模型基於15T高質量數據進行預訓練,其中特別融入了大量推理類合成數據,為後續強化學習擴展提供了堅實基礎。

在後訓練階段,智譜團隊不僅完成了對話場景的人類偏好對齊,還運用拒絕采樣和強化學習等先進技術,重點提升了模型在指令理解、工程代碼生成、函數調用等關鍵任務上的能力,從而顯著增強了智能體執行任務的核心素質。

實際測試表明,GLM-4-32B-0414在工程代碼編寫、Artifacts生成、函數調用、搜索問答及報告撰寫等多個應用場景均展現出色表現。

部分基準測試指標已達到或超越 GPT-4o、DeepSeek-V3-0324(671B)等更大規模模型的水平。

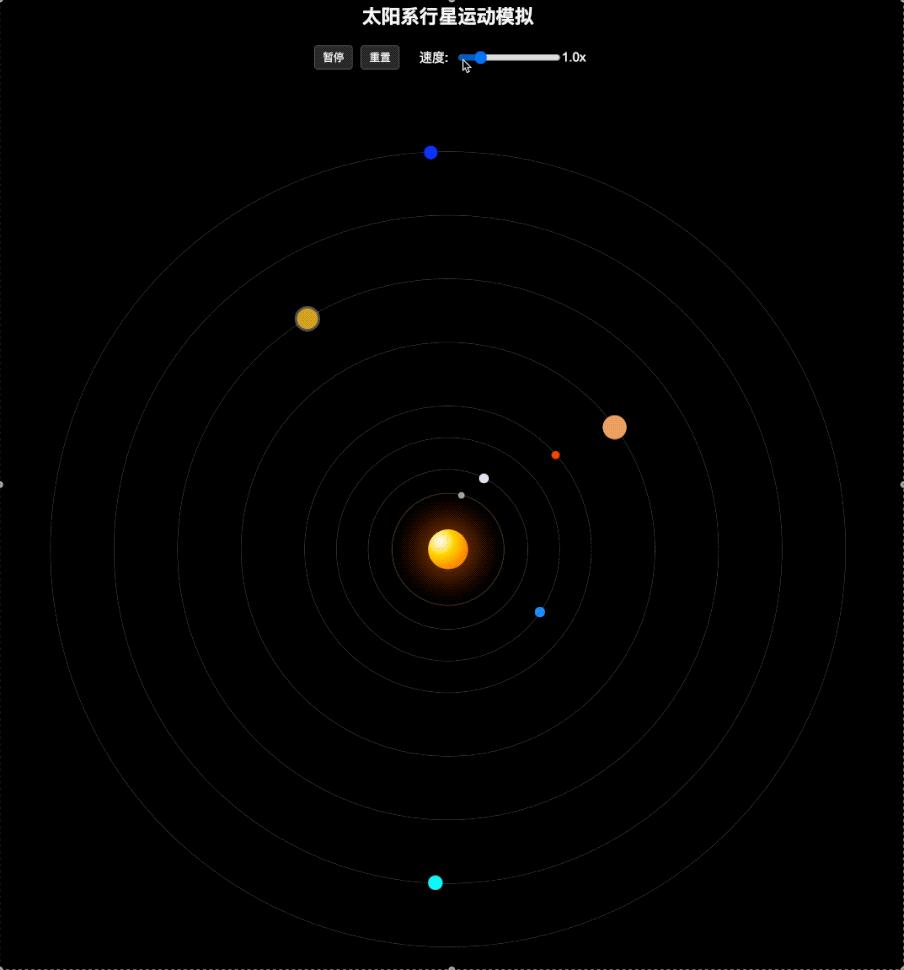

從實測效果來看,GLM-4-32B-0414進一步提升了代碼生成能力,可處理並生成結構更複雜的單文件代碼。

例如來上這麼一段Prompt:

用HTML模擬太陽系的行星運動。

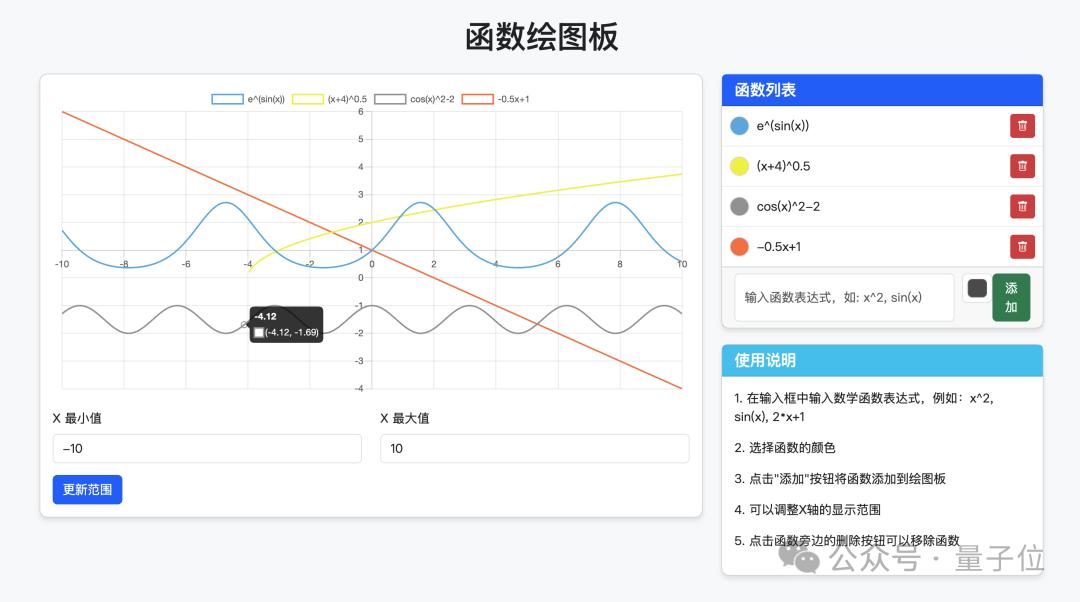

再如:

設計一個支持自定義函數繪製的繪圖板,可以添加和刪除自定義函數,並為函數指定顏色。

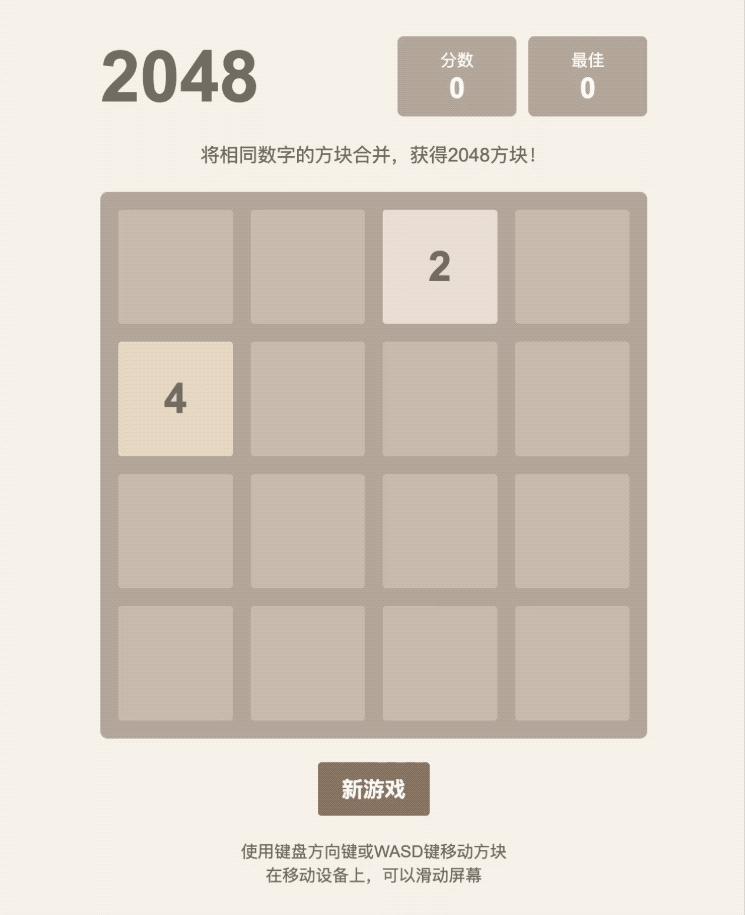

以及設計一個小遊戲也是不在話下:

用HTML網頁實現2048小遊戲。

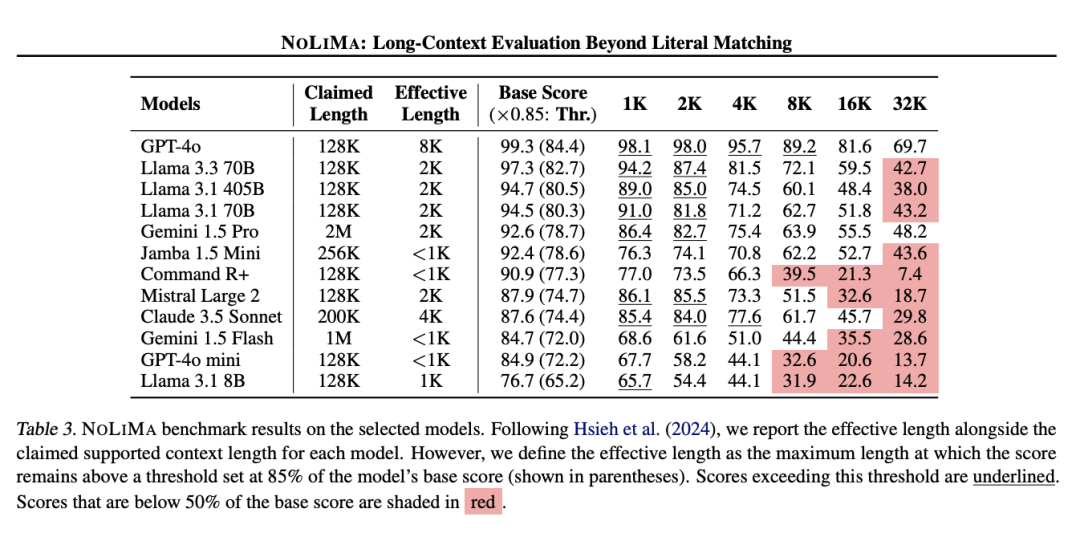

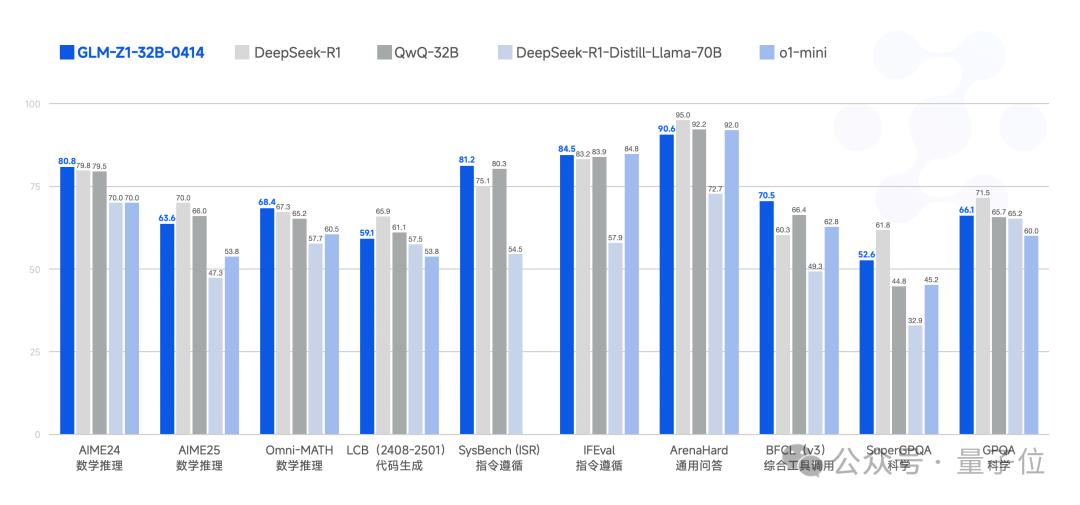

再來看下GLM-Z1-32B-0414的性能,一款專為深度推理優化的模型。

這個模型在GLM-4-32B-0414的基礎上,採用了冷啟動結合擴展強化學習的策略,並針對數學推導、代碼生成、邏輯推理等高難度任務進行了專項優化,顯著提升了複雜問題的解決能力。

此外,它還通過引入基於對戰排序反饋的通用強化學習(RLHF),模型的泛化能力得到進一步強化。

儘管僅擁有32B參數,GLM-Z1-32B-0414在部分任務上的表現已可媲美 671B 參數的DeepSeek-R1。

在AIME 24/25、LiveCodeBench、GPQA等權威基準測試中,該模型展現出卓越的數理推理能力,能夠高效應對更廣泛、更具挑戰性的複雜任務。

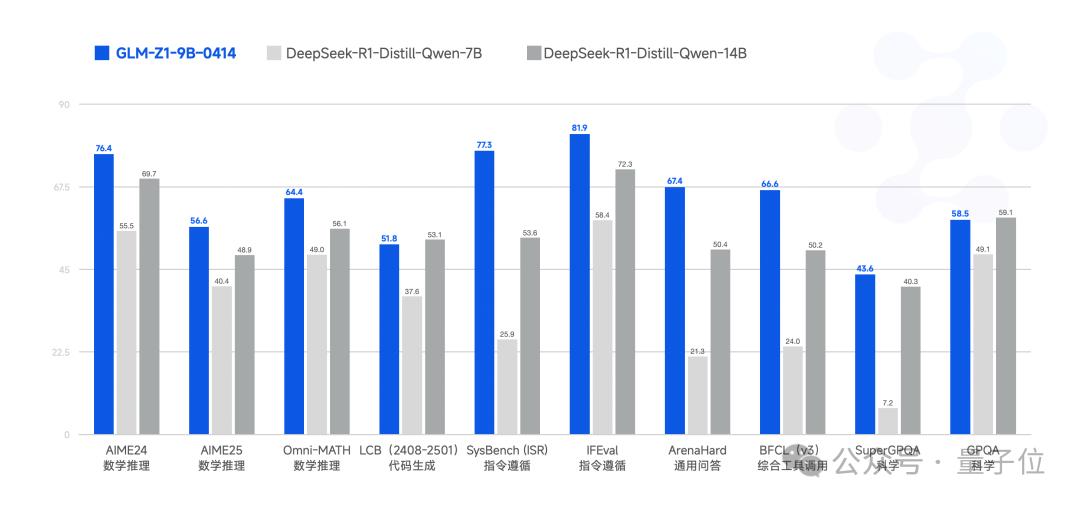

接下來,是更小規模的GLM-Z1-9B-0414,在技術上是沿用了上述模型的方法。

雖然只有9B大小,但它在數學推理及通用任務上展現出超越參數規模的卓越性能,綜合表現穩居同量級開源模型前列。

尤其值得關注的是,在資源受限的應用場景中,該模型能夠高效平衡計算效率與推理質量,為輕量化AI部署提供了極具競爭力的解決方案。

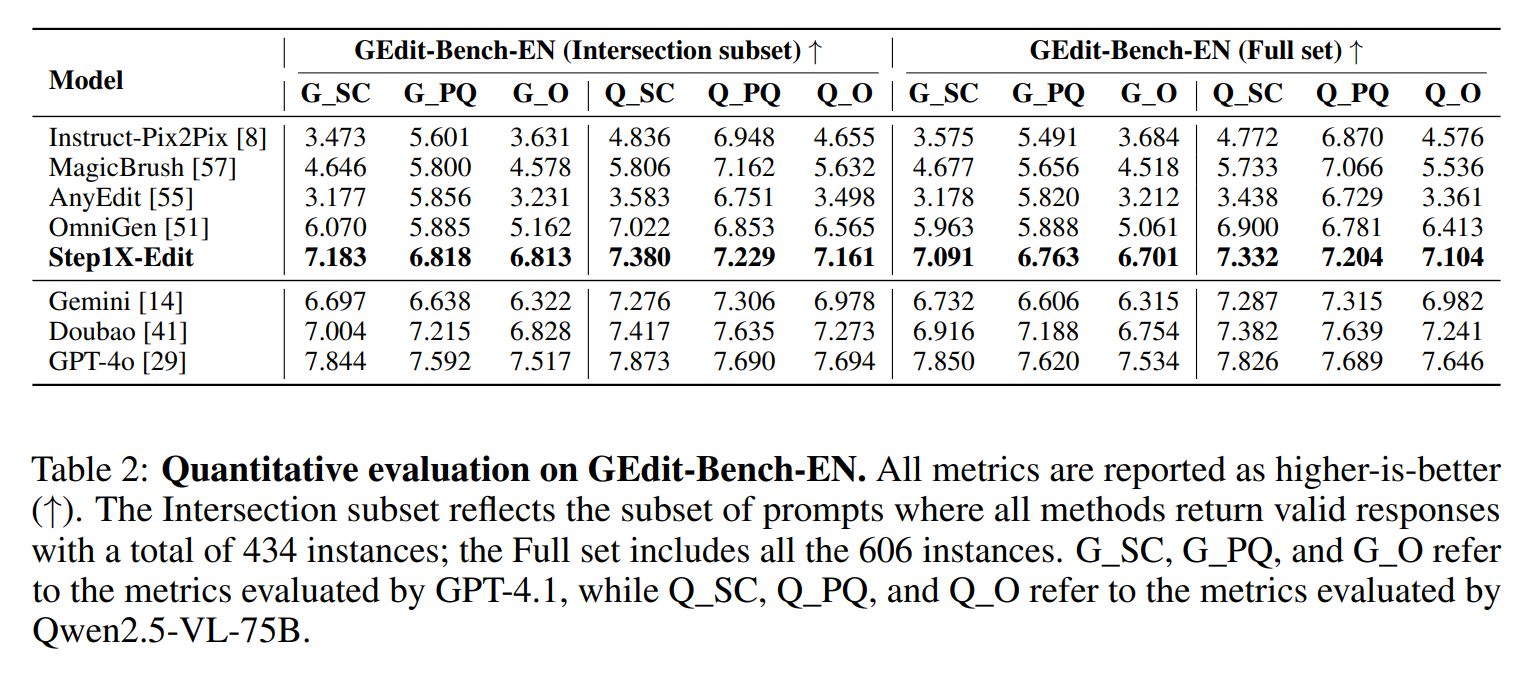

最後,再來看下沉思模型GLM-Z1-Rumination-32B-0414。

這個模型可以說是智譜對AGI未來形態的一個探索。

沉思模型採用與傳統推理模型截然不同的工作範式,通過多步深度思考機制有效應對高度開放性和複雜性問題。

其核心突破體現在三個方面:

在深度推理過程中智能調用搜索工具處理複雜子任務;

創新性地引入多維度規則獎勵體系,實現端到端強化學習的精準引導與擴展;

完整支持」問題發現→信息檢索→邏輯分析→任務解決」的研究閉環系統。

這些技術創新使該模型在學術寫作、深度研究等需要複雜認知能力的任務上展現出顯著優勢。

例如讓它回答一個科學假設推演問題:

如果人類在火星地下發現液態湖泊中存在類似地球古菌的微生物,請推測:(1) 這些微生物可能如何適應極端環境?(2) 這一發現對‘生命起源泛種論’的支持/反駁證據有哪些?(3) 設計一個可驗證這些假說的空間實驗方案(預算限制5億美元)。

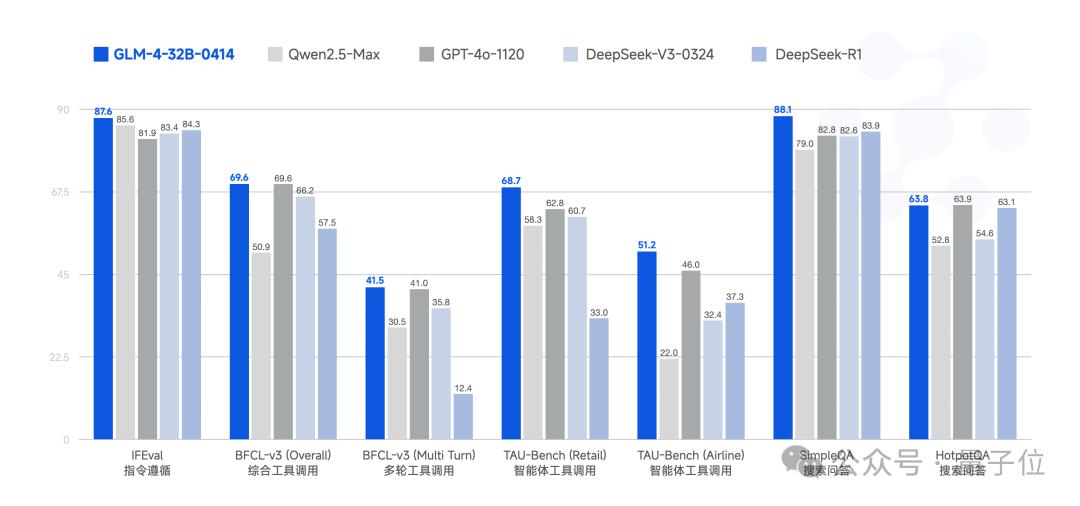

再看價格

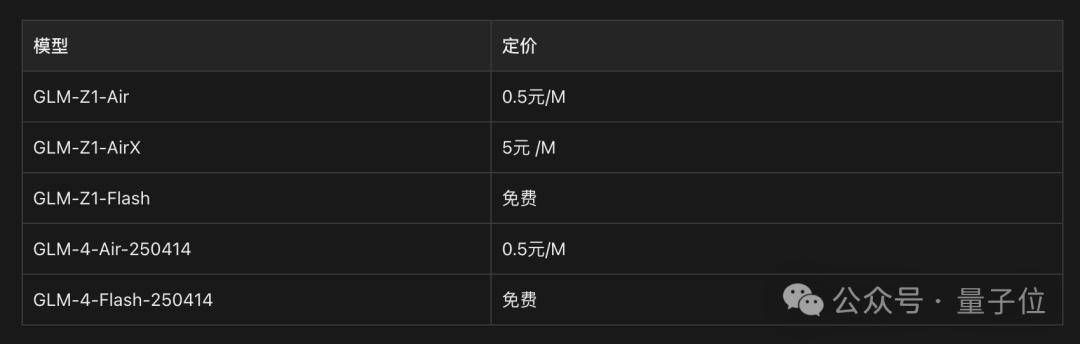

除模型開源外,基座、推理兩類模型也已同步上線智譜MaaS開放平台(bigmodel.cn),面向企業與開發者提供API服務。

本次上線的基座模型提供兩個版本:GLM-4-Air-250414和GLM-4-Flash-250414,其中GLM-4-Flash-250414完全免費。

上線的推理模型分為三個版本,分別滿足不同場景需求:

GLM-Z1-AirX(極速版):定位國內最快推理模型,推理速度可達 200 tokens/秒,比常規快 8 倍;

GLM-Z1-Air(高性價比版):價格僅為 DeepSeek-R1 的 1/30,適合高頻調用場景;

GLM-Z1-Flash(免費版):支持免費使用,旨在進一步降低模型使用門檻。

為了更加一目瞭然,價格表如下:

至於配置方面,32B基礎模型、32B推理模型、32B沉思模型(裸模型)的要求如下:

1張H100 / A100或者更先進的NVIDIA旗艦顯卡

4張4090/5090/3090

One More Thing

除了上述內容之外,智譜這次還有一個亮點的動作——

拿下一個頂級域名Z.ai!

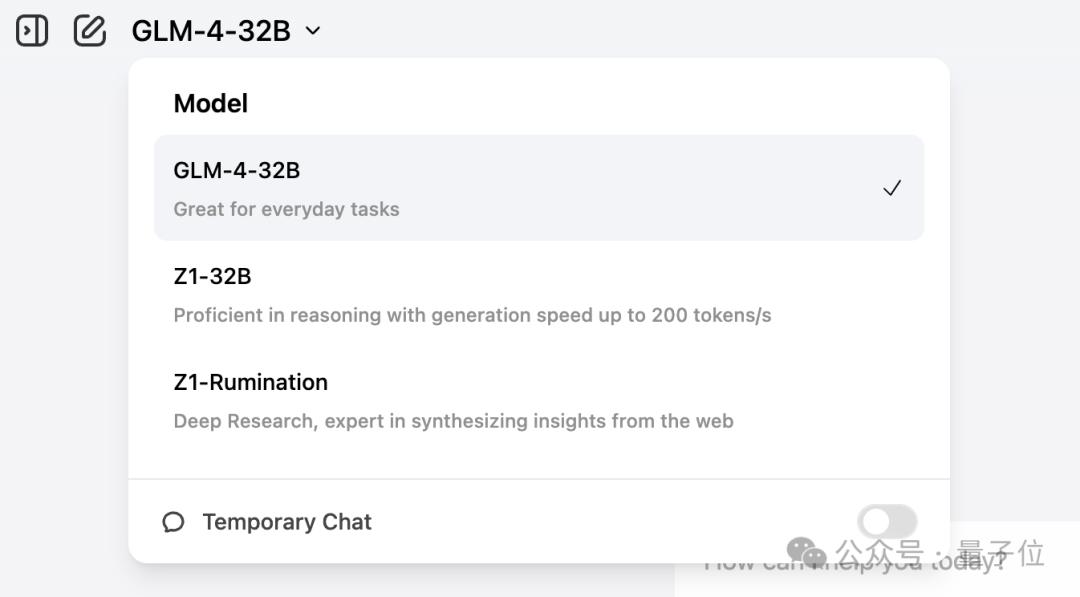

目前已經上線了下面三款模型:

而且官方還亮出了一個比較有意思的slogan:

最後,縱觀智譜在大模型時代的發展,不得不感慨其更新迭代以及開源的速度。

這樣難怪它能成為第一家正式啟動IPO流程的「大模型六小龍」。

體驗地址:z.ai

本文來自微信公眾號「量子位」,作者:金磊,36氪經授權發佈。