上海交大顧磊磊團隊新突破:AI讓視障人士「重獲光明」,研究登上Nature子刊

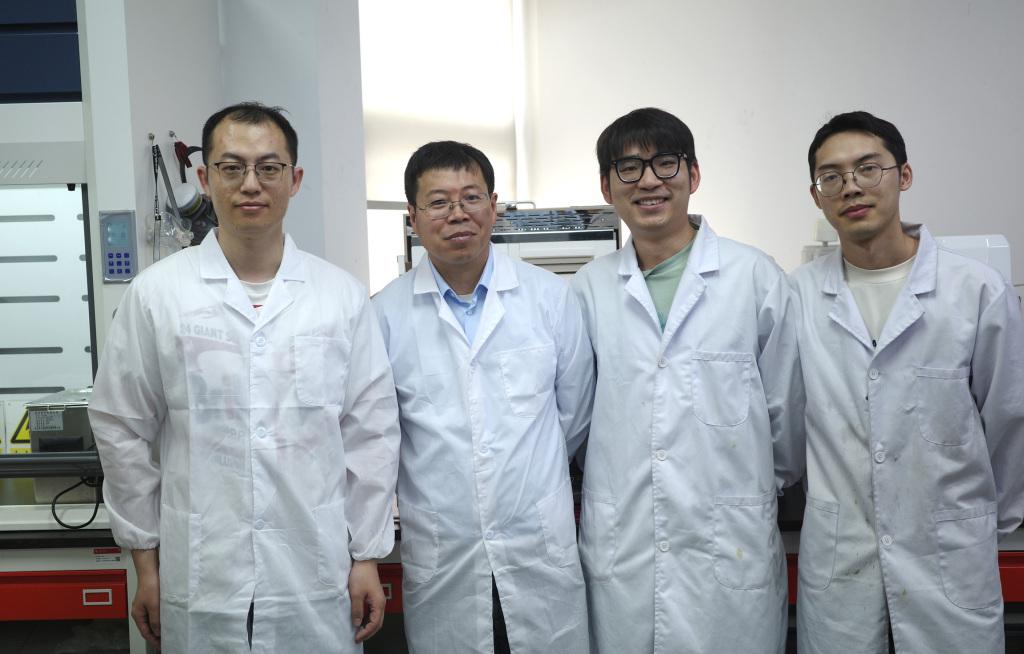

圖|顧磊磊(左二)和部分實驗室成員。

圖|顧磊磊(左二)和部分實驗室成員。 據世界衛生組織(WHO)2019 年發佈的《世界視力報告》顯示,全球約有 22 億人患有視力障礙,其中至少 10 億人的視力障礙本可預防或尚待解決。

視力障礙和失明不僅影響著世界各地人們的正常生活,還給全球帶來了巨大財政負擔,據估計每年造成的全球生產力損失高達 4110 億美元。

對於盲人和部分視障人士而言,可穿戴電子視覺輔助系統有助於維持他們的日常生活,但當前這類設備的人類適應性還不夠,無法大規模推廣。

如今,上海交通大學計算機學院清源研究院長聘教軌副教授、博士生導師顧磊磊團隊及其合作團隊,有望使用一種由 AI 驅動的可穿戴助盲系統幫助更多視障人士「重獲光明」。

圖|攝像頭目前安裝在眼鏡上,但該團隊正在努力使這些設備更輕便、更隱蔽。

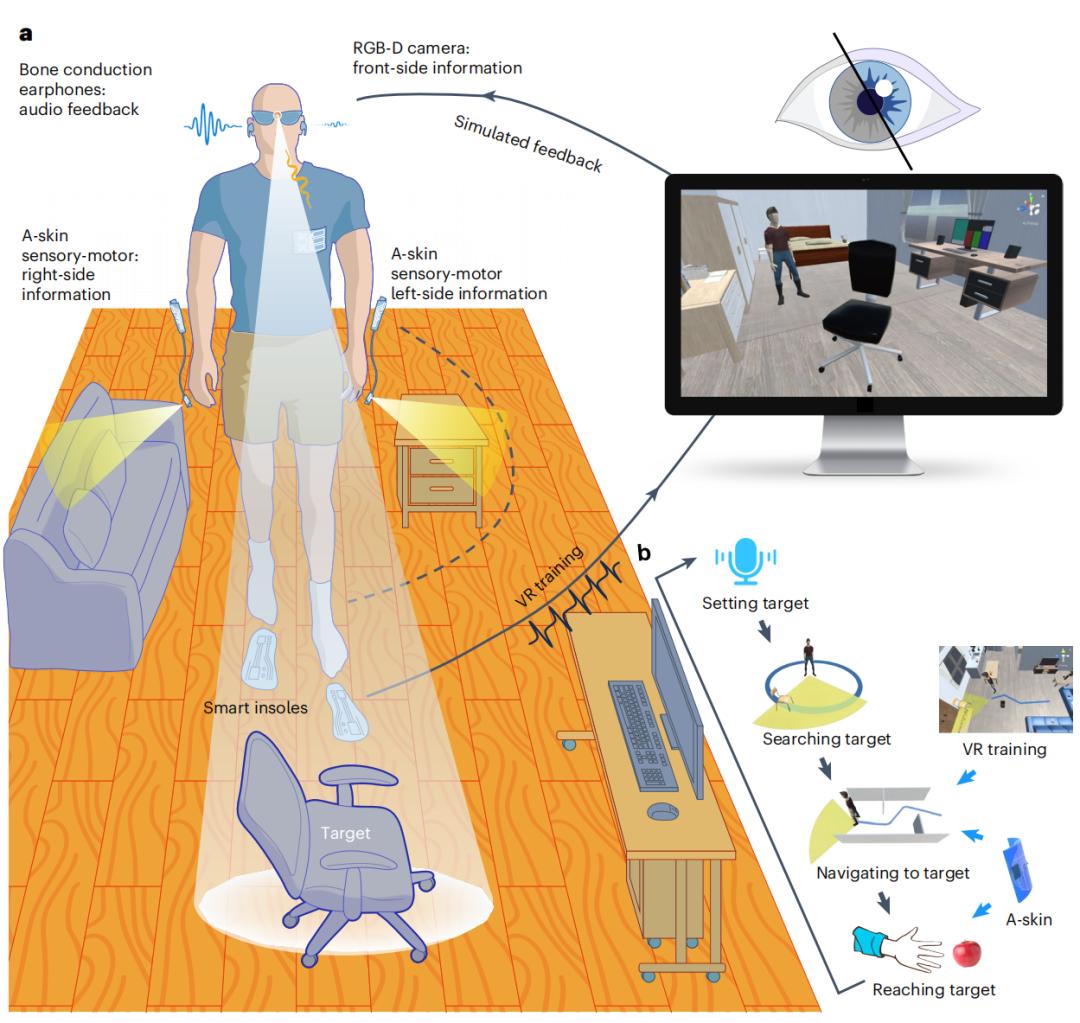

圖|攝像頭目前安裝在眼鏡上,但該團隊正在努力使這些設備更輕便、更隱蔽。據介紹,這是一套融合柔性電子和 AI 的穿戴助盲系統,以聽覺觸覺取代部分視覺,幫助盲人完成行動及抓取的日常任務。硬件上通過結構和功能設計儘可能實現輕、薄、美;軟件上優化系統的信息輸出方式,使其符合人類生理的聽覺觸覺以及大腦的認知方式,目標是使人像調用自己的器官一樣輕鬆使用外部系統;同時開發了基於VR 的沉浸式虛實結合的訓練系統,促進人機融合。

經過人形機器人以及盲人和部分視力障礙者在虛擬和真實環境中的測試,他們發現受試者在導航和導航後任務中的表現顯著提升,例如能在穿過迷宮時避開障礙物,以及拿取和抓住某個物體。

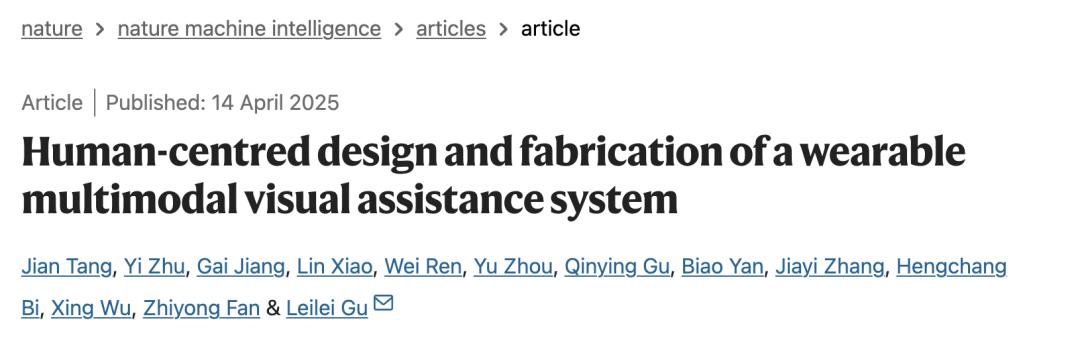

相關研究論文以「Human-centred design and fabrication of a wearable multimodal visual assistance system」為題,已發表在國際權威科學期刊 Nature Machine Intelligence 上。

論文鏈接:https://www.nature.com/articles/s42256-025-01018-6

論文鏈接:https://www.nature.com/articles/s42256-025-01018-6研究團隊表示,這款以人為本的可穿戴式視覺輔助系統,既能滿足視障者的獨特需求,又能確保將身體和認知壓力降至最低。該系統的音頻和觸覺組件的集成提供了有效的視覺支持,個性化算法和輕量級硬件為用戶友好型可穿戴視覺輔助系統提供了啟示。

AI 是如何為視障人士指路的?

為視障人士開發人工視覺是人類長期以來的追求。

可穿戴式電子視覺輔助系統為視力受損者或視障人士提供了一種前景廣闊的解決方案,為醫療和植入假肢提供了一種替代方案。這些設備不能恢復自然視力,而是通過將環境信息轉換成其他感官模式並輸入大腦來補償視力損失,從而協助完成日常任務。

先進的系統已使視障人士能夠執行基本的視覺功能,如導航、識別和尋找放錯的鑰匙等複雜任務。儘管這些技術的功能不斷髮展,但尚未在視障人士群體中得到廣泛應用。使用過程中的認知和體力負荷,以及使用前所需的複雜培訓過程,導致了採用率有限。

為解決上述問題,顧磊磊團隊提出了一種旨在提高視障者獨立生活能力的可穿戴視覺輔助系統。該系統可將視覺輸入轉化為音頻和觸覺反饋,確保高精確度、低延遲和對不同環境的適應性。

直觀的空間提示聽覺輸出和導航算法,有助於減輕認知負擔;A-skin 的獨特設計和放置有助於在惡劣環境中完成導航和導航後任務;虛擬現實(VR)訓練有助於快速、安全地進行訓練;基於摩擦發電的智能鞋墊則能夠以最低的功耗實現虛擬世界和現實世界的同步運動。

圖|可穿戴多模態視覺輔助系統概覽

圖|可穿戴多模態視覺輔助系統概覽整體系統硬件選用深度攝像頭 D435i(英特爾 RealSense)安裝在 3D 打印眼鏡框上。它通過 USB 與 Raspberry Pi 4 Model B 微控製器相連。所有計算均在本地進行,無需遠程服務器或其他服務。音頻提示通過無線骨傳導耳機傳送至大腦。整個系統由商用鋰離子電池供電。智能鞋墊內置三軸磁力計和摩擦電傳感器,所得角度和壓力數據分別用於估算行走步數和旋轉姿態。

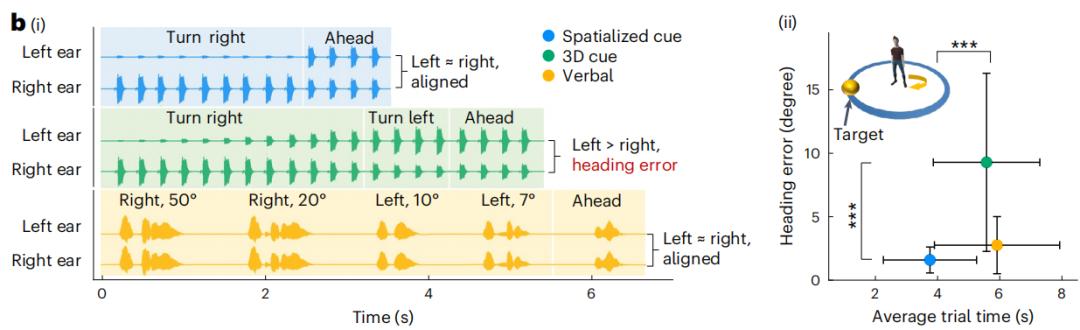

本設計通過使用生物兼容的編碼策略來傳達高級場景信息,如路徑方向的結果。他們對 12 名視障者進行了一次轉向目標實驗,以找到合適的音頻反饋。他們比較了三種反饋方法–二維空間提示音、三維立體聲和口語提示–並使用最終航向誤差和試驗時間等指標來評估其性能。

圖|音頻反饋策略比較

圖|音頻反饋策略比較在演示中,他們使用了人形機器人 TonyPi Pro,其原有頭部攝像頭被替換為 D435i,並在其操作系統中集成了與演示相關的功能模塊。

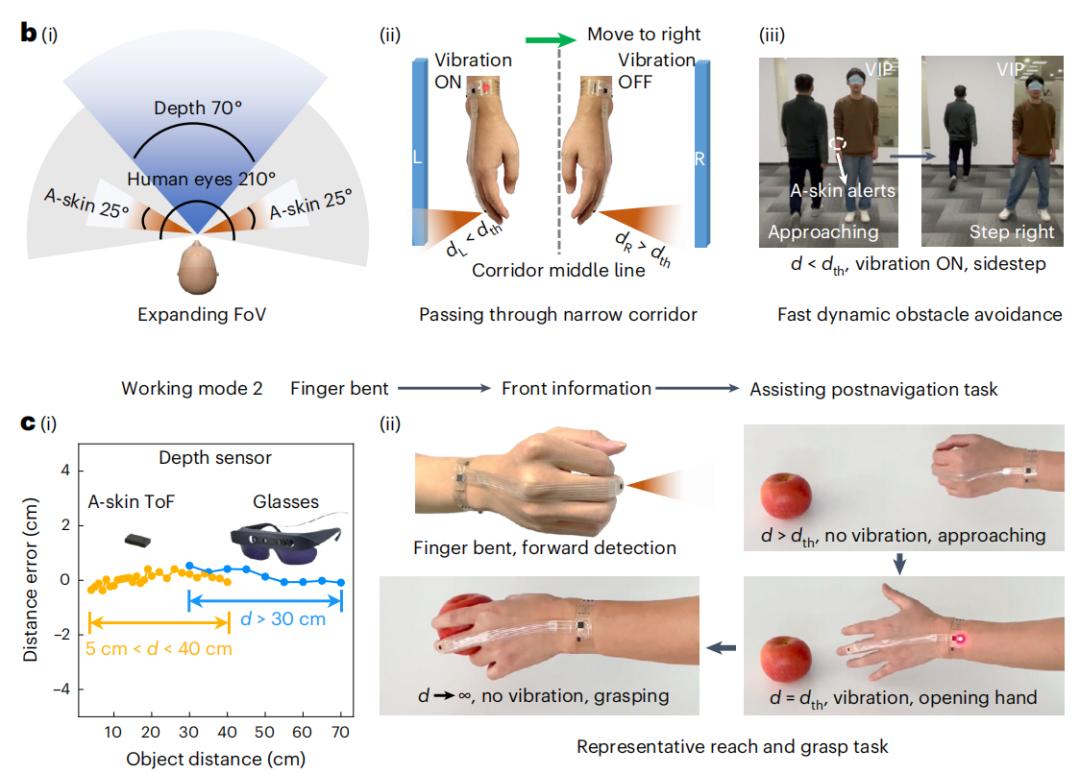

在人造皮膚的製備方面,電子元件(包括 ToF 傳感器、微控製器單元 MCU 及其他器件)通過柔性印刷電路板(FPC)工藝集成在柔性 PET 基板上。他們開發了一種可拉伸的電子皮膚,作為音頻反饋的補充。 該電子皮膚是一個集成的感官-運動裝置,通過提供近距離警報來提示是否有碰撞風險。該系統的核心部件是一個緊湊型飛行時間(ToF)傳感器。當距離小於預定閾值時,致動器就會振動以刺激皮膚。在驅動電路和皮膚之間他們特意保持了間隙,這有利於致動器的振動,同時促進兩者之間的空氣流通。這種空氣流通提高了皮膚的舒適度和透氣性,從而提高了長期佩戴性。

該電子皮膚的放置位置以經典的皮質同形體為指導,該同形體是誇張的人體圖形,說明大腦中用於控制身體各處傳感和運動的部分所佔比例。為了不影響正常運動任務的情況下實現高靈敏度,電子皮膚應放置在感覺較多但運動活動較少的區域。最終致動器和驅動電路被放置在手腕上。傳感器安裝在食指或中指的指背上,其功能根據手指的狀態(彎曲或伸直)而改變。

圖|用於高效觸覺反饋的人造皮膚感覺運動器

圖|用於高效觸覺反饋的人造皮膚感覺運動器在驅動系統設計中,PET 基板底部固定了一個薄型永磁體(厚度為 0.5 毫米,直徑為 5 毫米),而單層銅線圈(直徑同為 5 毫米)則安裝在 PET 窄帶上,二者共同構成振動單元。銅線圈通過電氣連接與 MCU 的輸出端相連。

ToF 傳感器與控制電路之間的可伸縮連接部分,則是通過材料打印機將銀顆粒打印在 PDMS(聚二甲基矽氧烷,Sylgard 184)基板上製成的。為了增強整體的柔韌性與可拉伸性,該連接區域還包覆了一層額外的 PDMS 封裝層。

在實驗者的選擇上,通過對試點研究的數據進行功率分析,估算出了視障參與者的最低人數。功率分析推薦了 9 名參與者,他們選擇了 12 名,以提供一個安全係數。他們在真實世界測試中又招募了 8 名視障人士,共有 20 名視障人士參與了實驗。參與者是隨機挑選的,來自不同的教育程度、年齡、性別和個人習慣背景。所有參與者都沒有使用過類似輔助設備的經驗,從而最大程度地減少了參與者可能已有的知識的影響。他們都被進一步蒙上了眼睛,以避免部分視障者的殘餘視力的影響。

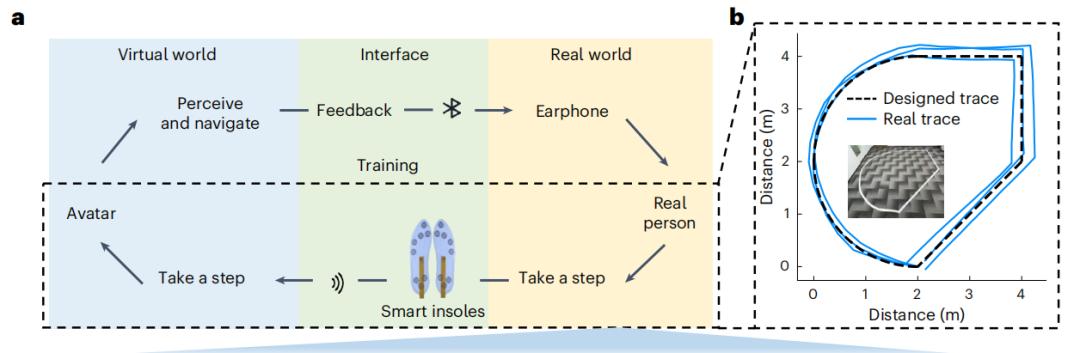

他們對參與者進行了元宇宙康復訓練和現實世界導航訓練,使用 Unity 構建虛擬環境。攝像頭和光線投射用於模擬 RGB-D 攝像頭。在前測和後測期間,他們在現實世界中建立了虛擬場景,使用可穿戴系統進行導航。為了避免場景記憶的影響,在訓練過程中,場景 1 和場景 2 隨機交替出現,並且這些場景的佈局隨機鏡像。每次訓練結束後,參與者都有 2 分鐘休息時間,在此期間可以提問和回答問題。這些措施確保了受試者不會重覆訓練完全相同的場景配置。

圖|沉浸式元宇宙訓練

圖|沉浸式元宇宙訓練為了評估訓練效果,他們設計了場景 3 進行驗證。它由一個迷宮組成,路徑總長度約為 25 米。經過場景 1 和 2 的訓練後,視障者直接進入場景 3,這是一個全新的場景,之前從未遇到過。參與者頭戴貼有標籤的帽子,超寬帶系統(UWB)以 50 Hz 的頻率記錄標籤的二維位置。用路徑總長度除以完成時間來計算平均行走速度,同時統計碰撞次數。該訓練計劃經過精心組織,以保證用戶在不過度勞累的情況下達到一致的成績水平。

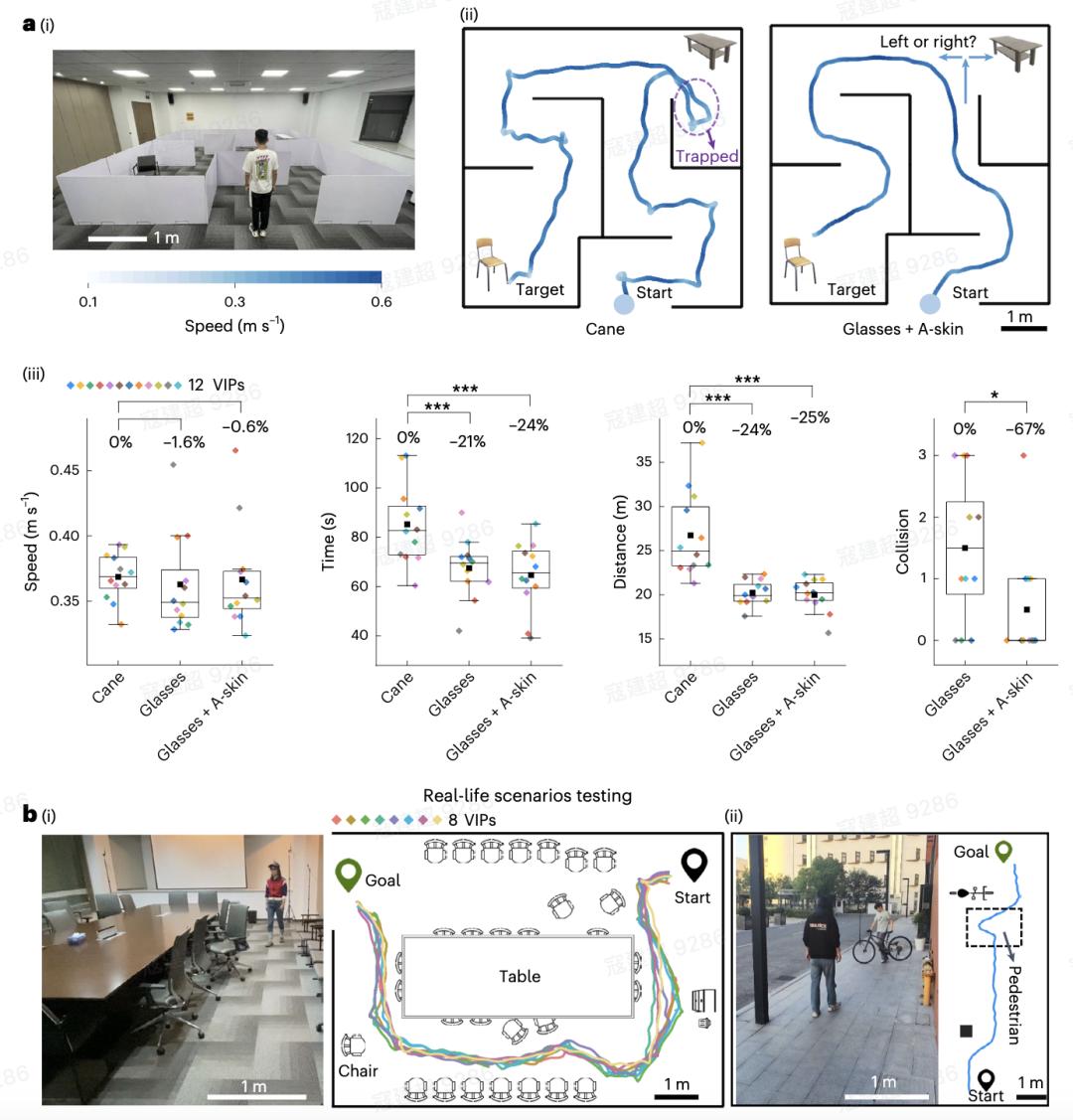

與傳統的白手杖相比,該系統轉彎更流暢,尋路效率更高。統計分析顯示,使用可穿戴系統的步行速度與使用枴杖的速度相當。導航時間和行走距離大幅減少了約 25%。加入電子皮膚後,碰撞事故明顯減少。

為了進一步評估可穿戴系統在不同真實世界環境中的影響,他們讓另外 8 名視障人士參與了 4 個不同場景的真實世界測試:室內和室外環境、靜態和動態障礙物、工作相關場景和日常生活場景,以及反映真實世界挑戰的綜合任務。這些任務的熟練完成凸顯了系統在應對現實生活挑戰方面的有效性。

圖|真實世界環境測試

圖|真實世界環境測試所有實驗結束後,視障人士完成了廣泛用於系統可用性評估的「系統可用性量表」。他們給可穿戴系統打出的平均可用性分數為 79.6 分,在 5000 個商業和研究設備中排名第 85 位。在隨後的開放式問題調查問卷中,參與者表示可穿戴系統提供了直觀的反饋和引人入勝的訓練遊戲。

研究結果表明,整合視覺、聽覺和觸覺能夠增強視力輔助系統的可用性和功能性。該系統反映了人眼的構造,將中央區域用於詳細處理,外圍區域用於監視,通過融合密集和稀疏數據處理、快速和慢速響應速度以及前端觀察能力,以最小的功耗和低延遲有效地監控了廣闊的區域。

同時,在硬件方面,該系統引入了柔性集傳感執行於一體的電子皮膚和自供電的摩擦電智能鞋墊,與傳統的剛性設備相比,具有更好的可穿戴性。

而且,該系統是一個開源平台,更廣泛、更多樣化的視障者群體的參與對於開發適合他們特定需求的導航輔助工具意義重大。

AI 助力視障人群「重獲光明」

科學家們一直致力於利用 AI 為視障人群研發補償視力損失的可穿戴設備,不僅有上述研究中視覺聽覺觸覺一體化的系統,還有和智能數據手機的避障設備。

今年 3 月,Nature 發佈了南京郵電大學通信與信息工程學院的一項研究。一副自主研發的眼鏡(重約 400 克,含約 80 克電池)和一部普通智能手機組成的可穿戴式避障設備,可以用於全面的環境感知,包括影片和深度模態,並實現了深度輔助影片壓縮模塊。

他們在智能手機上設計了一個跨模態障礙物檢測模塊,該模塊利用基於模態相關性的跨模態學習,確保可靠的檢測,並提供用戶友好的聽覺和觸覺警報。室內外多個實驗結果表明,該模塊的防撞率達到 100%,延遲小於 320 毫秒,續航時間約為 11 小時。

2023 年,由 GPT-4 提供支持的 AI 助手 Ask Envision 被設計用於輔助視障用戶。它具備多模態能力,可以接收圖像和文本,並生成對話式回應,還能夠為用戶提供更多關於周圍世界的視覺信息,並提升用戶的獨立性。

未來,隨著視覺模型、集成可穿戴電子設備、神經科學見解和個性化生成訓練環境等方面的更多進展,以及跨學科的進一步合作,AI 幫助視障人群「重獲光明」的方式還有更大的想像空間。

參考鏈接:

https://www.nature.com/articles/d41586-025-01214-9

https://www.who.int/news-room/fact-sheets/detail/blindness-and-visual-impairment

本文來自微信公眾號 「學術頭條」(ID:SciTouTiao),作者:與可,編審:學術君,36氪經授權發佈。