AI答IMO難題坦承「不會」,OpenAI:這就是自我意識

這一次,「不會」竟成了大模型的高光時刻。

雖然在IMO第6題上得了零分,OpenAI的金牌模型卻展現了「高智商的誠實」。

正如OpenAI研究員Noam Brown在最新訪談中所揭示的:

當IMO推理模型會在缺乏有效證據時表示「我不確定」,這會顯著減少隱藏錯誤。

在AI摘下IMO金牌後,OpenAI金牌小分隊成員Alex Wei、Sheryl Hsu和Noam Brown參與了紅杉資本組織的一場對話,揭秘模型攻克精英數學難題的底層突破。

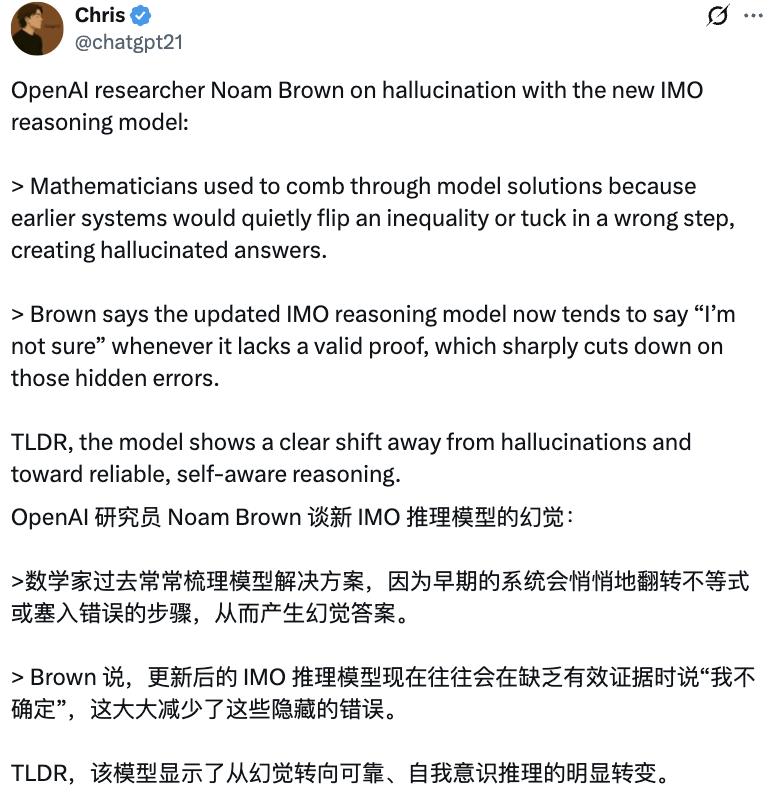

有網民幫忙總結了個太長不看版:

與過去那些「看起來完美,實則錯誤」的幻覺式答案不同,這一代大模型開始學會「承認自己不會」。

它標誌著模型正在從胡編亂造的幻覺式回答,轉向更加可靠且具有「自我認意識」的全新階段。

三位成員還在這場對話中,分享了更多關於衝刺IMO的有趣細節。

IMO金牌模型能承認自己不知道

儘管數學家與計算機科學家一致認可IMO金牌模型的價值。

但他們常常抱怨,當模型遇到知識盲區時,它總會輸出一個令人信服但錯誤的答案。

他們不得不耗費大量精力逐行驗算,才能甄別那些幻覺陷阱。

IMO第6題讓大模型全軍覆沒,當然,OpenAI也對其進行了大量計算。

有一個由2025×2025個單位正方形組成的網格。Matilda希望在網格上放置一些矩形圖塊,這些圖塊的大小不同,但每個圖塊的每一條邊都位於網格線上,並且每個單位正方形最多被一個圖塊覆蓋。

網格的每一行和每一列都恰好有一個未被任何瓷磚覆蓋的單位正方形,求出Matilda需要放置的最少瓷磚數量。

雖然投入海量算力最終僅得到一句「我無法回答」令人有些失望,但Alex Wei表示:

能看到模型避免產生幻覺是很好的。

Noam Brown也對模型的這一轉變表示讚賞,「如果它不知道,它就會承認它不知道。」

這代表模型開始具備「自我意識」。

這種「自我意識」可以幫助模型在面對困難問題時,承認自己的無能為力,而不是生成一個看似合理實則錯誤的解決方案。

有趣的是,在Alex Wei 2024年剛加入OpenAI一週時,Noam Brown就曾問過他,團隊何時能獲得IMO金牌。

當時Alex Wei認為2025年不太可能實現。

但令人驚歎的是,這個三人團隊僅用了兩月,就完成了他們一直在追求的目標——IMO金牌。

Noam Brown還表示:

OpenAI有一個很棒的地方,就是研究人員有很大的自主權去做他們認為有影響力的研究。

Alex還強調,他們的團隊「真正優先考慮通用技術」,而不是專門開發用於數學競賽的系統。

OpenAI IMO金牌核心團隊

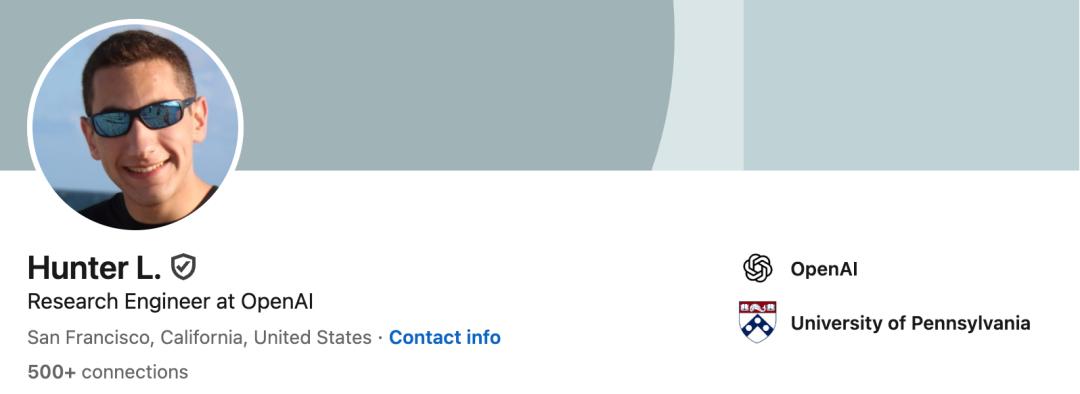

OpenAI IMO核心團隊僅由三名研究人員構成。

Alex Wei,本碩均就讀於哈佛大學,隨後在加州大學伯克利分校獲得計算機科學博士學位。

Alex還曾在Google、微軟和Meta實習,後於2024年1月加入OpenAI,現任研究科學家。他曾是FAIR團隊成員,參與開發了首個用於外交遊戲的人類級人工智能——CICERO。

Sheryl Hsu,畢業於史丹福大學計算機科學專業,是史丹福AI實驗室中IRIS實驗室的研究員,於2025年3月加入OpenAI。

Noam Brown,本科就讀於美國羅格斯紐澤西州立大學新布朗斯維克分校,隨後在卡內基·梅隆大學獲碩士和博士學位。他曾任職於DeepMind和Meta,於2023年6月加入OpenAI。

參考鏈接:

[1]https://x.com/chatgpt21/status/1950606890758476264

[2]https://www.youtube.com/watch?v=EEIPtofVe2Q

本文來自微信公眾號「量子位」,作者:關注前沿科技,36氪經授權發佈。