10分鍾被“好友”騙走430萬,AI詐騙能有多逼真?

近日,有媒體曝光了一起詐騙案件,被詐騙者遭遇AI換臉詐騙,10分鍾被“好友”騙走430萬元。近年來,AI換臉、換聲視頻在網絡上流行起來,AI合成的技術門檻逐漸降低。隨著人工智能技術的廣泛應用,一些不法分子開始利用其實施新型網絡詐騙。

AI詐騙能有多逼真?如何識別和預防AI詐騙?

網絡上的AI合成教學

從號碼到聲音,AI詐騙能有多逼真?

在家裡午睡時,王欣(化名)突然接到了母親同事的微信語音電話,對方問她現在在哪裡、在做什麼。在王欣還不知道發生了什麼的時候,她從電話裡聽到了母親的聲音,聲音聽起來很著急。雖然王欣之前和母親說好了下午會去看牙醫,母親也知道她在做什麼,但她還是接到了這樣一通詢問行程的電話。

母親告訴她,自己接到了一通號碼和王欣手機號一模一樣的來電。接通電話後,“王欣”的聲音從電話那邊傳來,母親聽到她的女兒在哭喊。電話那邊的人對母親說,王欣被他們綁架了,讓母親馬上給他們轉賬30萬元,不然就“撕票”。母親嚇壞了,立馬打算給對方轉錢,被旁邊的同事攔下,就這樣,午睡中的王欣被叫醒。

據王欣所說,“這個人還挺高明的,一開始我想,難道看不出來不是我的電話嗎?我後來看了一下,那個電話號碼就是我的手機號,連我自己都辨別不出來”。一模一樣的電話號碼瞞過了母親,神似王欣的聲音讓母親更加確信,“我媽媽說,那就是我的聲音。”母親還提到,對方一開始先詢問她身邊有沒有人,並要求她走到沒有人的地方。幸好通過微信語音電話及時確認了王欣在家,母親才放下心來。

“一年之前為了留學辦簽證,我需要提供30萬的存款證明,我第一反應就是這個。”王欣回憶起,曾和母親有過關於30萬元的對話。此外,王欣偶爾會在朋友圈和其它社交媒體上發自己的照片、視頻和聲音,身邊還有朋友喜歡在社交媒體上發類似的內容,曾在社交媒體上被冒充向身邊的人索要錢財。

此後,母親再一次收到了類似的電話。“現在,我媽媽都不太敢接我打的電話了,如果是微信電話的話還可能會接一下。”王欣說。

如何識別和預防AI詐騙?涉及資金往來應多途徑核對

中國社會科學院大學互聯網法治研究中心執行主任劉曉春認為,涉及資金往來等風險場景應多途徑核對。上海申倫律師事務所夏海龍律師表示,在AI詐騙中,獲取受害人面容及聲音素材的途徑比較多,一般是從受害人在社交媒體上分享的照片、短視頻中獲取,的確很難直接識別視頻或聲音的真假,最好的辦法就是在接到可疑電話後直接跟本人核實。

還有專家表示,在使用互聯網服務或者在社會生活中,要求輸入人臉等生物特徵數據的時候,要看對方收集生物特徵數據是不是符合《數據安全法》《個人信息保護法》的要求,是不是合法、正當和必要。

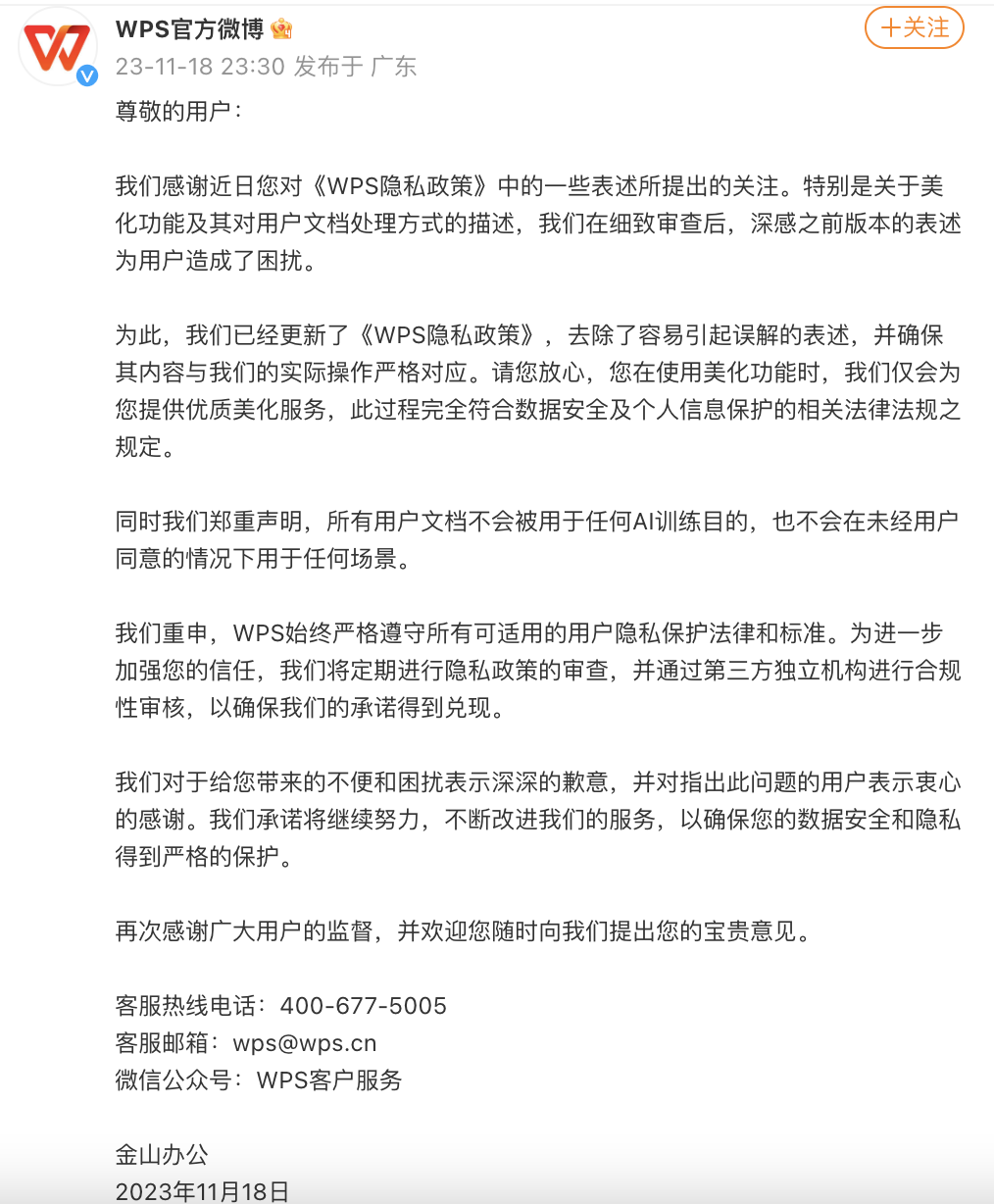

近年來,國家出台一系列規定防範AI詐騙。2022年11月,網信辦、工信部和公安部發佈的《互聯網信息服務深度合成管理規定》明確,深度合成服務提供者應當落實信息安全主體責任,建立健全用戶註冊、算法機制機理審核、科技倫理審查、信息發佈審核、數據安全、個人信息保護、反電信網絡詐騙、應急處置等管理制度,具有安全可控的技術保障措施。

今年8月開始施行的《生成式人工智能服務管理暫行辦法》規定,提供者對使用者的輸入信息和使用記錄應當依法履行保護義務,不得收集非必要個人信息,不得非法留存能夠識別使用者身份的輸入信息和使用記錄,不得非法向他人提供使用者的輸入信息和使用記錄。

針對提供深度合成服務的平台,夏海龍指出,如果侵權、違法行為由用戶個人實施,則提供相關服務的平台一般不需要承擔責任,但應履行相關法律義務,深度合成服務提供者和技術支持者提供具有生成或者編輯人臉、人聲等生物識別信息功能的模型、模板等工具的,應當依法自行或者委託專業機構開展安全評估。提供合成人聲、仿聲等語音生成或者顯著改變個人身份特徵的編輯服務可能導致公眾混淆或者誤認的,應當在生成或者編輯的信息內容的合理位置、區域進行顯著標識,向公眾提示深度合成情況。