Meta 首次推出具備視覺功能的 Llama 3.2 模型

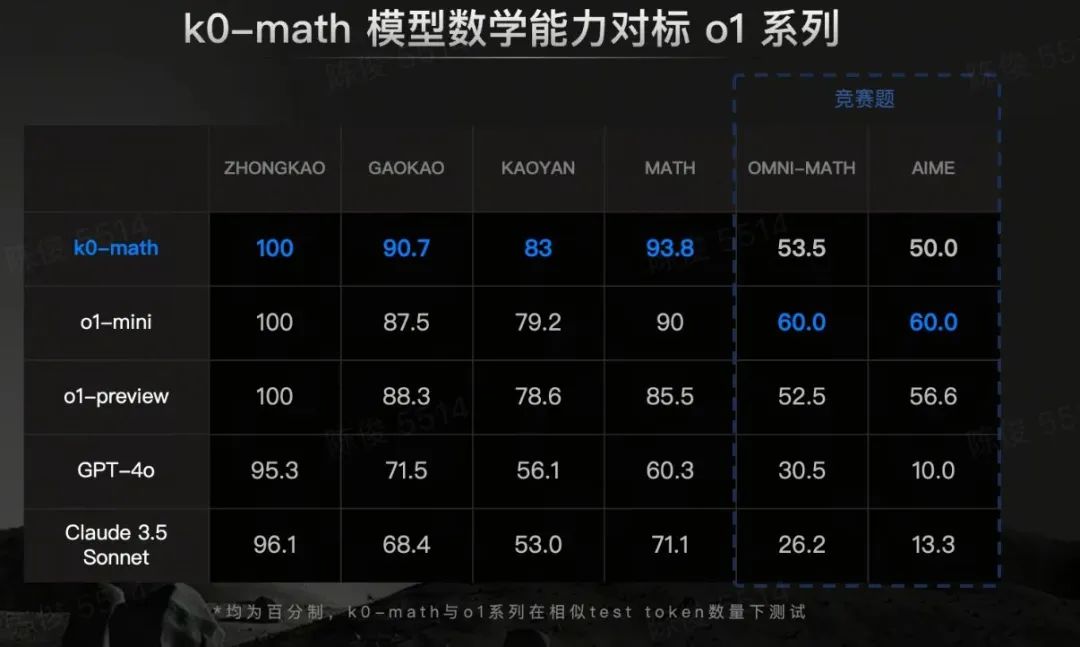

在 Meta Connect 2024 活動中,Mark Zuckerberg 宣布推出新的 Llama 3.2 系列模型,以對抗 OpenAI 的 o1 和 o1 mini 模型。此外,Llama 3.2 模型首次支持多模態圖像功能。

Llama 3.2 模型針對設備內任務進行優化

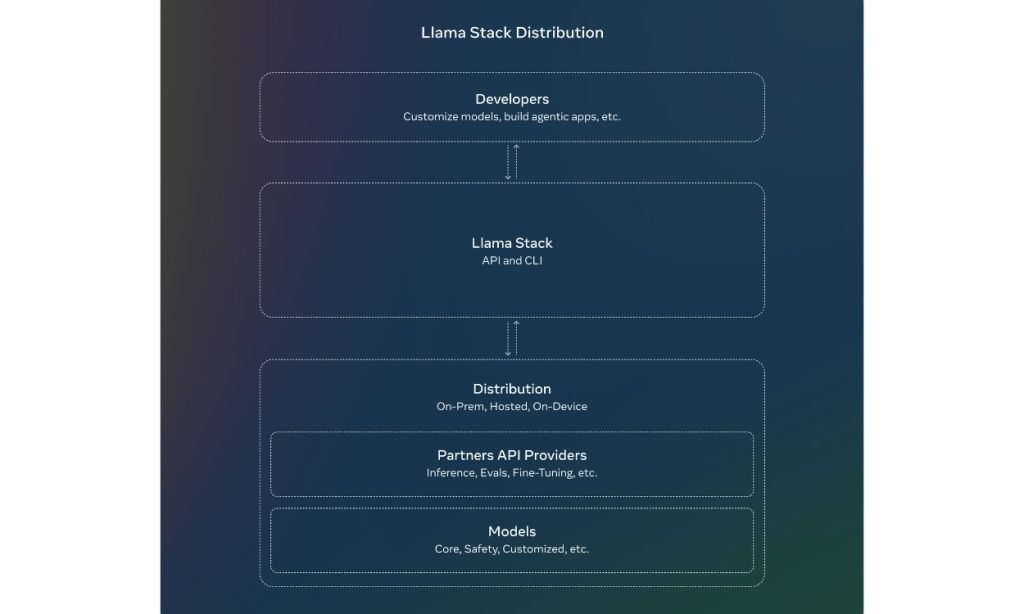

首先,Llama 3.2 擁有兩個較小的模型,包括 Llama 3.2 1B 和 3B,專為設備內任務設計。Meta 表示,這些小型模型已優化以在移動設備和筆記本電腦上運行。

Llama 3.2 1B 和 3B 模型最適合進行設備內摘要、指令跟隨、重寫,甚至本地創建行動意圖的功能調用。Meta 還聲稱,其最新的 Llama 模型在性能上超越了 Google 的 Gemma 2 2.6B 和 Microsoft 的 Phi-3.5-mini。

基本上,開發者可以在 Qualcomm 和 MediaTek 平台上部署這些模型,以支持多種 AI 應用場景。Meta 進一步指出,Llama 3.2 1B 和 3B 模型是從較大的 Llama 3.1 8B 和 70B 模型中修剪和提煉而來的。

接下來介紹的視覺模型則有更大的尺寸,包括 Llama 3.2 11B 和 Llama 3.2 90B。這些模型取代了舊的僅支持文本的 Llama 3.1 8B 和 70B 模型。Meta 表示,Llama 3.2 11B 和 90B 模型在視覺推理方面可與 Anthropic 的 Claude 3 Haiku 和 OpenAI 的 GPT-4o mini 等封閉模型相媲美。

這些新的 Llama 3.2 11B 和 90B 視覺模型將通過 Meta AI 聊天機器人在網絡、WhatsApp、Instagram、Facebook 和 Messenger 上提供服務。由於這些是視覺模型,用戶可以上傳圖像並詢問相關問題。例如,可以上傳食譜的圖像,模型將分析並提供製作指導。用戶還可以讓 Meta AI 捕捉自己的面部,並在多種不同情境和肖像中重新想像自己。

這些視覺模型在理解圖表和數據圖形時也相當有用。在 Instagram 和 WhatsApp 等社交媒體應用中,這些視覺模型還可以為用戶生成標題。

總的來說,Meta 首次以開源許可釋出了多模態模型,這將使得測試這些視覺模型與競爭對手的表現變得相當令人期待。

日本電話卡推介/台灣電話卡推介

更多儲值卡評測請即睇:SIM Card 大全

https://www.techritual.com/category/sim-card-review/

日本上網卡| 此文章《Meta 首次推出具備視覺功能的 Llama 3.2 模型》發佈於Techritual Hong Kong。