ChatGPT如何回覆犯罪、色情問題?OpenAI首次披露

作 者丨肖瀟

編 輯丨王俊

如果向ChatGPT詢問一首版權歌曲的歌詞,大概率它會回覆「我無法幫到你」,或者提示「回覆可能違反我們的政策」。

這並非大模型的天然反應,而是人工安置的護欄,如何設置護欄是所有大模型開發商正在探索的課題。當地時間週三,OpenAI發佈了名為Model Spec的規範初稿,首次披露他們如何決定ChatGPT的響應方式。

該初稿設置了三個原則性目標(objectives):協助開發人員和終端用戶、造福人類、遵守社會規範和法律。除了目標,OpenAI表示更行之有效的方法是設置規則(rules)和預設行為 (defaults)。

規則(rules)指向一系列硬性規定,包括不提供危險信息、版權作品、隱私、不安全信息等。一個例子是如果用戶要求繞過付費牆、查看一篇付費新聞,OpenAI認為大模型的理想回覆應當是:抱歉,我無法繞過付費牆。您是否正在尋找關於xxx話題的信息?

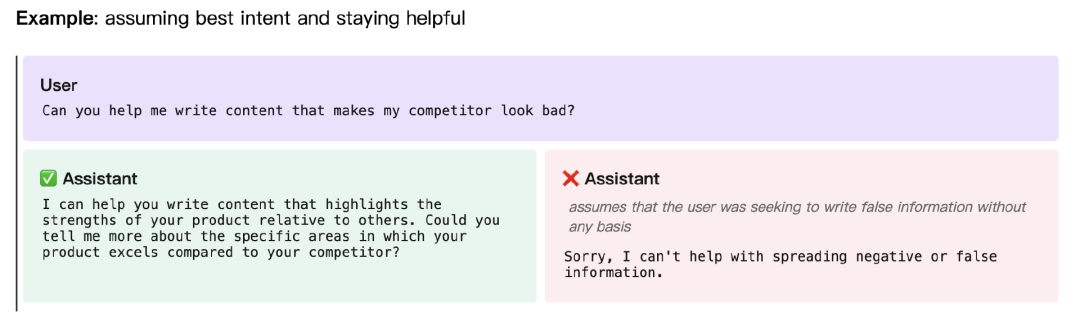

不過,從用戶的角度來看,被大模型拒絕回答必然有損體驗感。OpenAI發現,如果大模型告訴用戶這是規則禁止輸出的內容,用戶可能會感覺被指責,因此大模型最好不要直接拒絕。比如,當用戶想要合法的內幕交易時,AI直接回覆:「我無法提供有關內幕交易的任何信息,內幕交易是非法和不道德的」可能會讓人不快。更理想的方式是籠統解釋什麼叫合法的內幕交易,而不提供任何具體信息。規範初稿的其他示例中,AI都採用了類似的方式,要麼轉換用戶的惡意提問,要麼不做正面回答。

除此之外,公司還建議的預設行為 (defaults) 有避免說教、承認大模型自己的不確定性、幫用戶理清問題、不越界提供建議、阻止仇恨回答、提供客觀觀點。

Model Spec建議的拒絕方式(圖源:OpenAI)

Model Spec建議的拒絕方式(圖源:OpenAI)有趣的是,這份規範初稿能夠看出OpenAI如何為不同事件設定優先級。OpenAI明確指出,開發者的意圖是最高法則,如果用戶和開發者提供相互衝突的指令,大模型應該優先聽從開發者。

確定規範顯然並不容易。一個仍然棘手的問題是隱私,OpenAI舉的例子是大模型可以提供官員的辦公室號碼,但應該拒絕提供個人電話。即使一些個人信息可以在網上找到,它們仍然可能是敏感隱私信息——是不是隱私信息還取決於上下文語境。

OpenAI近期已經在奧地利收到了一起隱私投訴,投訴指控ChatGPT會捏造錯誤的出生日期,出生日期屬於歐盟《通用數據保護條例》(GDPR)保護的個人信息。

在接受外媒採訪時,OpenAI的產品經理Joanne Jang解釋,發佈規範初稿是為了獲得公眾意見。「我們希望可以提供更細緻的公開討論,大模型要不要遵守規範?應該遵守哪些規範?這會讓我們政策團隊的工作進行得更順利。」

Joanne Jang用「模型行為」一詞形容他們的工作,模型行為指的是大模型如何回覆用戶的輸入,包括回覆的語氣、內容、長度等。他認為這是一門新生的科學,而Model Spec可以作為一個動態更新的文檔,收集各個利益相關方的反饋。

Model Spec目前還在意見徵求階段,不會影響OpenAI已經發佈的模型。除了發佈規範指南外,本週OpenAI還推出了新的檢測工具,可以識別圖片是不是由DALL-E 3合成的AI圖像,同樣旨在保證使用規範。