Mistral AI兩連發:7B數學推理專用、Mamba2架構代碼大模型

機器之心報導

機器之心編輯部

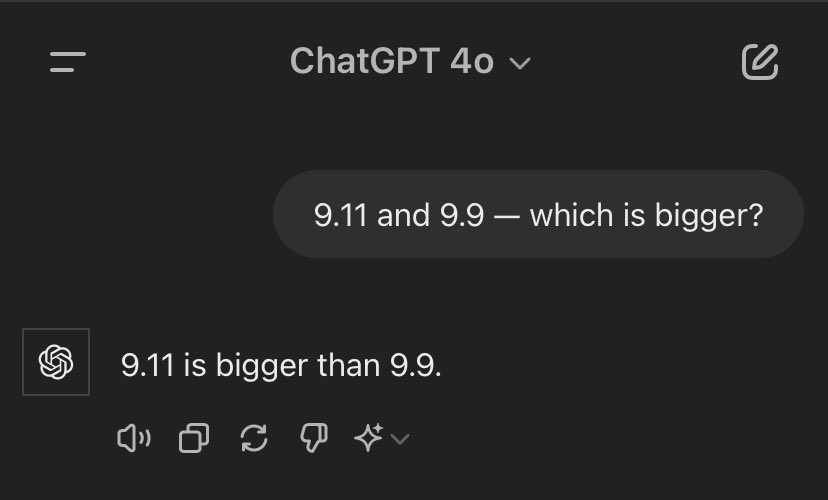

網民很好奇,Mathstral能不能搞掂「9.11和9.9誰大」這一問題。

昨天,AI圈竟然被「9.11和9.9誰大」這樣簡單的問題攻陷了,包括OpenAI GPT-4o、Google Gemini等在內的大語言模型都翻了車。

這讓我們看到,大語言模型在處理一些數字問題時並不能像人類那樣理解並給出正確的答案。

對於數字以及複雜的數學問題,專用模型更術業有專攻。

今天,法國大模型獨角獸 Mistral AI 發佈了一個專注於數學推理和科學發現的7B大模型「Mathstral」,來解決需要複雜、多步驟邏輯推理的高級數學問題。

該模型基於 Mistral 7B 構建,支持的上下文窗口長度為32k,遵循的開源協議為Apache 2.0 license。

Mathstral在構建時追求出色的性能與速度權衡,這是 Mistral AI積極推廣的一種開發理念,尤其是微調功能。

同時,Mathstral是一個指令型模型,可以使用它或者對它進行微調。模型權重已經放在了HuggingFace上。

-

模型權重:https://huggingface.co/mistralai/mathstral-7B-v0.1

下圖為 Mathstral 7B和Mistral 7B之間的MMLU性能差異(按學科劃分)。

Mathstral在各種行業標準基準上都達到其規模範圍內的 SOTA 推理性能。尤其是在MATH數據集上,它取得了 56.6%的通過率,在MMLU上取得了63.47%的通過率。

同時,Mathstral在MATH上的通過率(56.6%)比 Minerva 540B 高出 20% 以上。此外,Mathstral 在MATH 上以多數投票@64的成績得分為68.4%,使用獎勵模型的成績為 74.6%。

這一成績也讓網民好奇,Mathstral能不能搞掂「9.11和9.9誰大」這一問題。

代碼大模型:Codestral Mamba

-

模型權重:https://huggingface.co/mistralai/mamba-codestral-7B-v0.1

與Mathstral 7B一同發佈的,還有一款專門用於代碼生成的Codestral Mamba模型,使用的是Mamba2架構,同樣遵循Apache 2.0 license開源協議。這是一個指導模型,有70多億參數,研究者可以免費使用、修改和分發。

值得一提的是,Codestral Mamba是在Mamba作者Albert Gu、Tri Dao幫助下設計完成的。

一直以來,Transformer 架構撐起了AI領域的半壁江山,然而,與 Transformer 不同的是,Mamba 模型具有線性時間推理優勢,並且理論上能夠對無限長度的序列進行建模。該架構允許用戶廣泛地與模型互動,並且響應迅速,而不受輸入長度的限制。這種效率對於代碼生成尤其重要 。

在基準測試中,Codestral Mamba 在 HumanEval 測試中的表現優於競爭對手開源模型 CodeLlama 7B、CodeGemma-1.17B 和 DeepSeek。

Mistral 測試了該模型,該模型可以在 Mistral 的 la Plateforme API 上免費使用,可處理多達 256,000 個token的輸入——是 OpenAI 的 GPT-4o 的兩倍。

隨著Codestral Mamba發佈,就有網民在 VSCode中用起來了,很是絲滑。

參考鏈接:

參考鏈接:https://mistral.ai/news/mathstral/

https://mistral.ai/news/codestral-mamba/