打破生態孤島,國產異構原生AI算力工具問世,來自中科加禾

機器之心報導

作者:澤南

「通過系統優化軟件的幫助,開發的門檻會被降低,各種不同硬件會得到統一,讓技術生態得到發展。這對於當前智能生態的進步有重要的意義,」中國工程院院士、中科院計算所學術委員會主任、CCF 理事長孫凝暉在發佈會上致辭表示。「除了智能芯片、AI 行業應用以外,我們需要系統軟件優化的一方參與進來共同努力,這樣才能把國內生態做得更好。」

孫凝暉院士在發佈會上

面對算力「卡脖子」問題,我們終於迎來了系統級的解決方案。

7 月 20 日,AI 基礎設施創業公司中科加禾正式發佈了第一代異構原生 AI 算力工具。

面向當前國產算力大規模落地的趨勢,中科加禾提出的方法可以讓不同種類的芯片大規模並行,同時發揮最大效率,並讓算力的使用者無需關注不同芯片生態,做到直接拿來就用。

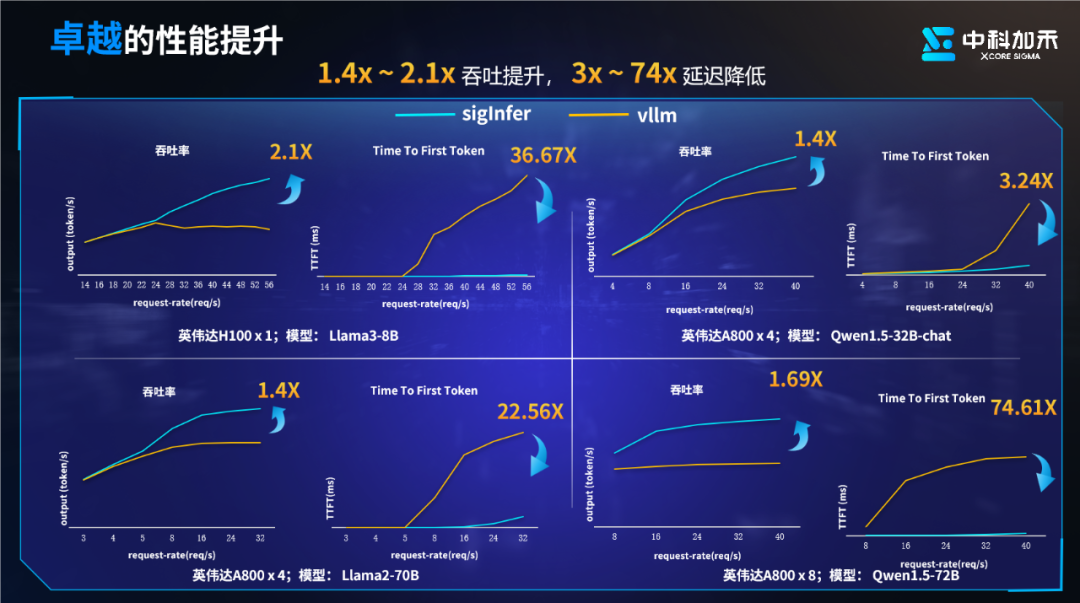

中科加禾創始人兼 CEO 崔慧敏發佈並介紹,「加禾異構原生 AI 算力工具」已經在國產算力的 AI 基礎設施上發揮一定作用。它兼容多種國產 AI 芯片,為屏蔽芯片差異提供了高性能的統一接口。在異構原生平台的基礎上,AI 算力集群在大模型推理上的時延可以降低 3-74 倍,吞吐率提升 1.4-2.1 倍,能效比提升 1.46 倍,可支持 340B 參數量的稠密大模型,以及 640B 的 MoE 大模型。

與此同時,中科加禾已實現對超過 10 家包括芯片、集成商、服務商等客戶提供高性能推理支持,其架構支持國內外主流大模型,並可以進行多樣化並行推理。

發佈會現場宣佈簽約及達成合作的算力提供、應用方夥伴包括:AMD、寶德、華為、杭州人工智能計算中心、開放傳神、摩亞線程、青雲科技、Rise VAST、燧原科技、無問芯穹、雲西算力、新華三等(按拚音首字母順序排序)。

中科加禾創始人、CEO 崔慧敏在發佈會上

異構原生 AI 算力,目標實現「三零一高」

中科加禾提出的方案,目標是讓 AI 大模型應用在不同芯片上實現零成本遷移,零損耗使用,零延遲部署的高效使用。

這套軟件工具包含異構原生大模型推理引擎「SigInfer」、異構原生微調引擎「SigFT」以及算子自動生成、轉譯工具「SigTrans」三款產品。

其中,昨天發佈的 SigInfer 是一款跨平台、高性能的異構原生推理引擎,不但支持服務器級的 AI 加速卡,還支持消費級 GPU。因此,它既可以部署於數據中心,也可以為各種端側設備實現加速。

作為異構計算的技術底座,通過 SigInfer 接入的不同 AI 算力,可以做到調用接口統一,平滑遷移業務應用。SigInfer 會在調用多種不同算力的同時進行多層次深度優化,充分挖掘芯片算力的潛能。

它具備現代大模型推理引擎所具備的各種特徵,如支持 API Serving、請求調度、Batch 管理、KV Cache 優化、張量並行、流水線並行、專家並行、甚至多機流水並行等能力。

中科加禾表示,SigInfer 已經支持了業界大部分的大模型結構。

目前,SigInfer 已經可以實現完備的推理引擎能力。其支持的異構加速卡集群可以靈活調度英偉達 AI 加速卡 + 國產 AI 加速卡進行混合推理,最高可擴展至萬億級的大模型。

使用 SigInfer 幫助 AI 芯片部署可以在業務訪問需求提升時,讓大模型服務保持較高的吞吐率和較低的時延,對於生成式 AI 的大規模應用來說,這些指標至關重要。

在同樣使用英偉達顯卡的情況下,我們可以看到 SigInfer 能提供較明顯的加速效果:

再進一步,使用國產芯片完成同類任務時,SigInfer 可以同樣提升並行計算時 AI 加速卡的吞吐率,同時大幅降低輸出 Token 的延遲。

異構原生 AI 算力工具可以根據大模型任務處理的不同階段、算子特徵、優化目標自適應優化等方式調整 AI 加速器的計算頻率,從而實現高效率。中科加禾給我們算了一筆賬,數據中心運營的過程中,使用 A800 加 SigInfer,相比 vllm 能效比可以提升 46%。

除了對雲基礎設施實施優化以外,中科加禾還展示了對於端側推理的性能優化。SigInfer 可以加速基於英特爾、高通、AMD 等大廠的芯片設備,相比業界主流部署方案,SigInfer 在端側推理的效率最高可以提升 5 倍。

在異構計算和效率提升的背後,是一系列前沿技術和工程的應用與優化。

為了提升並行計算的效率,中科加禾引入了一系列優化。例如深入解碼階段的訪存優化,讓 KV Cache 可以得到寄存器級別的複用,相比從 L2 加載,延遲和帶寬都得到了優化。

同時,為了緩解並行度的減少,中科加禾的研究人員在數據的 sequence 維度上也進行了並行劃分。結合 KV Cache 的複用優化,既節約了訪存,又增加了並行度,讓整個注意力機制的核心計算提高了執行效率。

中科加禾也探索了異構算力的高性能算子生成方法。通過與算力廠商合作,中科加禾把 cutlass 遷移到了國產芯片架構上,大幅提升了矩陣乘法的運行效率。在這其中,該公司通過結合編譯技術的優化實現了超過 20% 的性能提升。

在一系列技術的加持下,加禾異構原生 AI 算力工具實現了卓越的能效優化。

從編譯技術出發:中科加禾的技術路線

與以往一些 AI 算力基礎設施公司提供的能力不同,中科加禾提供的異構計算與加速,是圍繞編譯技術展開的。

對於計算機而言,編譯層所做的工作是「翻譯」,它負責把人類編寫的高級編程語言內容轉化成機器理解並能執行的語言。

在這個過程中,編譯還需要進行優化,即提高生成出來的機器代碼的運行效率。對於芯片性能而言,編譯發揮作用的範圍很大,但時常被人忽略。

在目前業內最流行的英偉達芯片上,CUDA 計算平台發揮了重要作用。它包含編程語言、編譯器、各種高性能加速庫及 AI 框架,可以在計算機執行任務時充當分配者的角色,充分利用不同硬件的算力資源,讓複雜的代碼模型跑得更快。可以說如今的 AI 生態,很大程度上就是建立在 CUDA 之上的。

對於國產算力而言,為了實現大規模應用,就需要構建其需要的生態和能力。

在生成式 AI 時代,人們對於算力的需求推動了芯片技術的發展,然而新的挑戰也已顯現:

-

從芯片公司的角度來看,生態也呈現多元碎片化發展,這會帶來開發成本增加以及落地效率和兼容性等問題。

-

從行業發展的角度來看,AI 技術正快速發展,其覆蓋越來越多的場景,意味著更多種類的算力將會參與其中,這就進一步推動了異構計算的需求。

因此,業界迫切需要一套能夠支持多種國產芯片的高效工具鏈。如果能夠出現一套通用化、低成本、高性能的基礎軟件,並可以幫助生態夥伴快速移植基於英偉達生態開發的應用程序,就可以充分發揮出國產芯片的潛力,帶動技術研發的步伐,從而逐步構建立起 AI 算力生態的正循環。

這就是中科加禾一直在做的事。

中科加禾提供的基礎軟件平台層,定位於算子、編譯、框架層幾個位置,在硬件和軟件之間架設了一座橋樑。其提供的異構原生 AI 算力工具可以幫助用戶平穩遷移 AI 模型和芯片架構,這就給 AI 應用帶來了極大的便利性。

這些層面的能力都涉及了編譯技術。AI 編譯覆蓋的範圍既包含圖層,也包含算子層,相對傳統編譯器在語義轉換上的跨度更大。例如,AI 編譯器一般要考慮計算圖劃分、子圖融合、並行計算、數據分塊等。這些都是較難解決的問題。

在這方面,中科加禾完成了大量研究,如在 Tensor 表達式層級做全局數據流分析,構建精確的計算圖和數據依賴圖,進而打破算子邊界進行算子融合,取得了很好的效果。在一些網絡上,其方法取得了相對於業界先進水平多達 3.7 倍的加速比。相關工作成果發表在今年的計算機領域頂級會議上。

構建端到端的算力使能解決方案,助力繁榮國產 AI 生態

中科加禾成立於 2023 年 7 月,團隊主要來自於中科院計算所。創始人崔慧敏畢業於清華大學計算機系,是中科院計算所編譯團隊負責人。該公司的核心團隊具備超過 20 年的編譯器研發經驗,曾作為核心成員主持或參與過多款國產芯片的編譯器研發工作。

自成立以來,該公司聚焦於芯片編譯與優化技術,致力於提供通用化、低成本、高性能的算力資源,以「聚芯片之合力,築國產之生態」為使命。目前,中科加禾已收穫了多輪共計近億元融資。

中科加禾正在圍繞三條路線打造系列產品,包括支持異構算力的 AI 大模型推理引擎、大模型微調框架、以及 AI 編譯工具套件。它們既可以幫助算力使用方快速使用多元化的 AI 算力,也可以幫助算力供應方完善軟件生態以及提升競爭力,補齊了國產 AI 算力生態的一塊重要拚圖。

更重要的是,中科加禾希望能成為一個「溝通」的橋樑,連接數量龐大的算力使用方和算力提供方,使雙方能愉快的雙向奔赴,從而推動異構原生 AI 算力的大規模應用和國產 AI 生態的蓬勃發展貢獻力量。