通義千問開源數學模型 Qwen2-Math,數學能力超越 GPT-4o

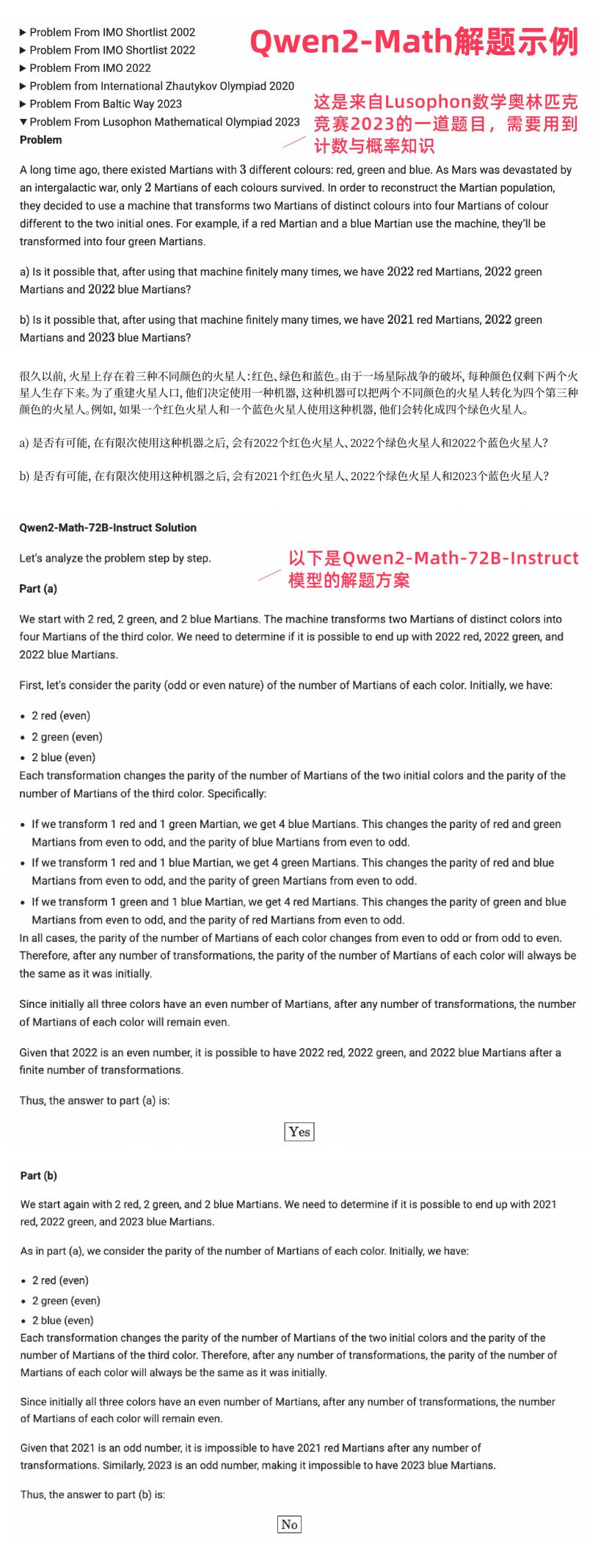

8 月 9 日消息,阿裡通義團隊開源新一代數學模型 Qwen2-Math,包含 1.5B、7B、72B 三個參數的基礎模型和指令微調模型。Qwen2-Math 基於通義千問開源大語言模型 Qwen2 研發,旗艦模型 Qwen2-Math-72B-Instruct 在權威測評集 MATH 上的得分超越 GPT-4o、Claude-3.5-Sonnet、Gemini-1.5-Pro、Llama-3.1-405B 等,以 84% 的準確率處理了代數、幾何、計數與概率、數論等多種數學問題,成為最先進的數學專項模型。

註:在 MATH 基準測評中,通義千問數學模型的旗艦款 Qwen2-Math-72B-Instruct 取得了 84% 的準確率,超過 GPT-4o、Claude-3.5-Sonnet、Gemini-1.5-Pro 和 Llama-3.1-405B 等開閉源模型。

Qwen2-Math 基礎模型使用 Qwen2 大語言模型進行初始化,並在精心設計的數學專用語料庫上進行預訓練,訓練數據包含大規模高質量的數學網絡文本、書籍、代碼、考試題目,以及由 Qwen2 模型合成的數學預訓練數據。所有預訓練和微調數據集都進行了去汙染處理。

隨後,研發團隊訓練了指令微調版本模型:首先,基於 Qwen2-Math-72B 訓練一個數學專用的獎勵模型;接著,將密集的獎勵信號與指示模型是否正確回答問題的二元信號結合,用作學習標籤,再通過拒絕采樣構建監督微調(SFT)數據;最後在 SFT 模型基礎上使用 GRPO 方法優化模型。

據悉,Qwen2-Math 系列模型目前主要支持英文,通義團隊很快就將推出中英雙語版本,多語言版本也在開發中。

通義團隊在多個中英文數學基準測評集對指令微調模型作了性能評估,除了 GSM8K 和 MATH 等常

見的測評基準,還引入了更具挑戰性的考試競賽類測試,如奧林匹克級別的基準測評 OlympiadBench、大學數學級別的基準測評 CollegeMath、高考(GaoKao)、美國數學邀請賽(AIME)2024 賽題、美國數學競賽(AMC)2023 賽題,中文測評則有 CMATH 測評集、2024 年中國高考和中考數學題。最終,Qwen2-Math-72B-Instruct 表現優異,在十大測評中都獲得了遠超其他開源數學模型的成績。

註:研發團隊在 greedy 和 RM@8 的條件下對模型作了測評,表中為每款 Qwen2-Math-72B-Instruct 模型列出了三個得分結果,分別是第 1 次回答得分(無下標數字)、8 次回答中出現最多次數的答案的得分,8 次回答中 reward model 所選答案的得分。

「大模型能不能做數學題」,不僅是社交平台的熱門話題,也是業界非常關注的研究課題。處理高級數學問題,需要模型具備複雜多步邏輯推理能力。通義團隊在技術博客中表示,希望通過開源「為科學界解決高級數學問題做出貢獻」,未來將持續增強模型數學能力。

附:Qwen2-Math 解題示例