時序=圖像?無需微調,視覺MAE跨界比肩最強時序預測大模型

AIxiv專欄是機器之心發佈學術、技術內容的欄目。過去數年,機器之心AIxiv專欄接收報導了2000多篇內容,覆蓋全球各大高校與企業的頂級實驗室,有效促進了學術交流與傳播。如果您有優秀的工作想要分享,歡迎投稿或者聯繫報導。投稿郵箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

本文第一作者陳謀祥是浙江大學計算機四年級博士生,研究方向為時間序列預測、LLM 代碼生成和無偏排序學習。通訊作者劉成昊是 Salesforce 亞洲研究院高級科學家,曾提出時序預測基礎模型 Moirai。該工作由浙江大學、道富科技和 Salesforce 共同完成。

機器之心曾在兩個月前報導過,大語言模型(LLM)用於時序預測真的不行,連推理能力都沒用到。近期,浙大和 Salesforce 學者進一步發現:語言模型或許幫助有限,但是圖像模型能夠有效地遷移到時序預測領域。

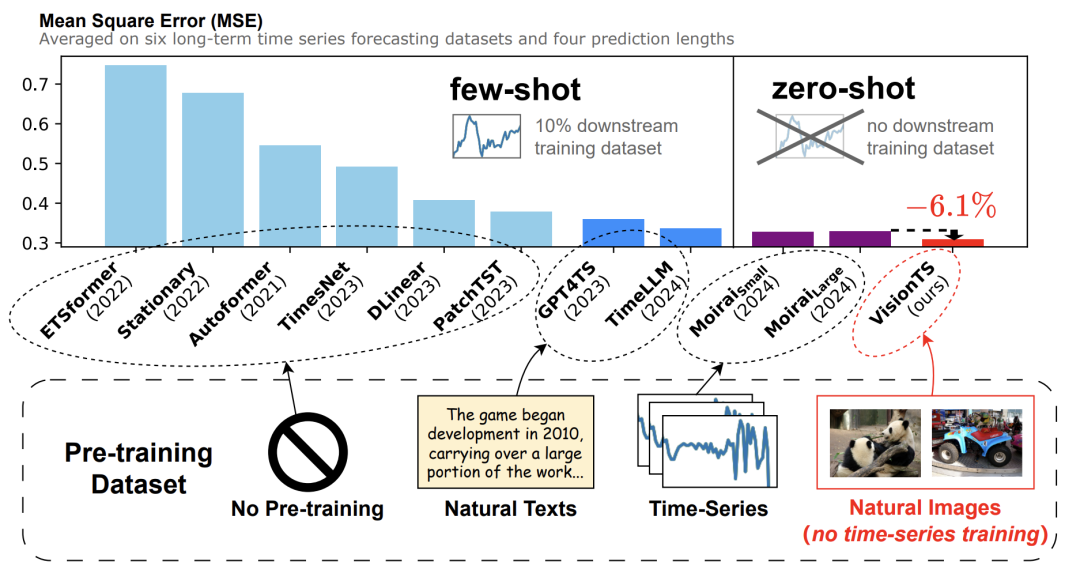

他們提出的 VisionTS 時序預測框架,基於何愷明的代表作 ——MAE 模型。VisionTS僅從自然圖像(ImageNet)中預訓練而無需時間序列微調,即可直接跨界比肩(甚至超越)一眾強大的時序預測基礎模型,如 Moirai 和 TimesFM 等,而這些基礎模型均使用了大量時間序列數據預訓練。

這篇論文證明了:計算機視覺和時間序列這兩個看似風馬牛不相及的領域,可能具有密切聯繫。其實,這也符合人類的習慣:我們很難從一串數字序列直接看出規律,但如果將其轉成一張時序趨勢圖,就能更容易地從中看出圖片變化的規律。

-

論文題目:VisionTS: Visual Masked Autoencoders Are Free-Lunch Zero-Shot Time Series Forecasters

-

論文地址:https://arxiv.org/abs/2408.17253

-

代碼倉庫:https://github.com/Keytoyze/VisionTS

圖一:VisionTS 無需時序數據微調,即可在零樣本情況下超越最大的時序基礎模型 Moirai。

近年來,預訓練基礎模型(Foundation Models)已經促進了自然語言處理(NLP)和計算機視覺(CV)領域的變革。通過在大量數據上進行預訓練,這些模型在各種下遊任務中表現出色,甚至在沒有見過的數據上也能很好地完成任務。

這種趨勢正在推動時間序列預測發生重大變化,從傳統的「單數據集訓練單模型」 轉向「通用預測」,即採用一個預訓練模型來處理不同領域的預測任務。

目前,訓練能夠通用預測的時序預測基礎模型有兩條主要研究路徑。第一條路徑是嘗試把已經在文本數據上訓練好的 LLM 應用於時間序列預測任務。然而,由於這兩種數據模式之間存在顯著差異,這種語言與時序之間的可遷移性最近受到了一些質疑。

第二條路徑是從零開始收集大量來自不同領域的時間序列大數據集,直接訓練一個基礎模型(如 Moirai,TimesFM 等)。然而,不同領域的時間序列數據之間在長度、頻率、維度和語義上有很大差異,這限制了他們之間的遷移效果。到目前為止,構建高質量的時間序列數據集仍然充滿挑戰,處於探索階段。

在本文中,論文作者提出了創新的第三條路徑:用預訓練好的視覺模型來構建時序預測基礎模型。這是因為圖像中的像素變化可以自然地看作是時間序列。這一序列和現實中的時序數據有許多相似的特點:

1.相似的形式:圖像和時序都是連續的,而語言是離散的。

2.相似的起源:圖像和時序是自然信號,源於對真實世界物理現象的觀測結果,而語言是人類創造的。

3.相似的信息密度:圖像和時間序列通常包含大量冗餘數據,而語言的密度更高。

4.相似的時序特徵:圖像中常見的許多特徵也在真實世界的時間序列數據中出現,而這些特徵在語言中很少見,如下圖所示。

圖二:ImageNet 上的一張圖片:像素變化序列經常呈現出現實世界時間序列的特點,如趨勢性(Trend)、週期性(Seasonality)和穩定性(Stationarity)。

基於這些見解,該論文希望回答這樣一個問題:一個在圖像上已經訓練好的視覺模型,能否直接作為通用時間序列預測的基礎模型,一站式加入午餐豪華大禮包?

方法:基於何愷明的視覺 MAE

來預測時間序列

圖三:VisionTS 架構。

該論文基於提示學習(prompt learning)的思想,將時間序列預測任務重構為 MAE 預訓練使用的塊級圖像補全任務。思路很簡單:將時間序列的歷史窗口轉變為可見的圖像塊(visible patches),預測窗口轉變為被遮擋的圖像塊(masked patches),如圖三所示。

1.分割(Segmentation)

對於一個長度為 L 的輸入序列窗口,第一個目標是將其轉換為二維矩陣。首先將其分割成 L/P 個長度為 P 的子序列,其中 P 是週期長度(如果時間序列沒有明顯的週期性,可以直接設置 P=1)。接著,這些子序列被堆疊成一個二維矩陣,形狀 (P, L/P)。

2.標準化(Normalization)

MAE 會對輸入進行標準化。因此,該論文提出標準化二維矩陣,將其轉變為標準差為 0.4 左右的數據。

3.渲染(Render)

眾所周知,每個圖像有三個通道。該論文簡單地將歸一化後的矩陣渲染為灰度圖像,也就是三個通道都相同。

4.對齊(Alignment)

考慮到預訓練時圖像的大小可能與這一矩陣大小不匹配,該論文提出將圖像的尺寸從原始的 (P, L/P) 調整為適合 MAE 輸入的尺寸。論文作者選擇雙線性插值來調整尺寸。

5.重建與預測(Reconstruction & Forecasting)

在得到 MAE 重建的圖像後,可以簡單地逆轉之前的步驟來進行預測。具體來說,論文作者選擇將重建的整個圖像重新調整回時間序列的分段,然後提取出預測窗口。

實驗效果

測試結果顯示,VisionTS 在涵蓋多個領域的35個基準數據集上表現出色,涉及時序預測的各種場景。

下表展示了部分數據,其中 VisionTS 在無需時序數據微調的情況下,能夠驚人地達到最佳預測性能。零樣本情況下,能夠比肩甚至超越 Moirai(一個在 27B 通用時序數據上訓練的時序大模型),甚至超越了少樣本訓練的 LLM(TimeLLM 和 GPT4TS)以及其他常用的時序預測模型。

這些結果顯示,圖像→時間序列的遷移能力要強於文本→時間序列,甚至與不同時序數據領域之間的相互遷移能力相當。

下圖展示了 VisionTS 的一個預測樣例,包括輸入圖像(a)、重建圖像(b)以及對應的預測曲線(c)。可以發現,VisionTS 恰當地捕捉了這一數據的週期性和趨勢性,而 Moirai 和 Seasonal Naïve 忽略了趨勢性。

更多研究細節,可參考原論文。