一塊顯卡理解一部電影,最新超長影片理解大模型出爐,「大海撈針」準確率近95%,代碼已開源

僅需1塊80G顯卡,大模型理解小時級超長影片。

智源研究院聯合上海交通大學、中國人民大學、北京大學和北京郵電大學等多所高校帶來最新成果超長影片理解大模型Video-XL。

它借助語言模型(LLM)的原生能力對長視覺序列進行壓縮,不僅保留了短影片理解的能力,而且在長影片理解上展現了出色的泛化能力。

相較於同等參數規模的模型,Video-XL在多個主流長影片理解基準評測的多項任務中排名第一。

而且在效率與性能之間實現了良好的平衡,僅需一塊80G顯存的顯卡即可處理2048幀輸入(對小時級長度影片采樣),並在影片「海中撈針」任務中取得了接近95%的準確率。

△圖一:不同長影片模型在單塊80G顯卡上支持的最大幀數及在Video-MME上的表現

△圖一:不同長影片模型在單塊80G顯卡上支持的最大幀數及在Video-MME上的表現要知道,長影片理解是多模態大模型的核心能力之一,也是邁向通用人工智能(AGI)的關鍵一步。

然而,現有的多模態大模型在處理10分鐘以上的超長影片時,仍然面臨性能差和效率低的雙重挑戰。

Video-XL正是為此而來,模型代碼均已開源。

僅需幾秒鍾,VideoXL便可以準確檢索長影片中植入的廣告內容(https://github.com/VectorSpaceLab/Video-XL/tree/main/examples),也可以像人類一樣準確理解電影中發生的主要事件。本影片僅用於學術研究,如有問題,請隨時聯繫。

未來,它有望在電影摘要、影片異常檢測、廣告植入檢測等應用場景中展現出廣泛的應用價值,成為得力的長影片理解助手。

超長影片理解難平衡性能和效率

使用MLLM進行長影片理解具有極大的研究和應用前景。然而,當前的影片理解模型往往只能處理較短的影片,無法處理十分鐘以上的影片。

儘管最近研究社區出現了一些長影片理解模型,但這些工作主要存在以下問題:

壓縮視覺token帶來的信息損失:為了使語言模型的固定窗口長度適應長影片帶來的大量視覺token,眾多方法嘗試設計機制對視覺token進行壓縮,例如LLaMA-VID主要降低token的數量,而MovieChat, MALMM則設計memory模塊對幀信息進行壓縮。然而,壓縮視覺信息不可避免帶來信息的損失和性能降低。

性能和效率的不平衡:相關工作LongVA嘗試finetune語言模型擴大其上下文窗口,併成功將短影片理解能力泛化到了長影片上。LongVila優化了長影片訓練的開銷,提出了高效訓練長影片訓練的範式。然而,這些工作並未考慮推理時影片幀數增加帶來的計算開銷。

建立統一視覺編碼機制

模型結構

△

△如圖二所示,Video-XL的整體模型結構和主流的MLLMs結構相似,由視覺編碼器(CLIP), 視覺-語言映射器(2-layer MLP)以及語言模型(Qwen-7B)構成。

特別之處在於,為了處理各種格式的多模態數據(單圖,多圖和影片),Video-XL建立了一個統一的視覺編碼機制。

針對多圖和影片數據,將每幀分別輸入CLIP;針對單圖,將其劃分為多個圖像塊,並將圖像塊輸入CLIP進行編碼。因此,一個N幀的影片或者一個N圖像塊的圖片都將統一標記成 N × M 視覺tokens。

視覺上下文隱空間壓縮

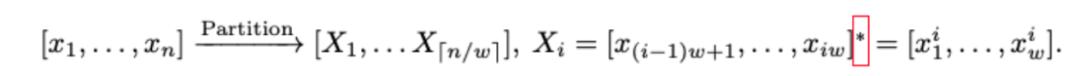

相比於以往長影片模型直接對視覺token壓縮,Video-XL嘗試利用語言模型對上下文的建模能力對長視覺序列進行無損壓縮。對於視覺語言連接器輸出的視覺信號序列:

其中n為視覺token的數量。Video-XL的目標在於將X壓縮成更為緊湊的視覺表示C (|C| < |X|)。在下文中將詳細介紹視覺上下文隱空間壓縮的原理。

受到Activation Beacon的啟發,Video-XL引入了一種新的特殊標記,稱為視覺摘要標記(VST),記為 。基於此可以將視覺信號的隱層特徵壓縮到VST在LLM中的激活表示中(每層的Key和Value值)。具體而言,首先將視覺信號序列X分成大小為w的窗口(預設每個窗口長度為1440):

接著,對每個窗口首先確定壓縮比,並插入一組VST標記,以交替的方式在視覺標記序列中插入。在該過程中,視覺token表示的變化可以由以下公式表達:

LLM將逐個處理每個窗口進行編碼,並使用額外的投影矩陣在每層自注意力模塊中處理VST的隱藏值。編碼完成後,普通視覺標記的激活值被丟棄,而VST的激活值被保留並累積,作為處理後續窗口時的視覺信號代理。

模型訓練方式

Video-XL通過優化在壓縮視覺信號下的生成質量來進行訓練。下一個Token的預測通過以下公式進行計算:

其中,θ代表模型所有優化的參數,包含語言模型,視覺編碼器、視覺語言連接器、VST的投影矩陣,以及VST的token embedding。模型通過最小化標準的自回歸損失進行訓練,訓練過程中不計算VST標記的損失(其標籤設為-100),因為它們僅用於壓縮。同時,為了靈活支持不同的壓縮粒度,訓練時每個窗口的壓縮比會從{2,4,8,12,16}中隨機抽取。在推理時,可以根據具體的效率需求選擇一個壓縮比並應用於所有窗口。

模型訓練數據

在預訓練階段,Video-XL使用Laion-2M數據集優化視覺語言連接器。在微調階段,Video-XL充分利用了MLLM在各種多模態數據集上的能力。對於單圖像數據,使用了Bunny 695k和Sharegpt-4o的57k張圖片。對於多圖像數據,使用了從MMDU提取的5k個數據。對於影片數據,收集了不同時長的影片樣本,包括來自NExT-QA的32k樣本,Sharegpt-4o的2k影片樣本,CinePile的10k樣本以及11k個帶有GPT-4V影片字幕註釋的私有數據。

為了增強長影片理解能力並釋放視覺壓縮機制的潛力,本工作開發了一個自動化的長影片數據生產流程,並創建了一個高質量數據集——視覺線索順序數據(VICO)。該流程首先從CinePile數據或YouTube等影片平台獲取長影片,涵蓋電影、紀錄片、遊戲、體育等開放領域的內容。每個長影片被分割成14秒的片段。對於每個片段,本工作使用VILA-1.5 40B模型生成詳細描述。這些描述包括動作序列和關鍵事件,基於這些字幕,本工作利用ChatGPT將線索按時間順序排列。VICO數據集通過要求模型檢索關鍵幀並檢測時間變化,提升其長影片理解能力。

單項任務超越GPT-4o

(一)評測基準

Video-XL選用多個主流影片理解評測基準,對於長影片理解任務,評測了VNBench, LongVideoBench, MLVU和Video-MME;對於短影片理解任務,評測了MVBench和Next-QA。

(二)評測結果

1、長影片理解:

△

△ △

△如表一,表二所示Video-XL在多個主流的長影片評測基準上展現了卓越性能。其中在VNBench上準確率超過了目前最好的長影片模型大約10%。

在MLVU的驗證集上,僅僅具有7B參數的Video-XL甚至在單項選擇任務上超越了GPT-4o模型。而在Video-MME和LongVideoBench等數據集上,Video-XL也在同等量級規模的長影片理解模型中排名第一。

2、超長影片理解:

Video-XL通過進行了影片「大海撈針」測試來評估其處理超長上下文的能力。LLaVA-NexT-Video和LongLLaVA都採用了簡單的位置信息外推算法,但在輸入更多上下文時,仍然難以理解關鍵信息。

雖然LongVA通過微調LLM來處理更長的輸入,但高昂的計算成本限制了其在單塊80G GPU上處理約400幀的能力。相比之下,Video-XL在相同硬件條件下,以16倍壓縮比和2048幀輸入,達到了近95%的準確率。這表明,Video-XL在準確性和計算效率之間實現了最佳平衡。

3、短影片理解:

儘管Video-XL的設計主要面向長影片,但它保留了短影片理解的能力。在MVBench和Next-QA任務評測中,Video-XL取得了和目前SOTA模型相當的效果。

(三)消融實驗

△

△Video-XL對所提出的視覺壓縮機制和VICO數據集進行了消融實驗,如表三所示

1、視覺壓縮的有效性:

Video-XL使用Bunny 695k數據集訓練了兩個模型:一個不使用壓縮,另一個使用隨機壓縮比(從{2, 8, 16}中選取)。對於壓縮模型,在影片基準MLVU和圖像基準MME、MMBench上測試時應用了不同的壓縮比。值得注意的是,即使使用16的壓縮比,壓縮模型在仍表現出較好的效果,接近甚至超越了基線模型。

2、VICO數據集的有效性:

Video-XL使用不同數據集訓練了四個模型:(a) 僅使用Bunny 695k;(b) Bunny 695k結合NeXTQA 32k;(c) Bunny 695k結合CinePile 10k;(d) Bunny 695k結合長影片字幕5k;(e) Bunny 695k結合VICO 5k。值得注意的是,即使僅使用5k的VICO數據,Video-XL也超過了使用NeXTQA 32k訓練的模型。此外,主要事件/動作排序任務比字幕生成任務帶來了更顯著的提升,因為它促使模型從長序列中提取關鍵片段並進行理解。

(四)可視化結果

△

△目前。Video-XL的模型代碼均已開源,以促進全球多模態影片理解研究社區的合作和技術共享。

論文鏈接:https://arxiv.org/abs/2409.14485模型鏈接:https://huggingface.co/sy1998/Video_XL項目鏈接:https://github.com/VectorSpaceLab/Video-XL

*本文系量子位獲授權刊載,觀點僅為作者所有。

本文來自微信公眾號「量子位」,作者:允中,36氪經授權發佈。