「安全智能」的背後,Ilya 究竟看到了什麼?

文|飛哥說AI,作者 | 李維、高佳

當 Ilya Sutskever 離開 OpenAI 重歸大眾視野,帶著他名為 SSI(Safe Superintelligence Inc.) 的新公司。

這一舉動驚訝之餘又在意料之中——Ilya 直接跳過 AGI ,直指 SSI (Safe Superintelligence)。

他篤定表示:「超級智能已近在咫尺,建立安全的超級智能(SSI)是我們這個時代最重要的技術問題。

」這位深度學習和AI 領域的傳奇,前 OpenAI 的真正靈魂人物,Ilya 在那場戲劇性的內變事件中,始終處於風暴中心,也直指槓桿問題——有效加速還是超級對齊?

這場關乎AI價值觀和路線之爭的底層,Ilya 為何對「超級對齊」如此堅定?

以至風暴平息後,外界一直在猜測:Ilya 究竟看見了什麼,促使他必須聯手董事會作出驅逐CEO Sam Altman 的決定。此後的 Ilya 一直隱身,直到不久前揮一揮衣袖離開 OpenAI,他帶領的超級對齊團隊也因此解散。Ilya 轉身創立新公司。

「安全智能」的背後,他究竟看到了什麼?

早在 2023 年 10 月 3 日,Ilya 曾在伯克利大學做過一次演講,題為《一個無監督學習的理論》(A Theory of Unsupervised Learning)。由於內容艱澀,知曉者寥寥,而它卻是人工智能史上最重要的時刻之一,註定將載入史冊。

這次演講堪稱一位深度學習領域頂尖專家對自己開創、如今名冠天下的GPT模型的理論反思和總結。

Ilya 在演講中揭示了大模型的核心原理,並生動描述了他在獨立領悟無監督序列學習機制時的癡迷,興奮之情溢於言表。雖然理論晦澀,聽懂他的人也極為有限,但演講本身卻精彩絕倫、振聾發聵。

直到前不久,超級對齊團隊的前成員 Leopold Aschenbrenner 發表了一篇長達165頁的文章《Situation Awareness》,初步揭示了 OpenAI 內部目睹 GPT 模型指數級進化時的震撼和隱憂。

這多少部分回答了 Ilya 看到了什麼的問題,而 Ilya 本人一直緘默,直至今天官宣出山。

回顧他在伯克利的自白式演講,似乎可以一窺他面對潛在超級智能時的「頓悟」時刻,回答他對安全智能的「初心」。那是 Ilya 一次罕見的深度分享,試圖為世人傳真經。

世人聽見了嗎?

機器學習:監督學習與無監督學習

為了兼顧不同數學基礎的讀者,本文力圖主要用通俗易懂的語言深入淺出解讀 Ilya 的這一重要的技術演講。純粹技術性的解說,非技術人員可以選擇略過,並不影響對於這篇演說的主旨的理解。

精讀之前,我們複習一下機器學習的基本概念。

大家都知道,機器學習就像讓計算機當學生,人類當老師,通過給計算機大量的「練習題」和「答案」,讓它慢慢學會解題的能力。這就是監督學習(supervised learning)。但是,計算機真的能從練習題中學到本事,而不是死記硬背嗎? Ilya 告訴我們,這是有理論保證的。

想像一下,眼前有一大堆題海,每道題都配有標準答案。這就是模型的訓練數據。模型訓練就是勤奮刷題,終於把這些題幾乎都做對了,這意味著訓練誤差很低。但是題海再大,總有刷完的一天。

當新題擺在面前,還能答對嗎?新題就是測試數據,相當於考試,能否答對,取決於模型的測試誤差。

數學告訴我們,只要題海足夠大,遠遠超過模型的規模,那麼模型在訓練題上的出色表現(低訓練誤差),就能確保在考場上的發揮(低測試誤差)。換句話說,題海刷得好,考場差不了!這就是監督學習的數學保證。

當然,題海再大,如果只是死記硬背,不去歸納總結,你的腦容量再大、「記憶力」再強,也只是一個填鴨式的學霸,缺乏真正的學習應變的能力(叫做「泛化」能力)。

只有當你的大腦袋裡面的「小聰明」不要太高(聰明反被聰明誤),才會被迫去總結規律,提煉精華(業內叫「壓縮」),從題海中學到真本事。

這就是為什麼模型規模不能太大,不能給模型太多的投機取巧的空間。

總之, Ilya 想說的是,大數據+低訓練誤差,就是監督學習的制勝法寶,有數學證明為保證。這一點,從理論到實踐都已得到證實。

自從12年前深度學習革命以來,無數成功案例告訴我們,只要訓練數據足夠充足,神經網絡就是「學霸」,從識別貓狗到機器翻譯,都難不倒它。

但無監督學習呢?沒有標準答案的題海,計算機還能學到智能嗎?聽起來有點懸,但 Ilya 接下來就要講,他是如何試圖為無監督學習也尋找到堅實的數學基礎的。

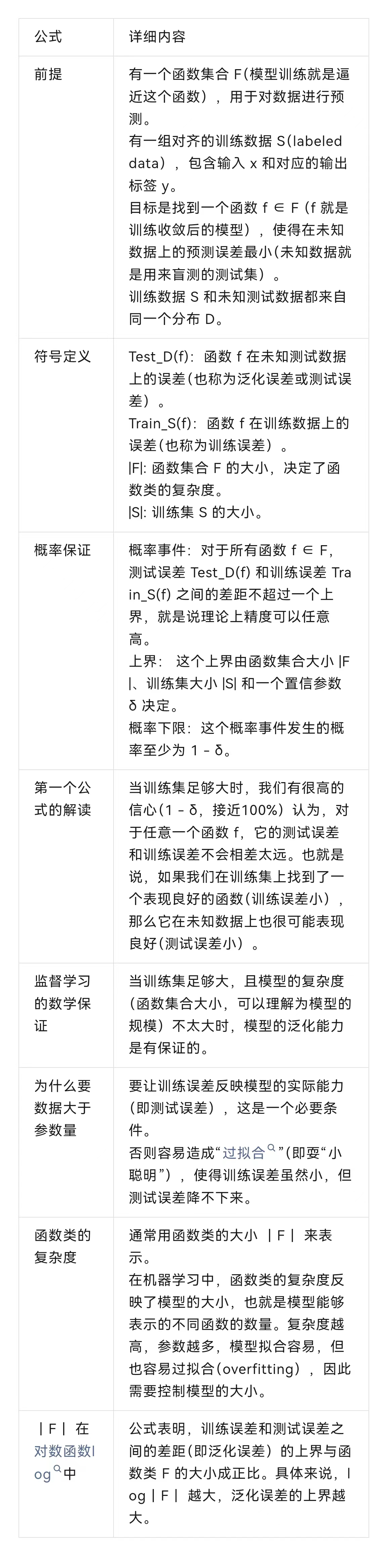

這是 Ilya 講演的第一幀slide,從監督學習講起,給出了理論上的保證。

所謂理論就是那個統計學習理論中著名的 Hoeffding 不等式,其主要含義是:當訓練誤差足夠低,且訓練樣本數遠大於「模型自由度」(可以理解為模型的規模)時,測試誤差也能保證足夠低,這就是監督學習能夠起作用的理論基礎。

具體說,就是模型規模一定要小於數據規模,否則,它根本就不用做真正的「壓縮」或抽像,不去找規律,它就全部死記硬背了。我們知道死記硬背的模型,沒有泛化能力。

它在訓練集上死記硬背,考了高分,到了盲測的測試集上就抓瞎了,模型的質量就得不到保證。所以公式裡面,模型複雜度(模型大小)是個關鍵變量。

具體的解讀如下表所示,數學基礎不足的讀者可以跳過這些公式理解的細節,並不影響對於主旨的理解。

總之,本頁 slide 表達的核心觀點是:低訓練誤差+大訓練集,就能確保模型的泛化能力,這就是監督學習背後的理論保證。

這個其實我們早已知道,第一,宏觀上和理論上,「萬能近似定理」(Universal Approaximation Theorem)早已論證了深層神經網絡可以逼近任意涵數。

第二,當代 AI 歷史上,12年前的深度學習革命就開始證明,只要有足夠帶標數據,神經網絡就可以讓「老母雞變鴨」,或做任何其他變換。

Ilya 接著說,不像監督學習有明確的數學保證,無監督學習似乎缺乏類似的理論支撐。但是,他發現了一種叫做「分佈匹配」(distribution matching)的範式,似乎能讓無監督學習也獲得數學保障。這話一出,大家都來了興趣,洗耳恭聽。

你可能會說,無監督學習不就是在學習數據的內在特徵嗎?比如,從一堆沒有標籤的貓狗圖片中,自動歸納出貓和狗的共同特徵。這對以後分類貓狗確實有幫助。

但如果這堆圖片是完全隨機的塗鴉,亂成一團,那無監督學習還能學到什麼嗎?另外,就算學到了貓長鬍鬚狗長尾巴,這些知識對別的任務,比如識別交通標誌,有什麼用呢?

Ilya 說,問題的關鍵在於我們要透過現象看本質。比如GPT這樣的語言模型,表面上是在學習預測下一個詞(next token prediction)。

實質上,它在匹配語言的分佈,學習語言的隱含規律。比如,在「我愛吃蘋果」這句話裡,「我愛吃」後面更可能出現「蘋果」,而不是「磚頭」,這反映了語言的內在知識。

這種分佈匹配,是一種特殊的模式規律的匹配。不同的是,它匹配的不是具體的字符串或詞串(token sequence),而是詞與詞之間的關係,也就是語言的規律性,類似於語義結構。 Ilya 認為,這種分佈匹配,才是無監督學習獲得智能的本質。不管是文本、圖像還是語音,它們都有內在的分佈規律性,而無監督學習就是要發現、匹配和對齊這些分佈規律。

所以,圖片不能太隨機,數據集不能都是塗鴉,得有一定的規律性,無監督學習才能抓住它們的隱藏共性。至於學到的知識對別的任務有沒有用,那要看這些任務的數據分佈是不是相似。如果都是自然圖像,那從貓狗身上學到的特徵,多少還能遷移到其他動物身上。但如果是完全不同的領域,比如醫學影像,那可能就沒什麼參考價值了。

總之, Ilya 給了我們一個新的視角:無監督學習的本質是分佈匹配,是一種規律性的模式匹配。這個視角,似乎為無監督學習的有效性提供了一種解釋。接下來, Ilya 將進一步解釋,分佈匹配是如何給無監督學習提供理論保證的。

分佈匹配:無監督學習的新思路

大家都知道,機器翻譯曾是監督學習的天下。為什麼?因為我們有歷史積累的海量人工翻譯數據啊。就像學生有課本和習題冊,英語在左邊,漢語在右邊,監督學習就吃這一套。

但是,如果老師突然不給雙語對齊數據了,只給你一些英語書和另一些不相幹的漢語書,讓你自己琢磨怎麼對齊學習自動翻譯,你該怎麼辦?

這就是無監督學習要解決的問題。 Ilya 說,無監督學習也能搞掂各種語言的機器翻譯(當然能,現在我們都在大模型模型中見識了,大模型把機器翻譯早已搞得妥妥的了,我們不再需要專門的翻譯軟件了),甚至任何從輸入到輸出的轉換任務。這是什麼原理呢?

原來, Ilya 發現了一個新思路,就是前面提過的分佈匹配。什麼意思?就是說,如果英語書庫和漢語書庫足夠大,包含了各種句型和語法,那它們的語言規律性就會顯現,就可以無監督學到。比如,英語里出現”I/me/my”的上下文分佈,和漢語里出現”我”的分佈應該有某種對應的規律性;英語里形容詞放在名詞附近,並且語義相諧,漢語裡應該也差不多,等等。這就為潛在的語言對齊提供了基本條件。

Ilya 指出,只要兩種語言原生數據足夠豐富,一種語言的輸入作為條件就能幾乎唯一地確定另一種語言的翻譯等價物。而且,這個原理不僅適用於機器翻譯,還適用於語音識別、圖像轉換等各種AI任務。

Ilya 在2015年就獨立發現了這個思路,他被它背後的數學原理迷住了。那是什麼原理?就是所謂「壓縮」理論。如果我們能找到一個方法,既能最大限度地壓縮英語數據,又能最大限度地壓縮漢語數據,那這個方法就能抓住兩種語言的共同規律,而這些規律就是翻譯的基礎。

所以 Ilya 提出,無監督學習其實就是在尋找最優的數據壓縮方法。這個視角不僅很酷,還能讓無監督學習的有效性有了數學上的解釋。雖然現實中的任務沒有那麼理想化,但這個原理讓無監督學習有了堅實的理論基礎,可以和監督學習一樣有說服力。

接下來, Ilya 還會進一步講解背後的數學原理。雖然有點抽像,但他保證乾貨滿滿。我們拭目以待,看他如何用壓縮的魔法來解釋無監督學習的奧秘。

下面是技術性的細節解讀,主旨不變,讀者可以選擇跳過去。

什麼是基於分佈匹配的無監督學習呢?

給定兩個沒有直接對齊的數據集X和Y (比如英語和法語的語料),我們要找到一個函數f,使得f(X)的分佈與Y的分佈相似。在機器翻譯、語音識別等轉換任務中,如果X和Y的維度足夠高,X這個條件能提供很強的約束,幾乎可以唯一地決定f(X)。後面會證明,這種無監督學習方法對任意端到端的任務Y=f(X)都有其理論保證,類似於監督學習的數學保證。

Ilya 在2015年獨立發現了這一思路,並對其數學原理(Kolmogorov複雜性,簡稱K氏複雜性)產生了濃厚興趣。但他也指出,現實中的機器學習任務與這種理想化的分佈式匹配還是有差距的。但這不影響他講原理。

接下來, Ilya 提出了他主要想說的觀點:把無監督學習看作是一個數據壓縮問題,可以讓我們從數學上理解無監督學習為什麼有效,在任務執行上使之與監督學習處於同等地位。

他指出,壓縮和預測之間有一一對應關係,每個壓縮算法都對應一個預測模型,反之亦然。他說,儘管這一點可能不那麼直觀,但已經是一個廣為人知的結論了。可以這樣理解,壓縮的逆操作是解壓縮,解壓縮的同義詞是預測。所以, Ilya 認為都是一回事。 機器學習中的過程與逆過程是推理階段的指向不同而已,從模型角度看是一回事。這引出了後面的他一再聲稱是「純乾貨」的大模型無監督學習的理論,即K氏複雜性。

這張 slide 的表達方式非常奇特,他似乎覺得需要引入一個「遺憾指數」來表達他對於自學習搞掂所有任務的信心:沒有遺憾。

Ilya 提出了一個從壓縮視角來形式化無監督學習的思路。考慮一個機器學習算法A,它試圖去壓縮數據集Y,同時可以利用另一個無標註數據集X。我們的目標是讓A儘可能好地壓縮Y。那麼怎麼衡量算法A的性能呢? Ilya 引入了「遺憾(regret)」這個概念。

如果A的「遺憾」很低,就意味著:我們已經充分利用了無標註數據X中的所有信息,來幫助壓縮Y。換句話說,沒有人能比我們做得更好了。如果X中存在任何對Y有用的模式,我們已經盡力去挖掘和利用了。

據稱這就提供了一個評估無監督學習算法的角度:好的算法應該能最小化這種「遺憾」,充分挖掘無標註數據的價值,讓我們晚上「睡得安穩」,不必擔心還有進一步提升的空間沒有利用。以壓縮而論,就是要原則上能夠榨乾海綿中的最後一滴水。

當然,無標註數據X的壓縮實際上對預測Y有多大幫助,可能有巨大差異。X可能含有破解Y的關鍵(例如語言之間的機器翻譯,這是因為語言與語言的深層語義是同構的,具有天然的可對齊特性),但也可能X對於預測Y沒什麼用處。無論如何,一個「低遺憾」的無監督學習算法,應能根據X的實際效用,盡力壓縮X來預測Y。

總的來說, Ilya 為刻畫和理解無監督學習提供了一個他自己的(有點古怪的)視角,讓我們聚焦於從無標註數據中學習有用信息這一核心問題上。

下面要談計算理論了,他先給了個警告,說這個理論有點晦澀。

Ilya 討論了Kolmogorov複雜度作為「終極壓縮器」的性質,以及它與無監督學習的關聯。

關於壓縮的理論,想像你是一個特工,你的任務是把一份機密文件傳遞給你的同伴。但是這份文件太大了,你沒法直接攜帶。所以你決定對文件進行「壓縮」,找到一種最簡潔的方式來表達文件的內容。

這就引出了K氏複雜度的概念。在特工的世界里,一份文件的 K氏複雜度就是能夠完整描述這份文件的最短指令。你可以把這個最短指令想像成一套「暗號」,只要你的同伴知道這套暗號,他就能完全還原出文件。

現在,假設你有兩份文件要傳遞,一份是機密情報(數據集X),另一份是行動計劃(數據集Y)。為了安全起見,你不能直接把行動計劃寫出來。但是,你覺得機密情報里可能隱藏著製定行動計劃的線索。所以,你希望找到一種方法能最大限度地解碼機密情報,來指導行動計劃的製定。

這就是無監督學習要解決的問題。在 Ilya 看來,一個好的無監督學習算法,應該能找到數據的最簡潔表示(即 K氏複雜度),同時又能最大限度地利用這種表示來完成下遊任務。例如,下遊任務是解函數 y=F(x),那麼算法就是要找到x與y的K氏複雜度,借此找到輸入x到輸出y的映射關係F。

然而,從數學上講,真正的K氏複雜度是不可計算的,就像我們沒法為每一份文件都找到最完美的暗號。但 Ilya 認為,我們可以訓練一個大型神經網絡(如GPT)來近似這個過程。因為理論上,神經網絡可以擬合任何函數,包括「生成文件的最短指令」這個函數。通過不斷調整網絡的參數,我們就可以一步步逼近最優的壓縮方案。

為了證明K氏複雜度是最佳的壓縮器, Ilya 給出了一個數學論證。用特工的比喻來說,大意就是,任何一套暗號的編碼,加上解碼指令的長度以及製定和理解這套暗號所需的額外信息,一定多於最簡潔的「完美暗號」,即K氏複雜度。

所以,K氏複雜度代表了壓縮的理論極限,任何實際的壓縮算法都不可能超越它。雖然這個極限不可達,但它為我們評判無監督學習算法提供了一個基準。 Ilya 認為,GPT 等大型語言模型之所以有效,正是因為它們能通過梯度下降等優化算法,不斷逼近這個基準,學習到數據的高度壓縮表示,並運用於下遊任務。這就是K氏複雜度和無監督學習的聯繫。雖然有點抽像,但核心思想是清晰的:壓縮是無監督學習的本質,而追求最簡潔的壓縮,就是追求最優的無監督學習。

下面是上述內容的技術性解說,主旨不變,不關心技術細節的讀者可以選擇跳過去到下一幀slide的解讀。

首先,一個對象的K氏複雜度被定義為能夠輸出該對象的最短程序的長度。直觀上,這個最短程序就是對象的最優壓縮。K氏複雜度給出了壓縮問題的一個通用下界。

假設我們有一個數據對象X(可以是一個字符串、一張圖片等),如何對X進行壓縮呢?一種直觀的想法是找到一個程序P,使得P的輸出就是X。如果P的長度比X短,那麼P就可以看作X的一個壓縮。K氏複雜度的思想是,P包含了產生X所需的全部信息,但又不包含任何多餘信息,是一種無冗餘的表示。這就是「無損壓縮」的概念。

現在回到無監督學習。假設我們有未標註數據集X和下遊任務數據集Y。如果要最大限度利用X去幫助預測Y,就希望找到一個算法,能最優地壓縮X,同時還能利用從X中學到的知識去幫助預測Y。

就是說,算法應該能計算X和Y的K氏複雜度,得到它們的最短程序表示,並利用X的表示去優化Y的表示。如果算法能做到這一點,就意味著它把X中一切有助於Y的信息都提取出來用到了。 Ilya 把這種性質叫做「無遺憾」,因為我們沒有浪費X的任何有用部分。

問題在於,從數學上可以證明,K氏複雜度是不可計算的,也就是說不存在一個算法能夠對任意輸入X算出最短程序P。所以完全理想的「無遺憾」的無監督學習在計算機里是無法實現的。但 Ilya 認為,我們訓練的大型神經網絡GPT,在某種意義上可以看作是K氏複雜度的一個近似。因為神經網絡是一個通用的函數擬合器,理論上能逼近任何函數(根據萬能近似定理 UAT),包括”最短程序”。而SGD(隨機梯度下降)讓我們能夠高效地適配網絡權重,去逼近最短程序。所以 Ilya 覺得,無監督深度學習能work,背後的奧秘就在於它在找K氏複雜度的一個可計算的替代物。

具體看 slide, Ilya 在這裏引入了一個不等式,刻畫了理論上的K氏複雜度與一般壓縮算法之間的關係: 任何數據的K氏複雜度一定是最短的程序,即最優的壓縮。

這個公式的證明基於一個稱為「模擬論證」(The Simulation Argument) 的反證法思想實驗。

這個矛盾的關鍵在於,我們在構造程序 P 時,忽略了壓縮器 C 本身的複雜度 K(C)。一旦我們考慮了這個複雜度,就會發現 P 的長度不可能短於 K(X),因為 K(C) 本身就不可能短於 K(X)。

這個證明實際上揭示了信息本身的一個基本性質:存在一個理論上的壓縮極限,這個極限是由信息的內在複雜性決定的,而不是由我們的壓縮技術決定的。

證明的價值在於它將 K(X) 從一個抽像的數學定義轉化為了一個有實際意義的理論極限。它告訴我們,不管我們如何改進壓縮算法,都存在一個理論上無法踰越的界限。雖然 K氏複雜度不可計算,但它為我們評估無監督學習模型提供了一個理論基準。

然而,就壓縮而言,K氏複雜度最優,不等於 GPT最優。但按照 Ilya 的說法,他們「發現」GPT可能是K氏複雜度的最好逼近。GPT通過無監督序列學習做到了在AI各任務上的碾壓效果,支持了這個發現。

Ilya 的終極理論:從條件建模到聯合建模

這是 Ilya 演講的最後一幀 slide,也是理論最精彩的奧秘,值得好好梳理和咀嚼。

無監督學習的目標通常被定義為「學習數據的內在結構」。 Ilya 提出用數據壓縮的角度來理解無監督學習:一個好的無監督學習算法,應該能最大限度地壓縮數據,最簡潔地表示數據的內容。這就引出了K氏複雜度的概念。

一個數據對象的 K氏複雜度,就是能夠完整描述這個對象的最短計算機程序的長度。可以想像,這個最短程序就像一個「壓縮包」,里麵包含了重構原始數據所需的全部信息。從這個角度看,無監督學習的目標就是尋找數據的最優壓縮表示,也就是 K氏複雜度。

但在實踐中,我們往往需要處理多個相關的數據集。比如在機器翻譯中,我們有源語言數據集 X 和目標語言數據集 Y。我們希望學習一個模型,能夠把 X 中的句子翻譯成 Y 中的句子。按照傳統的思路,這是一個條件概率問題:給定 X,Y 的概率分佈是什麼?用 K氏複雜度來表示,就是求 K(Y|X),即給定 X 的條件下,Y 的最短描述長度。

然而, Ilya 提出了一個不同的思路。他說,與其像監督學習那樣將 X 和 Y 視為條件與結果,不如將它們視為一個整體,在一個巨大的模型裡面一起進行壓縮。也就是說,我們要尋找一個聯合的 K氏複雜度 K(X,Y),即同時壓縮 X 和 Y 的最短程序長度,這就是我們的無監督學習出來的預訓練大模型(LLM)。

這個聯合壓縮程序必須能夠充分利用 X 和 Y 之間的相關性,用 X 中的信息去自動對齊 Y,就像我們學習外語時,會自然利用母語的知識去理解和記憶外語單詞一樣。

Ilya 認為,這種聯合壓縮的思想,才是無監督學習的真正威力所在。因為現實世界的數據往往是相互關聯的,存在大量的深層共同模式和規律。如果我們能夠用無監督學習去發現和利用這些規律,就能極大地提高學習的效率和泛化能力。

這也是 GPT 等大型語言模型能夠在各種任務上展現驚人性能的原因:它們通過海量數據的無監督預訓練,學會了訓練集的種種內在規律性,而這種規律性在相關的數據間月有通用性,可以對齊。

當然,在數學上,真正的 K氏複雜度是不可計算的。但 Ilya 認為,我們可以用深度神經網絡(例如GPT)去近似這個過程。通過梯度下降等優化算法,神經網絡可以在海量數據中尋找最優的壓縮表示,雖然可能不是嚴格意義上的 K氏複雜度,但足以捕捉數據的本質特徵及其對齊規律。

所以, Ilya 的理論可以看作是一個無監督學習的新範式,它將傳統的獨立建模(如英語模型、漢語模型;再如,語言模型、視覺模型,等等)提升到了大一統的關聯建模的高度。在這個範式下,無監督學習的目標不再是單純地壓縮單一群體的數據,而是尋找數據之間的聯繫。

這種跨模式、跨模態的學習,才是通用人工智能的高級形態。

現在我們仔細看這最後一張slide,裡面的X是數據集1,Y是數據集2,要點是榨乾X「海綿中的每一滴水(信息或價值)」 可以幫助預測Y,這就是 Ilya 說的X與Y一起訓練所能造成的效果:無監督的X學習居然幫助完成了從X到Y的轉換任務(預測Y就是轉換成Y)。

最關鍵的思想是:K(YIX) 變成了 K(X, Y)。

就是說, Ilya 把「 input X 條件下的 output Y」 這個放之四海而皆準的函數式AI任務,改成一個近似的求解問題,即,變成一個X與Y按照「原生態」放在一起聯合訓練:這實際上就是目前多模態大一統對於輸入數據不做模態切割的訓練方式,簡寫為 K(X, Y)。

這種近似變換,的確在「序列學習是AI任務的萬能模擬器」的實踐上看到了效果,但缺乏論證。 Ilya 試圖在理論上加強論證,並強調了自己的驚喜發現:X 的自學習居然對於Y的有很強的預測作用。

無監督自學習的本來含義是:X 的自學習就是為了壓縮X;Y 的自學習就是為了壓縮Y。

這個容易理解,因為自學習的本質就是回歸,只有正例(但可以有理論上無窮的正例),沒有反例。無監督自學習沒有具體的任務指向,是從語言學習語言,從圖像學習圖像,從音樂學習音樂,等等,實質就是從現象中不斷歸納和抽像大大小小的規律性(各種 patterns)。

Ilya 在 slide 裡面指出:Conditioning on a dataset, not an example。

壓縮的對像是數據集,而不是數據點,這一點非常重要,這其實是形式壓縮與內容壓縮的分水嶺。形式壓縮只是一個機械過程,產生不了智能。只有內容壓縮才能成就人工智能。

如何理解形式的無損壓縮(例如數字音樂)與內容的無損壓縮(例如 Suno)的區分和聯繫?

對一首特定的歌曲做無損壓縮,目的是要保證壓縮後可以100%還原成原來的音樂形式(包括音樂中的噪音和瑕疵)。這是傳統意義上的音樂壓縮,對像是數據個體,即,那首音樂。如果我們對音樂的集合做壓縮,無論大模型是用GPT還是用 Diffusion,你的對象就不再是個體,而是一個群體,結果就是大模型了,例如 Suno。

但個體對象轉變為群體對象的時候,形式的壓縮就自然轉化為內容的壓縮。這是因為群體雖然是個體組成的,但為群體壓縮,如同是為群體「畫像」,勾勒的是群體的統計性形象,它看上去可能是個個體,但它不是原數據中的任何一個特定的個體複製,否則就不是模型,而是記憶庫了。

這不難理解,因為大模型壓縮的本意就是要找出數據集的特徵和規律性。

你看,大模型GPT4生成的文字,我們可能似曾相讀;大模型 Suno 生成的音樂,我們可能似曾相聞;大模型 Sora 生成的影片,我們可能似曾相見;大模型 MJ 生成的圖片,我們可能似曾相識。

但它們是在大數據作為整體被抽像或壓縮以後,根據 prompt trigger 的條件,重新「還原」出來的虛擬個體:源於數據,高於數據,混跡於數據,真假莫辨。

既然壓縮的對像是整個的 dataset 的內容,解壓以後如何衡量其效果呢?黃金標準在哪裡?新人可能沒意識到,無監督也要有標準的。實踐層面,黃金標準是有的,否則沒法訓練。

這個標準就是每一個sample自己,等於是回到了個體。但這是不確切不完整的,標準完全有可能是其他的等價答案,因為同一個內容是可以有多種說法或形式表達的。

所謂自學習,就是以逼近個體為手段,不斷逼近群體。實現手段就是所謂「掩碼」(把自己披上個紅蓋頭),ntp 就把 next token 遮蓋住。訓練就是計算與每一個sample的loss,利用梯度下降的 back prop不斷調參,最後讓這個 loss 在數據集群體訓練中下降到一個可以接受的點,大模型就煉成了。

最後這張 slide 和 Ilya 的解釋,都在強調一個核心觀點:條件 K氏複雜度 K(Y|X) 提供了一種理論上最優的無監督學習解決方案。

K(Y|X) 的定義: 在允許訪問輸入數據集 X 的情況下,輸出數據集 Y 的最短程序的長度。

K(Y|X) 的意義: 它代表了從 X 中提取所有對預測 Y 有價值的信息的理論上限。一個能夠達到 K(Y|X) 的算法,就是利用無標籤數據 X 進行對於Y預測的最佳算法。

這實際上可以看成是大模型能做各種語言機器翻譯的理論基礎。因為每一種語言都是潛在的 X 也是潛在的 Y,在難以思議的語言數據量灌進去自學習以後,LLM 就學會了各種語言以及語言之間的關聯性,也就具備了X–》Y 的翻譯潛能。

實踐中,機器翻譯的任務在初期與其他任務的學習一樣,是通過少量的翻譯樣本(few shots),在指令遵循的微調中定義了任務,最終觸發了大模型對各種語言互譯的內力。這種無監督學習各種任務的內力所依據的理論基礎正是本次演講的主題。

然而,K(Y|X) 在實際中是不可計算的。 Ilya 提出了一種可行的替代方案,即,使用普通的 K氏複雜度 K(X,Y)(聯合壓縮 X 和 Y)。他認為,在實際機器學習任務中,K(X,Y) 可以達到與 K(Y|X) 相當的效果。

重點的理論說十遍,上面這句話是精華的精華:條件建模被 Ilya 換成了序列建模,從而論證了 GPT 的大一統。以前在傳統機器學習裡面,最廣為人知的一個概率近似變換是馬高夫鏈式簡化,與此有異曲同工的感覺。

結語

Ilya 在伯克利的歷史性講演,關於無監督學習的理論闡釋,揭示的是自學習大模型,尤其是 GPT 幾乎一統天下的奧秘。

Ilya 似乎思考和猶疑了很久,終於在伯克利隱晦泄漏了「天機」。雖然理論及其論證顯得有些艱澀,但要真正搞懂GPT「預測下一詞」的序列學習方式為什麼成為 AI 任務的萬能模擬器,這個講演是一個必要的重要指引。

深究 Ilya 的演講,將他的說法反復咀嚼,震撼之餘,陡增了對他的欽仰。他以一種天才先知的形象,挾著他孤獨求敗與高處不勝寒,有一種大徹大悟、悲天憫人的氣息,同時保持了一個實驗室研究生 nerd 般的單純、專注以及滿懷理想的赤誠可愛。

他聲稱自己偏好壓縮,但並不強調所謂無損壓縮。他給自己,也給主流留了餘地,提出了「無遺憾」的說法——雖然 GPT 可能做不到無損或完美,但是他在理論上論證了沒有更好的辦法了,GPT 是最接近無損的無遺憾的模型。

當 Ilya 正式出山,建立「安全超級智能」 SSI 公司,強調只有一個重點、一個目標、一個產品,那就是要用技術確保大模型將要帶來的超級人工智能對人類是安全的。

「AI 將萬世不朽,它的誕生如同開天闢地」。當 Ilya 目光炯炯地談及 AI 的進程,他也最有資格斷言,並引領著,「邁向AGI的激動人心又危險的旅程」。

參考:

- https://www.youtube.com/live/AKMuA_TVz3A?si=7dVfcBUv3rHBHtyT

- https://situational-awareness.ai/