最強模型Llama 3.1 405B正式發佈

今天淩晨,大家期待已久的 Llama 3.1 官方正式發佈了!

Meta 官方發出了「開源引領新時代」的聲音。

在官方博客中,Meta 表示:「直到今天,開源大語言模型在功能和性能方面大多落後於封閉模型。現在,我們正在迎來一個開源引領的新時代。我們公開發佈 Meta Llama 3.1 405B,我們認為這是世界上最大、功能最強大的開源基礎模型。迄今為止,所有 Llama 版本的總下載量已超過 3 億次,我們才剛剛開始。」

Meta 創始人、CEO 朱克伯格也親自寫了篇長文《Open Source AI Is the Path Forward》,闡述為什麼開源對所有開發者、對 Meta、對世界都是好事。

此次發佈的要點包括:

-

最新的系列模型將上下文長度擴展到了 128K、增加了對八種語言的支持,并包括頂級開源模型 Llama 3.1 405B;

-

Llama 3.1 405B 獨樹一幟,Meta 官方稱其可與最好的閉源模型相媲美;

-

此次發佈還提供了更多與模型配合使用的組件(包括參考系統)來將 Llama 打造為一個系統;

-

用戶通過 WhatsApp 和 meta.ai 就可以體驗 Llama 3.1 405B 了。

地址:https://llama.meta.com/

各位網民可以下載嚐鮮了。

Llama 3.1 介紹

Llama 3.1 405B 是首個公開可用的模型,在常識、可操縱性、數學、工具使用和多語言翻譯等方面可與頂級 AI 模型相媲美。

Meta 表示最新一代的 Llama 將激發新的應用程序和建模範式,包括利用合成數據生成來提升和訓練更小的模型,以及模型蒸餾 —— 這是一種在開源領域從未達到的能力。

與此同時,Meta 還推出了 8B 和 70B 模型的升級版本,支持多種語言,上下文長度達到 128K,推理能力也更強。最新模型支持高級用例,例如長篇文本摘要、多語言對話智能體和編碼助手。

舉例來說,Llama 3.1 可以將故事翻譯成西班牙語:

當用戶提問「有 3 件襯衫、5 條短褲和 1 條連衣裙,假如要旅行 10 天。準備的衣服夠不夠?」模型能夠快速地進行推理。

長上下文:對於上傳的文檔,Llama 3.1 能夠分析和總結最多 8k token 的大型文檔。

編碼助手,對於用戶要求,可以快速編寫代碼:

此外,Llama 3.1 405B 的開發者還發推文「劇透」,表示開發 GPT-4o 一樣集成語音和視覺能力的模型還在開發中。

Meta 還對開源協議進行了更改,允許開發人員使用 Llama 模型(包括 405B)的輸出來改進其他模型。此外,為了兌現開源承諾,從今天開始,Meta 將這些模型提供給社區,用戶可以在 llama.meta.com 和 Hugging Face 上下載。

下載地址:

https://huggingface.co/meta-llama

https://llama.meta.com/

模型評估

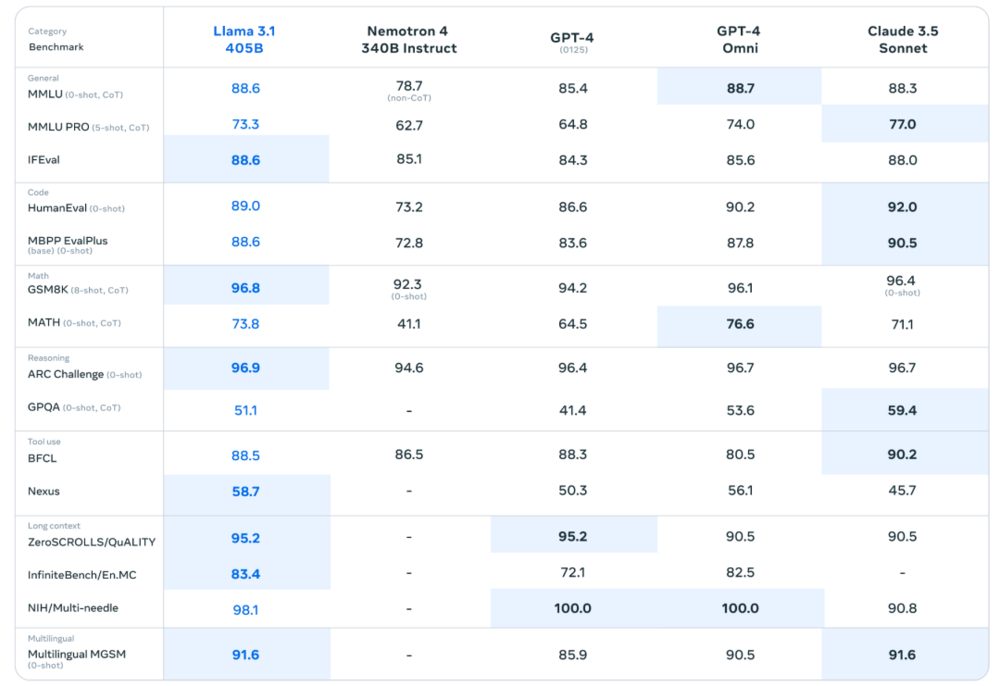

Meta 在超過 150 個基準數據集上進行了評估,此外,他們還進行了廣泛的人類評估。

實驗結果表明,旗艦模型 Llama 3.1 405B 在一系列任務中與領先的基礎模型包括 GPT-4、GPT-4o 和 Claude 3.5 Sonnet 具有競爭力。此外,8B 和 70B 小型模型與具有相似數量參數的閉源和開源模型具有競爭力。

模型架構

作為 Meta 迄今為止最大的模型,使用超過 15 萬億個 token 訓練 Llama 3.1 405B 是一項重大挑戰。為了實現這種規模的訓練,Meta 優化了整個訓練堆棧,並在超過 16,000 個 H100 GPU 上訓練,使該模型成為第一個在此規模上訓練的 Llama 模型。

為瞭解決這個問題,Meta 在設計上做出了以下一些選擇,重點保持模型開發過程的可擴展性和簡單性。

-

選擇了僅進行少量調整的標準解碼器 Transformer 模型架構,而不是混合專家模型,以最大限度地提高訓練穩定性。

-

採用迭代後訓練程序,每輪都使用監督微調和直接偏好優化。這使 Meta 能夠為每輪創建最高質量的合成數據,並提高每項功能的性能。

與之前版本的 Llama 相比,Meta 提高了用於預訓練和後訓練的數據數量和質量,如為預訓練數據開發更仔細的預處理和管理管道,為後訓練數據開發更嚴格的質量保證與過濾方法。

正如語言模型 scaling laws 所預期的那樣,Meta 新旗艦模型優於使用相同程序訓練的較小模型。Meta 還使用 405B 參數模型來提高較小模型的後訓練質量。

為了支持 405B 模型的大規模推理產出,Meta 將模型從 16 比特 (BF16) 量化為 8 比特 (FP8) ,有效降低了所需的計算要求,並允許模型在單個服務器節點運行。

指令和聊天微調

Llama 3.1 405B 努力提高模型響應用戶指令的實用性、質量和詳細指令遵循能力,同時確保高水平的安全性。

在後訓練階段,研究團隊通過在預訓練模型的基礎上進行幾輪對齊來構建最終的聊天模型。每輪都涉及監督微調(SFT)、拒絕采樣(RS)和直接偏好優化(DPO)。

研究團隊使用合成數據生成來產生絕大多數 SFT 示例,並多次迭代以在所有功能上生成越來越高質量的合成數據。此外,研究團隊還採用了多種數據處理技術,以過濾這些合成數據,達到最高質量,並可以跨功能擴展微調數據量。

Llama 系統

Llama 模型一直是作為 AI 系統的一部分而存在的,可以協調多個組件,包括調用外部工具。Meta 旨在超越基礎模型,讓開發人員能夠靈活地設計和創建符合其願景的定製產品。

為了在模型層之外負責任地開發人工智能,Meta 發佈了一個完整的參考系統,其中包括多個示例應用程序以及新組件,例如 Llama Guard 3(一種多語言安全模型)和 Prompt Guard(一個 prompt 注入過濾器)。這些示例應用程序是開源的,可以由開源社區構建。

為了與行業、初創公司和開源社區進行更廣泛的合作,幫助更好地定義組件的接口,Meta 在 GitHub 上發佈了針對「Llama Stack」的評論請求。Llama Stack 是一組標準化接口,用於構建規範的工具鏈組件(微調、合成數據生成)和智能體應用程序。這有助於更輕鬆地實現互操作性。

與封閉模型不同,Llama 模型權重可供下載。開發人員可以根據自己的需求和應用程序完全定製模型,在新數據集上進行訓練,並進行額外的微調。

使用 Llama 3.1 405B 進行開發

對於普通開發者來說,部署 405B 這樣大規模的模型無疑是一項挑戰,它需要大量的計算資源和專業技能。在與開發者社區的交流中,Meta 意識到,生成式 AI 的開發不僅僅是給模型輸入 prompt。他們期望所有開發者都能在以下領域充分開發 Llama 3.1 405B 的潛力:

-

實時和批量推理

-

監督式微調

-

測試和評估模型在特定應用中的性能

-

持續預訓練

-

檢索增強生成(RAG)

-

函數調用

-

合成數據生成

發佈即日起,Llama 3.1 405B 模型的所有高級功能都將開放,開發者們可以即刻上手。開發者們還可以探索更高階的工作流,例如基於模型蒸餾的合成數據生成。這次升級,Meta 還無縫集成了合作夥伴 AWS、NVIDIA 和 Databricks 提供的解決方案,以實現更高效的檢索增強生成(RAG)。此外,Groq 已經為在雲端部署模型進行了低延遲推理的優化,也對本地系統進行了類似的性能提升。

Meta 這次還為 Llama 3.1 405B 內置了「工具大禮包」,內含 vLLM、TensorRT 和 PyTorch 等關鍵項目,從模型開發到部署「開箱即用」,一步到位。

參考鏈接:https://ai.meta.com/blog/meta-llama-3-1/

本文來自微信公眾號:機器之心