KAN干翻MLP,開創神經網絡新範式!一個數十年前數學定理,竟被MIT華人學者複活了

新智元報導

編輯:桃子

【新智元導讀】KAN的誕生,開啟了機器學習的新紀元!而這背後,竟是MIT華人科學家最先提出的實踐想法。從KAN到KAN 2.0,這個替代MLP全新架構正在打開神經網絡的黑盒,為下一步科學發現打開速通之門。

KAN的橫空出世,徹底改變了神經網絡研究範式!

神經網絡是目前AI領域最強大的工具。當我們將其擴展到更大的數據集時,沒有什麼能夠與之競爭。

圓周理論物理研究所研究員Sebastian Wetzel,對神經網絡給予了高度的評價。

然而,萬事萬物並非「絕對存在」,神經網絡一直有一個劣勢。

其中一個基本組件——多層感知器(MLP),儘管立了大功,但這些建立在MLP之上的神經網絡,卻成為了「黑盒」。

因為,人們根本無法解釋,其中運作的原理。

為此,AI界的研究人員們一直在想,是否存在不同類型的神經網絡,能夠以更透明的方式,同樣輸出可靠的結果?

是的,的確存在。

2024年4月,MIT、加州理工等機構研究人員聯手提出,新一代神經網絡架構——Kolmogorov-Arnold network(KAN)。

它的出現,解決了以上的「黑盒」問題。

論文地址:https://arxiv.org/pdf/2404.19756

論文地址:https://arxiv.org/pdf/2404.19756比起MLP,KAN架構更加透明,而且幾乎可以完成普通神經網絡,在處理某類問題時的所有工作。

值得一提的是,它的誕生源於上個世紀中期一個數學思想。

數學家Andrey Kolmogorov和Vladimir Arnold

數學家Andrey Kolmogorov和Vladimir Arnold這個已經埋了30多年的數學原理,如今在DL時代被這位華人科學家和團隊重新發現,再次發光發亮。

雖然,這項創新僅僅誕生了5個月的時間,但KAN已經在研究和編碼社區,掀起了巨浪。

約翰霍普金斯大學計算機教授Alan Yuille讚揚道,KAN更易於解釋,可以從數據中提取科學規則,因此在科學領域中有著極大的應用」。

讓不可能,成為可能

典型的神經網絡工作原理是這樣的:

一層層人工神經元/節點,通過人工突觸/邊,進行連接。信息經過每一層,經過處理後再傳輸到下一層,直到最終將其輸出。

對邊進行加權,權重較大的邊,比其他邊有更大的影響。

在所謂的訓練期間,這些權重會不斷調整,最終使得神經網絡輸出越來越接近正確答案。

神經網絡的一個常見的目標是,找到一種數學函數、曲線,以便最好地連接某些數據點。

它們越接近這個函數,預測的結果就越準確。

假設神經網絡模擬了物理過程,理想情況下,輸出函數將代表描述該物理過程的方程,相當於物理定律。

對於MLP來說,會有一個數學定理,告訴你神經網絡能多接近最佳可能函數。

這個定理表明,MLP無法完美地表示這個函數。

不過,在恰當的情況下,KAN卻可以做到。

KAN以一種不同於MLP的方式,進行函數擬合,將神經網絡輸出的點連接起來。

它不依賴於帶有數值權重的邊,而是使用函數。

同時,KAN的邊函數是非線性和可學習的,這使得它們比MLP更靈活、敏感。

然而,在過去的35年里,KAN被認為在實際應用中,切不可行。

1989年,由MIT物理學家轉計算機神經科學家Tomaso Poggio,共同撰寫的一篇論文中明確指出:

KAN核心的數學思想,在學習神經網絡的背景下是無關緊要的。

Poggio的一個擔憂,可以追溯到KAN核心的數學概念。

論文地址:http://cbcl.mit.edu/people/poggio/journals/girosi-poggio-NeuralComputation-1989.pdf

1957年,數學家Andrey Kolmogorov和Vladimir Arnold在各自但相互補充的論文中證明——如果你有一個使用多個變量的單一數學函數,你可以把它轉換成多個函數的組合,每個函數都有一個變量。

然而,這裏有個一個重要的問題。

這個定理產生的單個變量函數,可能是「不平滑的」,意味著它們可能產生尖銳的邊緣,就像V字的頂點。

這對於任何試圖使用這個定理,重建多變量函數的神經網絡來說,都是一個問題所在。

因為這些更簡單的單變量部分,需要是平滑的,這樣它們才能在訓練過程中,學會正確地調增匹配目標值。

因此,KAN的前景一直以來黯淡無光。

MIT華人科學家,重新發現KAN

直到去年1月,MIT物理學研究生Ziming Liu,決定重新探討這個話題。

他和導師Max Tegmark,一直致力於讓神經網絡在科學應用中,更加容易被人理解,能夠讓人們窺探到黑匣子的內部。

然而,這件事一直遲遲未取得進展。

可以說,在這種「走投無路」的情況下,Liu決定在KAN上孤勇一試。

導師卻在這時,潑了一盆冷水,因為他對Poggio論文觀點太過熟悉,並堅持認為這一努力會是一個死胡同。

不過,Ziming Liu卻沒有被嚇到,他不想在沒有先試一下的情況下,放棄這個想法。

隨後,Tegmark也慢慢改變了自己的想法。

他們突然認識到,即使由該定理產生的單值函數,是不平滑的,但神經網絡仍可以用平滑的函數逼近數值。

Liu似乎有一種直覺,認定了KAN便是那個拯救者。

因為自Poggio發表論文,已經過了35年,當下的軟件和硬件取得了巨大的進步。

在2024年,就計算來講,讓許多事情成為可能。

大約肝了一週左右的時間,Liu深入研究了這一想法。在此期間,他開發了一些原型KAN系統,所有系統都有兩層。

因為Kolmogorov-Arnold定理本質上為這種結構提供了藍圖。這一定理,明確地將多變量函數分解為,不同的內部函數和外部函數集。

這樣的排列,使其本身就具備內層和外層神經元的兩層架構。

但令Liu沮喪的是,所設計的原型KAN並沒有在科學相關任務上,表現地更好。

導師Tegmark隨後提出了一個關鍵的建議:為什麼不嘗試兩層以上的KAN架構,或許能夠處理更加複雜的任務?

一語點醒夢中人。

這個開創性的想法,便成為他們突破的關鍵點。

這個羽翼未豐的原型架構,為他們帶來了希望。很快,他們便聯繫了MIT、加州理工、東北大學的同事,希望團隊能有數學家,並計劃讓KAN分析的領域的專家。

實踐證明,在4月份論文中,小組團證明了三層KAN,確實是可行的。

他們給出了一個示例,三層KAN可以準確地表示一個函數,而兩層KAN卻不能。

不過,研究團隊並沒有止步於此。自那以後,他們在多達六層的KAN上進行了實驗,每一層,神經網絡都能與更複雜的輸出函數,實現對準。

論文合著作者之一 Yixuan Wang表示,「我們發現,本質上,可以隨心所欲堆疊任意多的層」。

發現數學定理碾壓DeepMind

更令人震驚的是,研究者在兩個現實的世界問題中,對KAN完成了驗證。

第一個,是數學一個分支中的「紐結理論」。

2021年,DeepMind團隊曾宣佈,他們已經搭建了一個MLP,再獲得足夠紐結的其他屬性後,可以預測出給定紐結的特定拓撲屬性。

三年後,全新的KAN再次實現了這一壯舉。

而且,它更進一步地呈現了,預測的屬性如何與其他屬性相關聯。

論文一作Liu說,「這是MLP根本做不到的」。

第二個問題是,設計凝聚態物理中的一種現象,稱為Anderson局域化。

其目的是,預測特定相變將發生的邊界,然後確定描述該過程的數學公式。同樣,也只有KAN做到了在這一點。

Tegmark表示,「但與其他形式的神經網絡相比,KAN的最大優勢在於其可解釋性,這也是KAN近期發展的主要動力」。

在以上的兩個例子中,KAN不僅給出了答案,還提供瞭解釋。

他還問道,可解釋性意味著什麼?

「如果你給我一些數據,我會給你一個可以寫在T恤上的公式」。

終極方程式?

KAN這篇論文的出世,在整個AI圈引起了轟動。

AI大佬們紛紛給予了高度的評價,有人甚至直呼,機器學習的新紀元開始了!

目前,這篇論文在短短三個月的時間里,被引次數近100次。

很快,其他研究人員親自入局,開始研究自己的KAN。

6月,清華大學等團隊的研究人員發表了一篇論文稱,他們的 Kolmogorov-Arnold-informed neural network(KINN),在求解偏微方程(PDE)方面,明顯優於MLP。

對於研究人員來說,這可不是一件小事,因為PED在科學中的應用無處不在。

論文地址:https://arxiv.org/pdf/2406.11045

論文地址:https://arxiv.org/pdf/2406.11045緊接著,7月,來自新加坡國立大學的研究人員們,對KAN和MLP架構做了一個全面的分析。

他們得出結論,在可解釋性的相關任務中,KAN的表現優於MLP,同時,他們還發現MLP在計算機視覺和音頻處理方面做的更好。

而且,這兩個網絡架構在NLP,以及其他ML任務上,性能大致相當。

這一結果在人意料之中,因為KAN團隊的重點一直是——科學相關的任務,而且,在這些任務中,可解釋性是首要的。

論文地址:https://arxiv.org/pdf/2407.16674

論文地址:https://arxiv.org/pdf/2407.16674與此同時,為了讓KAN更加實用、更容易使用。

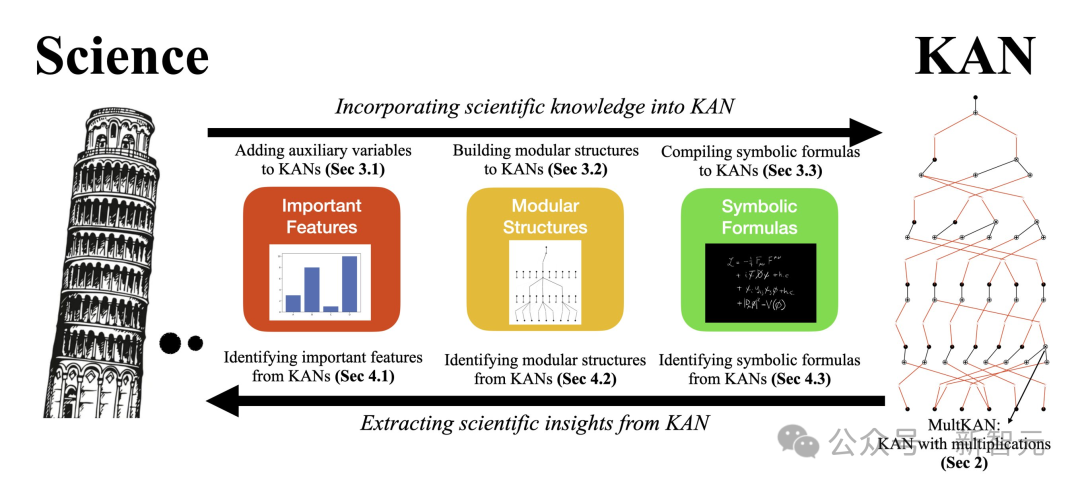

8月,KAN原班人馬團隊再次迭代了架構,發表了一篇名為「KAN 2.0」新論文。

論文地址:https://arxiv.org/pdf/2408.10205

論文地址:https://arxiv.org/pdf/2408.10205他們將其描述為,它更像是一本用戶手冊,而非一篇傳統的論文。

論文合著者認為,KAN不僅僅是一種達到目的的手段,更是一種全新的科學研究方法。

長期以來,「應用驅動的科學」在機器學習領域佔據主導地位,KAN的誕生促進了所謂的「好奇心驅動的科學」的發展。

比如,在觀察天體運動時,應用驅動型研究人員,專注於預測它們的未來狀態,而好奇心驅動型研究人員,則希望揭示運行背後的物理原理。

Liu希望,通過KAN,研究人員可以從中獲得更多,而不僅僅是在其他令人生畏的計算問題上尋求幫助。

相反,他們可能會把重點放在,僅僅是為了理解,而獲得理解之上。

參考資料:

Novel Architecture Makes Neural Networks More Understandable