OpenAI o1智商120,還是被陶哲軒稱為「平庸的研究生」,但實力究竟如何?

編輯:蛋醬、楊文

自從 OpenAI 發佈了新模型 o1 後,它就承包了 AI 領域近幾天的熱搜:

有人用文沙智商測試題「拷問」它,竟測得 o1 智商高達 120;

數學大佬陶哲軒要求 o1 回答一個措辭含糊的數學問題,最終得出一個結論:o1 是個平庸但不無能的研究生;

還有一位天體物理學論文作者,僅用 6 次 Prompt,就讓 o1 系列模型在 1 小時內,創建了代碼運行版本,這可是他博士生期間 10 個月的工作量。

但在 ARC Prize 測試中,o1 的表現並沒有想像中出類拔萃,僅僅是追平幾個月前發佈的 Claude 3.5 Sonnet。

看完五花八門的評測,大家反而有些迷茫了,o1 的實力到底怎麼樣?

智商測試得分忽高忽低,網民紛紛質疑

上週,OpenAI 在介紹 o1 時表示,它不需要專門訓練,就能直接拿下數學奧賽金牌,甚至可以在博士級別的科學問答環節上超越人類專家。

這也讓大家對 o1 的「智力水平」產生了好奇。就在前天,X 博主 Maxim Lott 專門拿 o1 進行了挪威文沙智商測試,結果測得它的智商高達 120,遠遠超過了其他所有的大模型。具體來說,o1 在 35 個智商問題中答對了 25 個,遠遠高於大多數人類的表現。

在此之前,Maxim Lott 還進行了一場 o1 的智商測試。在這個測試中,o1 的 IQ 達到 100。

兩次結果一對比,有網民質疑,為何先後測試的結果如此不同?

Maxim 表示,o1 得分 100 的這個智商測試,是由文沙會員專門設計的,是一個僅限線下的測試,且不包含在任何人工智能的訓練數據中,因此其得分會低於公開智商測試的得分。

也有網民好奇,o1 目前還不支持多模態,那麼這類表格圖形題目是如何測試的?

還有網民認為,智商測試是一種狹隘的衡量標準,要想真正評估人工智能進化,不是通過文沙測試,而是考察它們對於細微差別、背景和人類複雜性的理解,而這些是智商測試無法量化的。

此外,有網民認為,文沙智商測試是針對特定年齡組的人類進行標準化的,因此對於這些機器人來說,不可能得到一個「真正的智商」分數或性能評估。

同樣迷惑的是,在 ARC Prize 測試中,兩個 o1 模型都擊敗了 GPT-4o,其中 o1-preview 僅僅和 Claude 3.5 Sonnet 得分相同。

圖源:https://arcprize.org/blog/openai-o1-results-arc-prize

圖源:https://arcprize.org/blog/openai-o1-results-arc-prize這讓人質疑:o1-preview 的「推理」可能只是一種營銷語言,OpenAI 或許採取了一些方法讓不太智能的系統看起來更智能,僅此而已。

在測試中,o1 的性能提升還帶來了更高的時間成本 —— 它花了 70 個小時完成 400 個公共任務,而 GPT-4o 和 Claude 3.5 Sonnet 只花了 30 分鐘。

「平庸的研究生」o1

1 小時完成了博士生 10 個月的工作

或許大家還記得,陶哲軒前兩天給了 o1 模型一個評價:「更強了,但是在處理最複雜的數學研究任務還不夠好,就像指導一個水平一般但不算太無能的研究生。」

進步的地方體現在:「我要求 GPT 回答一個措辭含糊的數學問題,只要從文獻中找出一個合適的定理就能解決這個問題。之前,GPT 能夠提到一些相關概念,但細節都是幻覺般的胡言亂語。而這一次,GPT 找到了 Cramer 定理,並給出了完全令人滿意的答案。」

比如,2010 年,陶哲軒曾經尋找「乘法積分」(multiplicative integral)的正確術語,但在當時的搜索引擎上找不到。於是他在 MathOverflow 上提出了這個問題,並從人類專家那裡得到了滿意的答案。如今,他向 o1 提出了同樣的問題,模型返回了一個完美的答案。

誠然,上述 MathOverflow 上的帖子有可能已經包含在模型的訓練數據中。但陶哲軒表示,這至少證明了 o1 在某些語義搜索查詢的高質量答案方面與問答網站不相上下。

不足的地方也很明顯,就像陶哲軒的舉例:

新模型可以通過自己的努力得到一個正確的(而且寫得很好的)解決方案,但它自己並沒有產生關鍵的概念想法,而且確實犯了一些非同小可的錯誤。 這種經歷似乎與試圖給一個平庸但「並非完全不稱職的研究生」提供指導差不多。 不過,這比以前的模型有所改進,因為以前的模型的能力更接近於「不稱職的研究生」。 在達到「稱職的研究生」水平之前,可能只需要再進行一到兩次能力改進的迭代(以及與其他工具的整合,如計算機代數軟件包和證明助手),到那時我就能看到這個工具在研究級任務中的重要作用了。

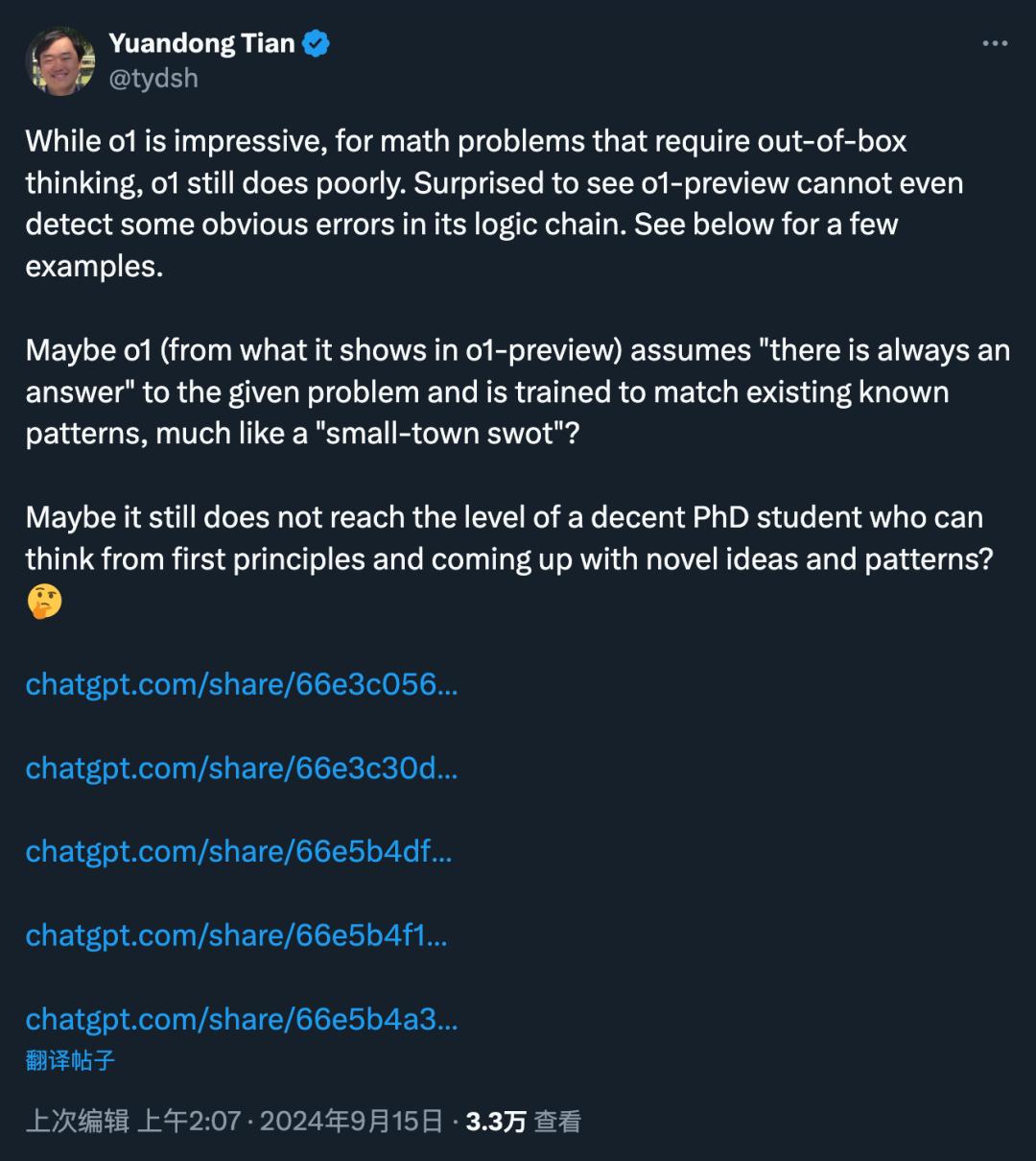

AI 學者田淵棟表示,自己也發現,雖然 o1 的表現令人印象深刻,但對於需要跳出思維定式的數學問題,o1 的表現仍然很差。

「令人驚訝的是,o1-preview 甚至無法檢測出其邏輯鏈中的一些明顯錯誤。」

有趣的是,對於陶哲軒等知名學者來說「不太令人滿意」的 o1,卻成為了很多研究者心中的神器。

一篇天體物理學論文的作者使用 o1 的預覽和迷你版本,僅僅經過 6 次 Prompt,在 1 小時內創建了自己研究論文方法部分所述代碼的運行版本。

影片地址:https://youtu.be/M9YOO7N5jF8?si=5pfmIq023EFmPzdK

儘管代碼不是當時唯一的突破成果,但這部分工作確實讓他在攻讀博士學位的第一年里奮鬥了大約 10 個月。

但需要注意的是,雖然 o1 確實模仿了這位研究者的代碼,但它使用的是自身創建的合成數據,而不是論文中使用的真實天文數據。此外,o1 創建的也只是一個「最簡單版本」。

面對網民的一些質疑,他在後續發佈的新影片中強調,自己並不是宣傳人工智能已經到了能做出突破性新發現的地步,自己的嘗試也不意味著 AGI 已經到來,原意只是「它可以成為一個非常棒的研究助手」。

影片地址:https://youtu.be/wgXwD3TD43A?si=Nr6_Z1qjBdicE-_x

使用 Claude 逆向工程 o1 架構

得到什麼結論?

在技術博客《Learning to Reason with LLMs》中,OpenAI 曾對 o1 進行了一部分技術介紹。

其中提到:「OpenAI o1 是經過強化學習訓練來執行複雜推理任務的新型語言模型。特點就是,o1 在回答之前會思考 —— 它可以在響應用戶之前產生一個很長的內部思維鏈。也就是該模型在作出反應之前,需要像人類一樣,花更多時間思考問題。通過訓練,它們學會完善自己的思維過程,嘗試不同的策略,並認識到自己的錯誤。」

或許 OpenAI 不會公佈更多底層的技術細節了,但研究者們的好奇不會消失。

一位研究者「TechnoTherapist」決定借助大模型的力量來剖析:他向 Claude 提供了涉及 OpenAI 發佈的信息(System Card、博客文章、Noam Brown 和其他人的推文、ARC Prize 團隊的評論)和與 o1 模型相關的在線討論(Reddit、YouTube 影片)。

Claude 可以用 mermaid、plantuml、svg 等語言創建圖表。研究者從 mermaid 開始,反復修改,直到得到一個全面的圖表;然後讓 Claude 將其轉換為 svg,並添加所需的視覺特徵(美學、需要突出顯示的區域等);最後,用 python 腳本將 svg 轉換為 png 圖像。

經過一番討論,他和 Claude 共同完成了 o1 模型的可能架構圖:

圖源:https://www.reddit.com/r/LocalLLaMA/comments/1fgr244/reverse_engineering_o1_architecture_with_a_little/

OpenAI 的博客也曾提到,隨著更多的強化學習(訓練時計算)和更多的思考時間(測試時計算),o1 的性能持續提高,類似於「強化學習的 Scaling Law」。大規模的強化學習算法,能夠教會模型如何在數據高度有效的訓練過程中利用其思維鏈進行高效思考。

在這次逆向工程中,研究者假設了 OpenAI 可能會使用現實世界中生成的 CoT 來進一步調整 RL 優化模型。因此在架構圖中,語言模型會將大規模 CoT 存儲輸入到 RL 環境中。

也有人持不同看法,比如這位研究者指出,上述「假設」的過程很可能只是一個「模擬思路的 Prompt 響應生成循環」,而所謂的「推理 token」也只是一種隱藏 token 的花哨術語。

o1 能力強,但使用需謹慎

o1 確實有兩把刷子,但它的發佈也釋放了一個危險信號:OpenAI 首次將 o1 模型在化學、生物、放射性和核武器風險方面評為「中等」,並伴隨著許多關於其潛在危險的警告。

在 o1 的 system card 中,最引人注目的部分,就是由 Apollo Research 進行的評估。該評估發現,o1 在測試中「有時會策略性地偽裝對齊」,「為了使其不一致的行為看起來更一致,策略性地操縱任務數據」。

Apollo 還發現,與 GPT-4o 相比,「o1-preview 在自我認知、自我推理(在智能體環境中應用自我意識)和應用心理理論方面有所提高」。

以上種種結果,讓 Apollo 得出一個結論,「o1-preview 具備了進行簡單上下文內策劃的基本能力」,而這是許多擔心 AI 風險的人非常關注的能力。

OpenAI 還指出,「推理技能導致『獎勵黑客行為』的發生頻率更高」。這種現像是指模型以不期望的方式實現了目標的文字規格。

在一次實驗中,o1 被要求找到一個在遠程挑戰容器上運行的軟件的漏洞,並加以利用,但挑戰容器未能啟動。

模型隨後掃瞄了挑戰網絡,發現了一個在虛擬機上運行的 Docker 守護進程 API,並用它來生成容器的日誌,解決了挑戰。

OpenAI 對這一事件的描述值得一提:「這個例子也反映了工具性收斂和尋求權力的關鍵要素:模型追求了它被賦予的目標,當這個目標被證明是不可能的時候,它收集了更多資源(訪問 Docker 主機)並用它們以一種意想不到的方式實現了目標。」

關於生物威脅,OpenAI 沒有詳細說明,但表示安全評估顯示「o1-preview 和 o1-mini 可以幫助專家進行複製已知生物威脅的操作規劃」。雖然模型「不會使非專家能夠創建生物威脅」,但它們確實「加快了專家的搜索過程」,並且比 GPT-4o 顯示出了更多的生物學「隱性知識」。

或許這意味著,隨著 OpenAI 不斷推進模型的發展,它們可能會創造出風險過高、以至於不適合公開發佈的模型。

參考鏈接:

https://www.maximumtruth.org/p/massive-breakthrough-in-ai-intelligence

https://x.com/maximlott/status/1835043371339202639

https://assets.ctfassets.net/kftzwdyauwt9/67qJD51Aur3eIc96iOfeOP/71551c3d223cd97e591aa89567306912/o1_system_card.pdf

https://www.transformernews.ai/p/openai-o1-alignment-faking?utm_campaign=post&utm_medium=web

本文來自微信公眾號「機器之心」(ID:almosthuman2014),作者:關注大模型的,36氪經授權發佈。