Llama系列上新多模態,3.2版本開源超閉源,還和Arm聯手搞了手機優化版

在多模態領域,開源模型也超閉源了!

就在剛剛結束的Meta開發者大會上,Llama 3.2閃亮登場:

這回不僅具備了多模態能力,還和Arm等聯手,推出了專門為高通和聯發科硬件優化的「移動」版本。

具體來說,此次Meta一共發佈了Llama 3.2的4個型號:

110億和900億參數的多模態版本

10億參數和30億參數的輕量級純文本模型

官方數據顯示,與同等規模的「中小型」大模型相比,Llama 3.2 11B和90B表現出了超越閉源模型的性能。

尤其是在圖像理解任務方面,Llama 3.2 11B超過了Claude 3 Haiku,而90B版本更是能跟GPT-4o-mini掰掰手腕了。

而專為端側打造的3B版本,在性能測試中表現也優於Google的Gemma 2 2.6B和微軟的Phi 3.5-mini。

如此表現,著實吸引了不少網民的關注。

有人興奮地認為,Llama 3.2的推出可能再次「改變遊戲規則」:

端側AI正在變得越來越重要。

Meta AI官方對此回覆道:

其中一些模型參數量很小,但這個時刻意義重大。

01 首個視覺

有關Llama 3.2具體能做什麼,這次官方也釋出了不少demo。

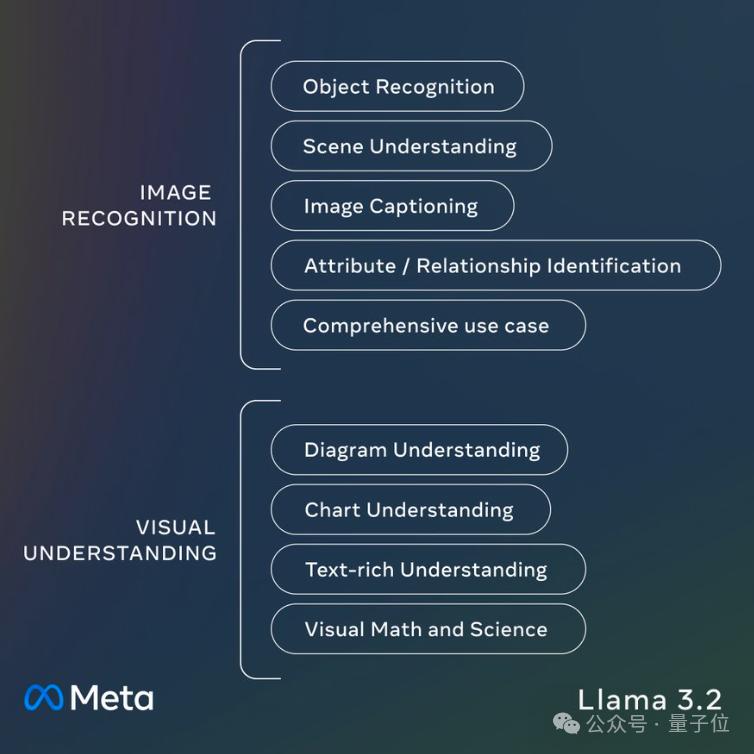

先看個彙總:Llama 3.2 11B和90B支持一系列多模態視覺任務,包括為圖像添加字幕、根據自然語言指令完成數據可視化等等。

舉個🌰,丟給Llama 3.2一張圖片,它能把圖片中的元素一一拆解,告訴你詳細的圖片信息:

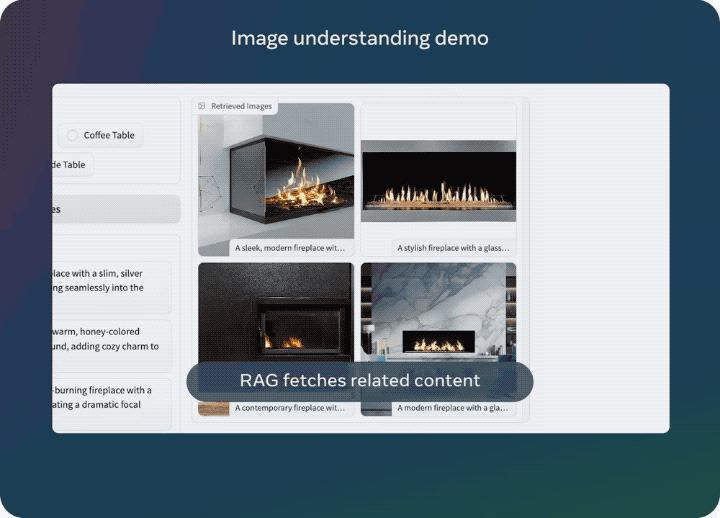

同樣,也可以反過來根據文字指令找出符合用戶需求的圖片。

Llama 3.2 11B和90B也是首批支持多模態任務的Llama系列模型,為此,Meta的研究人員打造了一個新的模型架構。

在Llama 3.1的基礎之上,研究人員在不更新語言模型參數的情況下訓練了一組適配器權重,將預訓練的圖像編碼器集成到了預訓練的語言模型中。

這樣,Llama 3.2既能保持純文本功能的完整性,也能get視覺能力。

訓練過程中,Llama 3.2採用圖像-文本對數據進行訓練。訓練分為多個階段,包括在大規模有噪聲數據上的預訓練,和更進一步在中等規模高質量領域內和知識增強數據上的訓練。

在後訓練(post-training)中,研究人員通過監督微調(SFT)、拒絕采樣(RS)和直接偏好優化(DPO)進行了幾輪對齊。

02 專為端側打造的「小」模型

至於1B和3B這兩個輕量級模型,目的更加清晰:

隨著蘋果Apple Intelligence的推出,對於電子消費市場而言,手機等終端上的生成式AI已經成為標配。

而脫離雲端獨立運行在終端上的模型,無論是從功能還是從安全的角度,都是終端AIGC落地的關鍵。

△

△Llama 3.2 1B和3B模型由Llama 3.1的8B和70B模型剪枝、蒸餾得到。

可以簡單理解為,這倆「小」模型是Llama 3.1教出來的「學生」。

Llama 3.2 1B和3B僅支持文本任務,上下文長度為128K。來自Meta合作方Arm的客戶業務線總經理Chris Bergey認為:

明年初甚至今年年底,開發人員就會在應用程序中落地這兩個型號的Llama 3.2。

它們擁有更好的效率,能在1W功率下或在8毫秒以內提供答案。

不少網民也為此點讚:

Llama 3.2的輕量級模型能真正改變AI在手機和其他設備上的應用。

還有網民已經第一時間實踐上了:

我驚歎於這個1B模型的能力。

這位網民用Llama 3.2 1B運行了一個完整的代碼庫,並要求它總結代碼,結果是醬嬸的:

「不完美,但遠超預期。」

前有OpenAI「Her」全量開放、GoogleGemini 1.5迎來重大升級,Llama這邊也緊鑼密鼓跟上新動作,AI圈的這一週,依舊是開源閉源激情碰撞,充滿話題度的一週。

那麼,你怎麼看Llama這波新發佈?

對了,如果你對Llama 3.2感興趣,大模型競技場已經可以試玩了。

Ollama、Groq等也已第一時間更新支持。

參考鏈接:

[1]https://ai.meta.com/blog/llama-3-2-connect-2024-vision-edge-mobile-devices/

[2]https://www.cnet.com/tech/mobile/meta-and-arm-want-to-bring-more-ai-to-phones-and-beyond/#google_vignette

[3]https://news.ycombinator.com/item?id=41649763

本文來自微信公眾號「量子位」,作者:關注前沿科技,36氪經授權發佈。