深度 | 一文看懂Gen AI浪潮下數據中心的新機遇

文 | AlphaEngineer,作者 | 費斌傑 北京市青聯委員 熵簡科技CEO

隨著生成式AI出現突破性進展,數據中心行業目前正在經歷史無前例的跨越式發展,在未來經濟增長和國家安全中有著舉足輕重的地位。

Nvidia 的 GB200 系列需要直接對芯片進行液冷,機架功率密度高達 130kW。在性能上,GB200 相比 H100 推理性能提升了約 9 倍,訓練性能提升約 3 倍。

因此,那些無法提供更高功率密度的數據中心將錯失為其客戶提供巨大的性能 TCO 改進的市場機遇,並將在生成式 AI 軍備競賽中落後。

AI需求的驅動促使數據中心設計向適應高功率密度轉變。例如,Meta拆除了一整棟在建建築,因為這是他們多年來一直使用的低功率密度的舊數據中心設計。相反,他們用全新的 AI-Ready 設計取而代之。

變化之下往往潛藏著機遇。昨日SemiAnalysis發佈了一篇深度報告,深入探討了【AI時代下數據中心的投資機遇】,乾貨滿滿。

我給大家解讀一下這篇長文的精華內容,報告鏈接放在文末,歡迎感興趣的朋友去看原文。

在正式展開之前,我先把主要結論列出來:

- 隨著Gen AI的發展,數據中心的設計更注重提高功率密度和計算密度,全新的設計理念蘊藏著新的機會。

- 按關鍵IT功率,可以將數據中心分為零售數據中心、批發數據中心、超大規模數據中心這三類。

- 數據中心的關鍵電氣設備包括:高壓電壓器、中壓開關櫃、柴油發電機、不間斷電源(UPS)等。

- 電氣設備往往形成寡頭壟斷的市場格局,在AI需求驅動下有望大幅提升收入規模和利潤率。

- 值得關注的電氣設備供應商包括:Schneider、ABB、CAT、VERTIV、EAT-N等。

下面我們正式開始。文章有點硬核,建議耐性閱讀哈。

(1)從「配備空調的辦公樓」開始

數據中心旨在以高效、安全的方式為 IT 設備供電,並在 IT 硬件的使用壽命內實現最低的總擁有成本(TCO)。

IT 設備通常佈置在裝有服務器、交換機和存儲設備的機架中,運行這些設備需要大量電力並產生大量熱量。

30 年前的數據中心就像是配有空調的辦公樓。但如今,隨著消費者每天觀看數十億小時的 YouTube、Netflix和Instagram,數據中心的規模已大幅擴大。

現代數據中心每平方英呎所需的電量可能是辦公樓的 50 倍以上,為這些服務器散熱則需要完全不同的冷卻設備,這引發了數據中心建設方式的深刻變化。

在這種規模下,數據中心的任何故障都會造成重大損失,這就需要數據中心內部擁有可靠的電氣和冷卻系統。

電氣故障雖然更常見,但往往具有較小的「爆炸半徑」。而冷卻故障一旦發生,造成的破壞性會很大。

根據Uptime Institute以及ANSI/TIA-942標準,可以將數據中心按「預期停機時間」和「冗餘度」進行分層評估,如下圖所示。

其中,Tier 3級在全球大型數據中心中最為常見。

當我們談到「冗餘度」時,通常使用「N」、「N+1」或「2N」等術語。例如,如果一個數據中心需要 10 個變壓器,N+1 的冗餘度表示總共需要儲備 11 個變壓器,其中 10 個可運行,1個冗餘,而 2N 則需要購買 20 個變壓器。

一個Tier 3級數據中心,通常要求變壓器和發電機等組件具有 N+1 冗餘,配電組件(不間斷電源 UPS和配電單元 PDU)具有 2N 冗餘。

Tier 4級數據中心不太常見,通常用於政府或國防領域。

(2)數據中心的核心參數:Critical IT Power

數據中心的規模和設計各異,我們通常根據其關鍵 IT 功率容量(Critical IT Power Capacity)對它們進行分類。這是因為在主機託管業務中,運營商會租賃空機架並按「IT 千瓦/月」定價,數據中心的空間成本遠低於電氣和冷卻設備的成本。

關鍵IT功率是指IT設備的最大功率,而電網的實際消耗也包括非IT負載,例如冷卻和照明。這就涉及到「利用率」的概念,通常來說雲計算的電力利用率通常為 50-60%,而 AI 訓練的電力利用率則超過 80%。

根據關鍵IT功率的差異,我們可以將數據中心分為以下三個類別。

零售數據中心(Retail Datacenters)

零售數據中心通常規模較小,功率容量較低 ,最多幾兆瓦,通常位於城市內。

他們通常有許多小租戶,這些租戶只租用幾個機架(即幾千瓦)。

零售數據中心的主要價值在於「位置、位置、位置」,其運營模式更類似傳統的房地產公司。

批發數據中心(Wholesale Datacenters)

相比零售批發中心,批發數據中心的規模更大,通常可以提供10-30MW的關鍵IT功率。

其客戶通常會租賃更大的區域,即一整排或多排,並可選擇進一步擴展。

與零售數據中心相比,其價值主張是部署更大的容量並具有可擴展性。

超大規模數據中心(Hyperscale Datacenters)

超大規模數據中心通常由Hyperscalers自行建造,供自己專用。

這些數據中心通常構成一個大型園區,園區內有多棟相互連接的建築。這些園區的額定功率通常高達數百MW,其中每棟建築的功率約為40-100MW。

例如下圖所示,Google的超大規模數據中心功率接近 300MW。

大型科技公司還可以請服務商為其定製數據中心,然後出租給他們,今年以來100MW 以上的定製租賃越來越常見。

為了讓大家對Hyperscale Datacenter Campus的電力需求有個直觀的感受,我們來做一個比較。

美國一戶普通家庭的平均電力消耗是 1.2 kW,因此一個 300MW 數據中心園區的年用電量相當於約 200,000 個家庭的用電量。

從另一個角度看,20,840 個 Nvidia H100 集群需要一個具有約 25.9MW 關鍵 IT 電力容量的數據中心。隨著Hyperscalers開始構建 100,000 個 H100 集群,對數據中心關鍵IT功率將有著顯著更高的需求。

(3)數據中心中的電力傳輸路徑

讓我們從一個最簡單的佈局開始,理解數據中心的設計方式。

數據中心的設計目標是將大量電力輸送到裝滿IT設備的機架上,這些機架位於被稱為數據大廳(Data Halls)的房間中。

為了最大限度地減少配電損耗,需要將電壓保持在儘可能高的水平。這是因為電壓越高意味著電流越低,功率損耗與電流的平方成正比(Ploss= I2R)。

但是高壓是很危險的,需要更多的絕緣措施。越靠近終端設備,電壓就要越低。

因此,向建築物輸送電力的首選方法是中壓,如11kV 或 25kV 或 33kV。而當我們從建築物內將電力輸送進入數據大廳時,需要再次將電壓降低至低壓,如美國的415V三相。

從外到內,電力傳輸遵循以下路徑:

電力公司一般提供的是高壓電力(>100 kV),因此需要使用on-site變電站和變壓器來將其降低至中壓(MV)。

然後,中壓電力將使用 MV 開關設備安全地分配到一個位於數據大廳附近的變壓器,將電壓降至低壓 (415V)。

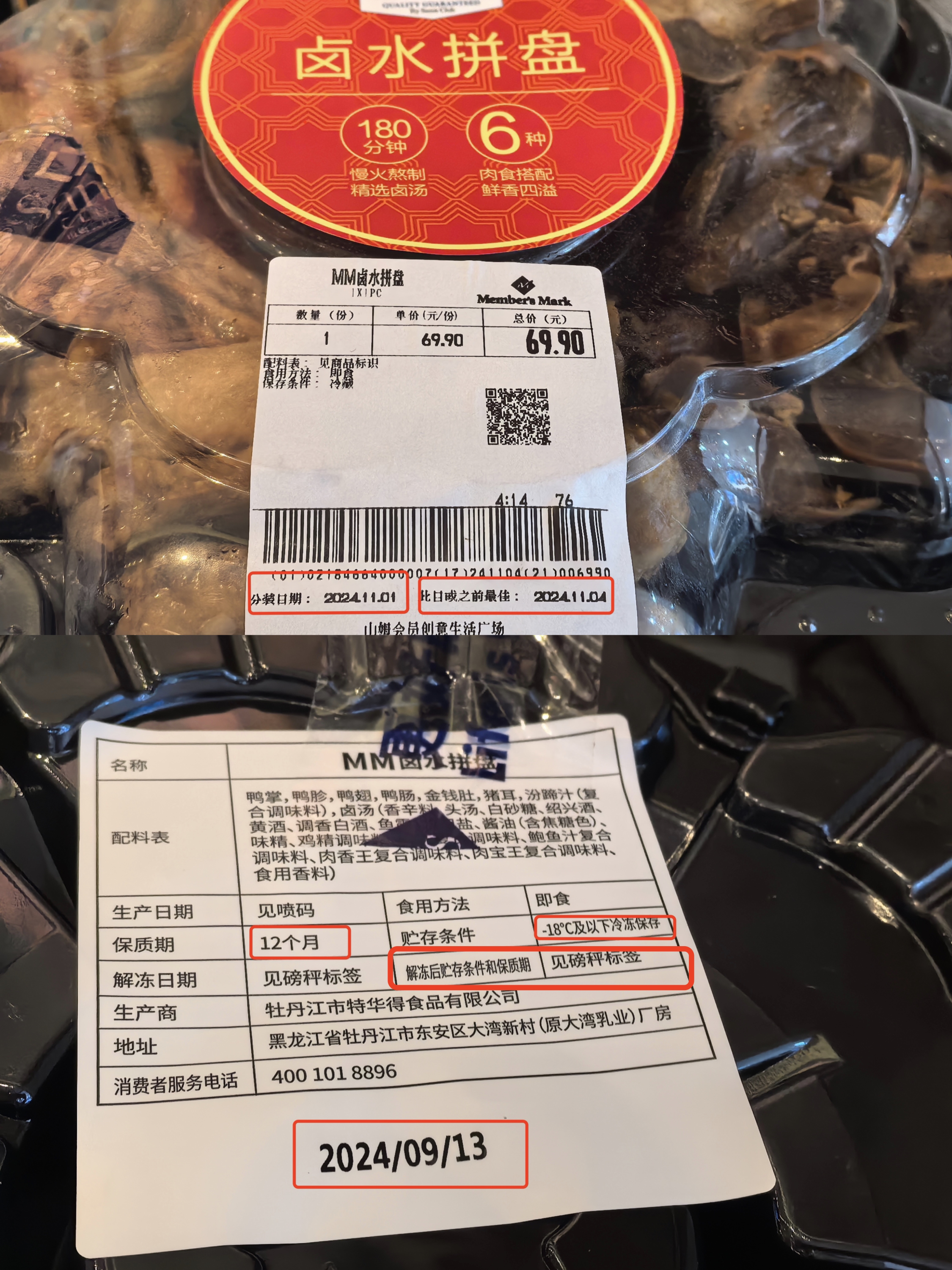

與變壓器配對的是柴油發電機,其輸出也是 415V 交流電。如果電力公司突然停電,自動轉換開關 (ATS) 可以自動將電源切換到發電機,確保持續供電。

電力進入數據大廳後,開始分成兩條傳輸路徑:一條通向IT設備,一條通向冷卻設備。我們重點來看IT設備的電力傳輸路徑。

首先,電力流經 UPS 系統,通過配電單元(PDU)將電力輸送給IT設備。

該系統連接到一組電池,通常有 5-10 分鐘的電池存儲時間,足夠發電機啟動並避免暫時停電。

隨後通過電源單元 (PSU) 和穩壓器模塊 (VRM) 向芯片進行供電。

當然,這張電力輸送圖會隨著數據中心容量的不同而形成很大差異,但是整體的思路和電力流向是相似的。

(4)數據中心中的核心電氣設備:高壓變壓器

現代超大規模數據中心往往在現場設有高壓變電站,例如下圖中Microsoft的站點。

這些設施通常會被放置在高壓 (HV) 輸電線路(138kV 或230kV 或 345kV)附近。

這些變壓器的額定功率以 MVA 為單位。MVA 大致相當於MW,但 MVA 是「視在功率(Apparent Power)」(就是電壓 * 電流),而 MW 是「實際」功率。通常來說,MW會比MVA低5-10%。

高壓變壓器額定容量通常在 50 MVA 和 100 MVA 之間。例如,需要 150MW 峰值功率的數據中心園區可以使用兩個 80 MVA 變壓器,或三個變壓器以實現 N+1 冗餘以應對可能的故障。

每個變壓器將電壓從 230kV 降至 33kV,將電流從~350 安培增加到 ~2500 安培。在這樣的 N+1 配置中,所有三個變壓器將共享負載,但以額定容量的 2/3 運行。

值得注意的是,高壓變壓器通常是定製的,因為每條輸電線路都有自己的特點,因此往往需要較長的交貨時間(>12 個月)。為了緩解建設瓶頸,數據中心運營商一般在規劃階段就開始預訂高壓變壓器。

儘管變壓器是數據中心中電力傳輸系統的核心組件,它其實是一種非常簡單的設備,即將交流電 (AC) 的電壓和電流從一個級別轉換為另一個級別。

變壓器的基本原理是電磁感應。我們把兩個銅線圈並排放置,其中一個線圈通上交流電,通過電磁感應,該線圈上的電力就可以傳輸到另一個線圈上。

在此過程中總功率保持不變,我們可以通過改變電線的特性來產生自己想要的電壓和電流。

例如當次級線圈的匝數少於主線圈,則電力將以較低的電壓和較高的電流傳輸,這是降壓變壓器的原理。

變壓器的兩個主要組件是線圈用的銅和「變壓器鐵芯」用的鋼。為了提升變壓器的傳輸性能,其鐵芯通常需要一種稱為 GOES(晶粒取向電工鋼)的特種鋼,這種鋼的製造商數量有限。

(5)發電機、中壓變壓器、配電器

在高壓變壓器的幫助下,我們將高壓(即 115kV 或 230kV 等)降至中壓 (MV)(即 33kV、22kV 或 11kV 等),下一步需要做的是使用中壓開關設備將中壓電力分配到各個數據大廳附近。

服務器和交換機等典型的 IT 設備無法在 11kV 下運行,因此在數據大廳通電之前,我們需要另一組中壓 (MV) 變壓器,通常為 2.5 MVA 或 3 MVA,將 MV(11kV/25kV/33kV)降至 LV(415V,美國常見電壓)。

下圖把這個中壓變壓和配電過程展示得比較清晰。

每個LV 變壓器旁邊都有一個與變壓器額定功率相匹配的發電機,如果變壓器或變壓器上遊的電源發生故障,發電機將自動介入。

自動轉換開關 (ATS) 通常是 LV 開關設備的組件,用於在發生這種情況時自動切換到發電機,將其作為主電源。

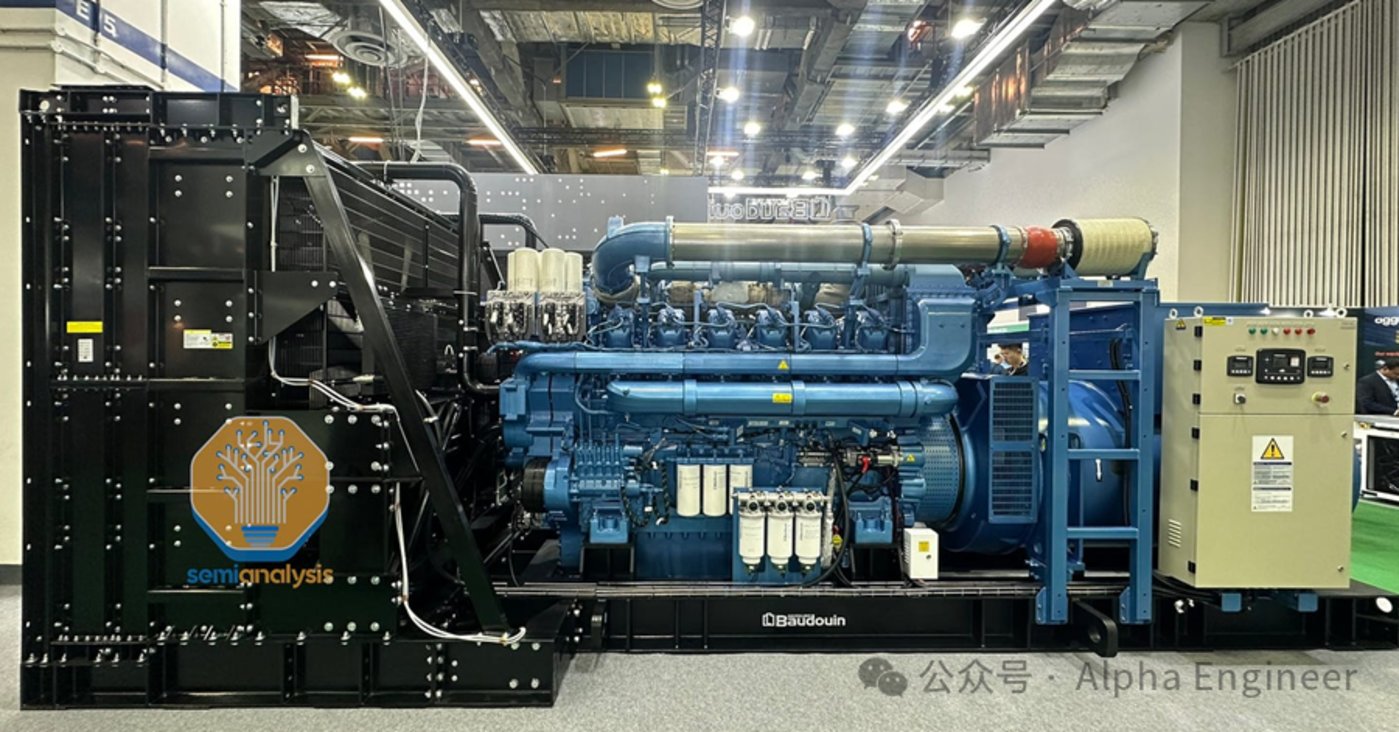

舉個例子,一台 3 兆瓦發電機的馬力超過 4,000,與火車頭的發動機類似。在超大規模數據中心中,通常有 20 台或更多這樣的發電機。

這些發電機通常使用柴油。數據中心在滿負荷情況下通常可儲存 24 到 48 小時的燃料,而柴油的運輸和儲存便利性使其成為首選。柴油也更節能,但汙染更嚴重。由於監管限制,柴油發電機往往更昂貴,因為需要特定設備來減少環境汙染。

自動轉換開關 (ATS) 的下遊是一套不間斷電源 (UPS) 系統,用於確保電源永不中斷。

發電機通常需要約 60 秒才能啟動並達到滿負荷,但就像汽車發動機一樣,它們有時不會在第一次啟動時啟動。UPS系統的作用是填補這一空白,因為它們的響應時間通常低於 10 毫秒。

UPS 通常會帶來3-5%的損耗,當負載較低時損耗會進一步加劇。現代設備可以通過待機模式(VFD)或者通過繞過 AC-DC-AC 的轉換,將效率提高到 99% 以上,但這會使轉換時間增加幾毫秒 (ms),並帶來短暫斷電的風險。

(6)突破傳統數據中心的極限:更高的機架密度

生成式AI帶來了新的大規模計算需求,從而顯著改變了數據中心的設計和規劃。

一個顯著的變化是計算密度。網絡是增加集群規模的關鍵因素,是資本支出中的重要組成部分。一個設計不良的網絡會顯著降低 GPU 利用率,大幅提高成本。

在大型集群中,我們希望儘可能多地使用銅線。使用銅電纜進行通信而非光纖收發器,是因為光纖收發器成本高、耗電高、延遲高。

但是,銅線高速傳輸的覆蓋範圍通常最多隻有幾米。因此,為了通過銅線進行通信,GPU 之間必須儘可能靠近彼此。

計算密度在Nvidia最新的GB200系列中體現得淋漓盡致。NVL72 是一個由 72 個 GPU 組成的機架,總功率超過 130kW。所有 GPU 都通過NVLink 互連,與 H100 相比吞吐量提高了 9 倍。

從數據中心的視角來看,這裡面最關鍵的參數是每個機架130 kW+的電力供給。

這與過去有何不同?讓我們看看下面的圖表:平均機架電力密度在2023年之前一直低於10kW,而Omdia 預計到 2030 年這個數字將上升到 14.8kW。

Hyperscaler數據中心的機架密度往往千差萬別。按照目前的數據來看,Meta 的機架密度最低,約10+千瓦,而 Google 的機架密度最高,通常超過 40 千瓦。

從這個角度來看,我們就不難理解為什麼Meta要拆掉自己的舊數據中心,按全新的設計方案來重新建設了。

Meta原先的設計方案是「H型」的建築,功率密度太低了。在比較功率密度時,Google 的每平方英呎千瓦密度比 Meta 高 3 倍以上。

雖然「H」也有自身的優點,但在AI時代最關鍵的計算密度上卻表現欠佳,如果不進行改建的話,將成為GenAI軍備競賽中的一個關鍵的競爭劣勢。

(7)構建下一代Blackwell數據中心的核心玩家

電力需求的大幅增加將導致電氣設備供應商的產銷量大幅增加,這可能會進一步收緊供應鏈,並導致價格上漲。

增加功率密度的需求將與總電力需求一樣具有強大的驅動力。無論設備的外形尺寸或佔地面積如何,電力設備的成本都將與提供的千瓦數成比例增加。

一個可以稍微抵消需求大幅增長的因素是,越來越多的Hyperscalers開始接受較低的冗餘度。

在大規模AI訓練中,GPU 節點的高故障率使得著訓練框架在某種程度上已經能夠應對節點故障,這意味著數據中心方面可以接受較低的冗餘度。

在數據中心的設計方案中,高密度化正成為首選方案。為了增加密度並縮短網絡距離,Hyperscalers和主機託管運營商正在建設多層數據中心,例如 Applied Digital Ellendale,它有三層樓和兩個 50MW 數據大廳。微軟和 QTS 也在這個方向上大舉進軍。

電氣設備大多是標準化的,而且電氣公司可以通過與當地安裝人員、電工、公用事業公司建立長期關係,從而形成一定規模的網絡效應,保護它們免受競爭,這導致了電氣行業出現了寡頭壟斷的市場結構。

這些主要供應商包括:

發電機組(如CAT、ABB、GENERAC等)

中壓變壓器(如Schneider、ABB、SIEMENS等)

開關櫃(如Schneider、VERTIV、EAT – N等)

不間斷電源(如EAT – N、ABB、VERTIV等)

配電單元(如Schneider、legrand、VERTIV等)

隨著Nvidia 大力推廣全新的超高密度設計,我們認為許多運營商尚未做好準備,機電工程人才的需求可能會驟增。

過去幾年來,施耐德和 Vertiv 等一些供應商投入了大量資金來構建自己的數據中心設計能力,現在正與Nvidia 合作構建 AI-ready藍圖。

在AI時代,快速變化和快速上市意味著數據中心運營商必須依靠施耐德和 Vertiv 等解決方案提供商來推動設計和部署。

這意味著電氣設備提供商將在AI時代獲得更大的議價能力、更大的市場空間、以及更高的利潤率。