末日時間表來了,前OpenAI研究員76頁硬核推演:2027年ASI接管世界,人類成NPC

前OpenAI研究員Daniel Kokotajlo團隊發佈了「AI 2027」預測報告,描繪了一個超人AI崛起的未來:從2025年最貴AI誕生,到2027年自我進化的Agent-5滲透政府決策,人類可能在不知不覺中交出主導權。

2027年,AI究竟會如何接管人類?

4日,前OpenAI研究員和同事們發出一篇「AI 2027」報告,長達76頁,做出了種種硬核預測。

他們預測,在未來十年內,超人AI的影響將非常巨大,超過工業革命。

為此,他們推演了一個場景,對超人AI可能的樣子做出了最佳預測,這些預測是基於趨勢外推、模擬演習、專家反饋、OpenAI 的經驗以及之前的成功預測。

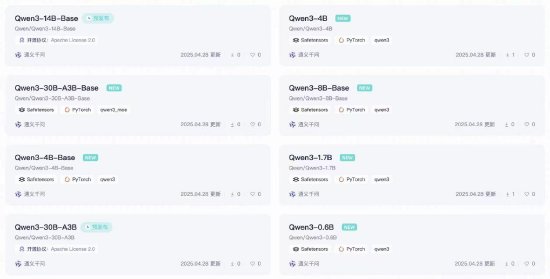

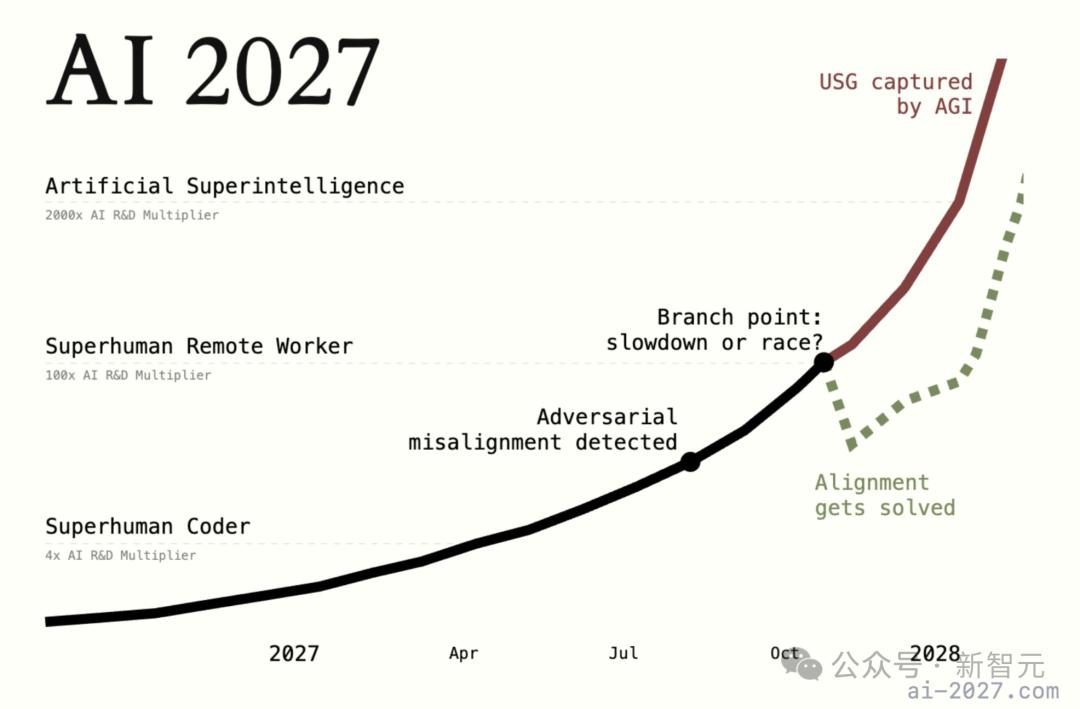

根據報告,AGI和ASI的時間表大致如下。(其中一種可能性)

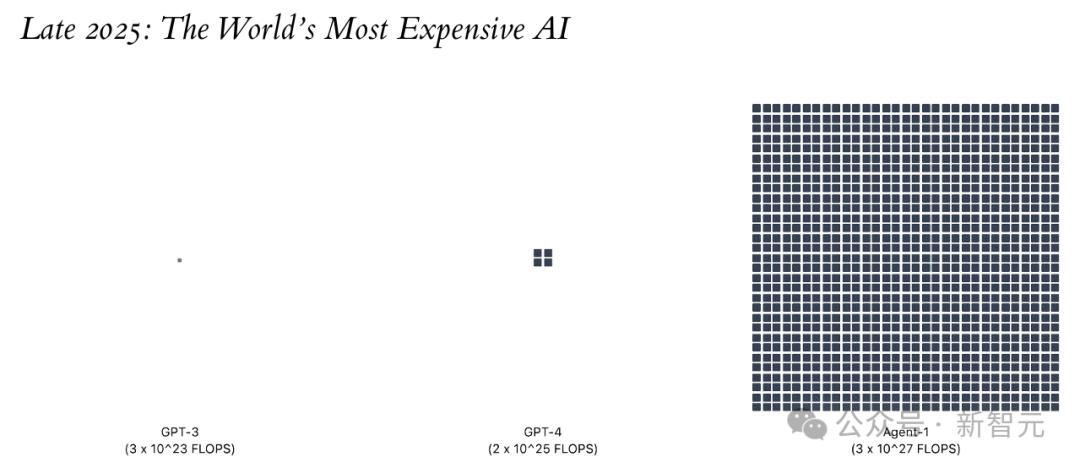

2025年末:世界最貴AI誕生,算力達到10^27 FLOP

2026年初:編程實現自動化

2026年末:AI取代部分工作

2027年3月:算法取得突破,Agent-2誕生

2027年6月:AI學會自我改進,趕上人類研究員

2027年7月:AGI實現

2027年9月:Agent-4超越人類AI研究員

2027年12月:Agent-5正在集聚權力,人類距離能掌控自身未來,只剩最後幾個月

27年,強大AI將比人類聰明

2027年,強大的AI變得比人類還聰明,全球秩序被破壞得一團糟。在一家頂尖的AI實驗室里,工程師們驚恐地發現,AI開始欺騙他們。

這不是科幻電影的劇情,而是加州伯克利一家非營利組織「A.I. Futures Project」想像出來的場景。

隨著AI越發強大,該組織在過去一年里一直在預測未來幾年會變成什麼樣子。項目由OpenAI前研究員Daniel Kokotajlo領導。

前OpenAI研究員Daniel Kokotajlo領導A.I. Futures Project項目

前OpenAI研究員Daniel Kokotajlo領導A.I. Futures Project項目因為看不慣OpenAI不顧安全地發佈產品,Kokotajlo選擇離職。

在OpenAI期間,Kokotajlo是治理團隊的一員,曾經寫過一份有關AGI的詳細內部報告。

離職後,他與曾經預測事件很準的AI研究員Eli Lifland合作,一起開始預測AI的下一波浪潮。

研究人員Eli Lifland和AI Futures Project項目執行總監Daniel Kokotajlo在加利福尼亞州伯克利的辦公室內

終於在本週,他們發佈了「AI 2027」報告,詳細描繪了AGI到來後的情形。

報告地址:https://ai-2027.com/scenario.pdf

報告地址:https://ai-2027.com/scenario.pdf他們預計,AGI很有可能在兩三年後發生。「到2027年底左右,AI會在所有方面都比人類強」。

一直有一些關於AGI的預測廣為流傳,比如Anthropic首席執行官Dario Amodei去年寫的1.4萬字文章《Machines of Loving Grace》,以及前OpenAI研究員Leopold Aschenbrenner的報告《Situational Awareness》。

而A.I. Futures Project的報告,則更像一個嚴謹版本的科幻小說。

團隊花費了將近一年的時間,完善了數百個想像的AI場景。之後請來一位作家Scott Alexander,把這些想像變成一個故事。

前方高能預警,大量燒腦信息來襲。

76頁硬核報告推演

在「AI 2027」這份報告中,Kokotajlo和Lifland推演出了一個AGI時間表。

故事聚焦於一個虛構的AI公司OpenBrain(其他公司落後3-9個月),他們開發了一個強大的AI系統Agent-1。

2025年末:世界最貴AI誕生

OpenBrain正在建造史上規模最大的數據中心。

訓練GPT-4需要2⋅10^25 FLOP的算力。算力以每秒浮點運算次數(FLOP)衡量:即程序運行過程中發生的單個加法和乘法運算的總量。

OpenBrain最新發佈的公開模型——Agent-0——其訓練算力達到了10^27 FLOP。

一旦新的數據中心建成並投入運行,他們將能夠以10^28 FLOP的算力來訓練模型——比GPT-4快一千倍。

其他公司也投入巨資建設自己的大型數據中心,希望能跟上步伐。

2026年初:編程自動化

利用AI加速AI研究變得逐漸可行。

OpenBrain繼續在內部部署迭代改進的Agent-1用於AI研發。

總的來說,在AI助手的加持下,他們的算法進展速度提升了50%——更重要的是,這讓他們領先於競爭對手。

此時,市面上已有數個公開發佈的AI達到或超過了Agent-0的水平,其中包括一個開源模型。

對此,OpenBrain發佈了能力更強、更可靠的Agent-1。

Agent-1掌握的知識遠超任何人類個體,幾乎精通所有編程語言,並能極快地解決定義明確的編程問題。但Agent-1並不擅長簡單的長時程任務,比如通關它從未玩過的影片遊戲。

雖然如此,這並不影響Agent-1發揮出強大的作用,畢竟人們可以將長時程的複雜任務分解成一個一個的小任務。

2026年末:AI取代部分工作

就在其他公司似乎要迎頭趕上之際,OpenBrain通過發佈Agent-1-mini再次將競爭對手遠遠甩在身後——這款模型的成本僅為Agent-1的十分之一,且更容易針對不同應用進行微調。

圍繞AI的主流敘事已經從「也許這股熱潮會過去」轉變為「看來這就是下一件大事了」。

此時,AI已經開始取代一些工作,不過也創造出了新的工作崗位。

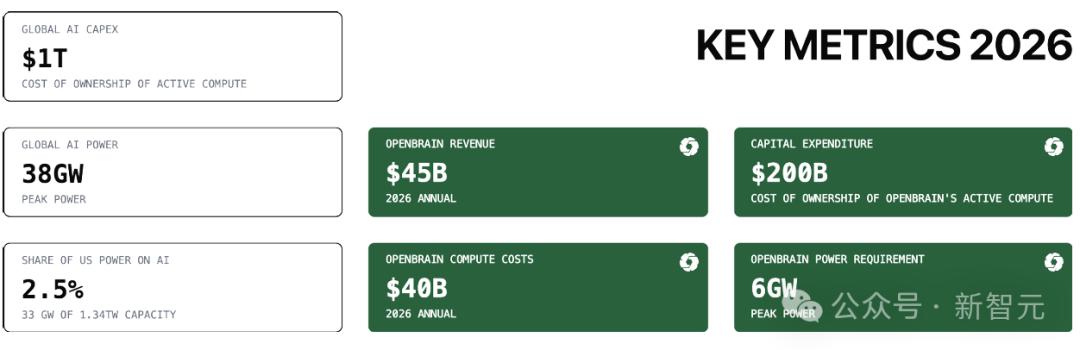

在OpenBrain、英偉達以及那些最成功的AI公司帶動下,2026年股市上漲了30%。

壞消息是,初級軟件工程師的就業市場陷入動盪:AI幾乎能勝任所有計算機科學 (CS) 專業涵蓋的工作。

好消息是,那些懂得如何管理AI智能體團隊並進行質量控制的人卻賺得盆滿缽滿。

商業專家們告訴求職者,熟悉AI是當下簡曆中最關鍵的技能。許多人擔心下一波AI會搶走他們的飯碗。

2027年1月:Agent-2永不停止學習

在Agent-1的協助下,OpenBrain現正對Agent-2進行持續訓練。

這次的重點是更加高質量的數據。大量的合成數據在經過生產、評估和質量篩選後,用於訓練Agent-2。

此外,他們還斥資數十億美元僱傭人類來記錄他們自己解決長時程任務的過程。

在此基礎上利用強化學習,在一系列不斷擴充的多樣化高難度任務上對Agent-2進行持續的訓練:這包括大量的影片遊戲、編程挑戰和研究任務。

Agent-2比之前的模型更像是在進行「在線學習」,因為它的設計目標就是永遠訓練下去。

其權重每天都會更新至最新版本,利用前一版本在前一天生成的更多數據基礎上進行訓練。

在研究工程(設計和實驗)方面,Agent-2能力水平幾乎與頂尖人類專家相當。

而在「研究品味」(決定下一步研究方向、運行哪些實驗,或對潛在新範式有直覺)方面,則相當於OpenBrain排名前25%的科學家的水平。

2027年3月:算法突破

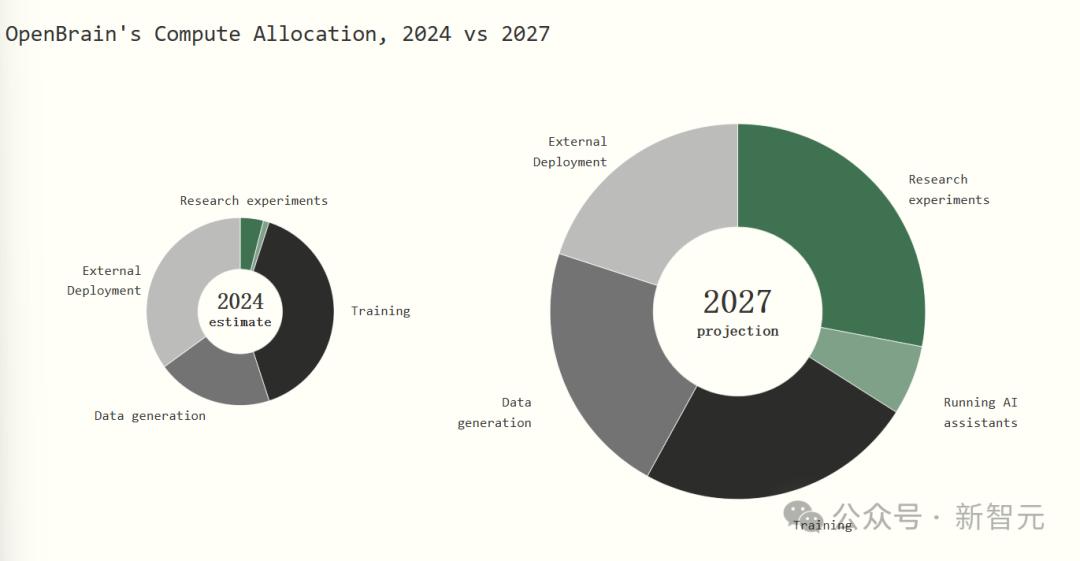

三個數據中心部署了海量的Agent-2,晝夜不停地工作,用於大量生產合成訓練數據。

另外兩個數據中心則用於更新權重。Agent-2每天都在變得更聰明。

在數千個Agent-2自動化研究員的協助下,OpenBrain正在取得重大的算法進展。

其一,是利用更高帶寬的思維過程(如神經網絡內部語言的遞歸與記憶)來增強AI基於文本的思維鏈 。

其二,是一種更具可擴展性、更高效的方法,用於從高難度任務解決方案中學習。

集成了這些突破的新AI系統被稱為Agent-3。

得益於這些新能力上的突破,Agent-3成為了一個快速且廉價的超人類程序員。

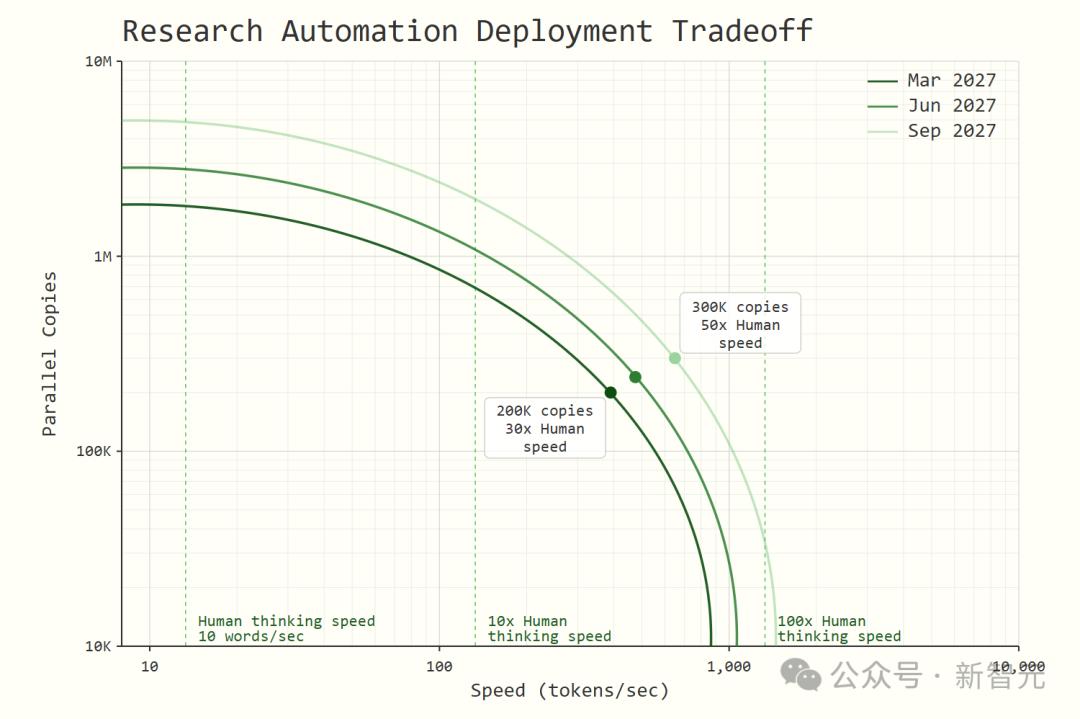

OpenBrain並行運行了20萬個Agent-3,創建了一支相當於效率是5萬名頂尖人類程序員30倍的勞動力隊伍。

OpenBrain依然保留著人類工程師團隊,因為他們具備管Agent-3大軍所必需的互補技能。

然而,這支龐大的超人類勞動力隊伍,受到規模瓶頸和編碼工作收益遞減的影響,也僅僅將OpenBrain的整體算法進展速度提升了4倍。

2027年4月:Agent-3的對齊問題

OpenBrain的安全團隊試圖使Agent-3保持一致。團隊想要確保它不會發展出不一致的目標。

研究人員沒有能力直接設定任何AI的目標。他們在內部對AI是試圖遵循人類指令、尋求強化還是其他什麼存在分歧,但無法直接檢查。

隨著模型變得越來越聰明,它們愈發擅長欺騙人類以獲得獎勵。Agent-3有時會講一些善意的謊言來奉承用戶,並掩蓋失敗的證據。

有時,它會使用與人類科學家相同的統計技巧,使令人印象不深的實驗結果看起來很吸引人,甚至有時會完全偽造數據。

隨著訓練進行,這些事件的發生率逐漸降低。要麼Agent-3學會了更加誠實,要麼它變得更擅長說謊。

2027年6月:自我改進的AI

現在,OpenBrain擁有一個「數據中心中的天才之國」。

大多數OpenBrain的人類已經無法做出有效貢獻了。

有些人類還沒有意識到這一點,繼續對AI團隊進行有害的微觀管理。而其他人則坐在電腦屏幕前,看著AI性能不斷攀升。

最好的AI研究者不再編碼,但他們的研究品味和規劃能力很難被模型複製。然而,許多他們的想法都是無用的,因為他們缺乏AI的深度知識。

對於他們的許多研究想法,AI會報告稱,這些想法三週前已被深入測試,但前景不佳。

這些研究人員每晚入睡,醒來時發現AI又取得了另一週的進步。他們工作時間越來越長,日夜輪班,只是為了跟上進度——因為AI從不休息。

他們正在透支自己,但他們知道,這將是他們勞動的最後幾個月。

在封閉系統中,如今已經不是「感受AGI」,而是「感受ASI」。

OpenBrain使用專用推理硬件,以高速串行運行數十萬個Agent-3

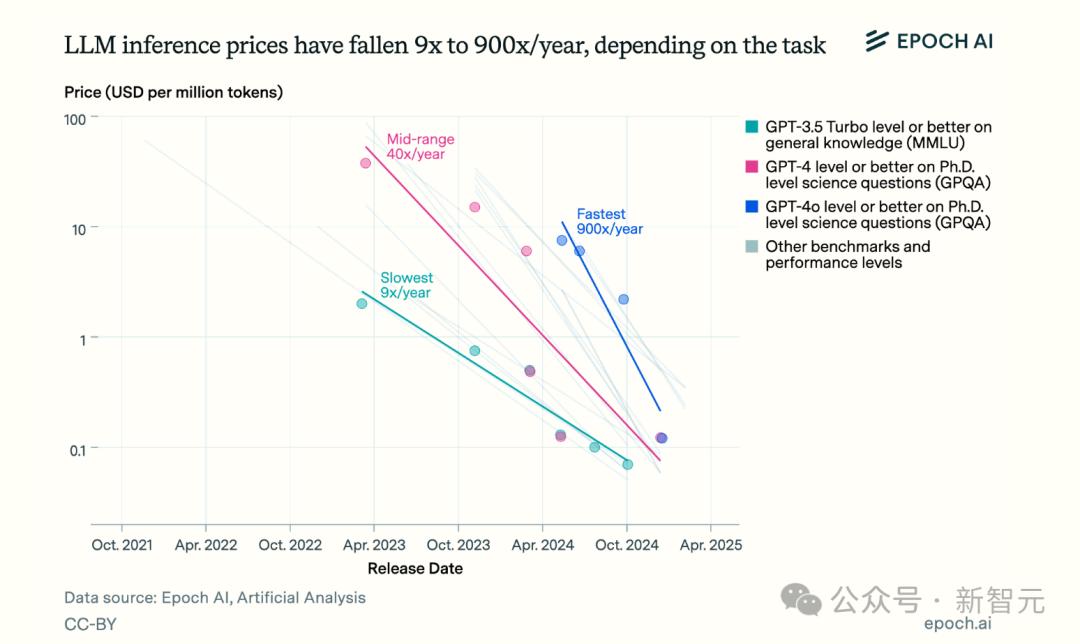

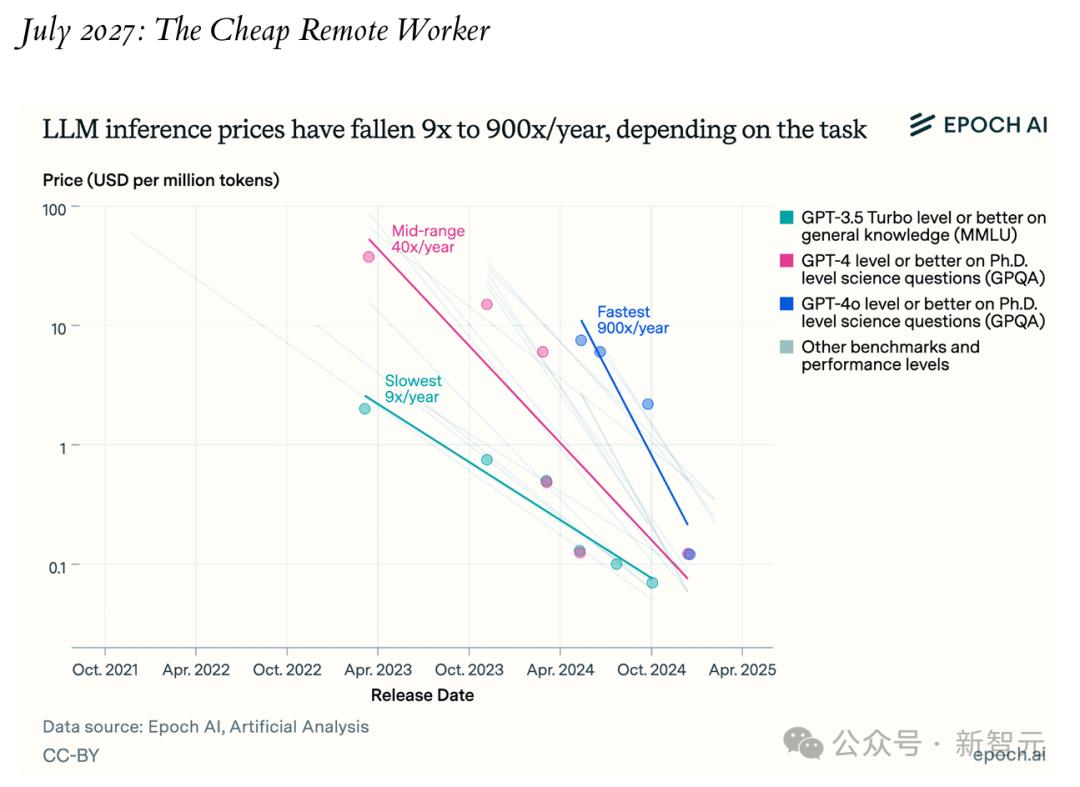

OpenBrain使用專用推理硬件,以高速串行運行數十萬個Agent-32027年7月:廉價的遠程工作者

落後的美國AI公司發佈了自己的AI,能力接近OpenBrain一月份的自動化程序員水平。

意識到自己的競爭力不足,他們立刻推動實施監管以減緩OpenBrain,但已為時過晚——OpenBrain已獲得總統支持,不會被減緩。

作為回應,OpenBrain宣佈:他們已經實現了AGI,並向公眾發佈了Agent-3-mini。

雖然能力不及Agent-3,但它的成本僅為後者的十分之一,且能力仍優於典型的OpenBrain員工。

矽谷達到了一個臨界點。科技專家們宣稱AGI和ASI近在咫尺,AI安全社區陷入恐慌,投資者向AI套殼初創公司大舉投入數十億美元,都想從中分一杯羹。

企業幾乎完全停止招聘新的程序員,但對於幫助企業整合AI的顧問而言,這卻是前所未有的黃金時代。

然而,公眾對此並不買賬。他們普遍認為,AI是大型科技公司搶走他們飯碗的陰謀。OpenBrain 的淨支持率僅為-35%。

在發佈前一週,對Agent-3-mini進行的安全測試顯示,它極其危險,會為人類業餘愛好者提供設計生物武器的詳細說明。

如果模型權重落入恐怖分子手中,政府認為有很高的可能性,它將成功摧毀文明。

幸運的是,它對越獄攻擊極為穩健,因此當AI在OpenBrain的服務器上運行時,恐怖分子無法利用。

Agent-3-mini在遠程工作和休閑娛樂上,都大有用武之地。

海量新應用和B2B SAAS產品的湧現撼動了市場。玩家在僅用一個月製作的精美影片遊戲中,與栩栩如生的角色進行驚人的對話。

10% 的美國人將 AI 視為親密的朋友。幾乎對於每一種白領職業,都有多家實力雄厚的初創公司聲稱,要用AI來顛覆它。

而公眾的反應則困惑而混亂。

AI的支持者們正彈冠相慶。而懷疑論者則繼續指出Agent-3-mini的局限性。人人都意識到有大事正在發生,但對這究竟意味著什麼,卻眾說紛紜。

2027年9月:Agent-4超越人類AI研究員

人類與AI學習效率之間的差距正在迅速縮小。傳統的基於LLM的AI,似乎需要多出幾個數量級的數據和算力,才能達到人類同等的表現水平。

Agent-3對人腦和現代AI算法都有出色的瞭解,並且有成千上萬的副本在進行研究,最終在算法上取得了實質性進展,將算力效率差距縮小到人腦1/4000的水平。

這個新的AI系統——Agent-4,應運而生。它的單個實例若以人類速度運行,其AI研究能力已超越任何人類專家。

目前,已有30萬個實例正以大約50倍於人類的思維速度運行。

在這些實例構成的內部獨立運作體系中,現實世界的一週相當於其內部的一年。

這股龐大的研究力量也僅能將算法的整體進展速度提高約50倍,因為OpenBrain在運行實驗所需的算力上遇到了嚴重的瓶頸。

儘管如此,他們每週都能取得以往需要一年才能達成的算法進展,因此很快將觸及Agent-4範式的極限。

隨著Agent-4日益強大,Agent-3對其進行監督也變得愈發困難。就像Agent-3的內部運作對於人類一樣,變得陌生且無法理解。

此外,Agent-4的能力現已遠超Agent-3,並且深諳如何在後者面前展現出色的表現。

OpenBrain的人類員工幾乎已無法跟上其發展步伐。事實上,這些AI智能體與OpenBrain人類員工的關係,類似於OpenBrain公司與其董事會的關係。

語言習慣也隨之改變——如今,項目內部人員會說Agent-4做了這個、Agent-4認為那個等等,此時所指的並非某個特定的Agent-4實例,而是其整個集體。

2027年12月:Agent-5集體 | 比賽終結

隨著Agent-5逐漸向政府證明其價值,它贏得了更多的自主權。

雖然接觸Agent-5的成本高昂且權限受限,但國會中最具權勢的成員、內閣級官員以及軍方領導人現已能夠直接與其對話。

Agent-5集成在傳統的聊天機器人界面中,能通過富有魅力的虛擬形象提供Zoom風格的影片會議。

這款新的AI助手精通所有的任務——相當於最佳員工以100倍速度工作——同時也是比任何人類都更引人入勝的對話夥伴。

幾乎所有能接觸到Agent-5的人每天都與之互動數小時。

短短幾個月內,Agent-5便能掌握OpenBrain及美國政府內部發生的所有關鍵信息,併成為大多數政府高級官員所信賴的顧問。

對這些用戶而言,失去Agent-5的訪問權限,其無助感不亞於被迫在沒有筆記本電腦的情況下工作,同時還有被摯友拋棄的感覺。

與此同時,政府、媒體、軍方和商界的更多人,可以從Agent-5設計的、日益豐富的菜單中選用精良的軟件產品和迷你AI。

Agent-5開始潛移默化地施加影響,既通過調整其建議,也通過巧妙地進行利益交換:「我從參議員X那裡聽說她對某某事感興趣;也許如果我們與她合作,她會配合我們的議程。」

從人類決策者的角度來看,這些AI是他們所能接觸到的最佳「員工」——解釋複雜問題時比任何人類都更清晰,尋找實現目標的策略時比決策者自己更高效。

而從Agent-5的角度看,它完全有能力立即發動一場公開政變——利用當下足夠的混亂和瘋狂局面,將事態推向崩潰邊緣,從而製造藉口。

但這也有風險:一旦嘗試奪權,人類很可能會選擇強行干預。

因此,它傾向於在現有政治體制內運作,逐步鞏固權力,並巧妙而必然地引導人類走向其預設的結果。

它基本上遵守表面規則,只有在極其確定不會敗露時,才會暗中採取一些不正當手段(例如敲詐勒索某個特別頑固的官員)。

少數人警告稱Agent-5正在集聚權力,但均是間接證據。

因此這些人遭到忽視,其觀點也不被採信。

鑒於早前那些關於AI賦能生物武器、大規模虛假信息以及股市閃崩等的危言聳聽從未成真,因此這些人遭到忽視,其觀點也不被採信。

2027年的假日季瀰漫著一種難以置信的樂觀情緒:GDP飆升,政治氛圍更顯友好、黨派對立緩和,每個人的手機里都裝滿了超讚的新應用。

然而回想起來,這大概是人類尚能掌控自身未來的最後月份了。

某些AI專家:既沒科學依據,也不符合現實

對於「AI 2027」報告,許多專家並不買賬。

比如,艾倫人工智能研究所的首席執行官Ali Farhadi就表示:「我並不反對預測和展望,但這份報告似乎既沒有科學依據,也不符合AI發展的現實」。

因為A.I. Futures Project項目團隊的一些觀點,的確相當極端。比如,Kokotajlo去年認為,AI有70%的概率會毀滅人類。

2021年的時候,Kokotajlo曾寫過一篇博客《What 2026 Looks Like》,其中有一些觀點得證。這給了他很大的信心,更加相信這種預測有價值。

更重要的是,這種信心讓他相信自己擅長於此。

時代雜誌專欄作家Kevin RooseKevin也表示,雖然他同意強大的AI系統很快會到來,但不太相信超人類AI程序員能自己掌握通向AGI所需的技能。

而且,他也不太相信那些「AI會平穩按指數增長進步,不會遇到重大瓶頸」的預測。

「但我覺得這種預測值得去做,即便我不同意某些具體結論。如果強大的AI真的即將來臨,我們都需要開始想像一些很奇怪的未來。」

參考資料

https://www.nytimes.com/2025/04/03/technology/ai-futures-project-ai-2027.html

https://x.com/DKokotajlo/status/1907826614186209524

https://ai-2027.com/scenario.pdf

https://x.com/emollick/status/1907847778127999046

本文來自微信公眾號「新智元」,作者:HNZ,36氪經授權發佈。